เพิ่มแหล่งที่มาของ Apache Kafka ไปยัง Fabric eventstream (ตัวอย่าง)

บทความนี้แสดงวิธีการเพิ่มแหล่งที่มาของ Apache Kafka ไปยังเหตุการณ์ Fabric

Apache Kafka เป็นโอเพนซอร์สแพลตฟอร์มแบบกระจายสําหรับการสร้างระบบข้อมูลแบบเรียลไทม์ที่ปรับขนาดได้ โดยการรวม Apache Kafka เป็นแหล่งข้อมูลภายในเหตุการณ์ของคุณ คุณสามารถนําเหตุการณ์แบบเรียลไทม์จาก Apache Kafka ของคุณได้อย่างราบรื่นและประมวลผลก่อนกําหนดเส้นทางไปยังหลายปลายทางภายใน Fabric

หมายเหตุ

แหล่งข้อมูลนี้ไม่ได้รับการสนับสนุนในภูมิภาคต่อไปนี้ของความจุพื้นที่ทํางานของคุณ: US3 ตะวันตก สวิตเซอร์แลนด์ตะวันตก

ข้อกำหนดเบื้องต้น

- เข้าถึงพื้นที่ทํางาน Fabric ด้วยสิทธิ์ผู้สนับสนุนหรือข้างต้น

- คลัสเตอร์ Apache Kafka ทํางาน

- Apache Kafka ของคุณต้องสามารถเข้าถึงได้โดยสาธารณะและไม่ได้อยู่หลังไฟร์วอลล์หรือมีความปลอดภัยในเครือข่ายเสมือน

หมายเหตุ

จํานวนสูงสุดของแหล่งข้อมูลและปลายทางสําหรับหนึ่งเหตุการณ์สตรีมคือ 11

เพิ่ม Apache Kafka เป็นแหล่งข้อมูล

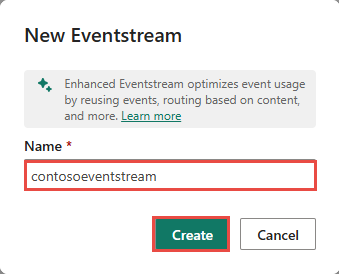

ในตัวแสดงเวลาจริงของ Fabric เลือก เหตุการณ์สตรีม เพื่อสร้างเหตุการณ์ใหม่

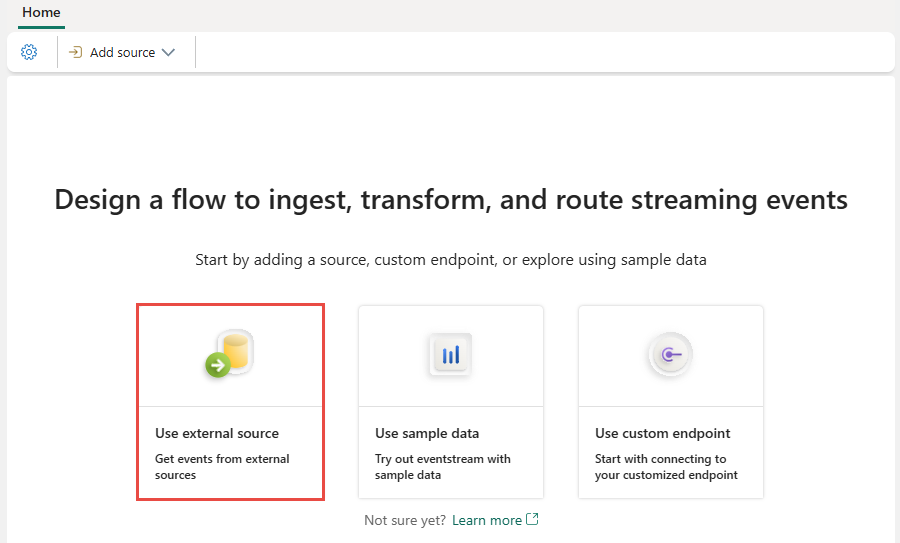

บนหน้าจอถัดไป เลือก เพิ่มแหล่งข้อมูลภายนอก

กําหนดค่าและเชื่อมต่อกับ Apache Kafka

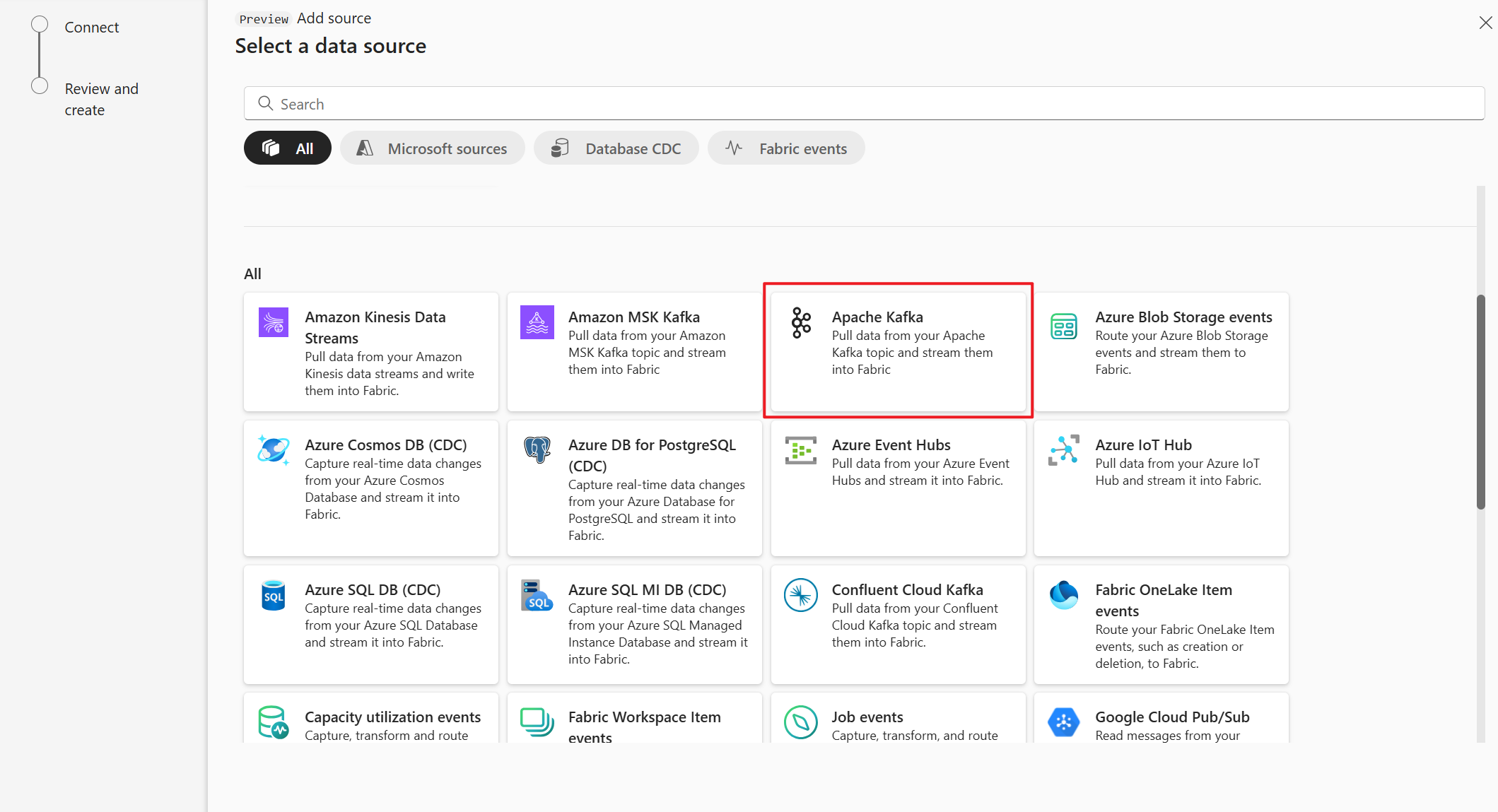

บนหน้าเลือกแหล่งข้อมูล เลือก Apache Kafka

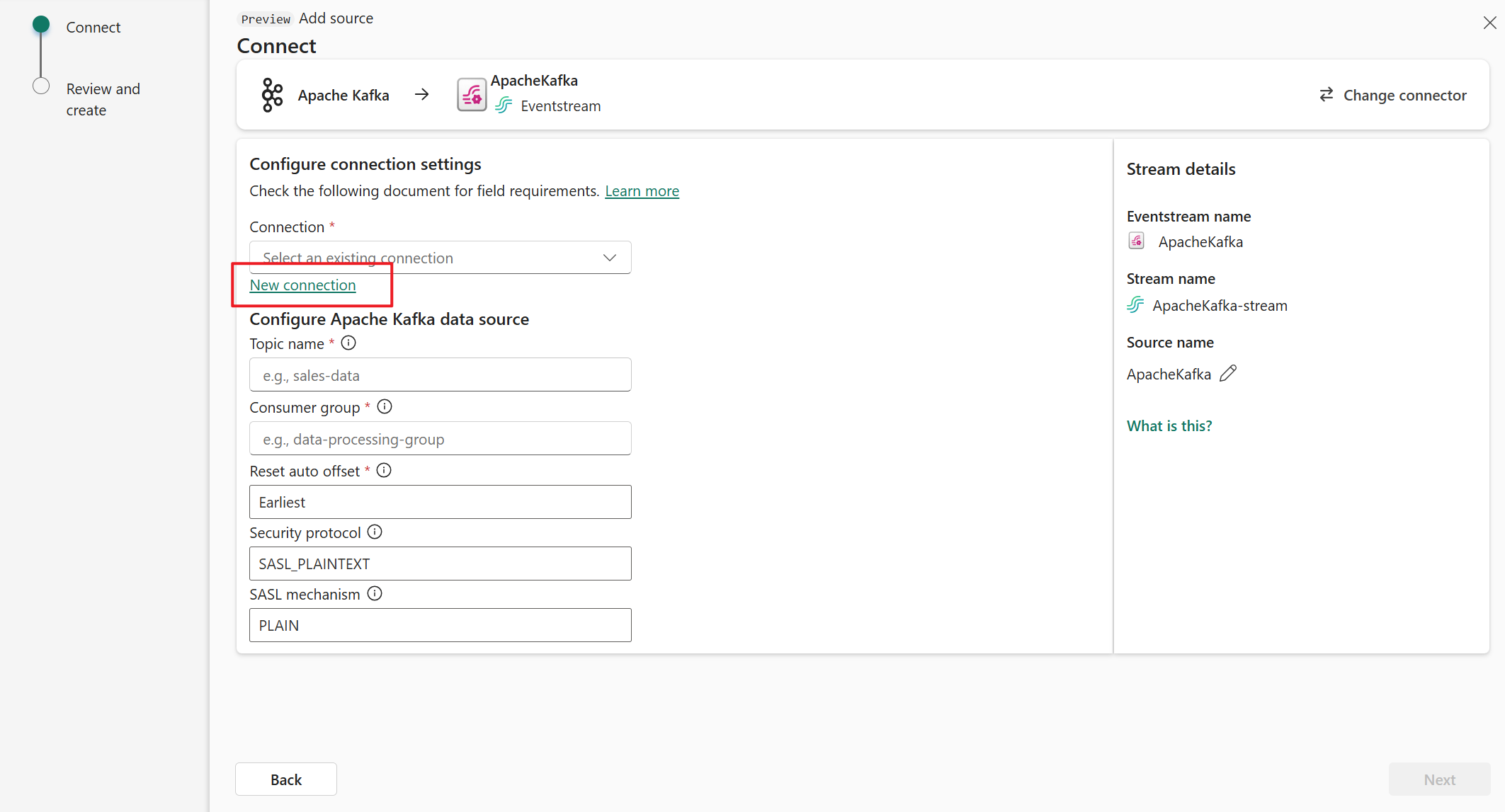

บนหน้า เชื่อมต่อ เลือก การเชื่อมต่อใหม่

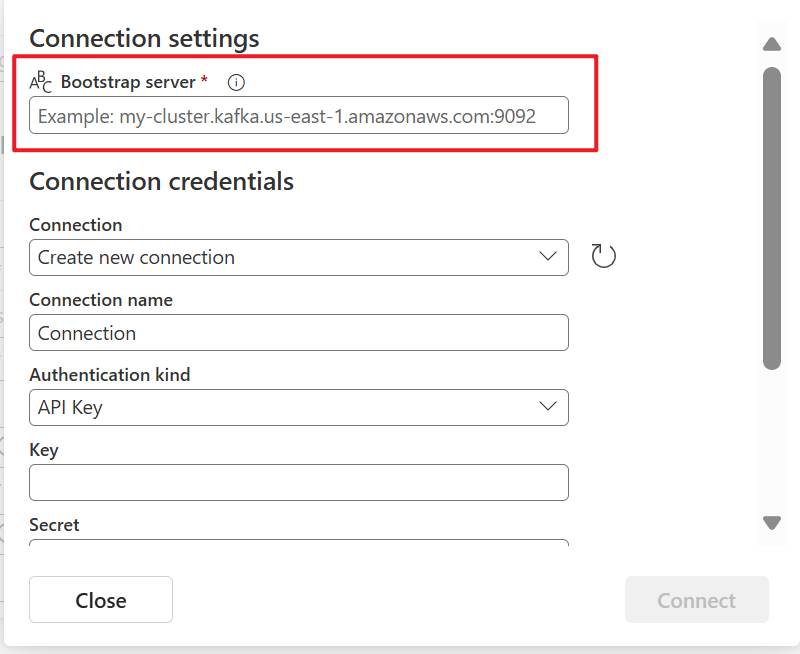

ในส่วน การตั้งค่าการเชื่อมต่อ สําหรับเซิร์ฟเวอร์ Bootstrap ให้ใส่ที่อยู่เซิร์ฟเวอร์ Apache Kafka ของคุณ

ในส่วน ข้อมูลประจําตัวการเชื่อมต่อ ถ้าคุณมีการเชื่อมต่อที่มีอยู่ไปยังคลัสเตอร์ Apache Kafka ให้เลือกจากรายการดรอปดาวน์สําหรับ การเชื่อมต่อ มิฉะนั้น ให้ทําตามขั้นตอนเหล่านี้:

- สําหรับ ชื่อการเชื่อมต่อ ให้ใส่ชื่อสําหรับการเชื่อมต่อ

- สําหรับ ชนิดการรับรองความถูกต้อง ให้ยืนยันว่ามี การเลือกคีย์ API แล้ว

- สําหรับ คีย์ และข้อมูล ลับ ให้ใส่คีย์ API และคีย์ลับ

เลือก เชื่อมต่อ

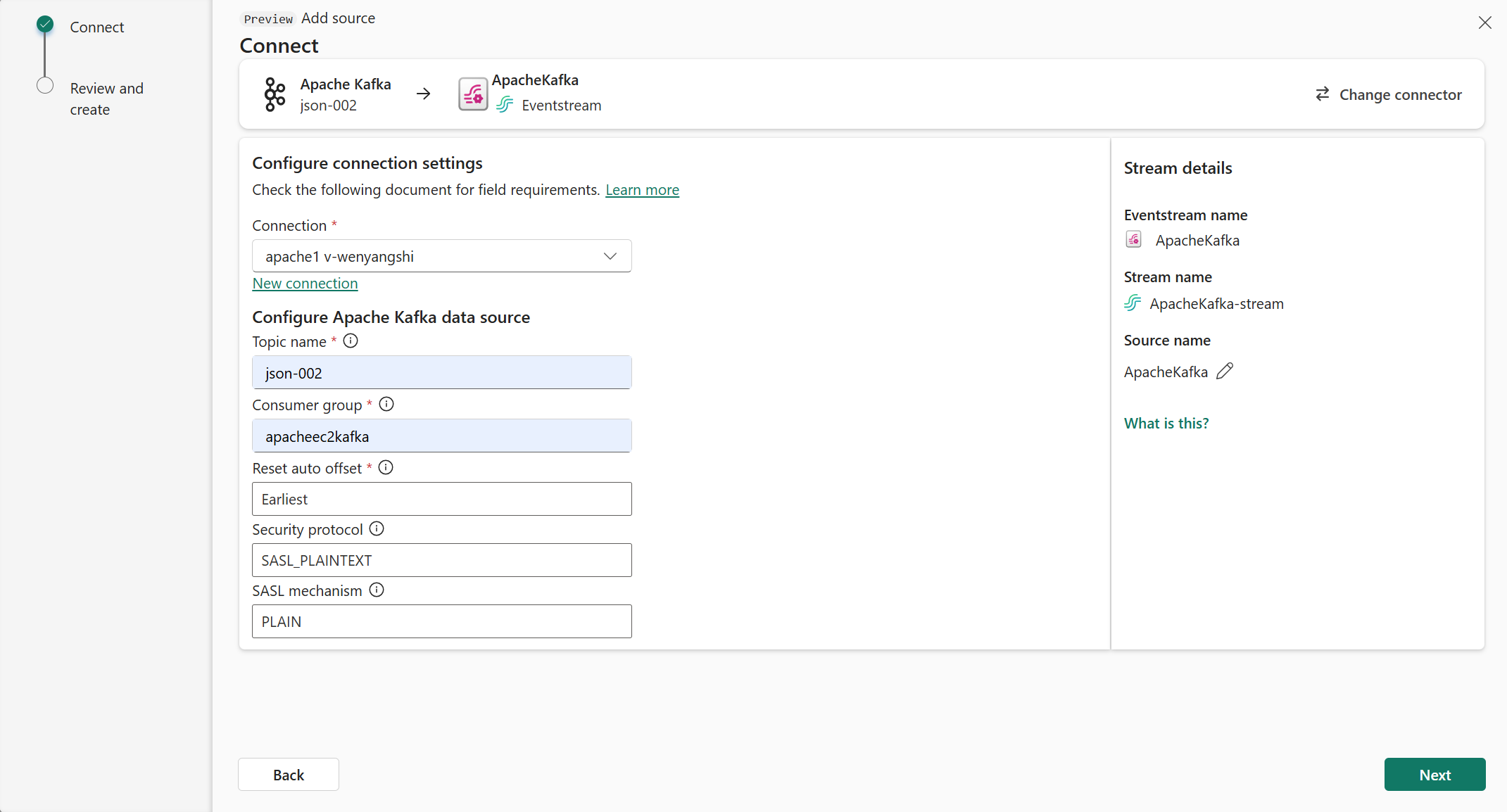

ตอนนี้ ที่หน้าเชื่อมต่อ ให้ทําตามขั้นตอนเหล่านี้

สําหรับ หัวข้อ ให้ป้อนหัวข้อ Kafka

สําหรับ กลุ่มผู้บริโภค ให้ป้อนกลุ่มผู้บริโภคของคลัสเตอร์ Apache Kafka ของคุณ เขตข้อมูลนี้มอบกลุ่มผู้บริโภคเฉพาะสําหรับการรับเหตุการณ์ให้กับคุณ

เลือก รีเซ็ตออฟเซต อัตโนมัติเพื่อระบุตําแหน่งที่จะเริ่มต้นค่าชดเชยการอ่านถ้าไม่มีการยอมรับ

สําหรับโพรโทคอลความปลอดภัย ค่าเริ่มต้นจะถูก SASL_PLAINTEXT

หมายเหตุ

ปัจจุบันแหล่งข้อมูล Apache Kafka สนับสนุนเฉพาะการส่งข้อมูลที่เข้ารหัสลับ (SASL_PLAINTEXT และ PLAINTEXT) ระหว่างคลัสเตอร์ Apache Kafka และ Eventstream ของคุณ การสนับสนุนสําหรับการส่งข้อมูลที่เข้ารหัสลับผ่าน SSL จะพร้อมใช้งานในเร็วๆ นี้

กลไก SASL ตามค่าเริ่มต้นมักจะเป็นแบบ PLAIN เว้นแต่ว่ากําหนดค่าเป็นอย่างอื่น คุณสามารถเลือก กลไก SCRAM-SHA-256 หรือ SCRAM-SHA-512 ที่เหมาะสมกับข้อกําหนดด้านความปลอดภัยของคุณ

เลือก ถัดไป บนหน้าจอ ตรวจสอบและสร้าง ให้ตรวจสอบสรุป จากนั้นเลือก เพิ่ม

ดูเหตุการณ์ที่อัปเดตแล้ว

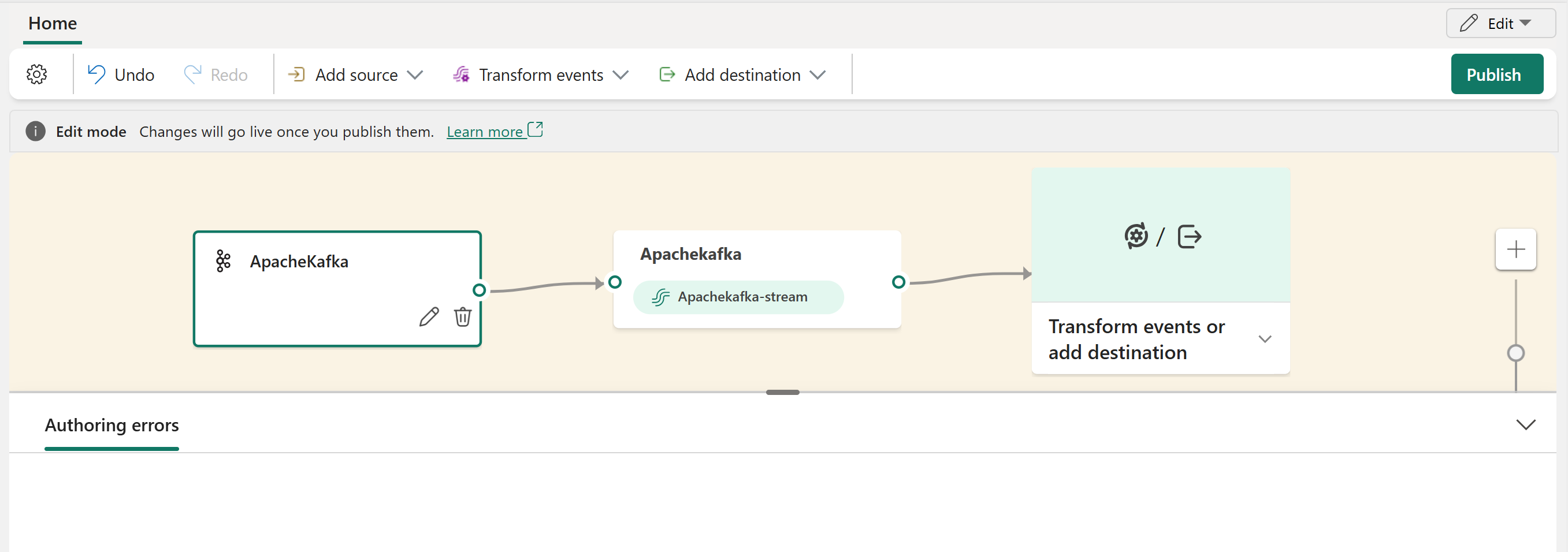

คุณสามารถดูแหล่งที่มาของ Apache Kafka ที่เพิ่มลงในการสตรีมของคุณในโหมดแก้ไขได้

หลังจากที่คุณทําตามขั้นตอนเหล่านี้แหล่งข้อมูล Apache Kafka จะพร้อมใช้งานสําหรับการแสดงภาพใน Live view

เนื้อหาที่เกี่ยวข้อง

ตัวเชื่อมต่ออื่นๆ: