Priser för Data Factory i Microsoft Fabric

Data Factory i Microsoft Fabric tillhandahåller serverlösa och elastiska dataintegreringstjänstfunktioner som skapats för molnskala. Det finns ingen beräkningskraft med fast storlek som du behöver planera för högsta belastning. I stället behöver du ange vilka åtgärder som ska utföras vid redigering av pipelines och dataflöden, vilket innebär en mängd förbrukade infrastrukturkapacitetsenheter, som du kan spåra ytterligare med hjälp av appen Kapacitetsmått för Microsoft Fabric för att planera och hantera dina förbrukningsmått. På så sätt kan du utforma ETL-processerna på ett mycket mer skalbart sätt. Dessutom debiteras Data Factory, precis som andra infrastrukturresurser, på en förbrukningsbaserad plan, vilket innebär att du bara betalar för det du använder.

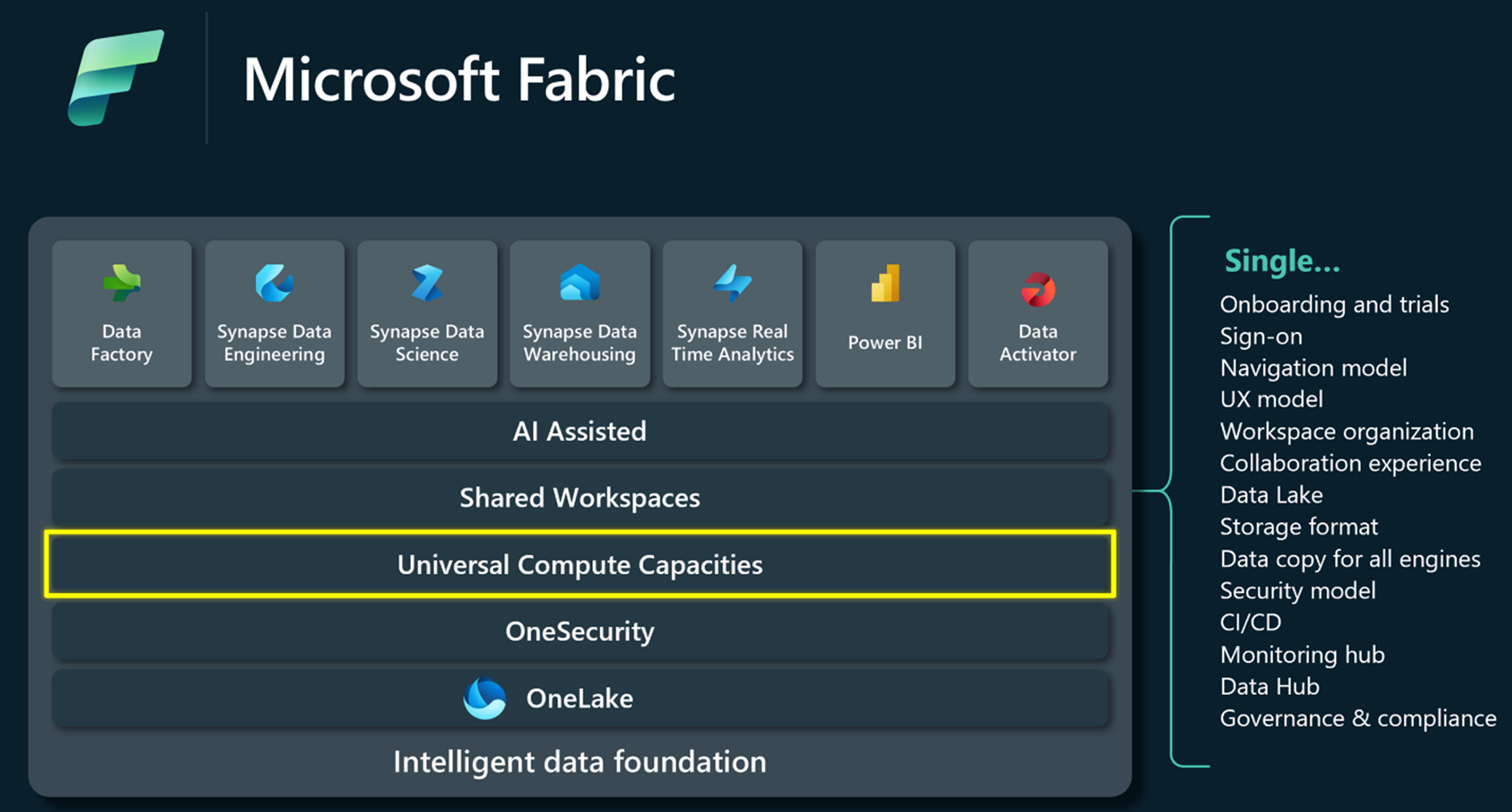

Microsoft Fabric-kapaciteter

Fabric är en enhetlig dataplattform som erbjuder delade upplevelser, arkitektur, styrning, efterlevnad och fakturering. Kapaciteter ger den databehandlingskraft som driver alla dessa upplevelser. De erbjuder ett enkelt och enhetligt sätt att skala resurser för att möta kundernas efterfrågan och kan enkelt ökas med en SKU-uppgradering.

Du kan enkelt hantera dina fabric Data Factory-körningskostnader med förenklad fakturering. Ytterligare användare kräver ingen kostnadshantering per användare, och du kan spara pengar genom att planera och genomföra Infrastrukturresurser för dina dataintegreringsprojekt framåt. Med alternativet betala per användning kan du enkelt skala upp och ned dina kapaciteter för att justera deras beräkningskraft och pausa deras kapaciteter när de inte används för att spara kostnader. Läs mer om infrastrukturresurser och användningsfakturering.

Prismätare för Data Factory

Oavsett om du är medborgare eller professionell utvecklare kan du med Data Factory utveckla dataintegreringslösningar i företagsskala med nästa generations dataflöden och datapipelines. Dessa upplevelser fungerar på flera tjänster med olika kapacitetsmätare. Datapipelines använder dataorkestrerings- och dataförflyttningsmätare , medan Dataflow Gen2 använder Standard Compute och High Scale Compute. Dessutom, precis som andra infrastrukturresurser, är den vanliga mätaren för lagringsförbrukning OneLake Storage.

Prissättningsexempel

Här är några exempelscenarier för prissättning av datapipelines:

- Ladda 1 TB Parquet till ett datalager

- Importera 1 TB Parquet till ett informationslager via mellanlagring

- Läsa in 1 TB CSV-filer till en Lakehouse-tabell

- Läsa in 1 TB CSV-filer till en Lakehouse-fil med binär kopia

- Ladda 1 TB Parquet till en Lakehouse-tabell

Här följer några prisexempel för Dataflow Gen2:

- Läsa in en lokal CSV-fil på 2 GB till en Lakehouse-tabell

- Ladda 2 GB Parquet till en Lakehouse-tabell