Prisscenario med hjälp av en datapipeline för att läsa in 1 TB Parquet-data till ett informationslager med mellanlagring

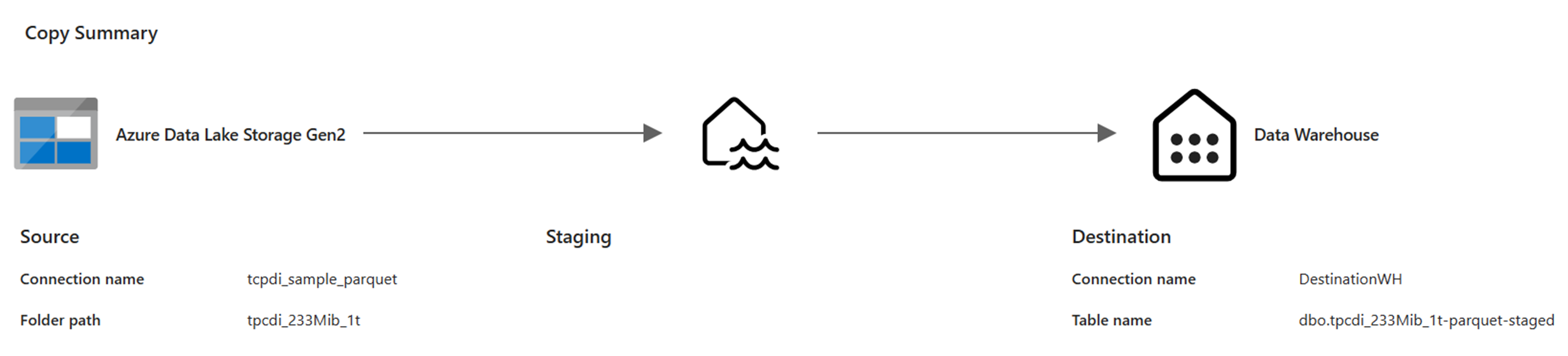

I det här scenariot användes en aktiviteten Kopiera i en datapipeline för att läsa in 1 TB Parquet-tabelldata som lagras i Azure Data Lake Storage (ADLS) Gen2 till ett informationslager med mellanlagring i Microsoft Fabric.

Priserna som används i följande exempel är hypotetiska och avser inte att innebära exakta faktiska priser. Dessa är bara för att visa hur du kan beräkna, planera och hantera kostnader för Data Factory-projekt i Microsoft Fabric. Eftersom Infrastrukturkapaciteter är unikt prissatta mellan regioner använder vi prissättningen betala per användning för en Infrastrukturkapacitet i USA, västra 2 (en typisk Azure-region) till 0,18 USD per CU per timme. Se Microsoft Fabric – Priser för att utforska andra prisalternativ för Infrastrukturkapacitet.

Konfiguration

För att åstadkomma det här scenariot måste du skapa en pipeline med följande konfiguration:

Kostnadsuppskattning med hjälp av fabric Metrics-appen

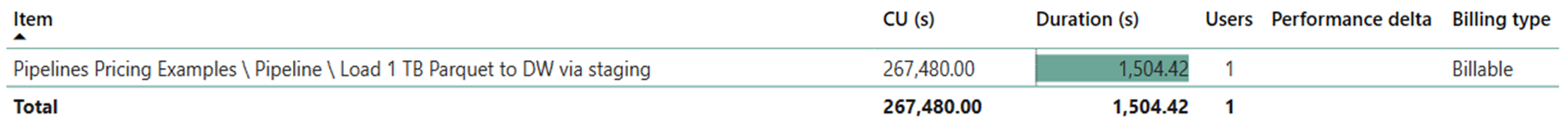

Dataförflyttningsåtgärden använde 267 480 CU-sekunder med en varaktighet på 1504,42 sekunder (25,07 minuter) medan aktivitetskörningen var null eftersom det inte fanns några icke-kopieringsaktiviteter i pipelinekörningen.

Kommentar

Även om den rapporteras som ett mått är den faktiska varaktigheten för körningen inte relevant när du beräknar de effektiva CU-timmarna med Fabric Metrics-appen eftersom CU-sekundersmåttet som det också rapporterar redan står för dess varaktighet.

| Metric | Dataförflyttningsåtgärd |

|---|---|

| CU-sekunder | 267 480 CU-sekunder |

| Effektiva CU-timmar | (267 480) / (60*60) CU-timmar = 74,3 CU-timmar |

Total körningskostnad på $0.18/CU hour = (74.3 CU-hours) * ($0.18/CU hour) ~= $13.37