Prisscenario med Dataflow Gen2 för att läsa in 2 GB Parquet-data till en Lakehouse-tabell

I det här scenariot användes Dataflow Gen2 för att läsa in 2 GB Parquet-data som lagras i Azure Data Lake Storage (ADLS) Gen2 till en Lakehouse-tabell i Microsoft Fabric. Vi använde provdata från NYC Taxi-green för Parquet-data.

Priserna som används i följande exempel är hypotetiska och avser inte att innebära exakta faktiska priser. Dessa är bara för att visa hur du kan beräkna, planera och hantera kostnader för Data Factory-projekt i Microsoft Fabric. Dessutom, eftersom Fabric-kapaciteter är unikt prissatta mellan regioner, använder vi betala-efter-användning-prissättning för en Fabric-kapacitet i US West 2 (en typisk Azure-region) med en kostnad på 0,18 USD per CU per timme. Mer information finns i Microsoft Fabric – Prissättning för att utforska andra prissättningsalternativ för Fabric-kapacitet.

Konfiguration

För att åstadkomma det här scenariot måste du skapa ett dataflöde med följande steg:

- Initiera Dataflöde: Hämta 2 GB Parquet-filer från ADLS Gen2-lagringskonto.

- Konfigurera Power Query:

- Gå till Power Query.

- Kontrollera att alternativet för iscensättning av frågan är aktiverat.

- Fortsätt att kombinera Parquet-filerna.

- Datatransformering:

- Höj upp rubriker för tydlighetens skull.

- Ta bort onödiga kolumner.

- Justera kolumndatatyper efter behov.

- Definiera utdatamål:

- Konfigurera Lakehouse som datautdatamål.

- I det här exemplet skapades och användes ett Lakehouse i Fabric.

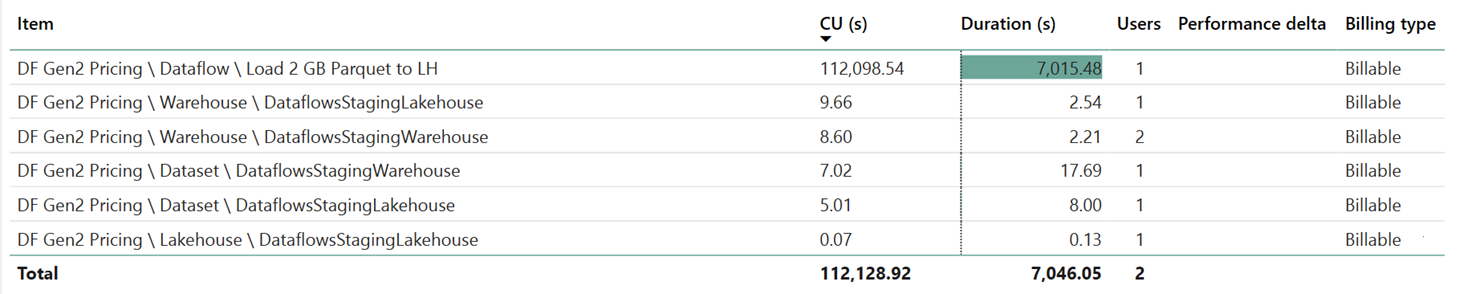

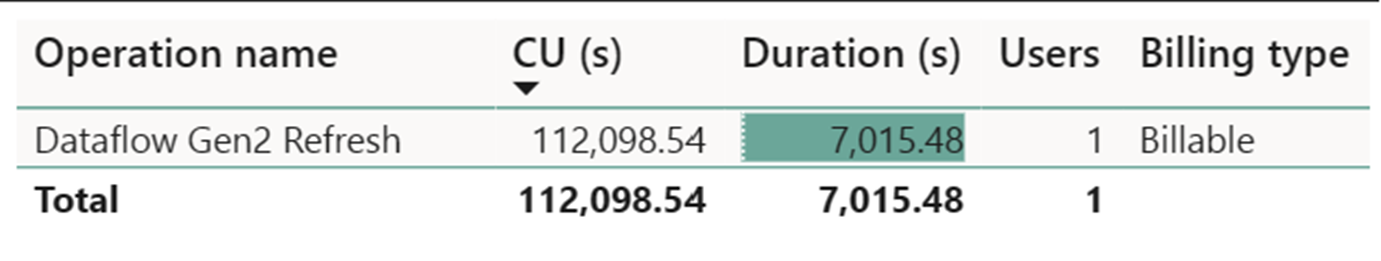

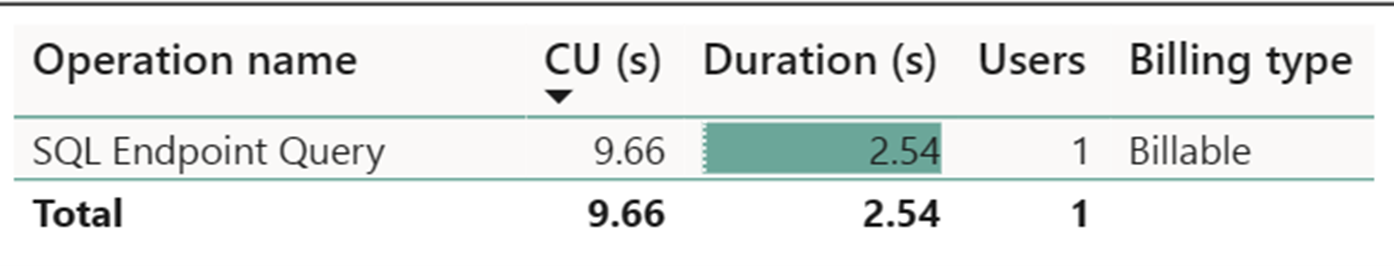

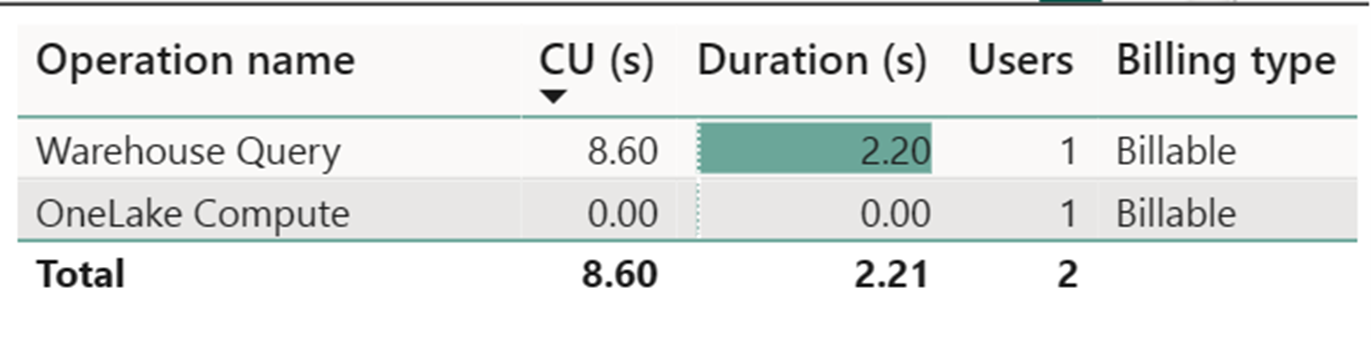

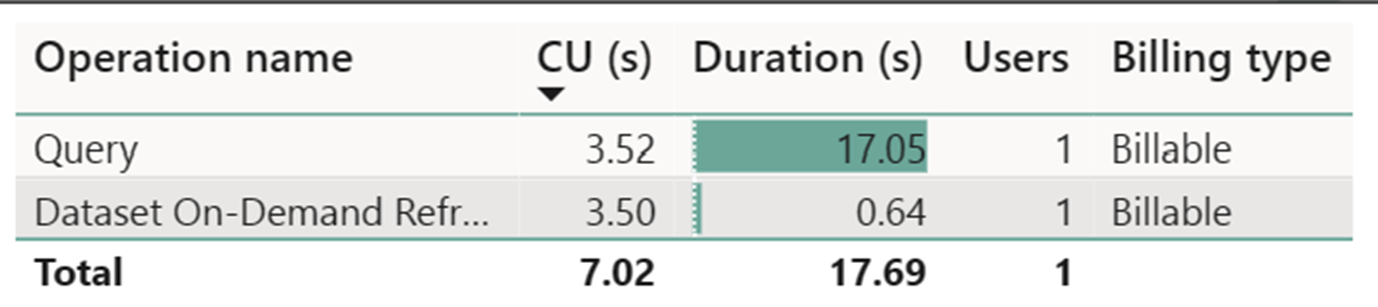

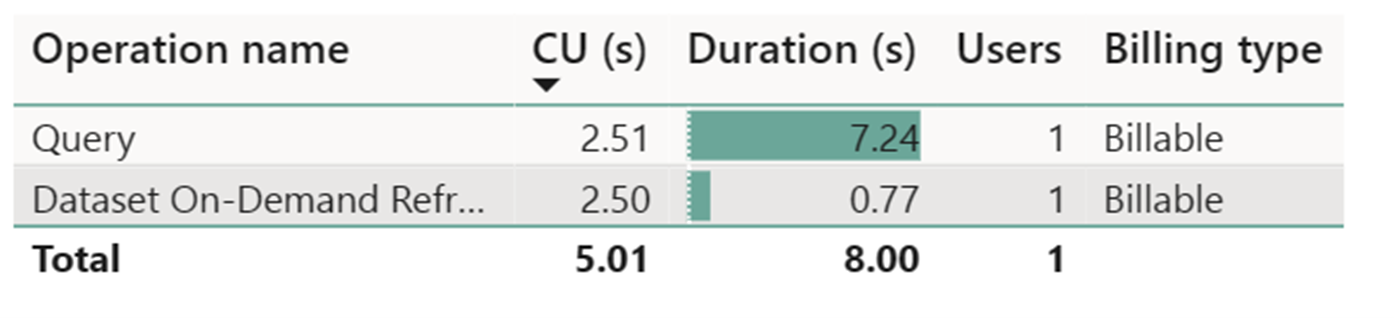

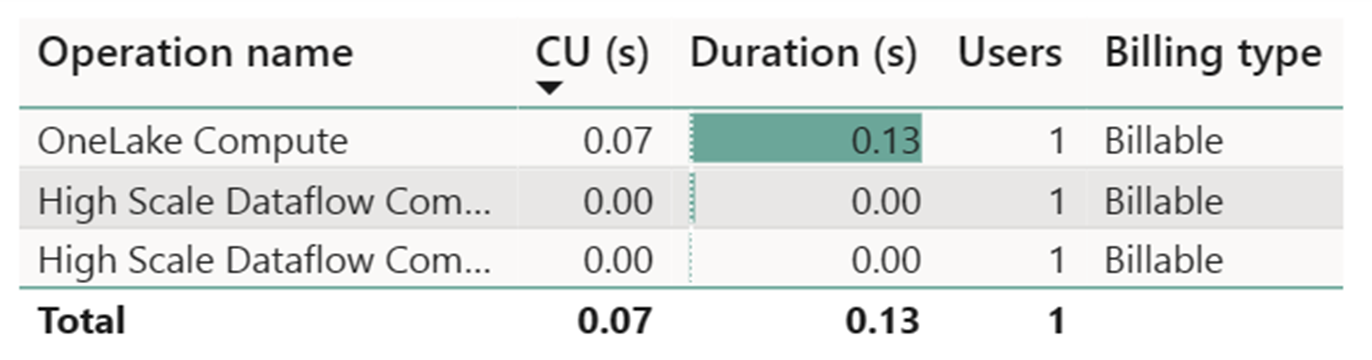

Kostnadsuppskattning med hjälp av fabric Metrics-appen

Dataflödesmätaren för hög skala registrerade försumbar aktivitet. Standardräknaren för beräkning vid uppdateringsoperationer för Dataflow Gen2 förbrukar 112,098.540 beräkningsenheter (CUs). Det är viktigt att tänka på att andra åtgärder, inklusive Warehouse Query, SQL Endpoint Query och Dataset On-Demand Refresh, utgör detaljerade aspekter av Dataflow Gen2-implementeringen som för närvarande är transparenta och nödvändiga för respektive åtgärder. Dessa åtgärder kommer dock att döljas i framtida uppdateringar och bör ignoreras när du beräknar kostnader för Dataflow Gen2.

Not

Även om den rapporteras som ett mått är den faktiska varaktigheten för körningen inte relevant när du beräknar de effektiva CU-timmarna med Fabric Metrics-appen eftersom CU-sekundersmåttet som det också rapporterar redan står för dess varaktighet.

| Metrik | Standardberäkning | Beräkning i hög skala |

|---|---|---|

| Totalt antal CU-sekunder | 112 098,54 CU-sekunder | 0 CU sekunder |

| Fakturerade effektiva CU-timmar | 112 098,54 / (60*60) = 31,14 CU timmar | 0/ (60*60) = 0 CU-timmar |

Total körningskostnad på $0.18/CU timme = (31.14 CU-timmar) * ($0.18/CU timme) ~= $5.60