Självstudiekurs i Lakehouse: Importera data till lakehouse

I den här handledningen matar du in fler dimensions- och faktatabeller från Wide World Importers (WWI) in i lakehouse.

Förutsättningar

- Om du inte har ett sjöhus måste du skapa ett sjöhus.

Mata in data

I det här avsnittet använder du Kopiera data-aktiviteten i Data Factory-pipelinen för att mata in exempeldata från ett Azure-lagringskonto till Filer-avsnittet i lakehouse som du skapade tidigare.

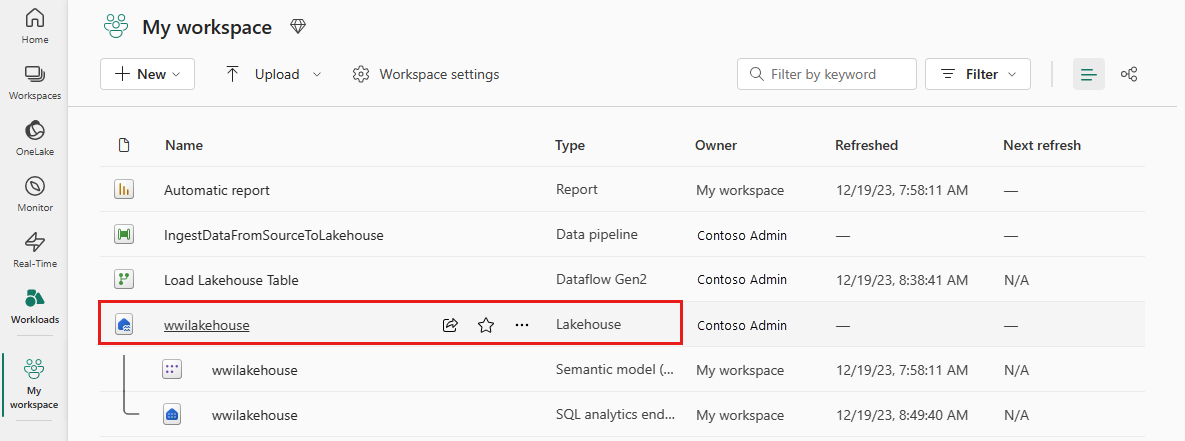

Välj Arbetsytor i det vänstra navigeringsfönstret och välj sedan din nya arbetsyta på menyn Arbetsytor . Objektvyn för arbetsytan visas.

I alternativet Nytt objekt i arbetsytans menyfliksområde väljer du Datapipeline.

I dialogrutan Ny pipeline anger du namnet som IngestDataFromSourceToLakehouse och väljer Skapa. En ny datafabrikspipeline skapas och öppnas.

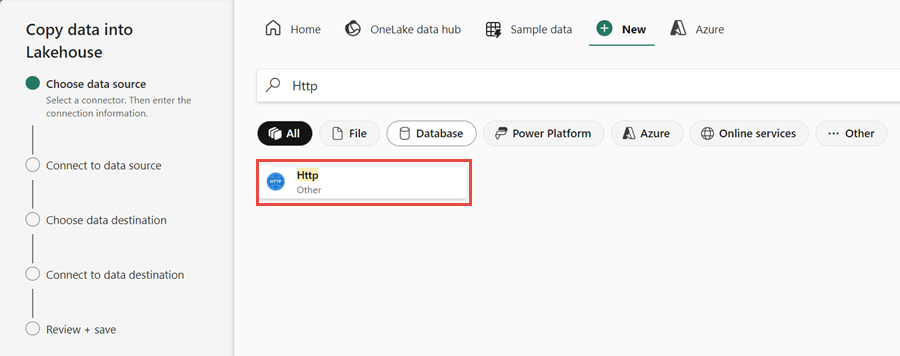

Konfigurera sedan en HTTP-anslutning för att importera exempeldata från World Wide Importers till Lakehouse. I listan med Nya källor väljer du Visa mer, söker efter Http och väljer den.

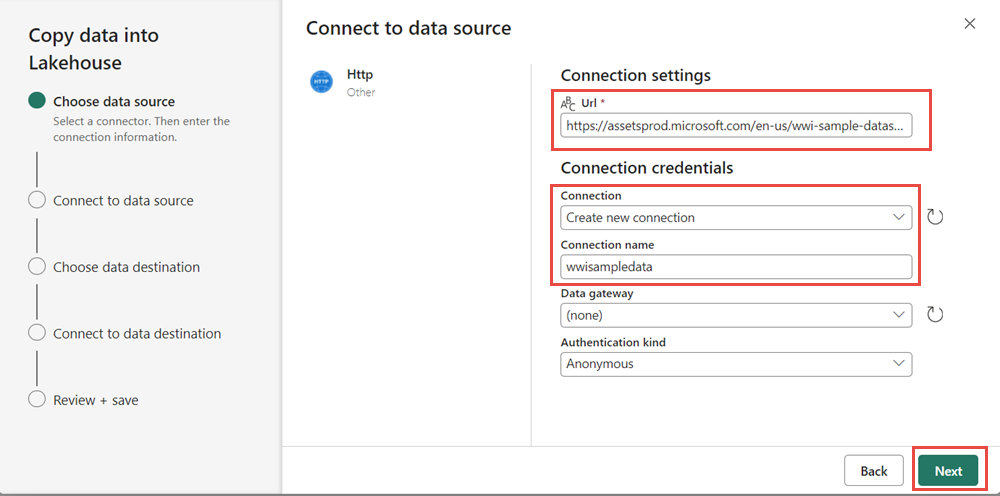

I fönstret Anslut till datakälla anger du informationen i tabellen nedan och väljer Nästa.

Egendom Värde webbadress https://assetsprod.microsoft.com/en-us/wwi-sample-dataset.zipAnslutning Skapa en ny anslutning Anslutningens namn wwisampledata Datagateway Ingen Typ av autentisering Anonym

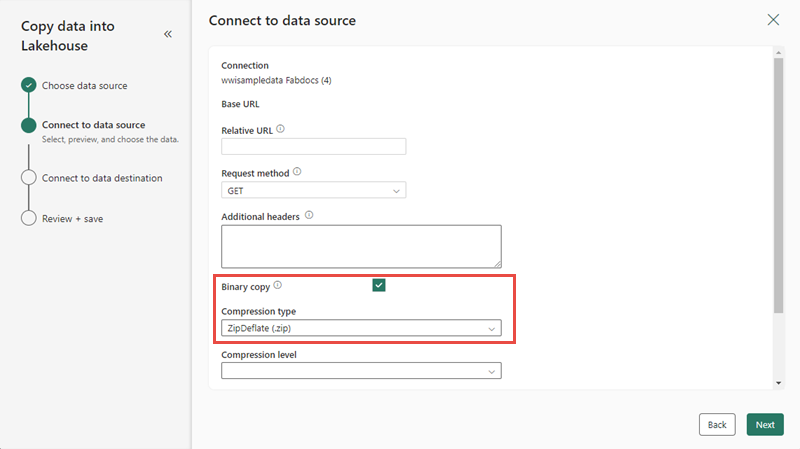

I nästa steg aktiverar du den binära kopian och väljer ZipDeflate (.zip) som komprimeringstyp eftersom källan är en .zip fil. Behåll de andra fälten som standardvärden och välj Nästa.

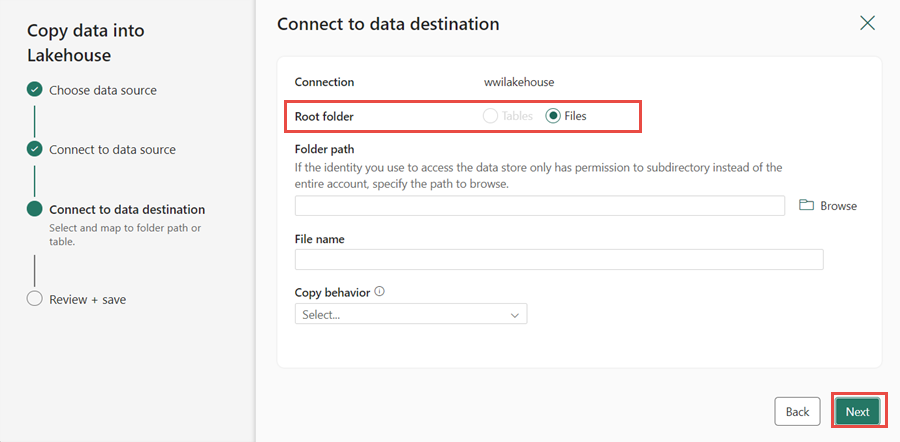

I fönstret Anslut till datamål anger du Rotmappen som Filer och väljer Nästa. Detta kommer att skriva data till avsnittet Filer i lakehouse.

Välj Nästa, målfilformatet anges automatiskt till Binary. Välj sedan Spara+Kör. Du kan schemalägga pipelines för att uppdatera data med jämna mellanrum. I den här handledningen kör vi bara pipelinen en gång. Datakopieringsprocessen tar cirka 10–15 minuter att slutföra.

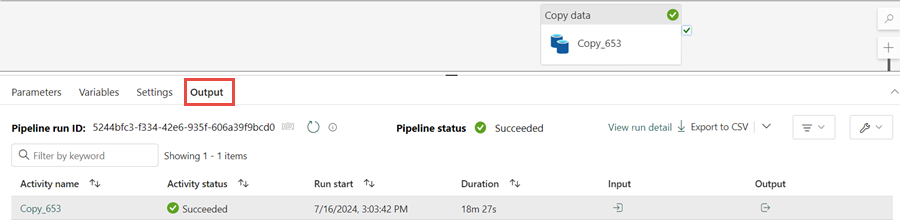

Du kan övervaka pipelinekörningen och aktiviteten på fliken Utdata . Du kan också visa detaljerad information om dataöverföring genom att välja glasögonikonen bredvid pipelinenamnet, som visas när du hovrar över namnet.

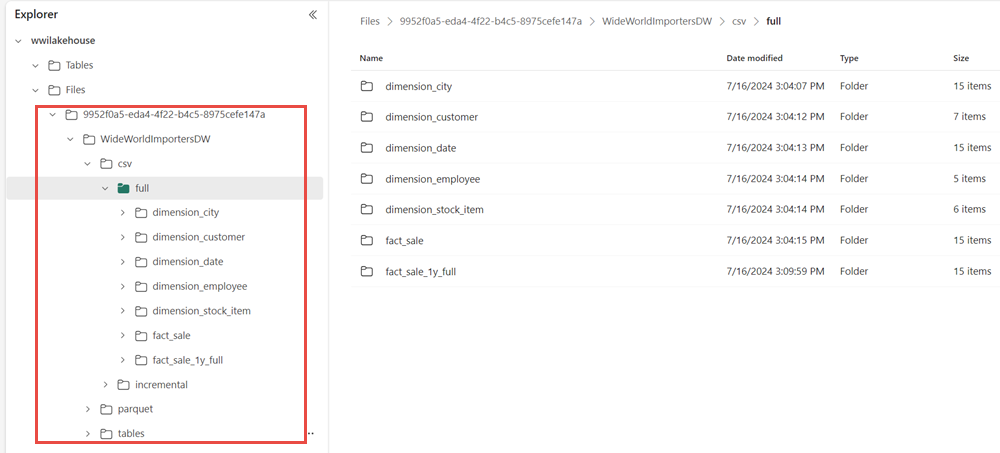

När pipelinen har körts går du till lakehouse (wwilakehouse) och öppnar utforskaren för att se importerade data.

Kontrollera att mappen WideWorldImportersDW finns i Utforskarvyn och innehåller data för alla tabeller.

Data skapas under avsnittet Filer i Lakehouse Explorer. En ny mapp med GUID innehåller alla data som behövs. Byt namn på GUID till wwi-raw-data

Information om hur du läser in inkrementella data i ett sjöhus finns i Inkrementellt läsa in data från ett informationslager till ett sjöhus.