Modellkatalog och samlingar i Azure AI Foundry-portalen

Viktigt!

Objekt markerade (förhandsversion) i den här artikeln är för närvarande i offentlig förhandsversion. Den här förhandsversionen tillhandahålls utan ett serviceavtal och vi rekommenderar det inte för produktionsarbetsbelastningar. Vissa funktioner kanske inte stöds eller kan vara begränsade. Mer information finns i Kompletterande villkor för användning av Microsoft Azure-förhandsversioner.

Modellkatalogen i Azure AI Foundry-portalen är navet för att identifiera och använda ett brett utbud av modeller för att skapa generativa AI-program. Modellkatalogen innehåller hundratals modeller mellan modellleverantörer som Azure OpenAI Service, Mistral, Meta, Cohere, NVIDIA och Hugging Face, inklusive modeller som Microsoft har tränat. Modeller från andra leverantörer än Microsoft är icke-Microsoft-produkter enligt definitionen i Microsofts produktvillkor och omfattas av de villkor som tillhandahålls med modellerna.

Modellsamlingar

Modellkatalogen organiserar modeller i olika samlingar:

Kuraterad av Azure AI: De mest populära icke-Microsoft-modellerna med öppen vikt och proprietära modeller som paketerats och optimerats för att fungera sömlöst på Azure AI-plattformen. Användning av dessa modeller omfattas av modellproviderns licensvillkor. När du distribuerar dessa modeller i Azure AI Foundry-portalen omfattas deras tillgänglighet av tillämpligt serviceavtal för Azure (SLA) och Microsoft tillhandahåller stöd för distributionsproblem.

Modeller från partner som Meta, NVIDIA och Mistral AI är exempel på modeller som är tillgängliga i den här samlingen i katalogen. Du kan identifiera dessa modeller genom att söka efter en grön bockmarkering på modellpanelerna i katalogen. Eller så kan du filtrera efter samlingen Curated by Azure AI .

Azure OpenAI-modeller är exklusivt tillgängliga i Azure: Flaggskeppsmodeller för Azure OpenAI som är tillgängliga via en integrering med Azure OpenAI Service. Microsoft stöder dessa modeller och deras användning enligt produktvillkoren och serviceavtalet för Azure OpenAI Service.

Öppna modeller från hubben Hugging Face: Hundratals modeller från hubben Hugging Face för realtidsinferens med hanterad beräkning. Hugging Face skapar och underhåller modeller som anges i den här samlingen. Om du vill ha hjälp kan du använda forumet för att krama ansikte eller krama ansiktssupport. Läs mer i Distribuera öppna modeller med Azure AI Foundry.

Du kan skicka en begäran om att lägga till en modell i modellkatalogen med hjälp av det här formuläret.

Översikt över modellkatalogfunktioner

Du kan söka efter och identifiera modeller som uppfyller dina behov genom keyword search och filters. Modellkatalogen erbjuder även mått för prestandamått för modellprestanda för utvalda modeller. Du kan komma åt riktmärket genom att Compare Models klicka eller från fliken Benchmark för modellkortet.

På modellkortet hittar du:

- Snabbfakta: du ser viktig information om modellen snabbt.

- Information: Den här sidan innehåller detaljerad information om modellen, inklusive beskrivning, versionsinformation, datatyp som stöds osv.

- Prestandamått: du hittar prestandamått för utvalda modeller.

- Befintliga distributioner: Om du redan har distribuerat modellen hittar du den under fliken Befintliga distributioner.

- Kodexempel: Du hittar de grundläggande kodexemplen för att komma igång med AI-programutveckling.

- Licens: Du hittar juridisk information som rör modelllicensiering.

- Artefakter: Den här fliken visas endast för öppna modeller. Du kan se modelltillgångarna och ladda ned dem via användargränssnittet.

Modelldistribution: Azure OpenAI

Mer information om Azure OpenAI-modeller finns i Vad är Azure OpenAI Service?.

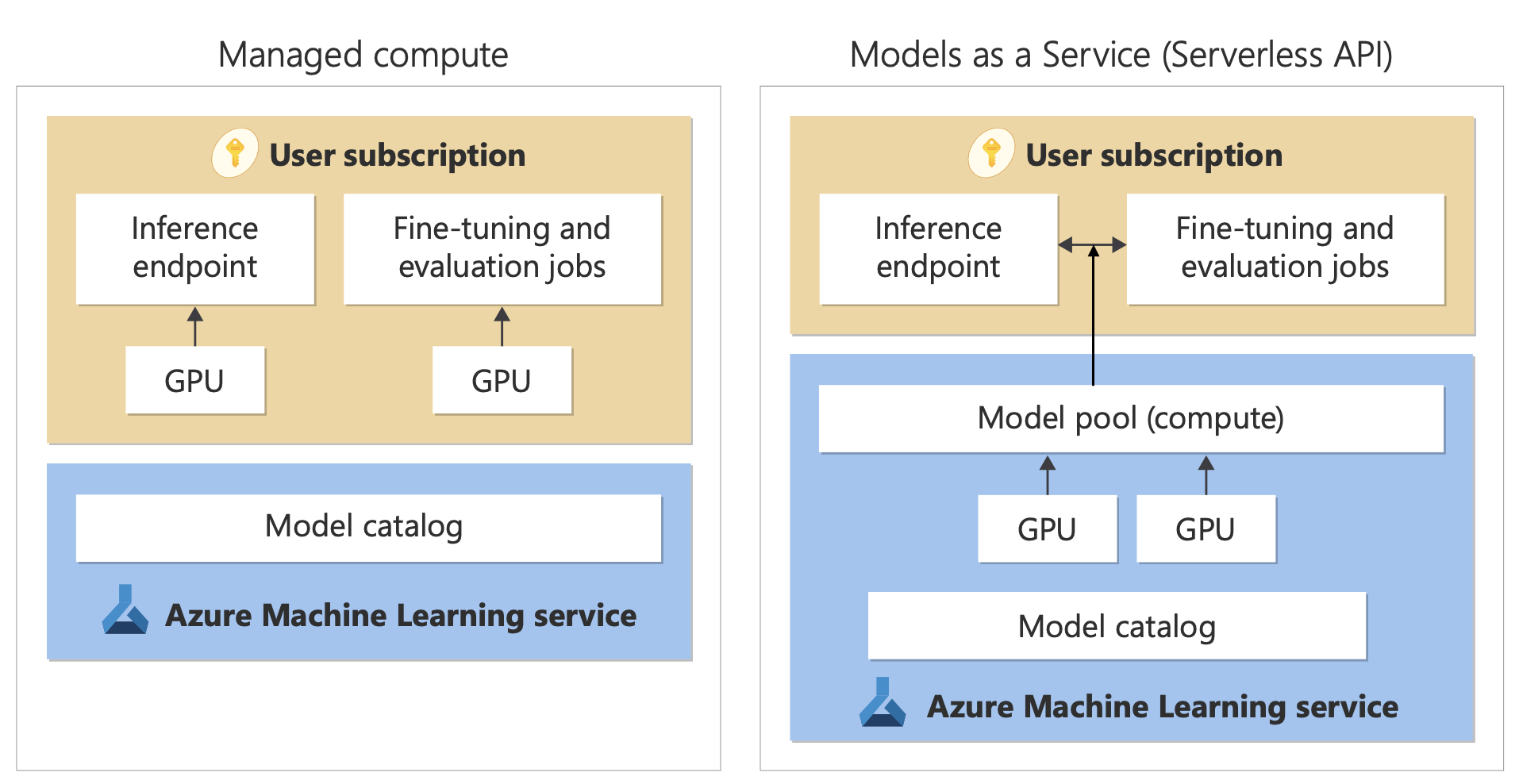

Modelldistribution: Hanterade beräknings- och serverlösa API:er

Förutom Azure OpenAI Service-modeller erbjuder modellkatalogen två olika sätt att distribuera modeller för din användning: hanterad beräkning och serverlösa API:er.

De distributionsalternativ och funktioner som är tillgängliga för varje modell varierar enligt beskrivningen i följande tabeller. Läs mer om databehandling med distributionsalternativen.

Funktioner för modelldistributionsalternativ

| Funktioner | Hantera databearbetning | Serverlöst API (betala per token) |

|---|---|---|

| Distributionsupplevelse och fakturering | Modellvikter distribueras till dedikerade virtuella datorer med hanterad beräkning. En hanterad beräkning, som kan ha en eller flera distributioner, gör ett REST API tillgängligt för slutsatsdragning. Du debiteras för den virtuella datorns kärntimmar som distributionerna använder. | Åtkomst till modeller sker via en distribution som etablerar ett API för åtkomst till modellen. API:et ger åtkomst till den modell som Microsoft är värd för och hanterar för slutsatsdragning. Du debiteras för indata och utdata till API:erna, vanligtvis i token. Prisinformation tillhandahålls innan du distribuerar. |

| API-autentisering | Nycklar och Microsoft Entra-autentisering. | Endast nycklar. |

| Innehållssäkerhet | Använd API:er för Azure AI Content Safety-tjänsten. | Azure AI-innehållssäkerhetsfilter är tillgängliga integrerade med slutsatsdragnings-API:er. Azure AI-innehållssäkerhetsfilter faktureras separat. |

| Nätverksisolering | Konfigurera hanterade nätverk för Azure AI Foundry-hubbar. | Hanterad beräkning följer flagginställningen för offentlig nätverksåtkomst (PNA). Mer information finns i avsnittet Nätverksisolering för modeller som distribueras via serverlösa API:er senare i den här artikeln. |

Tillgängliga modeller för distributionsalternativ som stöds

Följande lista innehåller serverlösa API-modeller. Azure OpenAI-modeller finns i Azure OpenAI-tjänstmodeller.

| Modell | Hantera databearbetning | Serverlöst API (betala per token) |

|---|---|---|

| AI21-familjemodeller | Inte tillgängliga | Jamba-1.5-Mini Jamba-1.5-Large |

| Gemensamma familjemodeller | Inte tillgängliga | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual Cohere-rerank-v3-english Cohere-rerank-v3-multilingual |

| DeepSeek-modeller från Microsoft | Inte tillgängliga | DeepSeek-R1 |

| Greta | Inte tillgängliga | Gretel-Navigator |

| Ai-familjemodeller för hälso- och sjukvård | MedImageParse MedImageInsight CxrReportGen Virchow Virchow2 Prisma BiomedCLIP-PubMedBERT microsoft-llava-med-v1.5 m42-health-llama3-med4 biomistral-biomistral-7b microsoft-biogpt-large-pub microsoft-biomednlp-pub stanford-crfm-biomedlm medicalai-clinicalbert microsoft-biogpt microsoft-biogpt-large microsoft-biomednlp-pub |

Inte tillgänglig |

| JAIS | Inte tillgängliga | jais-30b-chat |

| Meta Llama-familjemodeller | Llama-3.3-70B-Instruct Llama-3.2-3B-Instruct Llama-3.2-1B-Instruct Llama-3.2-1B Llama-3.2-90B-Vision-Instruct Llama-3.2-11B-Vision-Instruct Llama-3.1-8B-Instruct Llama-3.1-8B Llama-3.1-70B-Instruct Llama-3.1-70B Llama-3-8B-Instruct Llama-3-70B Llama-3-8B Llama-Guard-3-1B Llama-Guard-3-8B Llama-Guard-3-11B-Vision Llama-2-7b Llama-2-70b Llama-2-7b-chat Llama-2-13b-chat CodeLlama-7b-hf CodeLlama-7b-Instruct-hf CodeLlama-34b-hf CodeLlama-34b-Python-hf CodeLlama-34b-Instruct-hf CodeLlama-13b-Instruct-hf CodeLlama-13b-Python-hf Prompt-Guard-86M CodeLlama-70b-hf |

Llama-3.3-70B-Instruct Llama-3.2-90B-Vision-Instruct Llama-3.2-11B-Vision-Instruct Llama-3.1-8B-Instruct Llama-3.1-70B-Instruct Llama-3.1-405B-Instruct Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-70b Llama-2-70b-chat Llama-2-13b Llama-2-13b-chat |

| Microsoft Phi-familjemodeller | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct Phi-4 |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct Phi-4 |

| Mistral-familjemodeller | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Ministral-3B Mistral-NeMo |

| Nixtla | Inte tillgängliga | TimeGEN-1 |

Modelllivscykel: utfasning och tillbakadragning

AI-modeller utvecklas snabbt och när en ny version eller en ny modell med uppdaterade funktioner i samma modellfamilj blir tillgängliga kan äldre modeller dras tillbaka i AI Foundry-modellkatalogen. För att möjliggöra en smidig övergång till en nyare modellversion ger vissa modeller användarna möjlighet att aktivera automatiska uppdateringar. Mer information om modelllivscykeln för olika modeller, kommande datum för modellavgång och föreslagna ersättningsmodeller och versioner finns i:

- Utfasningar och tillbakadragningar av Azure OpenAI-tjänstmodeller

- Utfasningar och tillbakadragningar av Severless API-modell

Hantera databearbetning

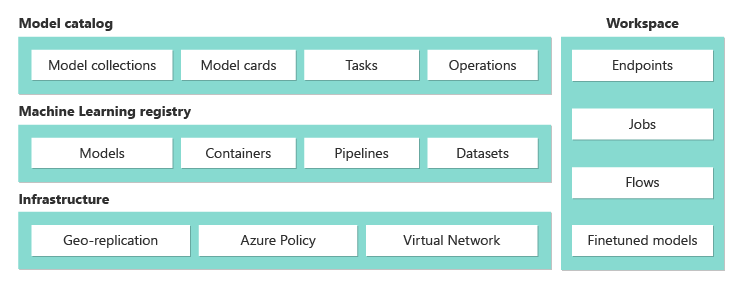

Möjligheten att distribuera modeller som hanterad beräkning bygger på plattformsfunktioner i Azure Machine Learning för att möjliggöra sömlös integrering av den breda samlingen modeller i modellkatalogen under hela livscykeln för llm-åtgärder (large language model).

Tillgänglighet för modeller för distribution som hanterad beräkning

Modellerna görs tillgängliga via Azure Machine Learning-register. Dessa register möjliggör en maskininlärningsinriktad metod för att vara värd för och distribuera Azure Machine Learning-tillgångar. Dessa tillgångar omfattar modellvikter, containerkörningar för att köra modellerna, pipelines för utvärdering och finjustering av modellerna samt datauppsättningar för benchmarks och exempel.

Registren bygger på en mycket skalbar och företagsklar infrastruktur som:

Levererar artefakter med låg latensåtkomstmodell till alla Azure-regioner med inbyggd geo-replikering.

Stöder företagets säkerhetskrav, till exempel att begränsa åtkomsten till modeller med hjälp av Azure Policy och säker distribution med hjälp av hanterade virtuella nätverk.

Distribution av modeller för slutsatsdragning med hanterad beräkning

Modeller som är tillgängliga för distribution till hanterad beräkning kan distribueras till Azure Machine Learning-hanterad beräkning för realtidsinferens. När du distribuerar till hanterad beräkning måste du ha en kvot för virtuella datorer i din Azure-prenumeration för de specifika produkter som du behöver för att köra modellen optimalt. Med vissa modeller kan du distribuera till en tillfälligt delad kvot för modelltestning.

Läs mer om att distribuera modeller:

Skapa generativa AI-appar med hanterad beräkning

Funktionen fråga flöde i Azure Machine Learning erbjuder en bra upplevelse för prototyper. Du kan använda modeller som distribuerats med hanterad beräkning i promptflöde med VERKTYGET ÖPPNA MODELL LLM. Du kan också använda REST-API:et som exponeras av hanterad beräkning i populära LLM-verktyg som LangChain med Azure Machine Learning-tillägget.

Innehållssäkerhet för modeller som distribueras som hanterad beräkning

Tjänsten Azure AI Content Safety är tillgänglig för användning med hanterad beräkning för att söka efter olika kategorier av skadligt innehåll, till exempel sexuellt innehåll, våld, hat och självskadebeteende. Du kan också använda tjänsten för att söka efter avancerade hot, till exempel riskidentifiering av jailbreak och skyddad materialtextidentifiering.

Du kan referera till den här notebook-filen för referensintegrering med Azure AI Content Safety för Llama 2. Eller så kan du använda verktyget Innehållssäkerhet (text) i snabbflödet för att skicka svar från modellen till Azure AI Content Safety för screening. Du debiteras separat för sådan användning enligt beskrivningen i prissättningen för Azure AI Content Safety.

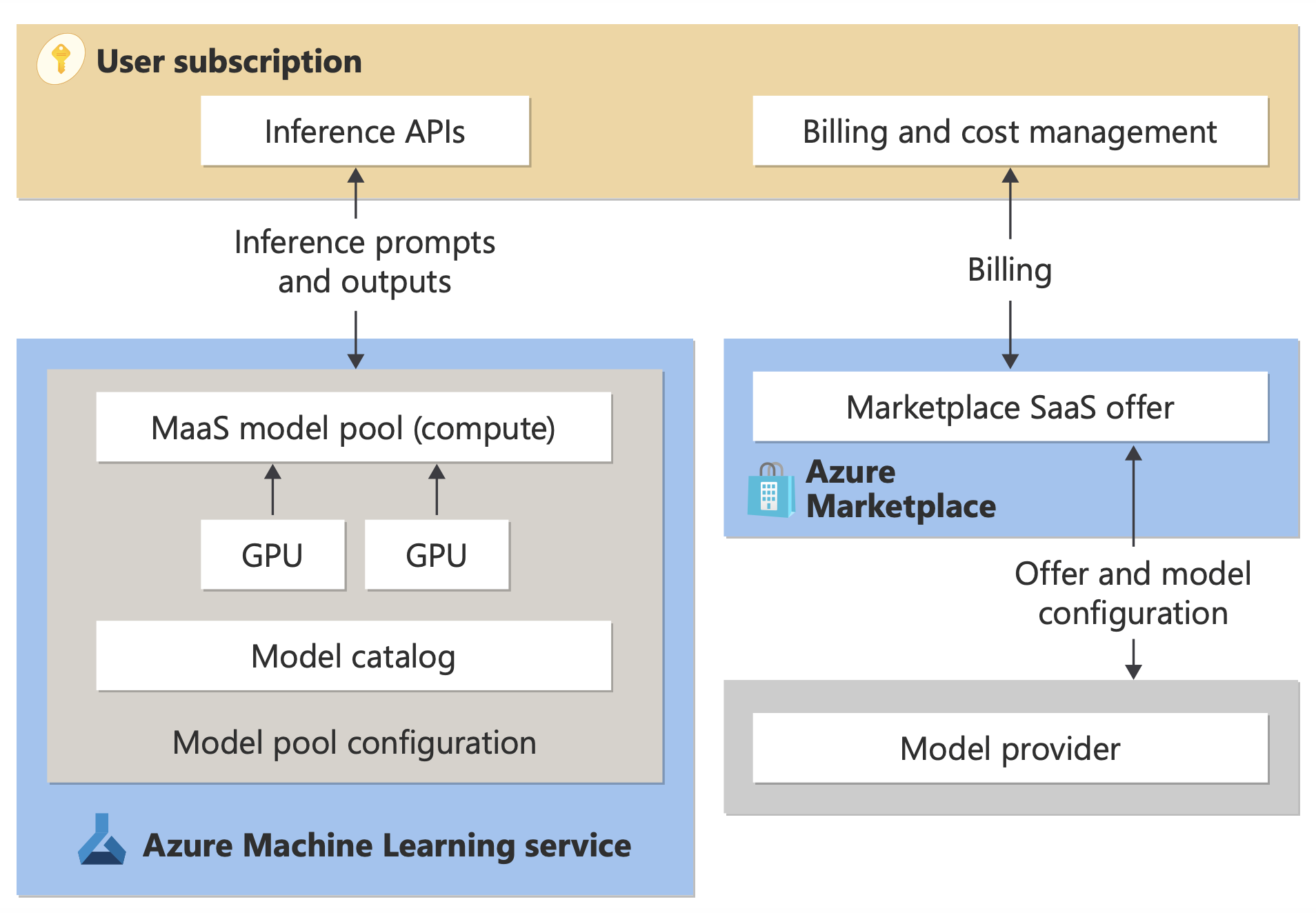

Serverlös API-fakturering (betala per token)

Du kan distribuera vissa modeller i modellkatalogen med betalning per token-fakturering. Den här distributionsmetoden, även kallad Serverlöst API, är ett sätt att använda modellerna som API:er utan att vara värd för dem i din prenumeration. Modeller finns i en Microsoft-hanterad infrastruktur som ger API-baserad åtkomst till modellleverantörens modell. API-baserad åtkomst kan avsevärt minska kostnaden för att komma åt en modell och förenkla etableringsupplevelsen.

Modeller som är tillgängliga för distribution som serverlösa API:er med betala per användning-fakturering erbjuds av modellleverantören, men de finns i en Microsoft-hanterad Azure-infrastruktur och nås via API. Modellleverantörer definierar licensvillkoren och anger priset för användning av sina modeller. Azure Machine Learning-tjänsten:

- Hanterar värdinfrastrukturen.

- Gör slutsatsdragnings-API:erna tillgängliga.

- Fungerar som dataprocessor för frågor som skickas och innehåll som skickas av modeller som distribueras via MaaS.

Läs mer om databehandling för MaaS i artikeln om datasekretess.

Kommentar

Molnlösningsleverantör-prenumerationer (CSP) har inte möjlighet att köpa maaS-modeller (serverlösa API-distributioner).

Fakturering

Identifierings-, prenumerations- och förbrukningsupplevelsen för modeller som distribueras via MaaS finns i Azure AI Foundry-portalen och Azure Machine Learning-studio. Användare accepterar licensvillkor för användning av modellerna. Prisinformation för förbrukning tillhandahålls under distributionen.

Modeller från icke-Microsoft-leverantörer faktureras via Azure Marketplace i enlighet med användningsvillkoren för Microsoft Commercial Marketplace.

Modeller från Microsoft faktureras via Azure-mätare som First Party Consumption Services. Som beskrivs i produktvillkoren köper du förbrukningstjänster från första part med hjälp av Azure-mätare, men de omfattas inte av Villkoren för Azure-tjänsten. Användning av dessa modeller omfattas av de angivna licensvillkoren.

Finjusteringsmodeller

Vissa modeller stöder också finjustering. För dessa modeller kan du dra nytta av hanterad beräkning (förhandsversion) eller serverlös API-finjustering för att skräddarsy modellerna med hjälp av data som du tillhandahåller. Mer information finns i översikten över finjustering.

RAG med modeller som distribueras som serverlösa API:er

I Azure AI Foundry-portalen kan du använda vektorindex och hämta utökad generering (RAG). Du kan använda modeller som kan distribueras via serverlösa API:er för att generera inbäddningar och slutsatsdragning baserat på anpassade data. Dessa inbäddningar och slutsatsdragningar kan sedan generera svar som är specifika för ditt användningsfall. Mer information finns i Skapa och använda vektorindex i Azure AI Foundry-portalen.

Regional tillgänglighet för erbjudanden och modeller

Fakturering per token är endast tillgängligt för användare vars Azure-prenumeration tillhör ett faktureringskonto i ett land/en region där modellleverantören har gjort erbjudandet tillgängligt. Om erbjudandet är tillgängligt i den relevanta regionen måste användaren ha en projektresurs i Azure-regionen där modellen är tillgänglig för distribution eller finjustering, i förekommande fall. Se Regiontillgänglighet för modeller i serverlösa API-slutpunkter | Azure AI Foundry för detaljerad information.

Innehållssäkerhet för modeller som distribueras via serverlösa API:er

För språkmodeller som distribueras via serverlösa API:er implementerar Azure AI en standardkonfiguration av textmodereringsfilter för Azure AI Content Safety som identifierar skadligt innehåll som hat, självskadebeteende, sexuellt och våldsamt innehåll. Mer information om innehållsfiltrering (förhandsversion) finns i Skadekategorier i Azure AI Content Safety.

Dricks

Innehållsfiltrering (förhandsversion) är inte tillgängligt för vissa modelltyper som distribueras via serverlösa API:er. Dessa modelltyper omfattar inbäddningsmodeller och tidsseriemodeller.

Innehållsfiltrering (förhandsversion) sker synkront när tjänstprocesserna uppmanar till att generera innehåll. Du kan debiteras separat enligt prissättningen för Azure AI Content Safety för sådan användning. Du kan inaktivera innehållsfiltrering (förhandsversion) för enskilda serverlösa slutpunkter:

- När du först distribuerar en språkmodell

- Senare genom att välja växlingsknappen för innehållsfiltrering på sidan med distributionsinformation

Anta att du bestämmer dig för att använda ett annat API än Azure AI Model Inference API för att arbeta med en modell som distribueras via ett serverlöst API. I sådana fall är innehållsfiltrering (förhandsversion) inte aktiverat om du inte implementerar det separat med hjälp av Azure AI Content Safety.

Information om hur du kommer igång med Azure AI Content Safety finns i Snabbstart: Analysera textinnehåll. Om du inte använder innehållsfiltrering (förhandsversion) när du arbetar med modeller som distribueras via serverlösa API:er löper du en högre risk att utsätta användare för skadligt innehåll.

Nätverksisolering för modeller som distribueras via serverlösa API:er

Slutpunkter för modeller som distribueras som serverlösa API:er följer inställningen för åtkomstflaggan för offentliga nätverk i azure AI Foundry-hubben som har projektet där distributionen finns. Om du vill skydda din serverlösa API-slutpunkt inaktiverar du åtkomstflaggan för offentligt nätverk på azure AI Foundry-hubben. Du kan skydda inkommande kommunikation från en klient till slutpunkten med hjälp av en privat slutpunkt för hubben.

Så här anger du åtkomstflaggan för offentligt nätverk för Azure AI Foundry-hubben:

- Gå till Azure-portalen.

- Sök efter den resursgrupp som hubben tillhör och välj din Azure AI Foundry-hubb från resurserna som anges för den här resursgruppen.

- På översiktssidan för hubben går du till Inställningar>Nätverk i det vänstra fönstret.

- På fliken Offentlig åtkomst kan du konfigurera inställningar för åtkomstflaggan för offentligt nätverk.

- Spara dina ändringar. Det kan ta upp till fem minuter att sprida ändringarna.

Begränsningar

Om du har en Azure AI Foundry-hubb med en privat slutpunkt som skapades före den 11 juli 2024 följer inte serverlösa API-slutpunkter som lagts till i projekt i den här hubben nätverkskonfigurationen för hubben. I stället måste du skapa en ny privat slutpunkt för hubben och skapa nya serverlösa API-distributioner i projektet så att de nya distributionerna kan följa hubbens nätverkskonfiguration.

Om du har en Azure AI Foundry-hubb med MaaS-distributioner som skapats före den 11 juli 2024 och du aktiverar en privat slutpunkt på den här hubben följer inte de befintliga serverlösa API-distributionerna hubbens nätverkskonfiguration. För att serverlösa API-distributioner i hubben ska kunna följa hubbens nätverkskonfiguration måste du skapa distributionerna igen.

För närvarande är Azure OpenAI On Your Data-stöd inte tillgängligt för serverlösa API-distributioner i privata hubbar, eftersom privata hubbar har åtkomstflaggan för offentligt nätverk inaktiverad.

Alla ändringar i nätverkskonfigurationen (till exempel aktivering eller inaktivering av åtkomstflaggan för offentligt nätverk) kan ta upp till fem minuter att sprida.