Комплексный сценарий обработки и анализа данных: введение и архитектура

Этот набор учебников демонстрирует пример комплексного сценария в интерфейсе обработки и анализа данных Fabric. Вы реализуете каждый шаг от приема данных, очистки и подготовки, обучения моделей машинного обучения и создания аналитических сведений, а затем потребляют эти аналитические сведения с помощью таких средств визуализации, как Power BI.

Если вы не знакомы с Microsoft Fabric, ознакомьтесь с Что такое Microsoft Fabric?.

Знакомство

Жизненный цикл проекта обработки и анализа данных обычно включает (часто итеративно) следующие шаги:

- Бизнес-понимание

- Сбор данных

- Исследование данных, очистка, подготовка и визуализация

- Обучение модели и отслеживание экспериментов

- Оценка моделей и создание аналитических сведений.

Цели и критерии успешности каждого этапа зависят от совместной работы, совместного использования данных и документации. Интерфейс обработки и анализа данных Fabric состоит из нескольких встроенных функций, которые обеспечивают совместную работу, приобретение данных, совместное использование и использование без проблем.

В этих руководствах вы принимаете роль ученого по обработке и анализу данных, который получил задачу для изучения, очистки и преобразования набора данных, содержащего состояние оттока 10 000 клиентов в банке. Затем вы создадите модель машинного обучения, чтобы предсказать, какие клиенты банка, скорее всего, уходят.

Вы узнаете, как выполнить следующие действия:

- Используйте записные книжки Fabric для сценариев обработки и анализа данных.

- Импортируйте данные в озеро данных Fabric с использованием Apache Spark.

- Загрузите существующие данные из дельта-таблиц в Lakehouse.

- Очистка и преобразование данных с помощью средств на основе Apache Spark и Python.

- Создание экспериментов и запусков для обучения различных моделей машинного обучения.

- Регистрация и отслеживание обученных моделей с помощью MLflow и пользовательского интерфейса Fabric.

- Выполните оценивание в масштабах и сохраните прогнозы и результаты предсказаний в lakehouse.

- Визуализация прогнозов в Power BI с помощью DirectLake.

Архитектура

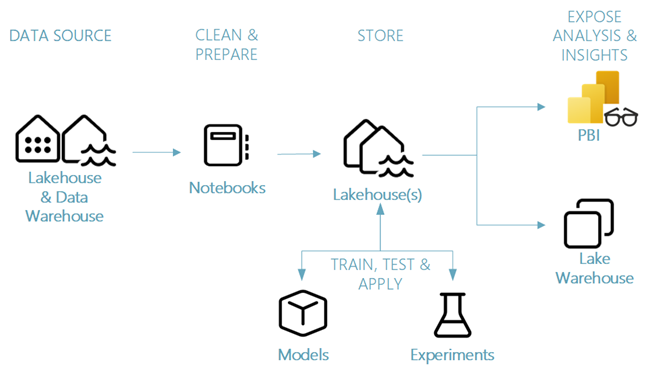

В этом руководстве мы продемонстрируем упрощенный комплексный сценарий обработки и анализа данных, который включает в себя:

- Загрузка данных из внешнего источника данных.

- Изучение и очистка данных.

- Обучение и регистрация моделей машинного обучения.

- Выполните пакетное оценивание и сохраните прогнозы.

- Визуализация результатов прогноза в Power BI.

Различные компоненты сценария обработки и анализа данных

Источники данных — Fabric упрощает и ускоряет подключение к службам данных Azure, другим облачным платформам и локальным источникам данных для их получения. С помощью записных книжек Fabric можно получать данные из встроенных Lakehouse, хранилища данных, семантических моделей и различных пользовательских источников данных, поддерживаемых Apache Spark и Python. В этой серии учебных материалов рассматриваются прием и загрузка данных из лейкхауса.

Изучение, очистка и подготовка. Опыт работы с данными в Fabric поддерживает очистку данных, преобразование, исследование и выделение признаков с помощью встроенных возможностей Spark, а также инструментов на основе Python, таких как Data Wrangler и библиотека SemPy. В этом руководстве показано исследование данных с помощью библиотеки Python seaborn и очистки и подготовки данных с помощью Apache Spark.

Модели и эксперименты. Платформа позволяет обучать, тестировать и оценивать модели машинного обучения, используя встроенные элементы для экспериментов и моделей с простой интеграцией с MLflow для отслеживания экспериментов, регистрации и развертывания моделей. Платформа также предоставляет возможности масштабного прогнозирования моделей (PREDICT) для получения и совместного использования аналитических данных.

хранилище — Фабрика стандартизирована на Delta Lake, что означает, что все движки Fabric могут взаимодействовать с тем же набором данных, хранящимся в Data Lakehouse. Этот уровень хранения позволяет хранить структурированные и неструктурированные данные, поддерживающие как хранилище на основе файлов, так и табличный формат. К сохраненным наборам данных и файлам можно легко получить доступ через все элементы интерфейса Fabric, такие как записные книжки и конвейеры.

Предоставлять анализ и аналитические сведения. Данные из системы lakehouse можно использовать в Power BI, ведущем инструменте бизнес-аналитики, для создания отчетов и визуализации. Данные, сохраненные в lakehouse, также можно визуализировать в записных книжках с помощью собственных библиотек визуализации Spark или Python, таких как matplotlib, seaborn, plotlyи т. д. Данные также можно визуализировать с помощью библиотеки SemPy, которая поддерживает встроенные, специальные визуализации для семантической модели данных, для зависимостей и их нарушений, а также для вариантов использования классификации и регрессии.