Adicionar e gerenciar uma fonte de eventos em um fluxo de eventos

Depois de criar um fluxo de eventos, você pode conectá-lo a várias fontes de dados e destinos.

Nota

Os recursos aprimorados são habilitados por padrão quando você cria fluxos de eventos agora. Se você tiver fluxos de eventos que foram criados usando recursos padrão, esses fluxos de eventos continuarão a funcionar. Você ainda pode editá-los e usá-los como de costume. Recomendamos que você crie um novo fluxo de eventos para substituir fluxos de eventos padrão para que possa aproveitar os recursos e benefícios adicionais dos fluxos de eventos aprimorados.

Depois de criar um fluxo de eventos, você pode conectá-lo a várias fontes de dados e destinos.

O Eventstream não só permite transmitir dados de fontes da Microsoft, mas também suporta a ingestão de plataformas de terceiros, como o Google Cloud e o Amazon Kinesis, com novos conectores de mensagens. Esse recurso expandido oferece integração perfeita de fluxos de dados externos ao Fabric, proporcionando maior flexibilidade e permitindo que você obtenha insights em tempo real de várias fontes.

Neste artigo, você aprenderá sobre as fontes de eventos que você pode adicionar a um fluxo de eventos.

Pré-requisitos

- Acesso a um espaço de trabalho no modo de licença de capacidade de malha (ou) no modo de licença de avaliação com permissões de Colaborador ou superiores.

- Pré-requisitos específicos de cada fonte que estão documentados nos seguintes artigos específicos da fonte.

Origens suportadas

Os fluxos de eventos de malha com recursos aprimorados oferecem suporte às seguintes fontes. Cada artigo fornece detalhes e instruções para adicionar fontes específicas.

| Origens | Description |

|---|---|

| Hubs de Eventos do Azure | Se você tiver um hub de eventos do Azure, poderá ingerir dados do hub de eventos no Microsoft Fabric usando o Eventstream. |

| Hub IoT do Azure | Se você tiver um hub IoT do Azure, poderá ingerir dados de IoT no Microsoft Fabric usando o Eventstream. |

| Captura de Dados de Alteração do Banco de Dados SQL do Azure (CDC) | O conector de origem CDC do Banco de Dados SQL do Azure permite capturar um instantâneo dos dados atuais em um banco de dados SQL do Azure. Em seguida, o conector monitora e registra quaisquer alterações futuras no nível da linha nesses dados. |

| Banco de Dados PostgreSQL CDC | O conector de origem CDC (Change Data Capture) do banco de dados PostgreSQL permite capturar um instantâneo dos dados atuais em um banco de dados PostgreSQL. Em seguida, o conector monitora e registra quaisquer alterações futuras no nível da linha nesses dados. |

| Banco de dados MySQL CDC | O conector de origem CDC (Change Data Capture Change Data Capture) do Banco de Dados MySQL do Azure permite capturar um instantâneo dos dados atuais em um banco de dados do Azure Database for MySQL. Você pode especificar as tabelas a serem monitoradas e o fluxo de eventos registra quaisquer alterações futuras no nível da linha nas tabelas. |

| Azure Cosmos DB CDC | O conector de origem CDC (Change Data Capture) do Azure Cosmos DB para fluxos de eventos do Microsoft Fabric permite capturar um instantâneo dos dados atuais em um banco de dados do Azure Cosmos DB. Em seguida, o conector monitora e registra quaisquer alterações futuras no nível da linha nesses dados. |

| SQL Server em máquina virtual (VM) Banco de dados (DB) CDC | O conector de origem do SQL Server on VM DB (CDC) para fluxos de eventos do Fabric permite capturar um instantâneo dos dados atuais em um banco de dados do SQL Server na VM. Em seguida, o conector monitora e registra quaisquer alterações futuras nos dados no nível da linha. |

| Azure SQL Managed Instance CDC | O conector de origem CDC da Instância Gerenciada SQL do Azure para fluxos de eventos do Microsoft Fabric permite capturar um instantâneo dos dados atuais em um banco de dados da Instância Gerenciada SQL. Em seguida, o conector monitora e registra quaisquer alterações futuras no nível da linha nesses dados. |

| Google Cloud Pub/Sub | O Google Pub/Sub é um serviço de mensagens que permite publicar e assinar fluxos de eventos. Você pode adicionar o Google Pub/Sub como fonte ao seu fluxo de eventos para capturar, transformar e rotear eventos em tempo real para vários destinos no Fabric. |

| Amazon Kinesis Data Streams | O Amazon Kinesis Data Streams é um serviço de ingestão e processamento de dados altamente escalável e durável, otimizado para streaming de dados. Ao integrar o Amazon Kinesis Data Streams como uma fonte em seu fluxo de eventos, você pode processar facilmente fluxos de dados em tempo real antes de roteá-los para vários destinos no Fabric. |

| Nuvem confluente Kafka | Confluent Cloud Kafka é uma plataforma de streaming que oferece poderosas funcionalidades de streaming e processamento de dados usando o Apache Kafka. Ao integrar o Confluent Cloud Kafka como uma fonte em seu fluxo de eventos, você pode processar perfeitamente fluxos de dados em tempo real antes de roteá-los para vários destinos no Fabric. |

| Amazon MSK Kafka | O Amazon MSK Kafka é um serviço Kafka totalmente gerenciado que simplifica a configuração, o dimensionamento e o gerenciamento. Ao integrar o Amazon MSK Kafka como uma fonte em seu fluxo de eventos, você pode facilmente trazer os eventos em tempo real do seu MSK Kafka e processá-los antes de roteá-los para vários destinos no Fabric. |

| Dados de exemplo | Você pode escolher Bicicletas, Táxi Amarelo ou eventos do Mercado de Ações como uma fonte de dados de exemplo para testar a ingestão de dados durante a configuração de um fluxo de eventos. |

| Ponto de extremidade personalizado (ou seja, aplicativo personalizado em capacidade padrão) | O recurso de ponto de extremidade personalizado permite que seus aplicativos ou clientes Kafka se conectem ao Eventstream usando uma cadeia de conexão, permitindo a ingestão suave de dados de streaming no Eventstream. |

| Barramento de Serviço do Azure (visualização) | Você pode ingerir dados de uma fila do Barramento de Serviço do Azure ou da assinatura de um tópico no Microsoft Fabric usando o Eventstream. |

| Apache Kafka (pré-visualização) | O Apache Kafka é uma plataforma distribuída de código aberto para a construção de sistemas de dados escaláveis e em tempo real. Ao integrar o Apache Kafka como uma fonte em seu fluxo de eventos, você pode facilmente trazer eventos em tempo real do seu Apache Kafka e processá-los antes de roteá-los para vários destinos no Fabric. |

| Eventos do Armazenamento de Blobs do Azure (visualização) | Os eventos do Armazenamento de Blobs do Azure são acionados quando um cliente cria, substitui ou exclui um blob. O conector permite vincular eventos de armazenamento de Blob a eventos de malha no hub em tempo real. Você pode converter esses eventos em fluxos de dados contínuos e transformá-los antes de roteá-los para vários destinos no Fabric. |

| Eventos do Item do Espaço de Trabalho de Malha (visualização) | Os eventos de Item de Espaço de Trabalho de Malha são eventos de Malha discretos que ocorrem quando são feitas alterações no seu Espaço de Trabalho de Malha. Essas alterações incluem a criação, atualização ou exclusão de um item de malha. Com os fluxos de eventos do Fabric, você pode capturar esses eventos do espaço de trabalho do Fabric, transformá-los e roteá-los para vários destinos no Fabric para análise adicional. |

| eventos do Fabric OneLake (pré-visualização) | Os eventos do OneLake permitem que você assine alterações em arquivos e pastas no OneLake e, em seguida, reaja a essas alterações em tempo real. Com os fluxos de eventos do Fabric, você pode capturar esses eventos do OneLake, transformá-los e roteá-los para vários destinos no Fabric para análise adicional. Essa integração perfeita de eventos OneLake em fluxos de eventos do Fabric oferece maior flexibilidade para monitorar e analisar atividades em seu OneLake. |

| eventos do Fabric Job (visualização) | Os eventos de trabalho permitem que você se inscreva nas alterações produzidas quando o Fabric executa um trabalho. Por exemplo, você pode reagir a alterações ao atualizar um modelo semântico, executar um pipeline agendado ou executar um bloco de anotações. Cada uma dessas atividades pode gerar um trabalho correspondente, que por sua vez gera um conjunto de eventos de trabalho correspondentes. Com os fluxos de eventos do Fabric, você pode capturar esses eventos de trabalho, transformá-los e roteá-los para vários destinos no Fabric para análise adicional. Essa integração perfeita de eventos de trabalho nos fluxos de eventos do Fabric oferece maior flexibilidade para monitorar e analisar as atividades em seu trabalho. |

Nota

O número máximo de fontes e destinos para um eventstream é 11.

Conteúdos relacionados

Pré-requisitos

Antes de começar, você deve preencher os seguintes pré-requisitos:

- Acesso a um espaço de trabalho no modo de licença de capacidade de malha (ou) no modo de licença de avaliação com permissões de Colaborador ou superiores.

- Para adicionar um Hubs de Eventos do Azure ou o Hub IoT do Azure como fonte de fluxo de eventos, você precisa ter a permissão apropriada para acessar suas chaves de política. Eles devem ser acessíveis publicamente e não protegidos por um firewall ou protegidos em uma rede virtual.

Origens suportadas

Os fluxos de eventos de malha oferecem suporte às seguintes fontes. Use links na tabela para navegar até artigos que fornecem mais detalhes sobre como adicionar fontes específicas.

| Origens | Description |

|---|---|

| Hubs de Eventos do Azure | Se você tiver um hub de eventos do Azure, poderá ingerir dados do hub de eventos no Microsoft Fabric usando o Eventstream. |

| Hub IoT do Azure | Se você tiver um hub IoT do Azure, poderá ingerir dados de IoT no Microsoft Fabric usando o Eventstream. |

| Dados de exemplo | Você pode escolher Bicicletas, Táxi Amarelo ou eventos do Mercado de Ações como uma fonte de dados de exemplo para testar a ingestão de dados durante a configuração de um fluxo de eventos. |

| Aplicação Personalizada | O recurso de aplicativo personalizado permite que seus aplicativos ou clientes Kafka se conectem ao Eventstream usando uma cadeia de conexão, permitindo a ingestão suave de dados de streaming no Eventstream. |

Nota

O número máximo de fontes e destinos para um eventstream é 11.

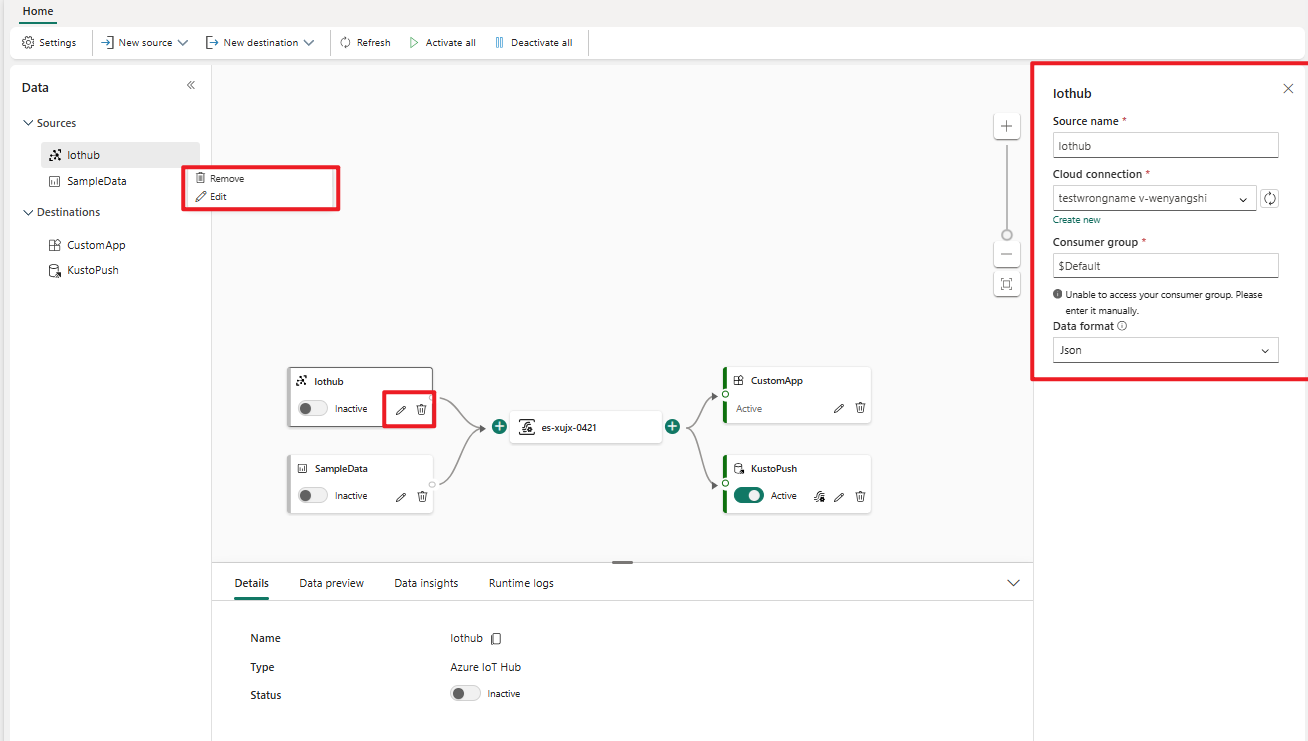

Gerenciar uma fonte

Editar/remover: você pode selecionar uma fonte de fluxo de eventos para editar ou remover por meio do painel de navegação ou da tela. Quando você seleciona Editar, o painel de edição é aberto à direita do editor principal.

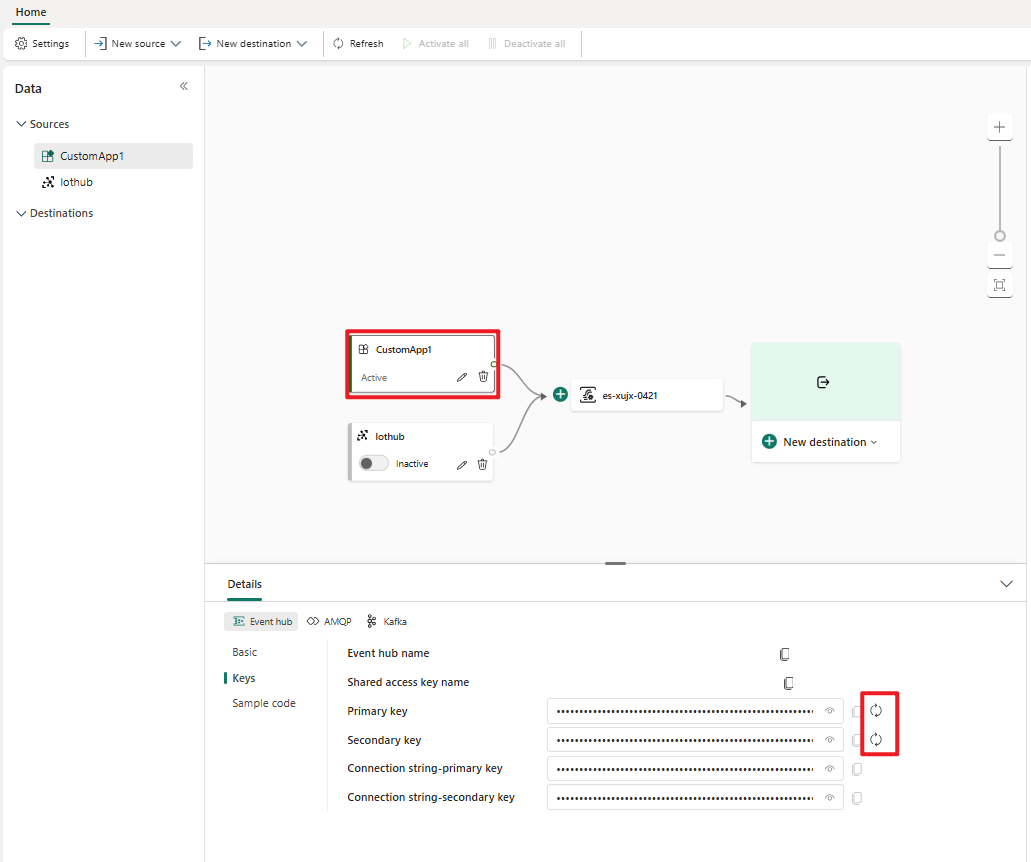

Regenerar chave para um aplicativo personalizado: se você quiser regenerar uma nova chave de conexão para seu aplicativo, selecione uma das fontes de aplicativo personalizadas na tela e selecione Regenerar para obter uma nova chave de conexão.