Adicionar origem do Amazon MSK Kafka a um fluxo de eventos

Este artigo mostra como adicionar uma fonte do Amazon MSK Kafka a um fluxo de eventos.

O Amazon MSK Kafka é um serviço Kafka totalmente gerenciado que simplifica a configuração, o dimensionamento e o gerenciamento. Ao integrar o Amazon MSK Kafka como uma fonte em seu fluxo de eventos, você pode facilmente trazer os eventos em tempo real do seu MSK Kafka e processá-los antes de roteá-los para vários destinos no Fabric.

Nota

Esta origem não é suportada nas seguintes regiões da capacidade do seu espaço de trabalho: Oeste US3, Suíça Oeste.

Pré-requisitos

- Acesso a um espaço de trabalho no modo de licença de capacidade de malha (ou) no modo de licença de avaliação com permissões de Colaborador ou superiores.

- Um cluster do Amazon MSK Kafka em status ativo.

- Seu cluster do Amazon MSK Kafka deve ser acessível publicamente e não estar protegido por um firewall ou protegido em uma rede virtual.

Nota

O número máximo de fontes e destinos para um eventstream é 11.

Adicionar Amazon MSK Kafka como fonte

- Em Fabric Real-Time Intelligence, selecione Eventstream para criar um novo eventstream.

- Na tela seguinte, selecione Adicionar fonte externa.

Configurar e conectar-se ao Amazon MSK Kafka

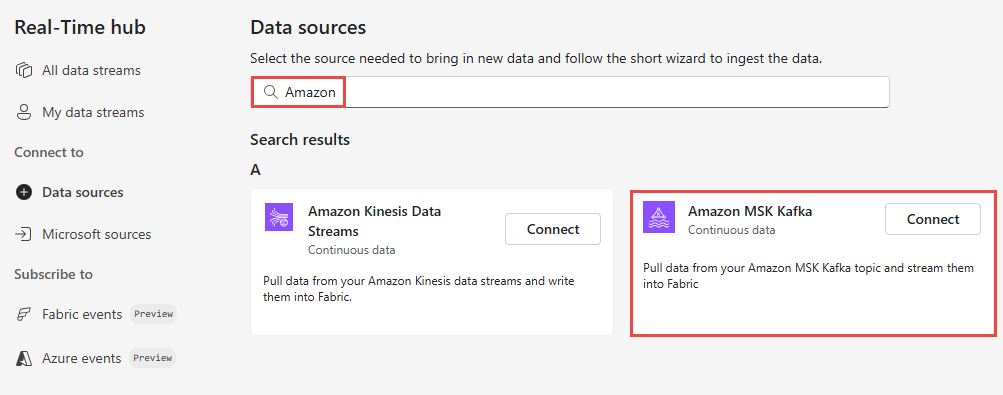

Na página Fontes de dados, selecione Amazon MSK Kafka.

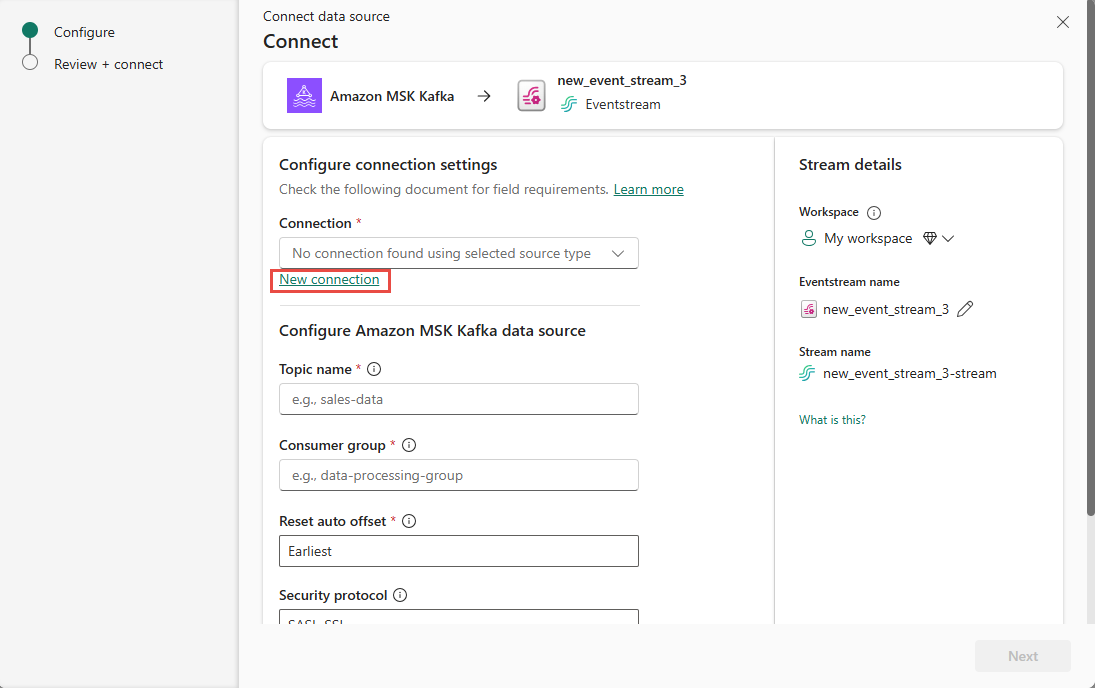

Na página Conectar, selecione Nova conexão.

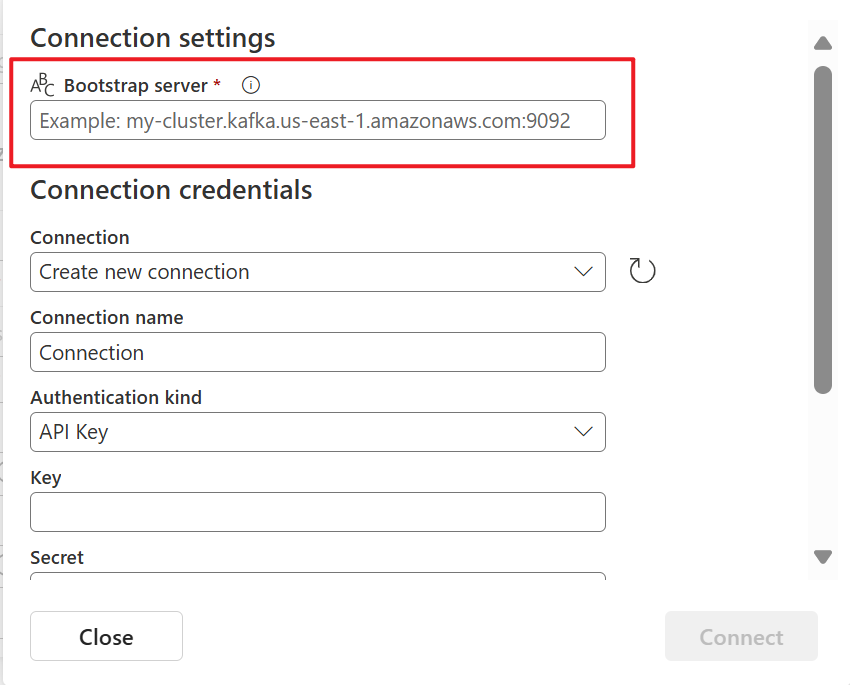

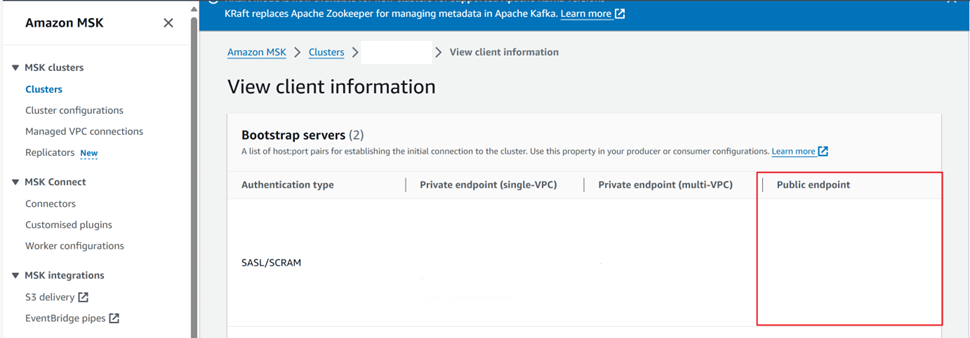

Na seção Configurações de conexão, para Servidor de Bootstrap, insira o ponto de extremidade público do cluster Kafka.

Para obter o ponto de extremidade público:

Na seção Credenciais de conexão, se você tiver uma conexão existente com o cluster do Amazon MSK Kafka, selecione-a na lista suspensa de Conexão. Caso contrário, siga estes passos:

- Em Nome da conexão, insira um nome para a conexão.

- Para Tipo de autenticação, confirme se a opção Chave de API está selecionada.

- Em Key and Secret, insira API key e key Secret for Amazon MSK Kafka cluster.

Selecione Ligar.

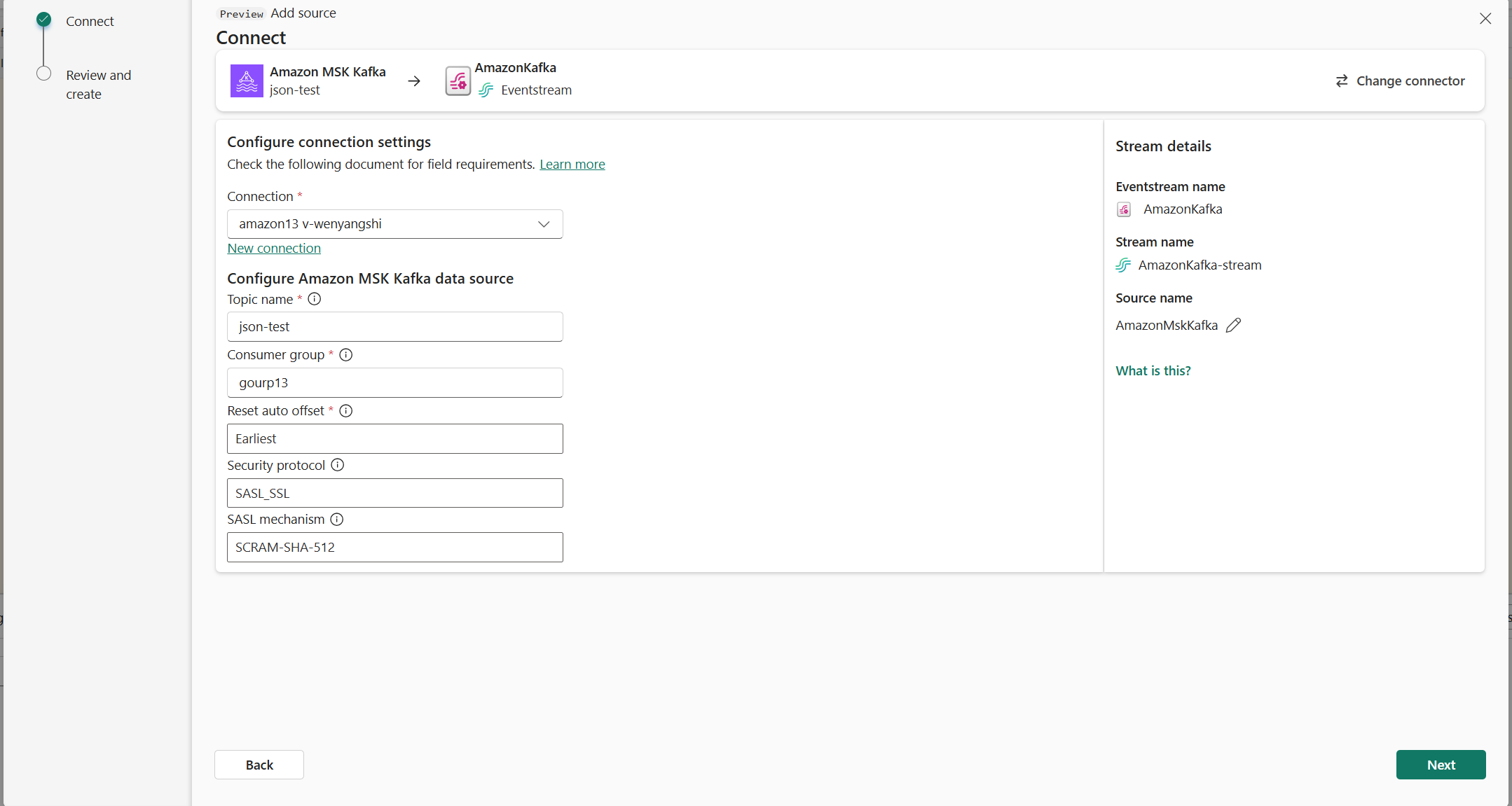

Agora, na página Conectar, siga estas etapas.

Em Tópico, insira o tópico Kafka.

Em Grupo de consumidores, insira o grupo de consumidores do seu cluster Kafka. Este campo fornece um grupo de consumidores dedicado para obter eventos.

Selecione Redefinir deslocamento automático para especificar por onde começar a ler deslocamentos se não houver confirmação.

Para o protocolo de segurança, o valor padrão é SASL_SSL. O mecanismo SASL padrão é SCRAM-SHA-512 e não pode ser alterado.

Selecione Seguinte. No ecrã Rever + ligar, reveja o resumo e, em seguida, selecione Ligar.

Ver fluxo de eventos atualizado

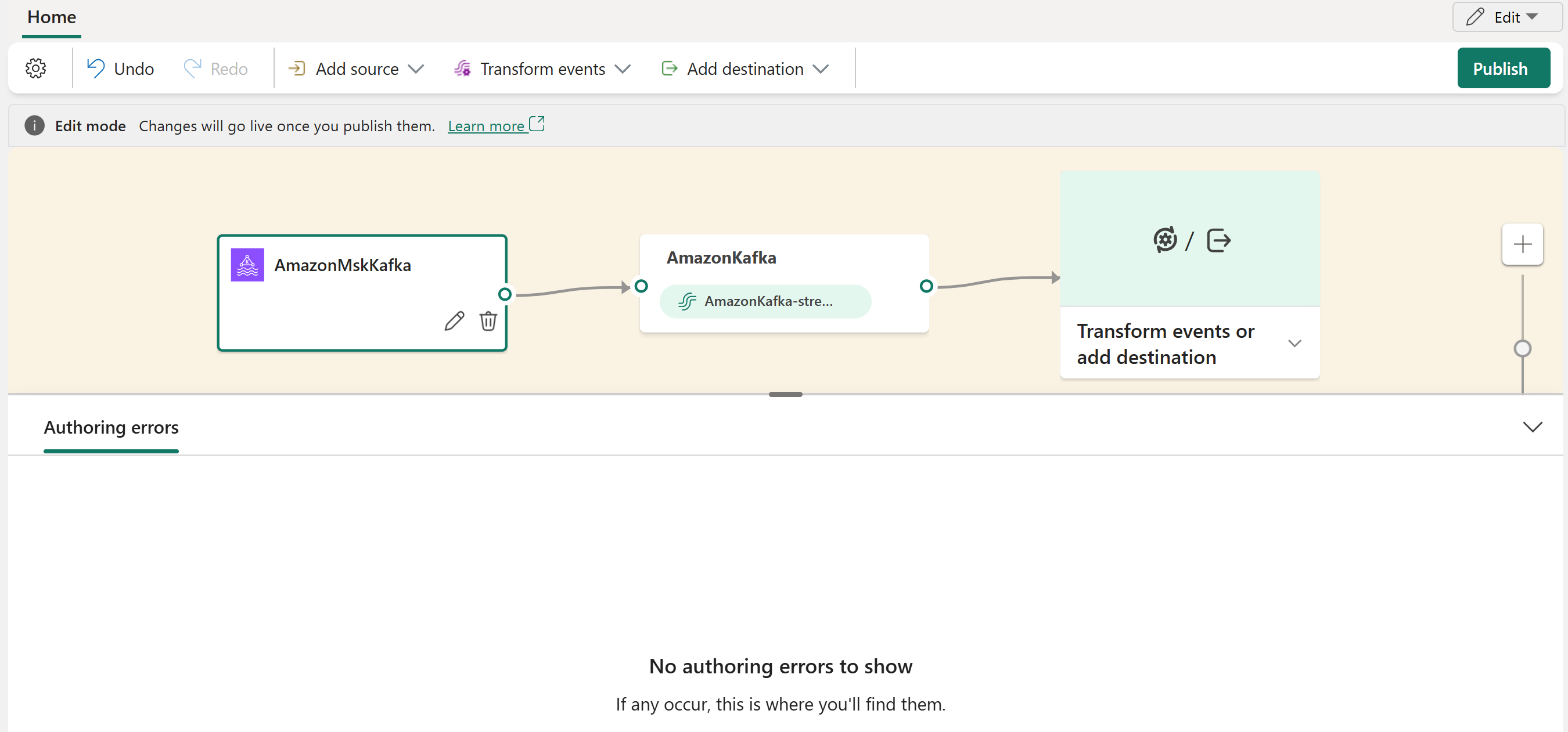

Você pode ver a fonte do Amazon MSK Kafka adicionada ao seu fluxo de eventos no modo de edição.

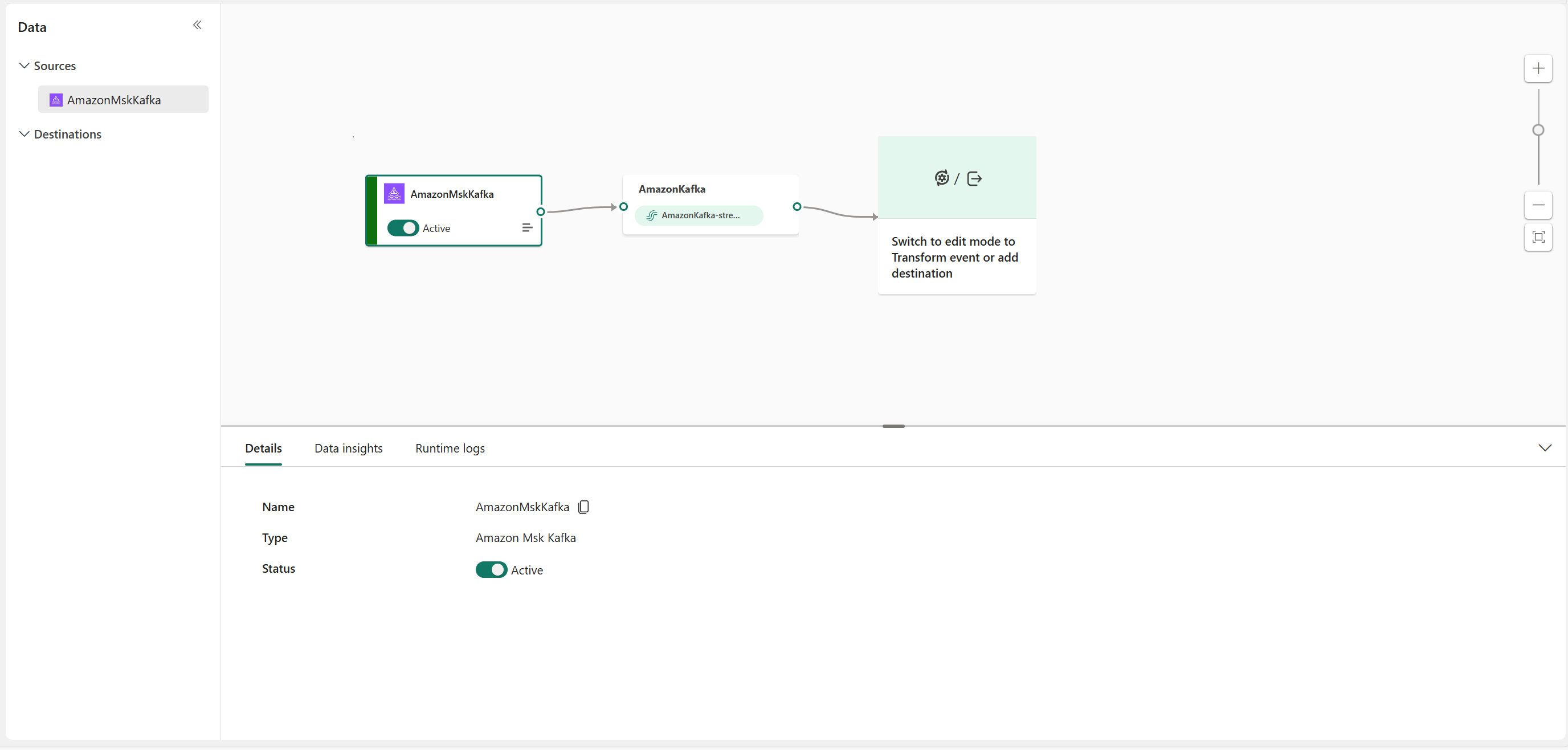

Depois de concluir essas etapas, a fonte do Amazon MSK Kafka fica disponível para visualização na Visualização dinâmica.

Conteúdos relacionados

Outros conectores:

- Amazon Kinesis Data Streams

- BD do Cosmos para o Azure

- Azure Event Hubs

- Hub IoT do Azure

- Captura de Dados de Alteração do Banco de Dados SQL do Azure (CDC)

- Ponto de extremidade personalizado

- Google Cloud Pub/Sub

- Banco de dados MySQL CDC

- Banco de Dados PostgreSQL CDC

- Dados de exemplo

- Eventos do Armazenamento de Blobs do Azure

- Evento do espaço de trabalho de malha