Tutorial: Copiar dados para o Azure Data Box Heavy via SMB

Copiar dados para o Azure Data Box Heavy

Importante

O Azure Data Box agora dá suporte à atribuição de camada de acesso no nível de blob. As etapas contidas neste tutorial refletem o processo de cópia de dados atualizado e são específicas para bloquear blobs.

As informações contidas nesta seção aplicam-se a pedidos feitos após 1º de abril de 2024.

Este tutorial descreve como ligar e copiar dados do computador anfitrião com a IU Web local.

Neste tutorial, irá aprender a:

- Ligar ao Data Box Heavy

- Copiar dados para o Data Box Heavy

Pode copiar dados do servidor de origem para o Data Box via SMB, NFS, REST, serviço de cópia de dados ou para discos geridos.

Em cada caso, certifique-se de que os nomes de partilha, os nomes das pastas e o tamanho dos dados seguem as diretrizes descritas nos limites do serviço Armazenamento do Azure e do Data Box Heavy.

Pré-requisitos

Antes de começar, certifique-se de que:

- Conclua o Tutorial: Configurar o Azure Data Box Heavy.

- Você recebe seu Data Box Heavy e que o status do pedido no portal é Entregue.

- Tem um computador anfitrião com os dados que quer copiar para o Data Box Heavy. O seu computador anfitrião deve:

- Executar um sistema operativo suportado.

- Estar ligado a uma rede de alta velocidade. Para velocidades de cópia mais rápidas, podem ser utilizadas em paralelo duas ligações de 40 GbE (uma por nó). Se não tiver uma ligação de 40 GbE disponível, recomendamos que tenha pelo menos duas ligações de 10 GbE (uma por nó).

Ligar às partilhas do Data Box Heavy

Com base na conta de armazenamento selecionada, o Data Box Heavy cria até:

- Três partilhas para cada conta de armazenamento associada de GPv1 e GPv2.

- Uma partilha para o armazenamento premium.

- Um compartilhamento para uma conta de armazenamento de blob, contendo uma pasta para cada uma das quatro camadas de acesso.

A tabela a seguir identifica os nomes dos compartilhamentos do Data Box aos quais você pode se conectar e o tipo de dados carregados na sua conta de armazenamento de destino. Ele também identifica a hierarquia de compartilhamentos e diretórios para os quais você copia seus dados de origem.

| Tipo de armazenamento | Nome da partilha | Entidade de primeiro nível | Entidade de segundo nível | Entidade de terceiro nível |

|---|---|---|---|---|

| Blob de blocos | <storageAccountName>_BlockBlob | <\accessTier> | <\nome_do_contêiner> | <\blockBlob> |

| Blob de páginas | <\storageAccountName>_PageBlob | <\nome_do_contêiner> | <\pageBlob> | |

| Armazenamento de ficheiros | <\storageAccountName>_AzFile | <\nome_do_arquivocompartilhamento> | <\ficheiro> |

Não é possível copiar arquivos diretamente para a pasta raiz de qualquer compartilhamento do Data Box. Em vez disso, crie pastas dentro do compartilhamento Data Box, dependendo do seu caso de uso.

Os blobs de bloco suportam a atribuição de camadas de acesso no nível do arquivo. Ao copiar arquivos para o compartilhamento de blob de bloco, a prática recomendada é adicionar novas subpastas dentro da camada de acesso apropriada. Depois de criar novas subpastas, continue adicionando arquivos a cada subpasta, conforme apropriado.

Um novo contêiner é criado para qualquer pasta que resida na raiz do compartilhamento de blob de bloco. Qualquer arquivo dentro dessa pasta é copiado para a camada de acesso padrão da conta de armazenamento como um blob de bloco.

Para obter mais informações sobre camadas de acesso de blob, consulte Camadas de acesso para dados de blob. Para obter informações mais detalhadas sobre as práticas recomendadas da camada de acesso, consulte Práticas recomendadas para usar camadas de acesso de blob.

A tabela a seguir mostra o caminho UNC para os compartilhamentos em seu Data Box e a URL correspondente do caminho de Armazenamento do Azure para a qual os dados são carregados. O URL do caminho de Armazenamento do Microsoft Azure final pode derivar do caminho da partilha UNC.

| Tipos de Armazenamento do Azure | Partilhas de Data Box |

|---|---|

| Blobs de bloco do Azure | \\<DeviceIPAddress>\<storageaccountname_BlockBlob>\<accessTier>\<ContainerName>\myBlob.txthttps://<storageaccountname>.blob.core.windows.net/<ContainerName>/myBlob.txt |

| Blobs de páginas do Azure | \\<DeviceIPAddress>\<storageaccountname_PageBlob>\<ContainerName>\myBlob.vhdhttps://<storageaccountname>.blob.core.windows.net/<ContainerName>/myBlob.vhd |

| Ficheiros do Azure | \\<DeviceIPAddress>\<storageaccountname_AzFile>\<ShareName>\myFile.txthttps://<storageaccountname>.file.core.windows.net/<ShareName>/myFile.txt |

Para obter mais informações sobre camadas de acesso de blob, consulte Camadas de acesso para dados de blob. Para obter informações mais detalhadas sobre as práticas recomendadas da camada de acesso, consulte Práticas recomendadas para usar camadas de acesso de blob.

Os passos para se ligar através de um cliente Windows ou Linux são diferentes.

Nota

Siga os mesmos passos para se ligar a ambos os nós do dispositivo em paralelo.

Ligar-se num sistema Windows

Se estiver a utilizar um computador anfitrião do Windows Server, execute estes passos para se ligar ao Data Box Heavy.

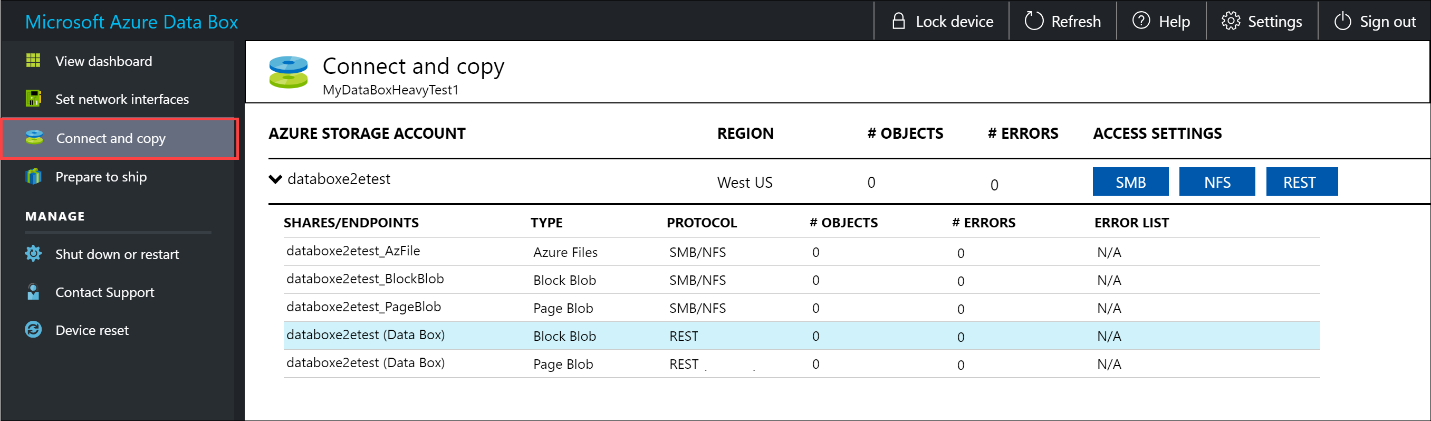

O primeiro passo é autenticar e iniciar uma sessão. Aceda a Ligar e copiar. Clique em Obter credenciais para obter as credenciais de acesso para as partilhas associadas à sua conta de armazenamento.

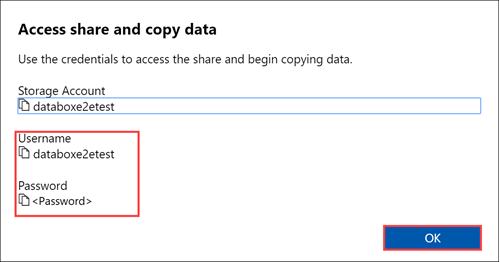

Na caixa de diálogo Aceder à partilha e copiar os dados, copie o Nome de utilizador e a Palavra-passe correspondentes à partilha. Clique em OK.

Para aceder às partilhas associadas à conta de armazenamento (databoxe2etest no exemplo a seguir) a partir do computador anfitrião, abra uma janela de comando. Na linha de comandos, escreva:

net use \\<IP address of the device>\<share name> /u:<user name for the share>Consoante o seu formato de dados, os caminhos de partilha são os seguintes:

- Blob de blocos do Azure –

\\10.100.10.100\databoxe2etest_BlockBlob - Blob de páginas do Azure –

\\10.100.10.100\databoxe2etest_PageBlob - Ficheiros do Azure –

\\10.100.10.100\databoxe2etest_AzFile

- Blob de blocos do Azure –

Introduza a palavra-passe da partilha quando lhe for pedido. O exemplo a seguir pode ser usado para se conectar ao compartilhamento BlockBlob no Data Box com o endereço IP 10.100.10.100.

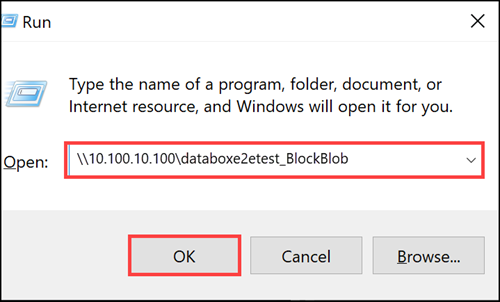

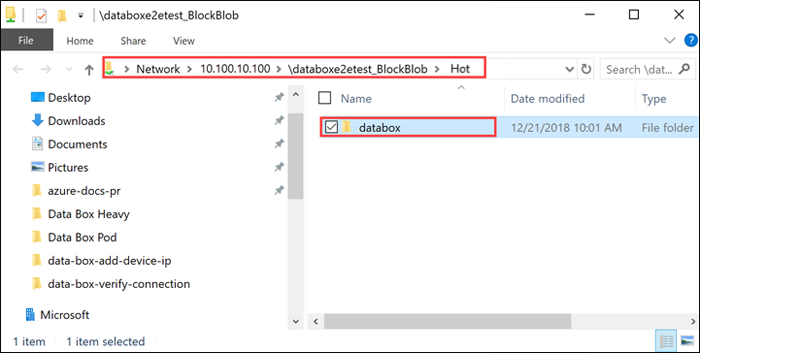

net use \\10.100.10.100\databoxe2etest_BlockBlob /u:databoxe2etest Enter the password for 'databoxe2etest' to connect to '10.100.10.100': The command completed successfully.Pressione Windows + R. Na janela Executar, especifique o

\\<device IP address>. Clique em OK para abrir o Explorador de Ficheiros.

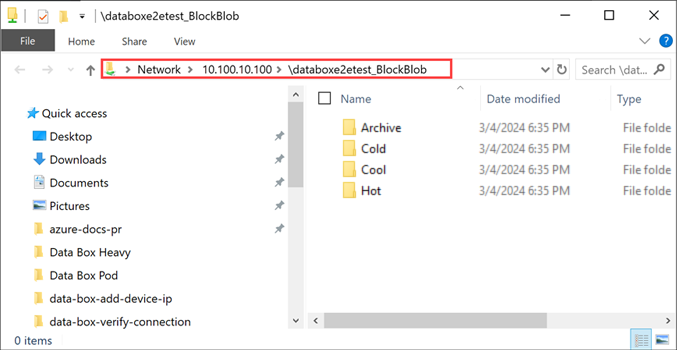

Agora deve conseguir ver as partilhas como pastas. Observe que, neste exemplo, o compartilhamento BlockBlob está sendo usado. Assim, as quatro pastas que representam as quatro camadas de acesso disponíveis estão presentes. Essas pastas não estão disponíveis em outros compartilhamentos.

Crie sempre uma pasta para os ficheiros que pretende copiar na partilha e, em seguida, copie os ficheiros para essa pasta. Não pode copiar ficheiros diretamente para a pasta raiz na conta de armazenamento. Todas as pastas criadas sob o compartilhamento PageBlob representam contêineres nos quais os dados são carregados como blobs. Da mesma forma, quaisquer subpastas criadas dentro das pastas que representam as camadas de acesso no compartilhamento BlockBlob também representam um contêiner de armazenamento de blob. As pastas criadas dentro do compartilhamento AzFile representam compartilhamentos de arquivos.

As pastas criadas na raiz do compartilhamento BlockBlob serão criadas como contêineres de blob. A camada de acesso desses contêineres será herdada da conta de armazenamento.

Ligar-se num sistema Linux

Se estiver a utilizar um cliente Linux, utilize o comando a seguir para montar a partilha SMB.

sudo mount -t nfs -o vers=2.1 10.126.76.172:/databoxe2etest_BlockBlob /home/databoxubuntuhost/databox

O parâmetro vers é a versão do SMB compatível com o sistema anfitrião Linux. Ligue a versão apropriada no comando acima.

Para as versões do SMB compatíveis com o Data Box Heavy, veja a secção Sistemas de ficheiros suportados pelos clientes Linux.

Copiar dados para o Data Box Heavy

Assim que estiver ligado às partilhas do Data Box Heavy, o passo seguinte é copiar os dados.

Considerações relacionadas com a cópia

Antes de começar a cópia de dados, reveja as seguintes considerações:

Verifique se copia os dados para as partilhas que correspondem ao formato de dados apropriado. Por exemplo, copie os dados de blobs de blocos para a partilha de blobs de blocos. Copie os VHDs para o blob de páginas.

Se o formato de dados não corresponder ao tipo de partilha apropriado, num passo posterior, o carregamento de dados para o Azure falhará.

Ao copiar os dados, confirme se o tamanho está em conformidade com os limites descritos em Limites de armazenamento do Azure e do Data Box Heavy.

Se os dados, que estão a ser carregados pelo Data Box Heavy, forem carregados em simultâneo por outras aplicações fora do Data Box Heavy, poderá resultar em falhas da tarefa de carregamento e danos nos dados.

Recomendamos que:

- Não utilize o SMB e o NFS ao mesmo tempo.

- Copie os mesmos dados para o mesmo destino final no Azure.

Nestes casos, não é possível determinar o resultado final.

Crie sempre uma pasta para os ficheiros que quer copiar na partilha e, em seguida, copie os ficheiros para essa pasta. A pasta criada nas partilhas dos blobs de blocos e dos blobs de páginas representa um contentor para o qual os dados são carregados como blobs. Não pode copiar ficheiros diretamente para a pasta raiz na conta de armazenamento.

Depois de ligar à partilha SMB, inicie a cópia dos dados.

Pode utilizar qualquer ferramenta de cópia de ficheiros compatível com SMB, como o Robocopy, para copiar os dados. É possível iniciar várias tarefas com o Robocopy. Utilize o seguinte comando:

robocopy <Source> <Target> * /e /r:3 /w:60 /is /nfl /ndl /np /MT:32 or 64 /fft /Log+:<LogFile>Os atributos são descritos na tabela seguinte.

Atributo Description . exe /e Copia os subdiretórios, incluindo diretórios vazios. /r: Especifica o número de repetições nas cópias falhadas. /w: Especifica o tempo de espera entre as repetições, em segundos. /is Inclui os mesmos ficheiros. /nfl Especifica que os nomes de ficheiro não estão registados. /ndl Especifica que os nomes de diretório não estão registados. /np Especifica que o progresso da operação de cópia (o número de ficheiros ou diretórios copiados até ao momento) não será apresentado. A apresentação do progresso reduz significativamente o desempenho. /MT Utilize multithreading (são recomendados 32 ou 64 threads). Esta opção não é utilizada com ficheiros encriptados. Pode ter de separar os ficheiros encriptados e não encriptados. No entanto, uma cópia de thread único reduz significativamente o desempenho. /fft Utilize para reduzir a granularidade de carimbo de data/hora para qualquer sistema de ficheiros. / b Copia os ficheiros no modo de Cópia de Segurança. /z Copia os ficheiros no modo de Reinício. Utilize se o ambiente for instável. Esta opção reduz o débito devido ao registo adicional. /zb Utiliza o modo de Reinício. Se o acesso for negado, esta opção utiliza o modo de Cópia de Segurança. Esta opção reduz o débito devido ao ponto de verificação. /efsraw Copia todos os ficheiros encriptados no modo EFS não processado. Utilize apenas com ficheiros encriptados. log+:<LogFile> Anexa a saída ao ficheiro de registo existente. O exemplo seguinte mostra a saída do comando robocopy para copiar ficheiros para o Data Box Heavy.

C:\Users>Robocopy C:\Git\azure-docs-pr\contributor-guide \\10.100.10.100\devicemanagertest1_AzFile\templates /MT:24 ------------------------------------------------------------------------------- ROBOCOPY :: Robust File Copy for Windows ------------------------------------------------------------------------------- Started : Thursday, April 4, 2019 2:34:58 PM Source : C:\Git\azure-docs-pr\contributor-guide\ Dest : \\10.100.10.100\devicemanagertest1_AzFile\templates\ Files : *.* Options : *.* /DCOPY:DA /COPY:DAT /MT:24 /R:5 /W:60 ------------------------------------------------------------------------------ 100% New File 206 C:\Git\azure-docs-pr\contributor-guide\article-metadata.md 100% New File 209 C:\Git\azure-docs-pr\contributor-guide\content-channel-guidance.md 100% New File 732 C:\Git\azure-docs-pr\contributor-guide\contributor-guide-index.md 100% New File 199 C:\Git\azure-docs-pr\contributor-guide\contributor-guide-pr-criteria.md New File 178 C:\Git\azure-docs-pr\contributor-guide\contributor-guide-pull-request-co100% .md New File 250 C:\Git\azure-docs-pr\contributor-guide\contributor-guide-pull-request-et100% e.md 100% New File 174 C:\Git\azure-docs-pr\contributor-guide\create-images-markdown.md 100% New File 197 C:\Git\azure-docs-pr\contributor-guide\create-links-markdown.md 100% New File 184 C:\Git\azure-docs-pr\contributor-guide\create-tables-markdown.md 100% New File 208 C:\Git\azure-docs-pr\contributor-guide\custom-markdown-extensions.md 100% New File 210 C:\Git\azure-docs-pr\contributor-guide\file-names-and-locations.md 100% New File 234 C:\Git\azure-docs-pr\contributor-guide\git-commands-for-master.md 100% New File 186 C:\Git\azure-docs-pr\contributor-guide\release-branches.md 100% New File 240 C:\Git\azure-docs-pr\contributor-guide\retire-or-rename-an-article.md 100% New File 215 C:\Git\azure-docs-pr\contributor-guide\style-and-voice.md 100% New File 212 C:\Git\azure-docs-pr\contributor-guide\syntax-highlighting-markdown.md 100% New File 207 C:\Git\azure-docs-pr\contributor-guide\tools-and-setup.md ------------------------------------------------------------------------------ Total Copied Skipped Mismatch FAILED Extras Dirs : 1 1 1 0 0 0 Files : 17 17 0 0 0 0 Bytes : 3.9 k 3.9 k 0 0 0 0 C:\Users>Para otimizar o desempenho, utilize os seguintes parâmetros do Robocopy ao copiar os dados. (Os números abaixo representam os melhores cenários).

Plataforma Principalmente arquivos < pequenos 512 KB Principalmente ficheiros médios de 512 KB a 1 MB Principalmente arquivos > grandes 1 MB Data Box Heavy 6 sessões de Robocopy

24 threads por sessões6 sessões de Robocopy

16 threads por sessões6 sessões de Robocopy

16 threads por sessõesPara obter mais informações sobre o comando do Robocopy, aceda a Robocopy e alguns exemplos.

Abra a pasta de destino para ver e verificar os ficheiros copiados.

À medida que os dados são copiados:

- Os nomes, tamanhos e formato dos ficheiros são validados para garantir que cumprem os limites de armazenamento e de objetos do Azure, bem como as convenções de nomenclatura dos contentores e dos ficheiros do Azure.

- Para garantir a integridade dos dados, a soma de verificação também é calculada inline.

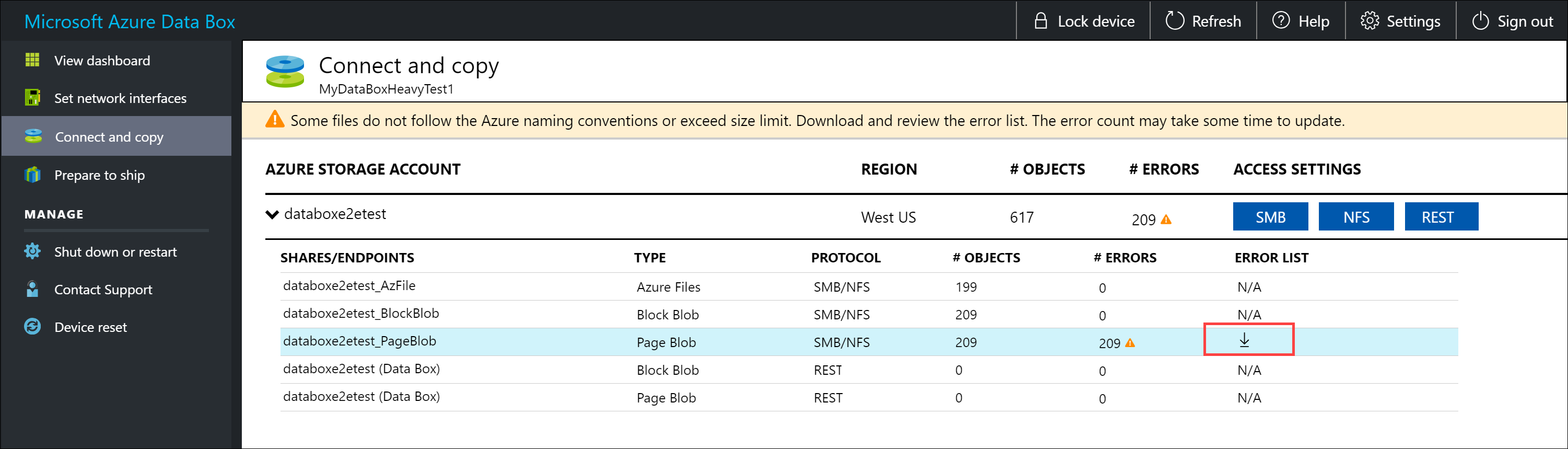

Se ocorrerem erros durante o processo de cópia, transfira os ficheiros de erro para resolução de problemas. Selecione o ícone de seta para transferir os ficheiros de erro.

Para obter mais informações, veja a secção Ver registos de erros durante a cópia de dados para o Data Box Heavy. Para obter uma lista detalhada de erros durante a cópia de dados, veja a secção Resolver problemas do Data Box Heavy.

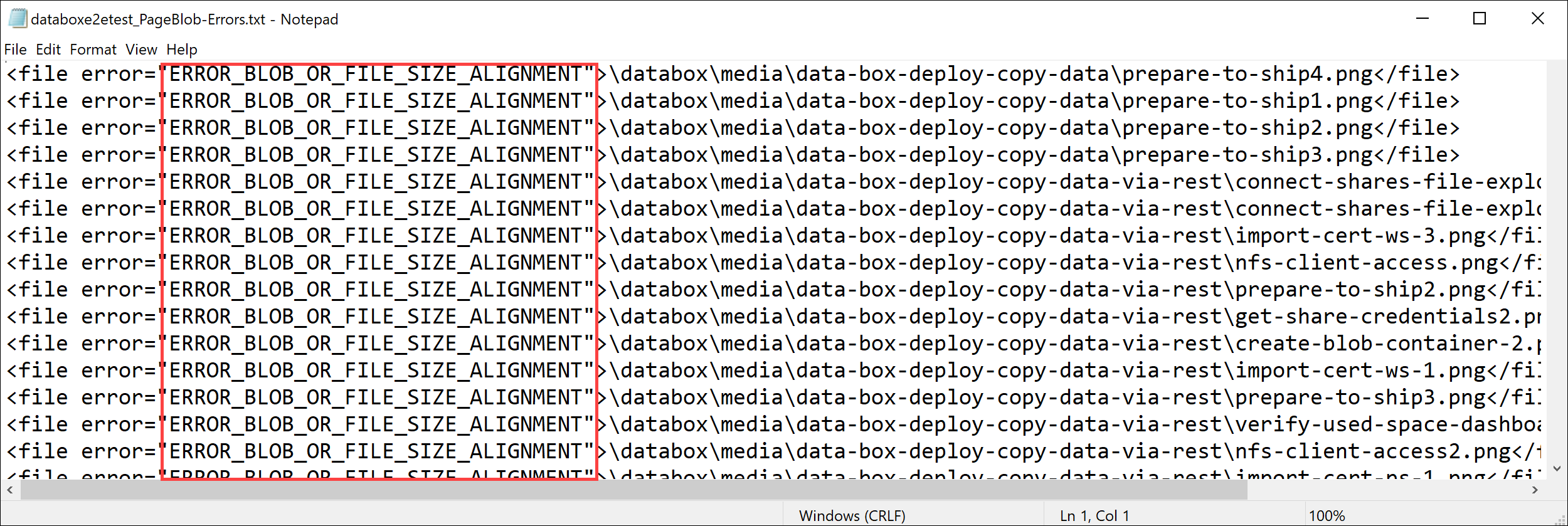

Abra o ficheiro de erros no Bloco de notas. O ficheiro de erros a seguir indica que os dados não estão corretamente alinhados.

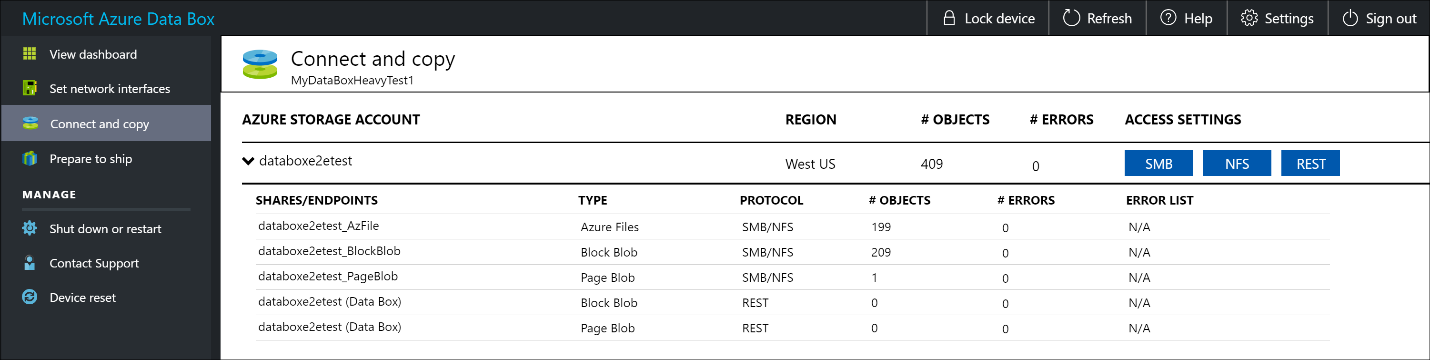

Num blob de páginas, os dados têm de ter um alinhamento de 512 bytes. Uma vez estes dados removidos, o erro ficará resolvido conforme mostrado na seguinte captura de ecrã.

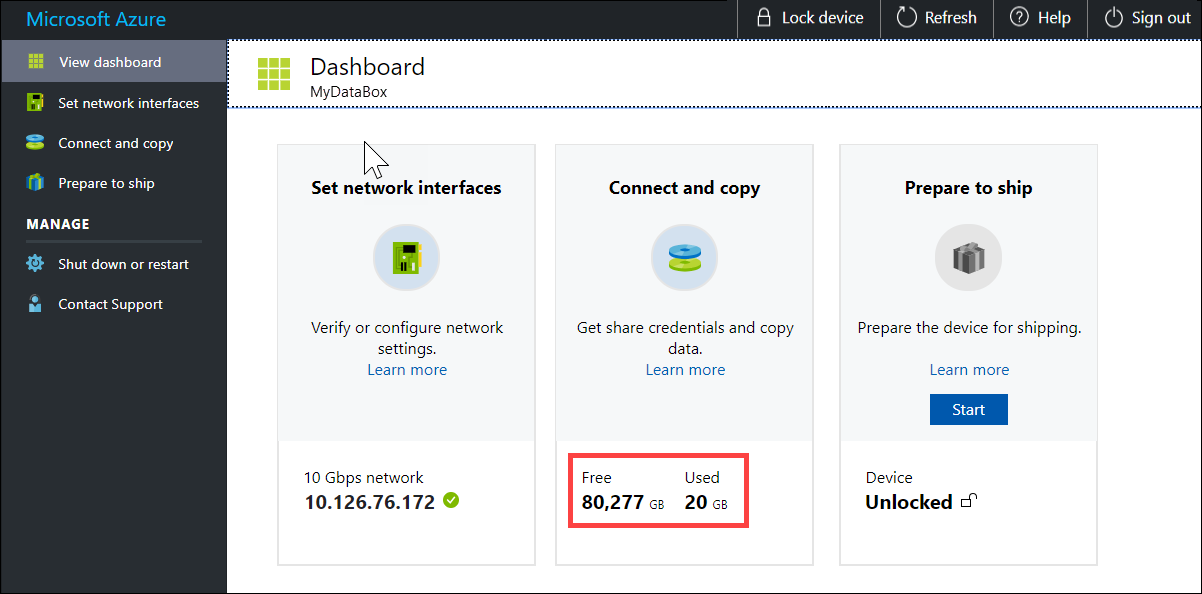

Uma vez concluída a cópia, aceda à página Ver Dashboard. Verifique o espaço utilizado e o espaço livre no dispositivo.

Repita os passos acima para copiar dados para o segundo nó do dispositivo.

Próximos passos

Neste tutorial, ficou a conhecer tópicos do Azure Data Box Heavy, como:

- Ligar ao Data Box Heavy

- Copiar dados para o Data Box Heavy

Avance para o tutorial seguinte para saber como enviar o Data Box Heavy de volta para a Microsoft.

Copiar dados através de SMB

Se estiver a utilizar um sistema anfitrião do Windows, utilize o seguinte comando para se ligar às partilhas SMB:

\\<IP address of your device>\ShareNamePara obter as credenciais de acesso de partilha, aceda à página Ligar e copiar na IU da Web local do Data Box.

Utilize uma ferramenta de cópia de ficheiros compatível com SMB, como o Robocopy, para copiar os dados para as partilhas.

Para obter instruções passo a passo, vá para Tutorial: Copiar dados para o Azure Data Box via SMB.

Copiar dados através de NFS

Se estiver a utilizar um sistema anfitrião NFS, utilize o seguinte comando para montar as partilhas NFS:

sudo mount <Data Box device IP>:/<NFS share on Data Box device> <Path to the folder on local Linux computer>Para obter as credenciais de acesso às partilhas, aceda à página Ligar e copiar na IU da Web local do Data Box Heavy.

Utilize o comando

cpoursyncpara copiar os dados.Repita estes passos para se ligar e copiar os dados para o segundo nó do Data Box Heavy.

Para obter instruções passo a passo, vá para Tutorial: Copiar dados para o Azure Data Box via NFS.

Copiar dados via REST

- Para copiar dados através do Armazenamento de blobs do Data Box via APIs REST, pode ligar-se através de http ou https.

- Para copiar dados para o Armazenamento de blobs do Data Box, pode utilizar o AzCopy.

- Repita estes passos para se ligar e copiar os dados para o segundo nó do Data Box Heavy.

Para obter instruções passo a passo, vá para Tutorial: Copiar dados para o armazenamento de Blob do Azure Data Box por meio de APIs REST.

Copiar dados através do serviço de cópia de dados

- Para copiar dados através do serviço de cópia de dados, tem de criar uma tarefa. Na interface do usuário da Web local do seu Data Box Heavy, vá para Manage > Copy data > Create.

- Preencha os parâmetros e crie uma tarefa.

- Repita estes passos para se ligar e copiar os dados para o segundo nó do Data Box Heavy.

Para obter instruções passo a passo, vá para Tutorial: Usar o serviço de cópia de dados para copiar dados no Azure Data Box Heavy.

Copiar dados para discos geridos

- Ao encomendar o dispositivo Data Box Heavy, deve ter selecionado discos geridos como o destino de armazenamento.

- Pode ligar-se ao Data Box Heavy via partilhas SMB ou NFS.

- Em seguida, pode copiar os dados através das ferramentas SMB ou NFS.

- Repita estes passos para se ligar e copiar os dados para o segundo nó do Data Box Heavy.

Para obter instruções passo a passo, vá para Tutorial: Usar o Data Box Heavy para importar dados como discos gerenciados no Azure.