Configurar uma conexão para usar a inferência de modelo de IA do Azure em seu projeto de IA

Importante

Os itens marcados (visualização) neste artigo estão atualmente em visualização pública. Essa visualização é fornecida sem um contrato de nível de serviço e não a recomendamos para cargas de trabalho de produção. Algumas funcionalidades poderão não ser suportadas ou poderão ter capacidades limitadas. Para obter mais informações, veja Termos Suplementares de Utilização para Pré-visualizações do Microsoft Azure.

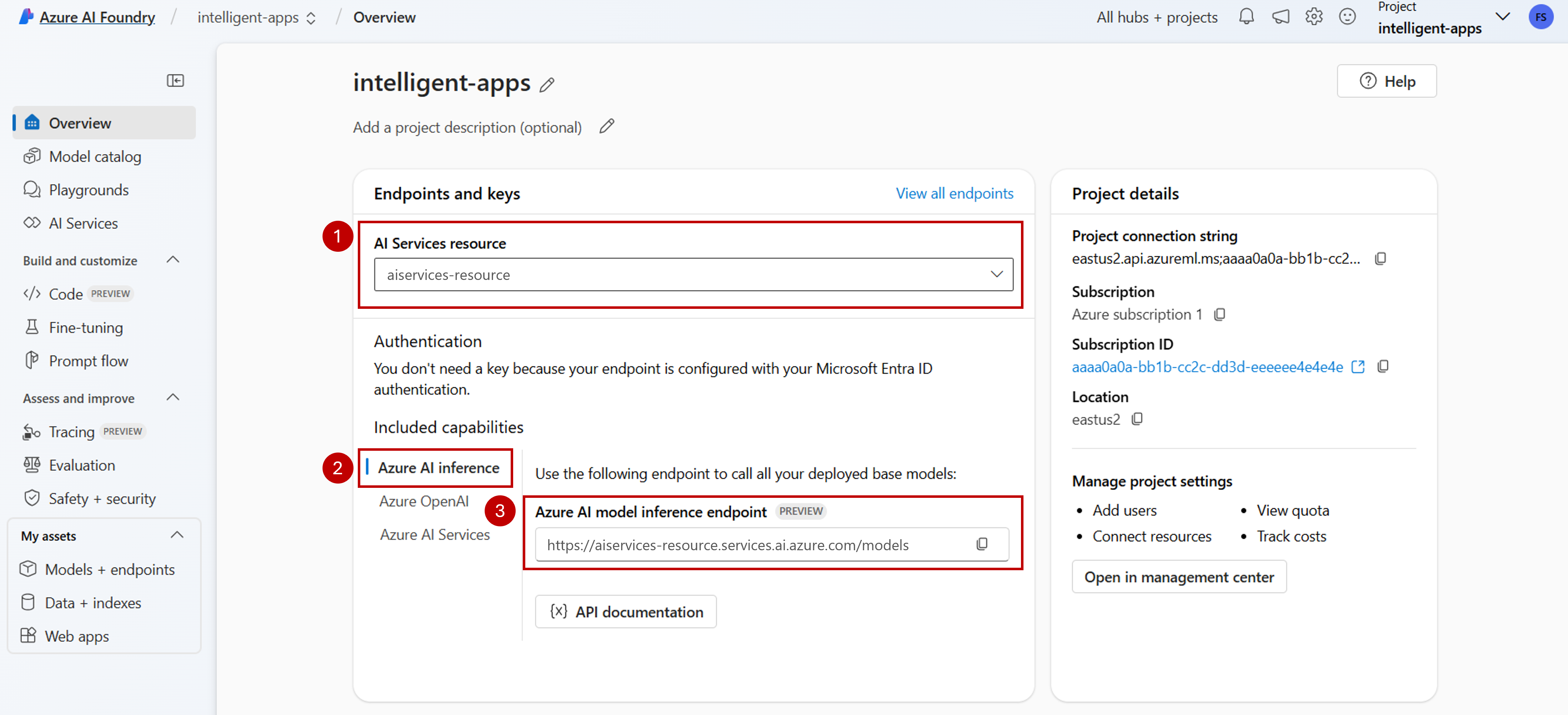

Você pode usar a inferência de modelo de IA do Azure em seus projetos no Azure AI Foundry para criar aplicativos de alcance e interagir/gerenciar os modelos disponíveis. Para usar o serviço de inferência de modelo de IA do Azure em seu projeto, você precisa criar uma conexão com o recurso Serviços de IA do Azure.

O artigo a seguir explica como criar uma conexão com o recurso Serviços de IA do Azure para usar o ponto de extremidade de inferência.

Pré-requisitos

Para concluir este artigo, precisa de:

Uma subscrição do Azure. Se você estiver usando Modelos do GitHub, poderá atualizar sua experiência e criar uma assinatura do Azure no processo. Leia Atualização de modelos do GitHub para inferência de modelo de IA do Azure, se esse for o seu caso.

Um recurso de serviços de IA do Azure. Consulte Criar um recurso dos Serviços de IA do Azure para obter mais detalhes.

- Um projeto de IA conectado ao seu recurso dos Serviços de IA do Azure. Você chama siga as etapas em Configurar o serviço de inferência de modelo de IA do Azure no meu projeto no Azure AI Foundry.

Adicionar uma ligação

Você pode criar uma conexão com um recurso de serviços de IA do Azure usando as seguintes etapas:

Vá para Azure AI Foundry Portal.

No canto inferior esquerdo da tela, selecione Centro de gerenciamento.

Na seção Conexões , selecione Nova conexão.

Selecione Serviços de IA do Azure.

No navegador, procure um recurso existente dos Serviços de IA do Azure em sua assinatura.

Selecione Adicionar ligação.

A nova conexão é adicionada ao seu Hub.

Volte à página de destino do projeto para continuar e agora selecione a nova conexão criada. Atualize a página se ela não aparecer imediatamente.

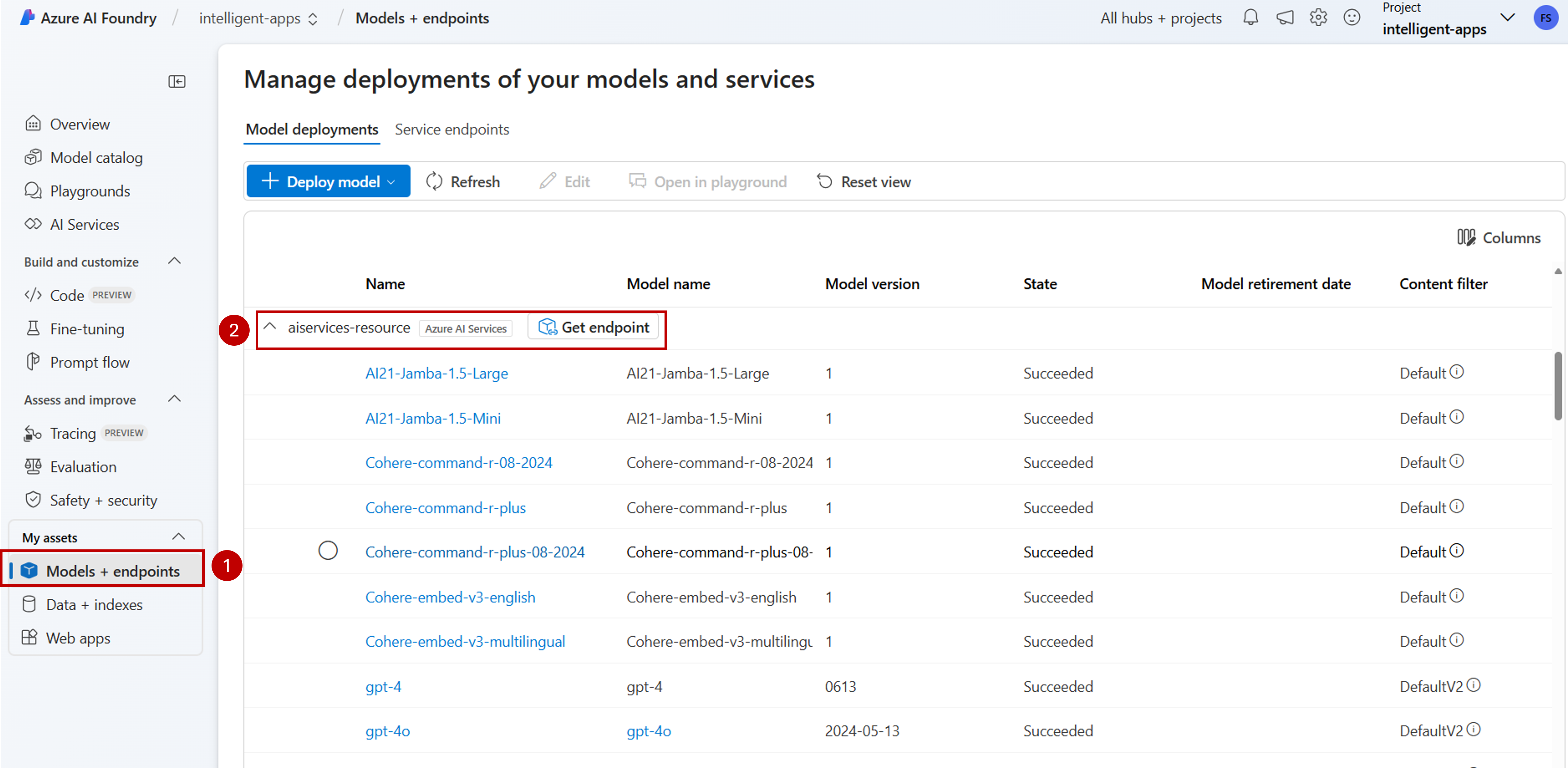

Veja implantações de modelo no recurso conectado

Você pode ver as implantações de modelo disponíveis no recurso conectado seguindo estas etapas:

Vá para Azure AI Foundry Portal.

Na barra de navegação esquerda, selecione Modelos + pontos de extremidade.

A página exibe as implantações de modelo disponíveis para você, agrupadas por nome de conexão. Localize a conexão que você acabou de criar, que deve ser do tipo Azure AI Services.

Selecione qualquer implantação de modelo que você deseja inspecionar.

A página de detalhes mostra informações sobre a implantação específica. Se você quiser testar o modelo, você pode usar a opção Abrir no playground.

O playground do Azure AI Foundry é exibido, onde você pode interagir com o modelo determinado.

Importante

Os itens marcados (visualização) neste artigo estão atualmente em visualização pública. Essa visualização é fornecida sem um contrato de nível de serviço e não a recomendamos para cargas de trabalho de produção. Algumas funcionalidades poderão não ser suportadas ou poderão ter capacidades limitadas. Para obter mais informações, veja Termos Suplementares de Utilização para Pré-visualizações do Microsoft Azure.

Você pode usar a inferência de modelo de IA do Azure em seus projetos no Azure AI Foundry para criar aplicativos de alcance e interagir/gerenciar os modelos disponíveis. Para usar o serviço de inferência de modelo de IA do Azure em seu projeto, você precisa criar uma conexão com o recurso Serviços de IA do Azure.

O artigo a seguir explica como criar uma conexão com o recurso Serviços de IA do Azure para usar o ponto de extremidade de inferência.

Pré-requisitos

Para concluir este artigo, precisa de:

Uma subscrição do Azure. Se você estiver usando Modelos do GitHub, poderá atualizar sua experiência e criar uma assinatura do Azure no processo. Leia Atualização de modelos do GitHub para inferência de modelo de IA do Azure, se esse for o seu caso.

Um recurso de serviços de IA do Azure. Consulte Criar um recurso dos Serviços de IA do Azure para obter mais detalhes.

Instale a CLI do Azure e a extensão para o

mlAzure AI Foundry:az extension add -n mlIdentifique as seguintes informações:

O seu ID de subscrição do Azure.

Seu nome de recurso dos Serviços de IA do Azure.

O grupo de recursos onde o recurso dos Serviços de IA do Azure é implantado.

Adicionar uma ligação

Para adicionar um modelo, primeiro você precisa identificar o modelo que deseja implantar. Você pode consultar os modelos disponíveis da seguinte maneira:

Inicie sessão na sua subscrição do Azure:

az loginConfigure a CLI para apontar para o projeto:

az account set --subscription <subscription> az configure --defaults workspace=<project-name> group=<resource-group> location=<location>Crie uma definição de conexão:

connection.yml

name: <connection-name> type: aiservices endpoint: https://<ai-services-resourcename>.services.ai.azure.com api_key: <resource-api-key>Crie a ligação:

az ml connection create -f connection.ymlNeste ponto, a conexão está disponível para consumo.

Importante

Os itens marcados (visualização) neste artigo estão atualmente em visualização pública. Essa visualização é fornecida sem um contrato de nível de serviço e não a recomendamos para cargas de trabalho de produção. Algumas funcionalidades poderão não ser suportadas ou poderão ter capacidades limitadas. Para obter mais informações, veja Termos Suplementares de Utilização para Pré-visualizações do Microsoft Azure.

Você pode usar a inferência de modelo de IA do Azure em seus projetos no Azure AI Foundry para criar aplicativos de alcance e interagir/gerenciar os modelos disponíveis. Para usar o serviço de inferência de modelo de IA do Azure em seu projeto, você precisa criar uma conexão com o recurso Serviços de IA do Azure.

O artigo a seguir explica como criar uma conexão com o recurso Serviços de IA do Azure para usar o ponto de extremidade de inferência.

Pré-requisitos

Para concluir este artigo, precisa de:

Uma subscrição do Azure. Se você estiver usando Modelos do GitHub, poderá atualizar sua experiência e criar uma assinatura do Azure no processo. Leia Atualização de modelos do GitHub para inferência de modelo de IA do Azure, se esse for o seu caso.

Um recurso de serviços de IA do Azure. Consulte Criar um recurso dos Serviços de IA do Azure para obter mais detalhes.

Um projeto de IA do Azure com um Hub de IA.

Instale a CLI do Azure.

Identifique as seguintes informações:

O seu ID de subscrição do Azure.

Seu nome de recurso dos Serviços de IA do Azure.

Sua ID de recurso dos Serviços de IA do Azure.

O nome do Hub de IA do Azure onde o projeto é implantado.

O grupo de recursos onde o recurso dos Serviços de IA do Azure é implantado.

Adicionar uma ligação

Use o modelo

ai-services-connection-template.biceppara descrever a conexão:ai-services-conexão-modelo.bicep

@description('Name of the hub where the connection will be created') param hubName string @description('Name of the connection') param name string @description('Category of the connection') param category string = 'AIServices' @allowed(['AAD', 'ApiKey', 'ManagedIdentity', 'None']) param authType string = 'AAD' @description('The endpoint URI of the connected service') param endpointUri string @description('The resource ID of the connected service') param resourceId string = '' @secure() param key string = '' resource connection 'Microsoft.MachineLearningServices/workspaces/connections@2024-04-01-preview' = { name: '${hubName}/${name}' properties: { category: category target: endpointUri authType: authType isSharedToAll: true credentials: authType == 'ApiKey' ? { key: key } : null metadata: { ApiType: 'Azure' ResourceId: resourceId } } }Execute a implantação:

RESOURCE_GROUP="<resource-group-name>" ACCOUNT_NAME="<azure-ai-model-inference-name>" ENDPOINT_URI="https://<azure-ai-model-inference-name>.services.ai.azure.com" RESOURCE_ID="<resource-id>" HUB_NAME="<hub-name>" az deployment group create \ --resource-group $RESOURCE_GROUP \ --template-file ai-services-connection-template.bicep \ --parameters accountName=$ACCOUNT_NAME hubName=$HUB_NAME endpointUri=$ENDPOINT_URI resourceId=$RESOURCE_ID