Atualização de modelos do GitHub para inferência de modelo de IA do Azure

Se você quiser desenvolver um aplicativo de IA generativa, você pode usar o GitHub Models para encontrar e experimentar modelos de IA gratuitamente. O playground e o uso gratuito da API são limitados por solicitações por minuto, solicitações por dia, tokens por solicitação e solicitações simultâneas. Se você tiver uma taxa limitada, precisará esperar que o limite de taxa que você atingiu seja redefinido antes de poder fazer mais solicitações.

Quando estiver pronto para colocar seu aplicativo em produção, você poderá atualizar sua experiência implantando um recurso dos Serviços de IA do Azure em uma assinatura do Azure e começar a usar o serviço de inferência de modelo de IA do Azure. Você não precisa alterar mais nada em seu código.

O artigo a seguir explica como começar a partir dos Modelos do GitHub e implantar um recurso dos Serviços de IA do Azure com inferência de modelo de IA do Azure.

Pré-requisitos

Para concluir este tutorial, precisa de:

- Uma conta do GitHub com acesso aos modelos do GitHub.

- Uma subscrição do Azure. Se você não tiver uma, será solicitado que você crie ou atualize sua conta do Azure para uma conta de pagamento conforme o uso quando estiver pronto para implantar seu modelo na produção.

Atualizar para a inferência de modelo de IA do Azure

Os limites de taxa para o playground e o uso gratuito da API destinam-se a ajudá-lo a experimentar modelos e desenvolver seu aplicativo de IA. Quando estiver pronto para colocar seu aplicativo em produção, use uma chave e um ponto de extremidade de uma conta paga do Azure. Você não precisa alterar mais nada em seu código.

Para obter a chave e o ponto de extremidade:

Acesse os modelos do GitHub e selecione o modelo em que está interessado.

No playground do seu modelo, selecione Obter chave de API.

Selecione Obter chave de produção.

Se você não tiver uma conta do Azure, selecione Criar minha conta e siga as etapas para criar uma.

Se você tiver uma conta do Azure, selecione Entrar novamente.

Se a sua conta existente for uma conta gratuita, primeiro tem de atualizar para um plano Pay as you go. Depois de atualizar, volte para o playground e selecione Obter chave de API novamente e, em seguida, entre com sua conta atualizada.

Depois de entrar na sua conta do Azure, você será direcionado para o Azure AI Studio > GitHub. Pode levar um ou dois minutos para carregar os detalhes iniciais do modelo no AI Studio.

A página é carregada com os detalhes do seu modelo. Selecione o botão Implantar para implantar o modelo em sua conta.

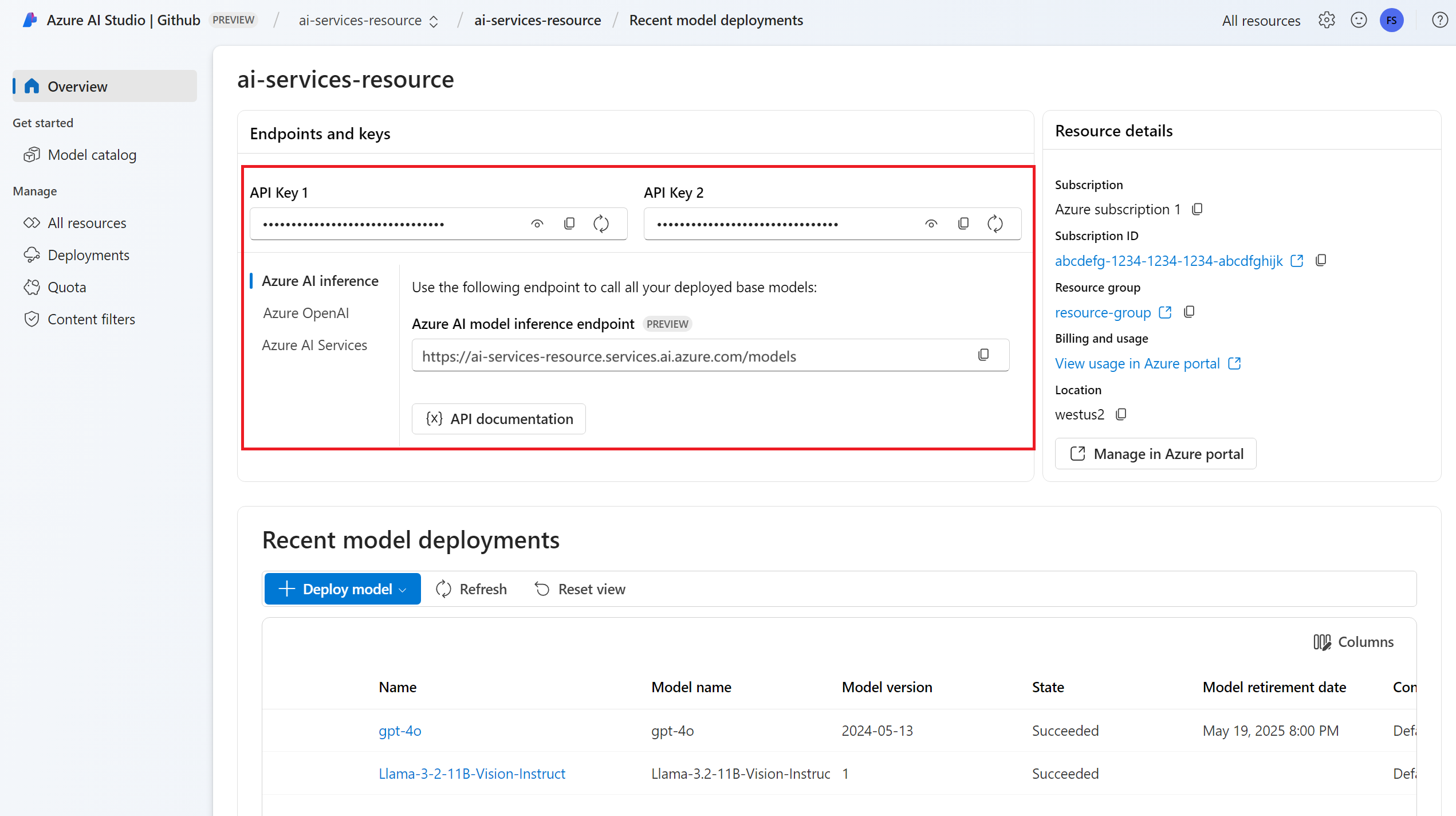

Depois de implantado, a chave de API e o ponto de extremidade do modelo são mostrados na visão geral. Use esses valores em seu código para usar o modelo em seu ambiente de produção.

Neste ponto, o modelo selecionado está pronto para ser consumido.

Atualize seu código para usar o novo ponto de extremidade

Depois que seu recurso dos Serviços de IA do Azure estiver configurado, você poderá começar a consumi-lo a partir do seu código. Para consumir o recurso dos Serviços de IA do Azure, você precisa da URL e da chave do ponto de extremidade, que estão disponíveis na seção Visão geral :

Você pode usar qualquer um dos SDKs suportados para obter previsões do ponto de extremidade. Os seguintes SDKs são oficialmente suportados:

- OpenAI SDK

- Azure OpenAI SDK

- Azure AI Inference SDK

Consulte a seção Idiomas suportados e SDKs para obter mais detalhes e exemplos. O exemplo a seguir mostra como usar o SDK de inferência de modelo de IA do Azure com o modelo recém-implantado:

Instale o pacote azure-ai-inference usando seu gerenciador de pacotes, como pip:

pip install azure-ai-inference

Em seguida, você pode usar o pacote para consumir o modelo. O exemplo a seguir mostra como criar um cliente para consumir finalizações de chat:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

Explore nossos exemplos e leia a documentação de referência da API para começar.

Gere sua primeira conclusão de bate-papo:

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

Use o parâmetro model="<deployment-name> para rotear sua solicitação para essa implantação.

As implantações funcionam como um alias de um determinado modelo em determinadas configurações. Consulte Página de conceito de roteamento para saber como os Serviços de IA do Azure encaminham implantações.

Importante

Ao contrário dos Modelos do GitHub, onde todos os modelos já estão configurados, o recurso Serviços de IA do Azure permite controlar quais modelos estão disponíveis em seu ponto de extremidade e em qual configuração. Adicione quantos modelos você planeja usar antes de model indicá-los no parâmetro. Saiba como adicionar mais modelos ao seu recurso.

Explore recursos adicionais

A inferência de modelo de IA do Azure dá suporte a recursos adicionais não disponíveis nos Modelos do GitHub, incluindo:

- Explore o catálogo de modelos para ver modelos adicionais não disponíveis nos modelos do GitHub.

- Configure a autenticação sem chave.

- Configure a filtragem de conteúdo.

- Configure o limite de taxa (para modelos específicos).

- Explore SKUs de implantação adicionais (para modelos específicos).

- Configure a rede privada.

Tem problemas?

Consulte a secção FAQ para obter mais ajuda.

Próximos passos

- Explore o catálogo de modelos no Azure AI studio.

- Adicione mais modelos ao seu endpoint.