Exemplo de preços: Integração de dados na VNET gerenciada do Azure Data Factory

APLICA-SE A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Gorjeta

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange tudo, desde a movimentação de dados até ciência de dados, análises em tempo real, business intelligence e relatórios. Saiba como iniciar uma nova avaliação gratuitamente!

Nesse cenário, você deseja excluir arquivos originais no Armazenamento de Blobs do Azure e copiar dados do Banco de Dados SQL do Azure para o Armazenamento de Blobs do Azure em uma programação horária por 8 horas por dia. Calculamos o preço por 30 dias. Você faz essa execução duas vezes em pipelines diferentes para cada execução. O tempo de execução desses dois gasodutos está sobreposto.

Os preços usados neste exemplo são hipotéticos e não pretendem implicar preços reais exatos. Os custos de leitura/gravação e monitoramento não são mostrados, pois normalmente são insignificantes e não afetam significativamente os custos gerais. As execuções de atividade também são arredondadas para os 1000 mais próximos nas estimativas da calculadora de preços.

Consulte a Calculadora de Preços do Azure para cenários mais específicos e para estimar seus custos futuros para usar o serviço.

Configuração

Para realizar o cenário, você precisa criar dois pipelines com os seguintes itens:

Para realizar o cenário, você precisa criar dois pipelines com os seguintes itens:

- Uma atividade de pipeline - Excluir atividade.

- Uma atividade de cópia com um conjunto de dados de entrada para os dados a serem copiados do armazenamento de Blob do Azure.

- Um conjunto de dados de saída para os dados no Banco de Dados SQL do Azure.

- Um gatilho de agendamento para executar o pipeline. Quando quiser executar um pipeline, você pode acioná-lo imediatamente ou agendá-lo. Além do pipeline em si, cada instância de gatilho conta como uma única execução de atividade.

Estimativa de custos

| Operações | Tipos e Unidades |

|---|---|

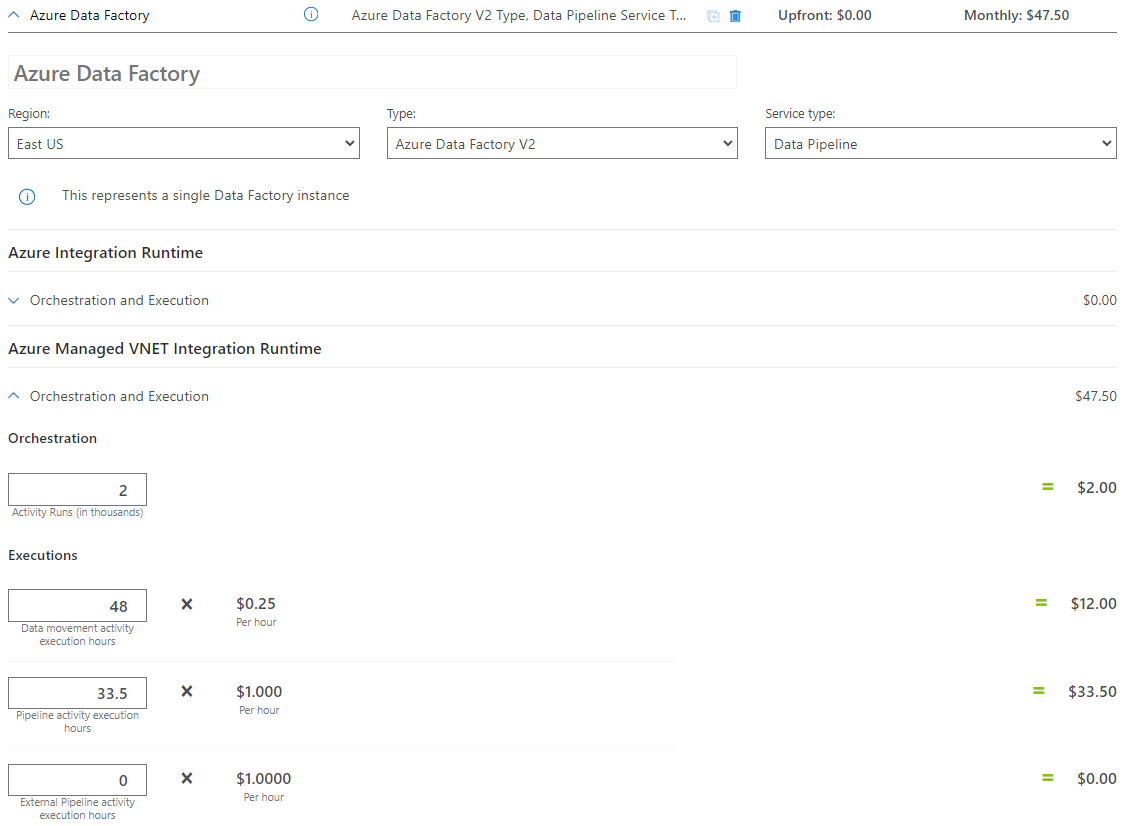

| Executar pipeline | 6 execuções de atividade por execução (2 para execuções de gatilho, 4 para execuções de atividade) = 1440, arredondadas para cima, uma vez que a calculadora só permite incrementos de 1000. |

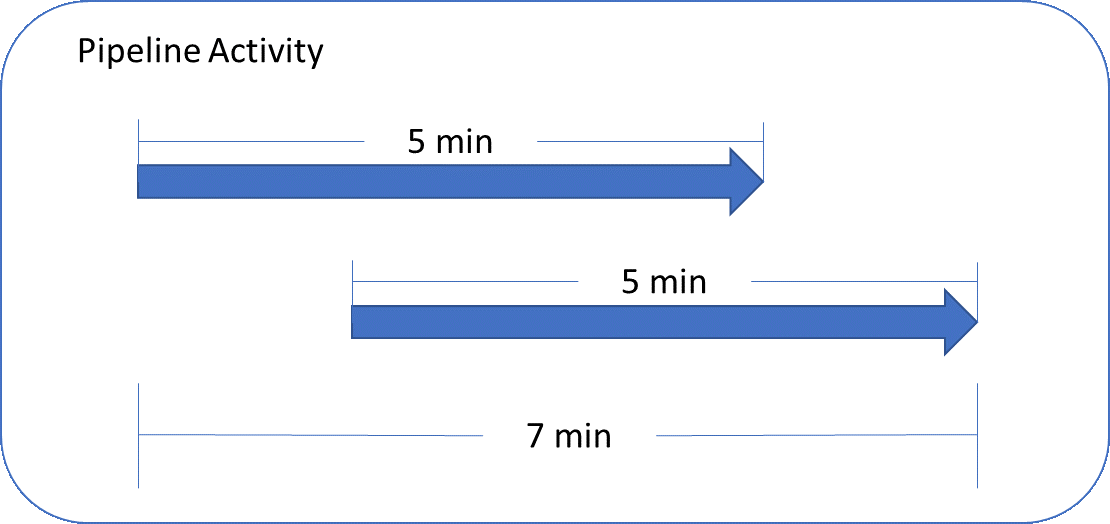

| Executar atividade de exclusão: tempo de execução do pipeline por execução = 7 min. Se a execução de Excluir atividade no primeiro pipeline for das 10h00 UTC às 10h05 UTC e a execução de Excluir atividade no segundo pipeline for das 10h02 UTC às 10h07 UTC. | Total (7 min + 60 min) / 60 min * 30 execuções mensais = 33,5 horas de execução da atividade do pipeline na VNET gerenciada. A atividade de pipeline suporta até 50 execuções simultâneas por nó na VNET gerenciada. Há um tempo de vida (TTL) de 60 minutos para a atividade do pipeline. |

| Suposição de dados de cópia: tempo de execução de DIU por execução = 10 min se a execução de cópia no primeiro pipeline for das 10h06 UTC às 10h15 UTC e a execução da atividade de cópia no segundo pipeline for das 10h08 UTC às 10h17 UTC. | [(10 min + 2 min (o tempo de fila cobra até 2 minutos)) / 60 min * 4 Azure Managed VNET Integration Runtime (configuração DIU padrão = 4)] * 2 = 1,6 horas diárias de execução da atividade de movimentação de dados na VNET gerenciada. Para obter mais informações sobre unidades de integração de dados e otimização do desempenho da cópia, consulte este artigo |

Exemplo de calculadora de preços

Preço total do cenário para 30 dias: $83.50

Conteúdos relacionados

- Exemplo de definição de preço: copie dados do AWS S3 para o armazenamento de Blob do Azure por hora por 30 dias

- Exemplo de definição de preço: copie dados e transforme com o Azure Databricks de hora em hora por 30 dias

- Exemplo de definição de preço: copie dados e transforme com parâmetros dinâmicos de hora em hora por 30 dias

- Exemplo de preços: Executar pacotes SSIS no tempo de execução de integração Azure-SSIS

- Exemplo de definição de preço: Usando a depuração de fluxo de dados de mapeamento para um dia de trabalho normal

- Exemplo de definição de preço: transformar dados no armazenamento de blob com fluxos de dados de mapeamento

- Exemplo de definição de preço: Obter dados delta do SAP ECC via SAP CDC no mapeamento de fluxos de dados