Adicionar origem do Apache Kafka a um Eventstream (versão prévia)

Este artigo mostra como adicionar a origem do Apache Kafka a um Eventstream.

O Apache Kafka é uma plataforma distribuída de software livre para a criação de sistemas de dados escalonáveis e em tempo real. Ao integrar o Apache Kafka como uma origem no eventstream, você pode facilmente trazer eventos em tempo real do Apache Kafka e processá-los antes de roteá-los para vários destinos no Fabric.

Observação

Não há suporte para esta origem nas seguintes regiões de capacidade do espaço de trabalho: Oeste dos EUA 3 e Oeste da Suíça.

Pré-requisitos

- Acesso ao workspace do Fabric com permissões de Colaborador ou acima.

- Um cluster do Apache Kafka em execução.

- O Apache Kafka deve ser acessível publicamente e não estar atrás de um firewall ou protegido em uma rede virtual.

Observação

O número máximo de origens e destinos para um fluxo de eventos é 11.

Adicionar o Apache Kafka como origem

Na Inteligência em Tempo Real do Fabric, selecione Eventstream para criar um eventstream.

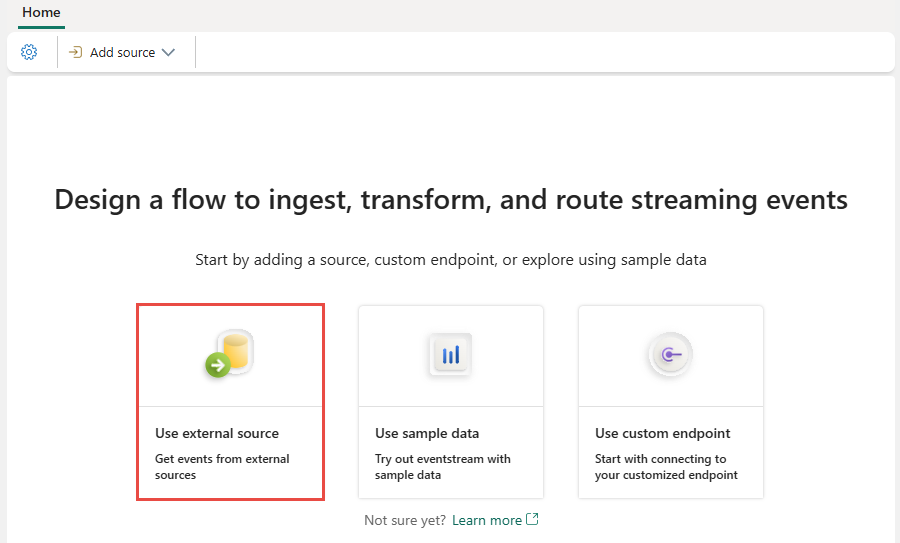

Na tela seguinte, selecione Adicionar origem externa.

Configurar e conectar-se ao Apache Kafka

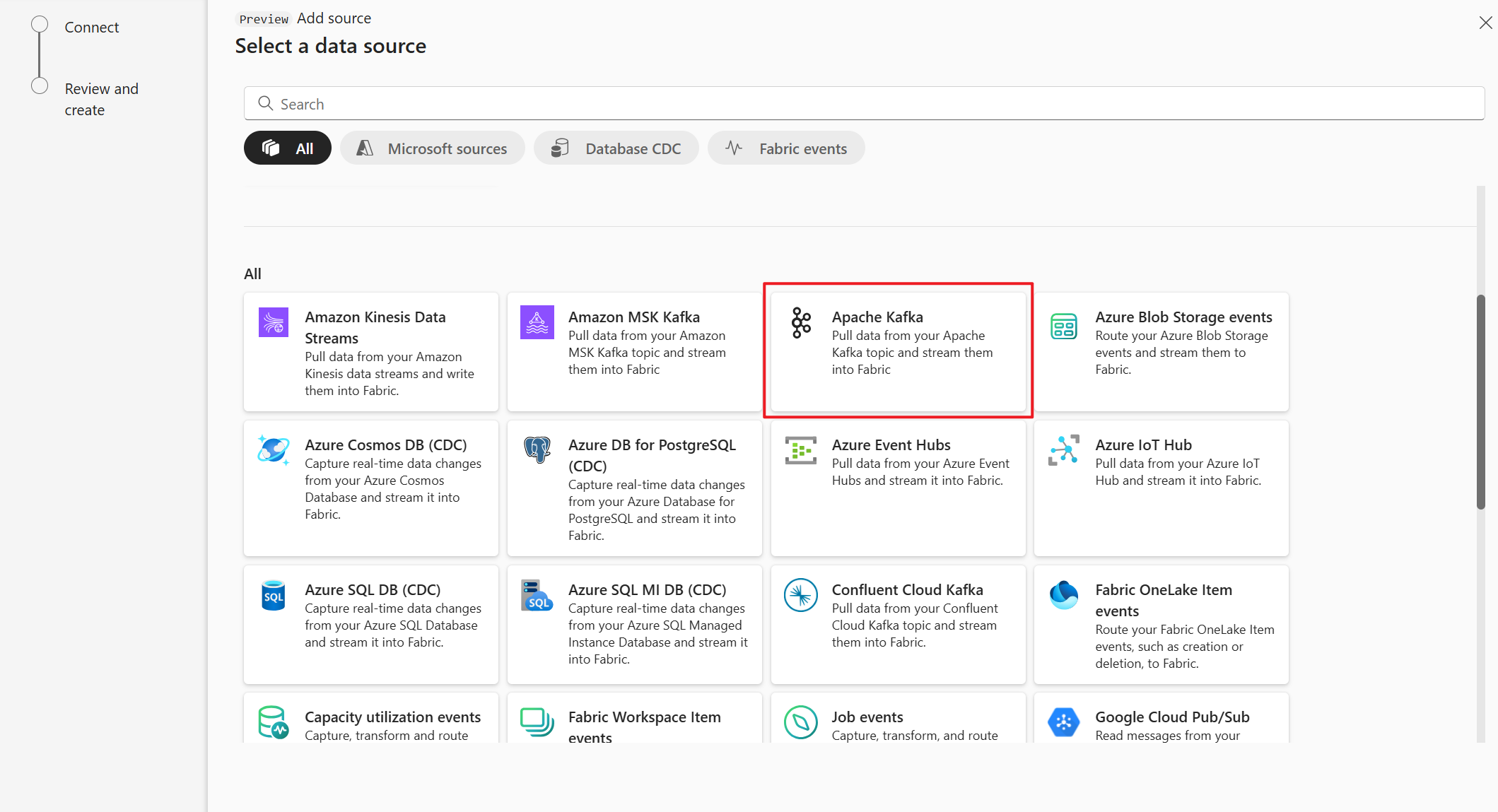

Na página Selecionar uma fonte de dados, selecione apache Kafka.

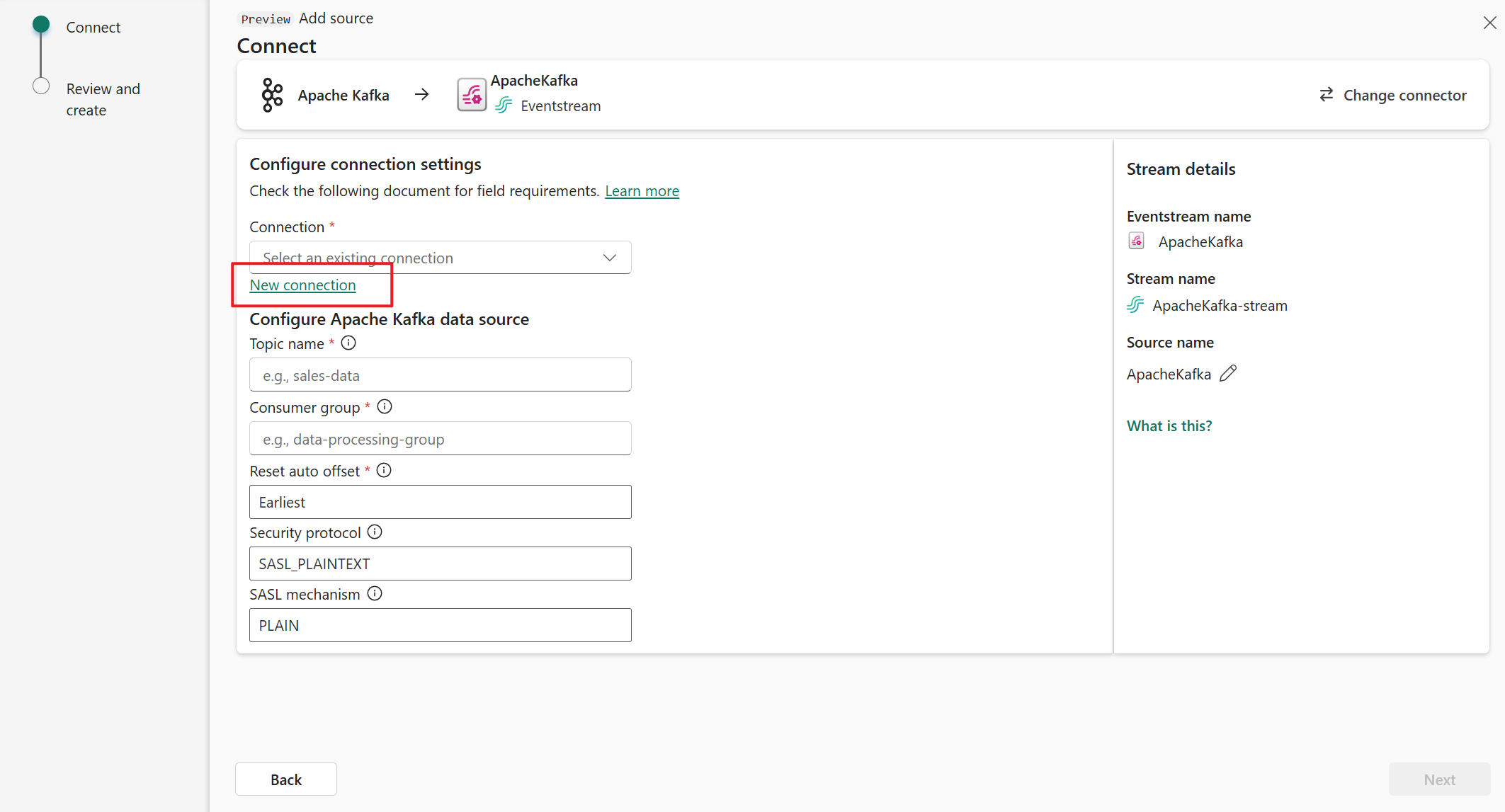

Na página Conectar, selecione Nova conexão.

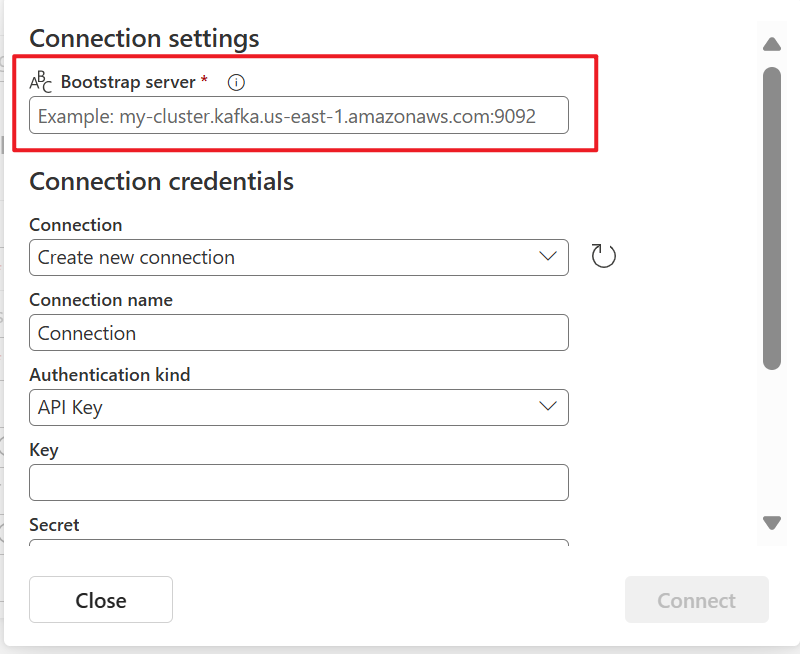

Na seção Configurações de conexão, em Servidor Bootstrap, insira o endereço do servidor Apache Kafka.

Na seção Credenciais de conexão, se você tiver uma conexão existente com o cluster do Apache Kafka, selecione-a na lista suspensa para Conexão. Caso contrário, siga estas etapas:

- Em Nome da conexão, insira um nome para a conexão.

- Em Tipo de autenticação, confirme se a Chave de API está selecionada.

- Em Chave e Segredo, insira a chave de API e o segredo da chave.

Selecione Conectar.

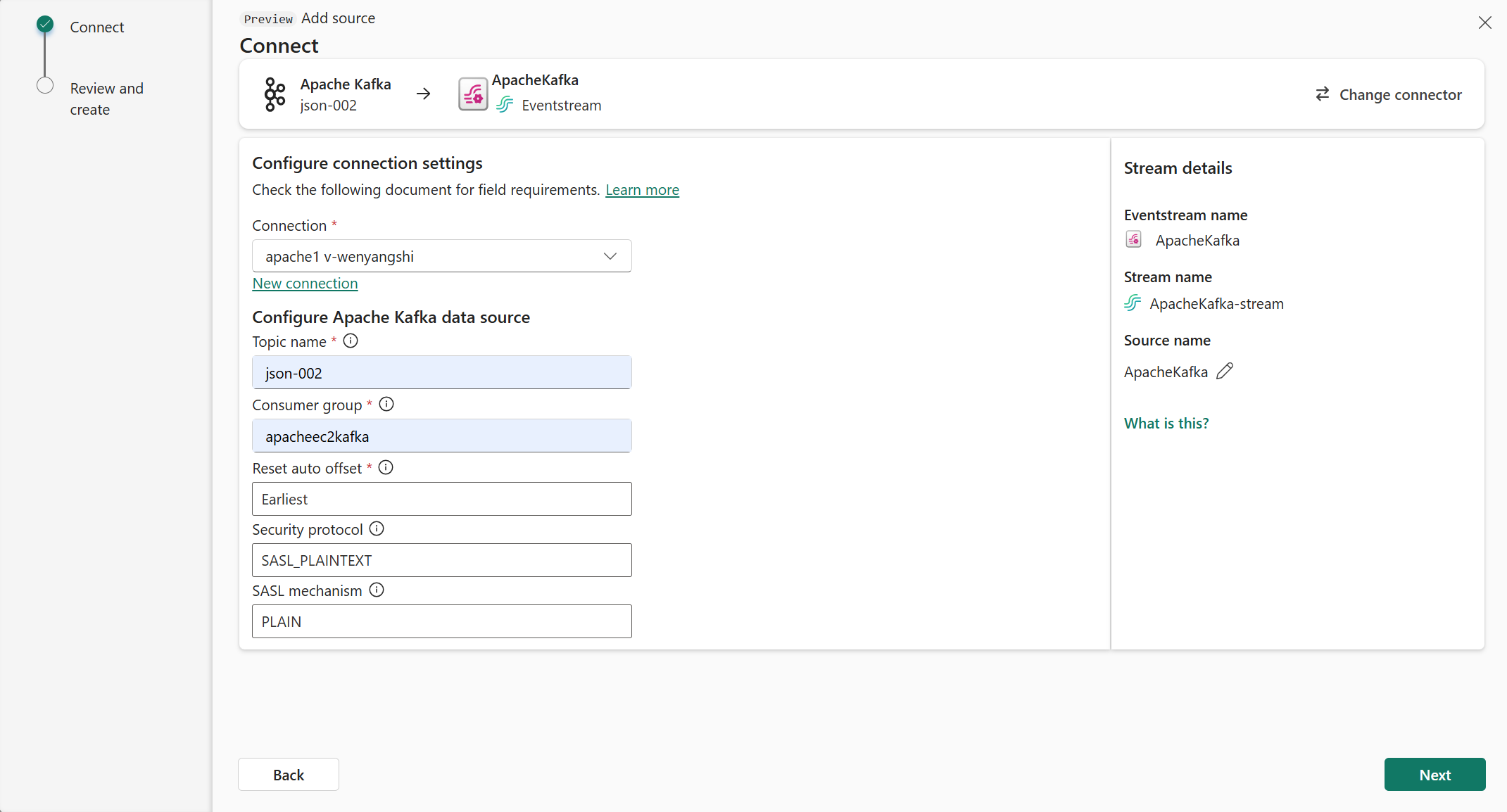

Agora, na página Conectar, siga estas etapas.

Em Tópico, insira o tópico Kafka.

Em Grupo de consumidores, insira o grupo de consumidores do cluster do Apache Kafka. Esse campo fornece um grupo de consumidores dedicado para obter eventos.

Selecione Redefinir deslocamento automático para especificar onde começar a ler os deslocamentos, se não houver confirmação.

Em Protocolo de segurança, o valor padrão é SASL_PLAINTEXT.

Observação

No momento, a origem do Apache Kafka dá suporte apenas à transmissão de dados não criptografada (SASL_PLAINTEXT e PLAINTEXT) entre o cluster do Apache Kafka e o Eventstream. O suporte para transmissão de dados criptografados via SSL estará disponível em breve.

O mecanismo SASL padrão normalmente é PLAIN, a menos que configurado de outra forma. Você pode selecionar o mecanismo SCRAM-SHA-256 ou SCRAM-SHA-512 que atende aos seus requisitos de segurança.

Selecione Avançar. Na tela Revisar e criar, revise o resumo e selecione Adicionar.

Exibir o Eventstream atualizado

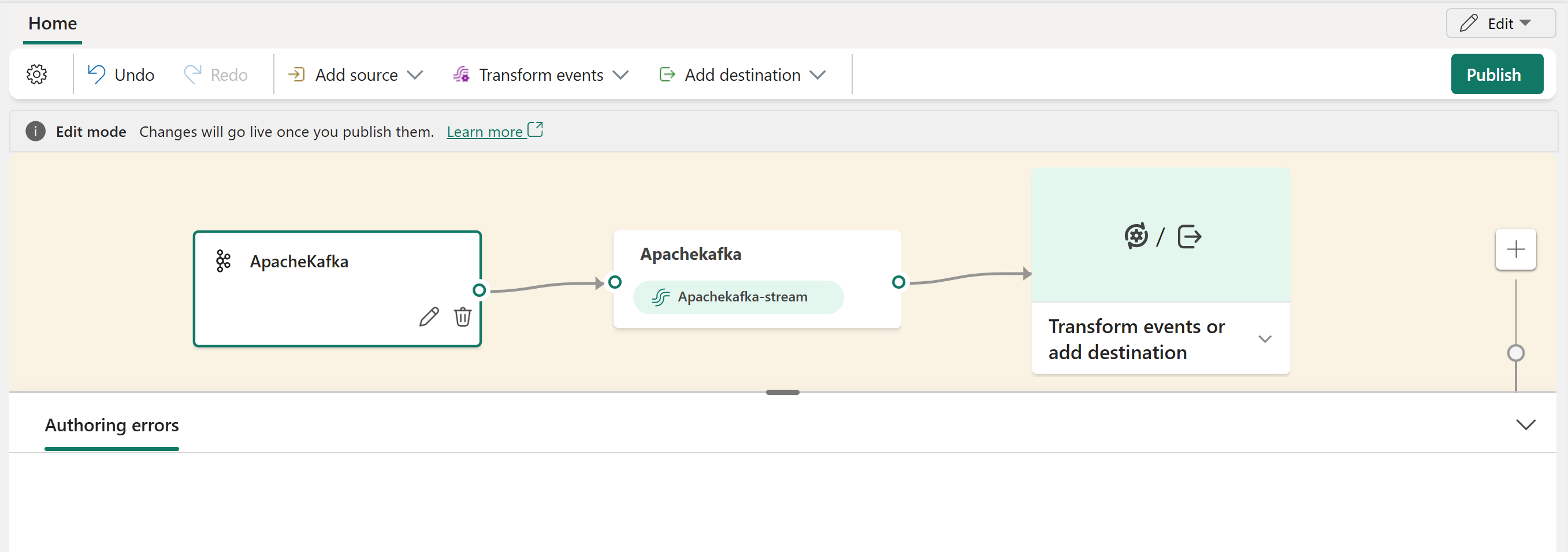

Você pode ver a origem do Apache Kafka adicionada ao Eventstream no modo Editar.

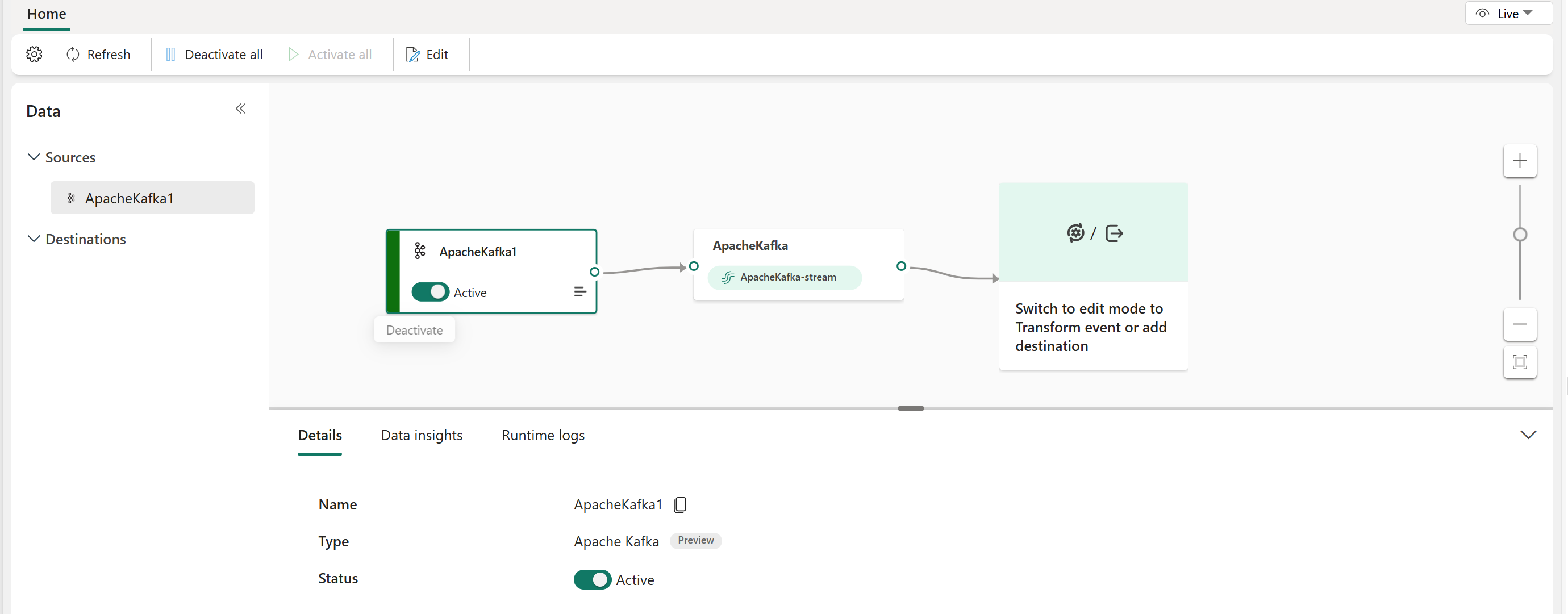

Depois de concluir essas etapas, a origem do Apache Kafka estará disponível para visualização no Modo de exibição ao vivo.

Conteúdo relacionado

Outros conectores:

- Amazon Kinesis Data Streams

- Azure Cosmos DB

- Hubs de eventos do Azure

- Hub IoT do Azure

- Captura de dados de alterações (CDA) com o Banco de Dados SQL do Azure

- Ponto de extremidade personalizado

- Pub/Sub do Google Cloud

- CDA do Banco de Dados MySQL

- CDA do Banco de dados PostgreSQL

- Dados de amostra

- Eventos de Armazenamento de Blobs do Azure

- Evento de espaço de trabalho do Fabric