Adicionar origem do Amazon MSK Kafka a um Eventstream

Este artigo mostra como adicionar a origem do Amazon MSK Kafka a um Eventstream.

O Amazon MSK Kafka é um serviço Kafka totalmente gerenciado que simplifica a instalação, o dimensionamento e o gerenciamento. Ao integrar o Amazon MSK Kafka como uma fonte no eventstream, você pode facilmente trazer os eventos em tempo real do MSK Kafka e processá-los antes de roteá-los para vários destinos dentro do Fabric.

Observação

Não há suporte para esta origem nas seguintes regiões de capacidade do espaço de trabalho: Oeste dos EUA 3 e Oeste da Suíça.

Pré-requisitos

- Acesso a um espaço de trabalho no modo de licença de capacidade do Fabric (ou) no modo de licença de Avaliação com permissões de Colaborador ou superior.

- Um cluster do Amazon MSK Kafka no status ativo.

- O cluster do Amazon MSK Kafka deve ser acessível publicamente e não estar por trás de um firewall ou protegido em uma rede virtual.

Observação

O número máximo de origens e destinos para um fluxo de eventos é 11.

Adicionar o Amazon MSK Kafka como origem

- Na Inteligência em Tempo Real do Fabric, selecione Eventstream para criar um eventstream.

- Na tela seguinte, selecione Adicionar origem externa.

Configurar e conectar-se ao Amazon MSK Kafka

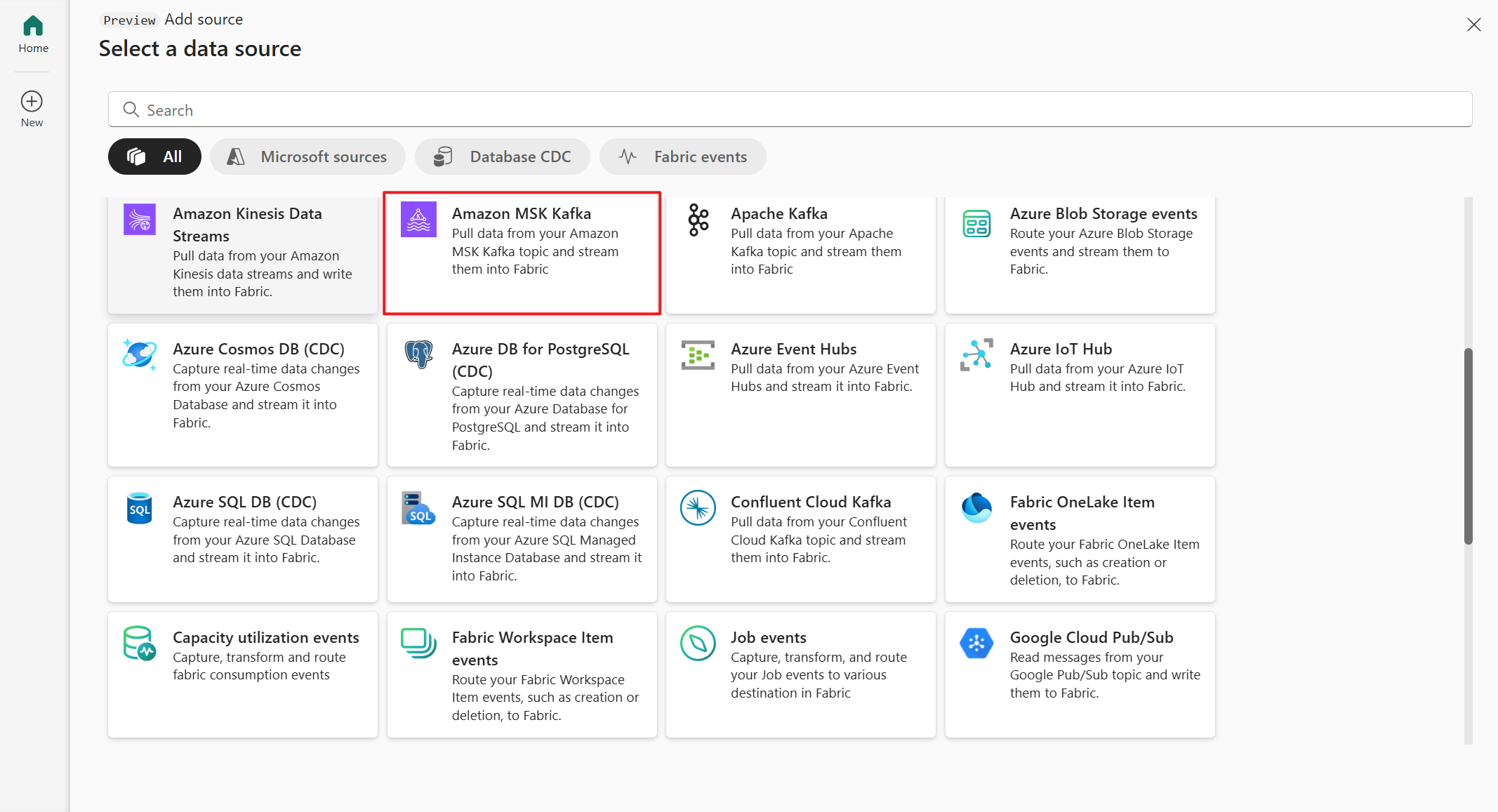

Na página Fontes de dados, selecione Amazon MSK Kafka.

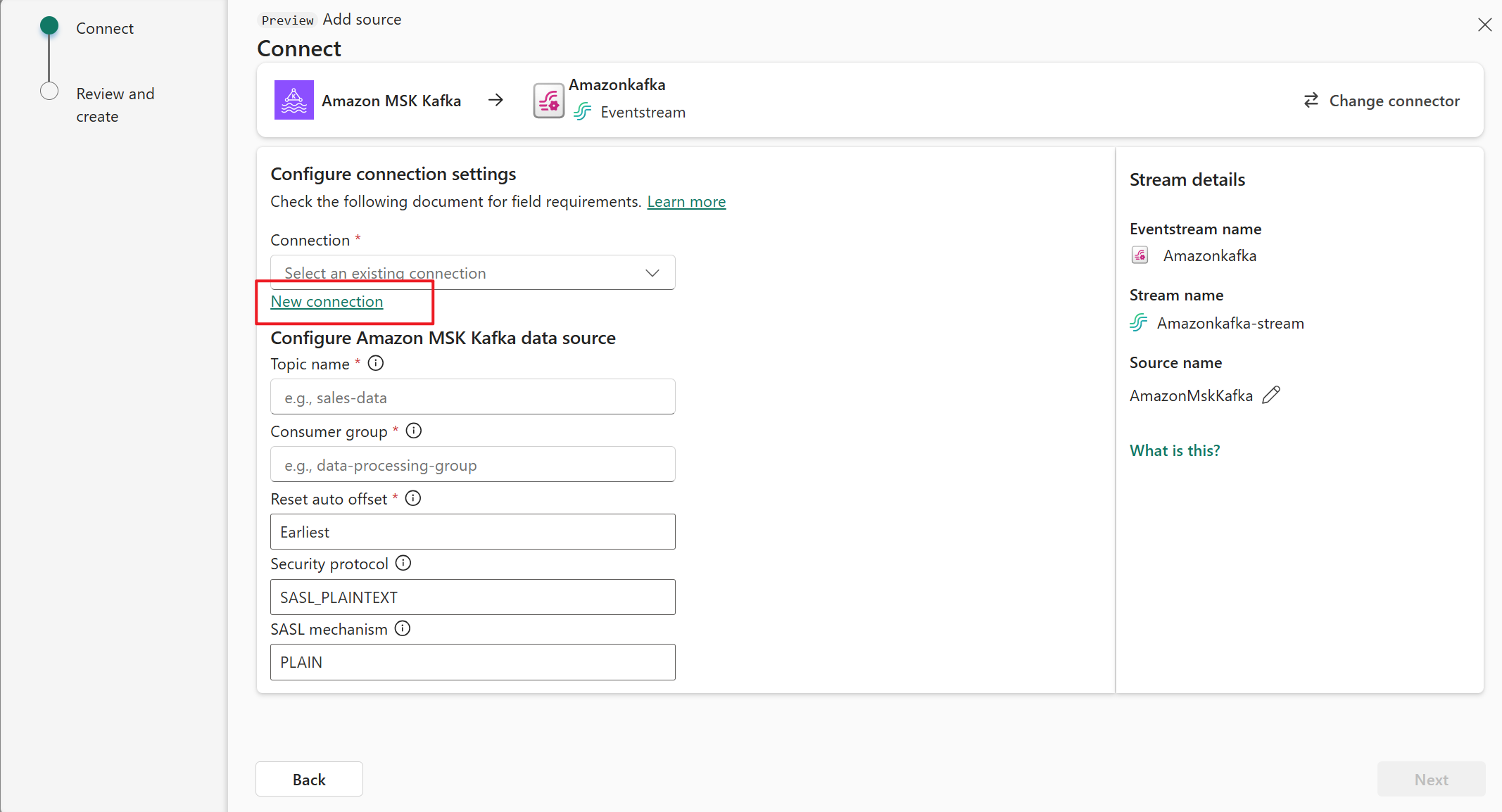

Na página Conectar, selecione Nova conexão.

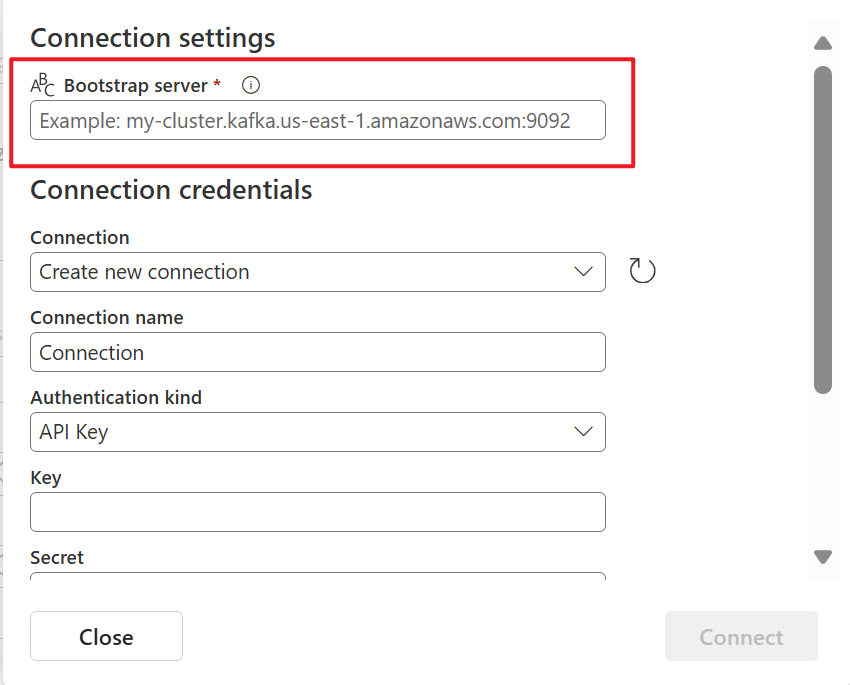

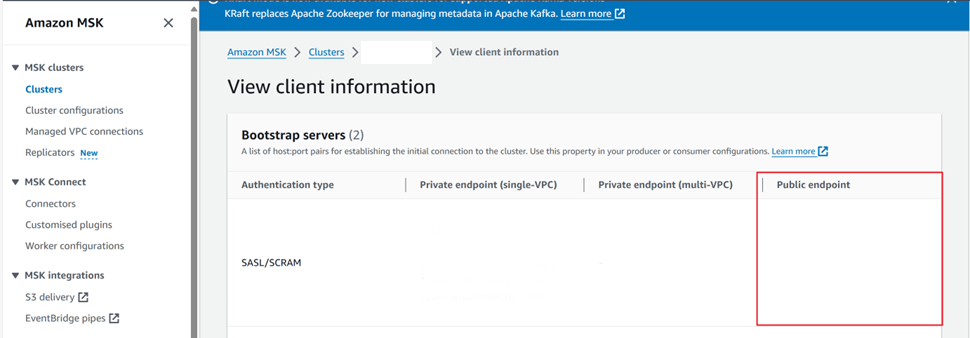

Na seção Configurações de conexão, em Servidor Bootstrap, insira o ponto de extremidade público do cluster do Kafka.

Para obter o ponto de extremidade público:

Na seção Credenciais de conexão, se você tiver uma conexão existente com o cluster do Amazon MSK Kafka, selecione-a na lista suspensa para Conexão. Caso contrário, siga estas etapas:

- Em Nome da conexão, insira um nome para a conexão.

- Em Tipo de autenticação, confirme se a Chave de API está selecionada.

- Em Cluster e Segredo, insira a chave de API e o segredo da chave para o cluster do Amazon MSK Kafka.

Selecione Conectar.

Agora, na página Conectar, siga estas etapas.

Em Tópico, insira o tópico Kafka.

Em Grupo de consumidores, insira o grupo de consumidores do cluster do Kafka. Esse campo fornece um grupo de consumidores dedicado para obter eventos.

Selecione Redefinir deslocamento automático para especificar onde começar a ler os deslocamentos, se não houver confirmação.

Em Protocolo de segurança, o valor padrão é SASL_SSL. O mecanismo SASL padrão é SCRAM-SHA-512 e não pode ser alterado.

Selecione Avançar. Na tela Examinar e conectar, examine o resumo e selecione Conectar.

Exibir o Eventstream atualizado

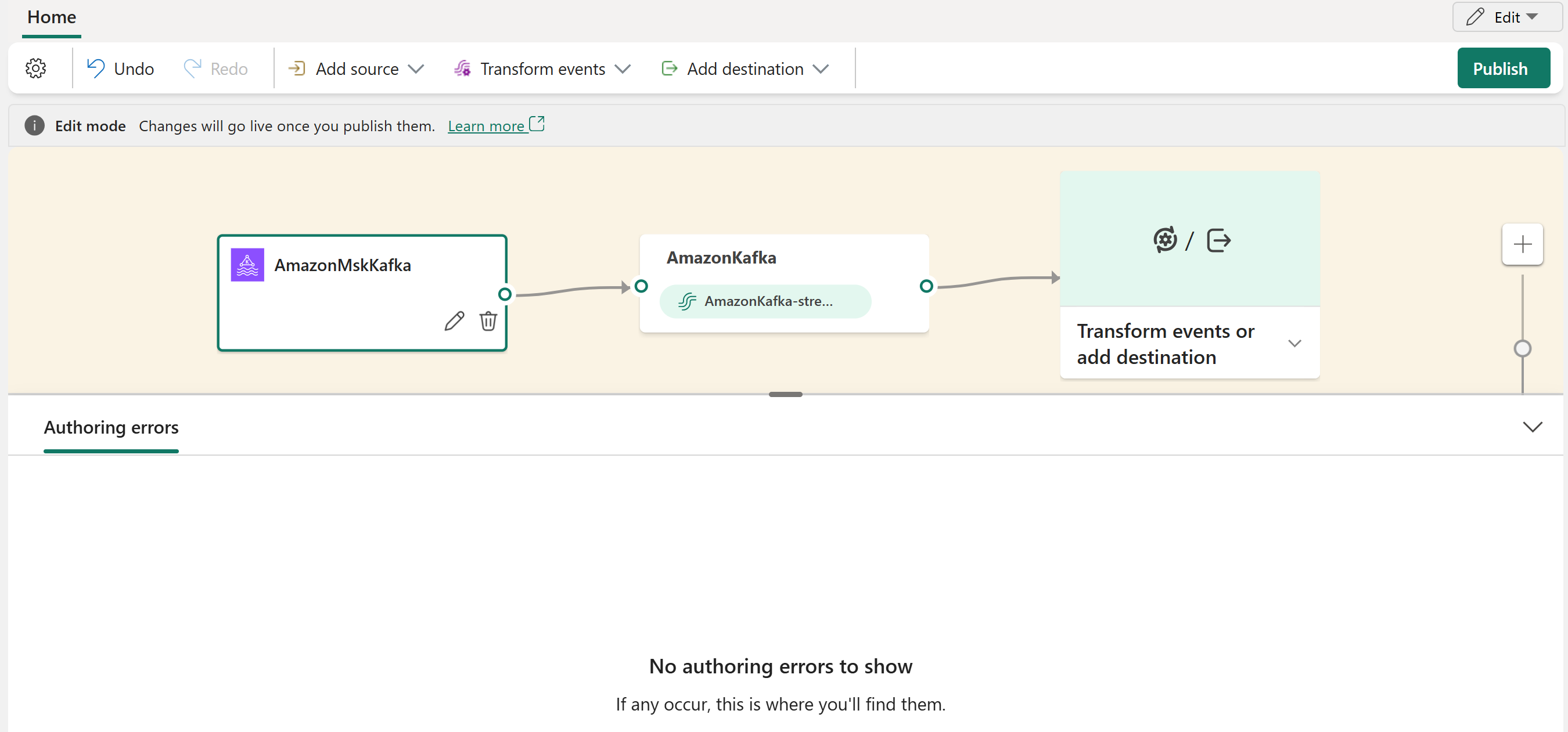

Você pode ver a origem do Amazon MSK Kafka adicionada ao Eventstream no modo Editar.

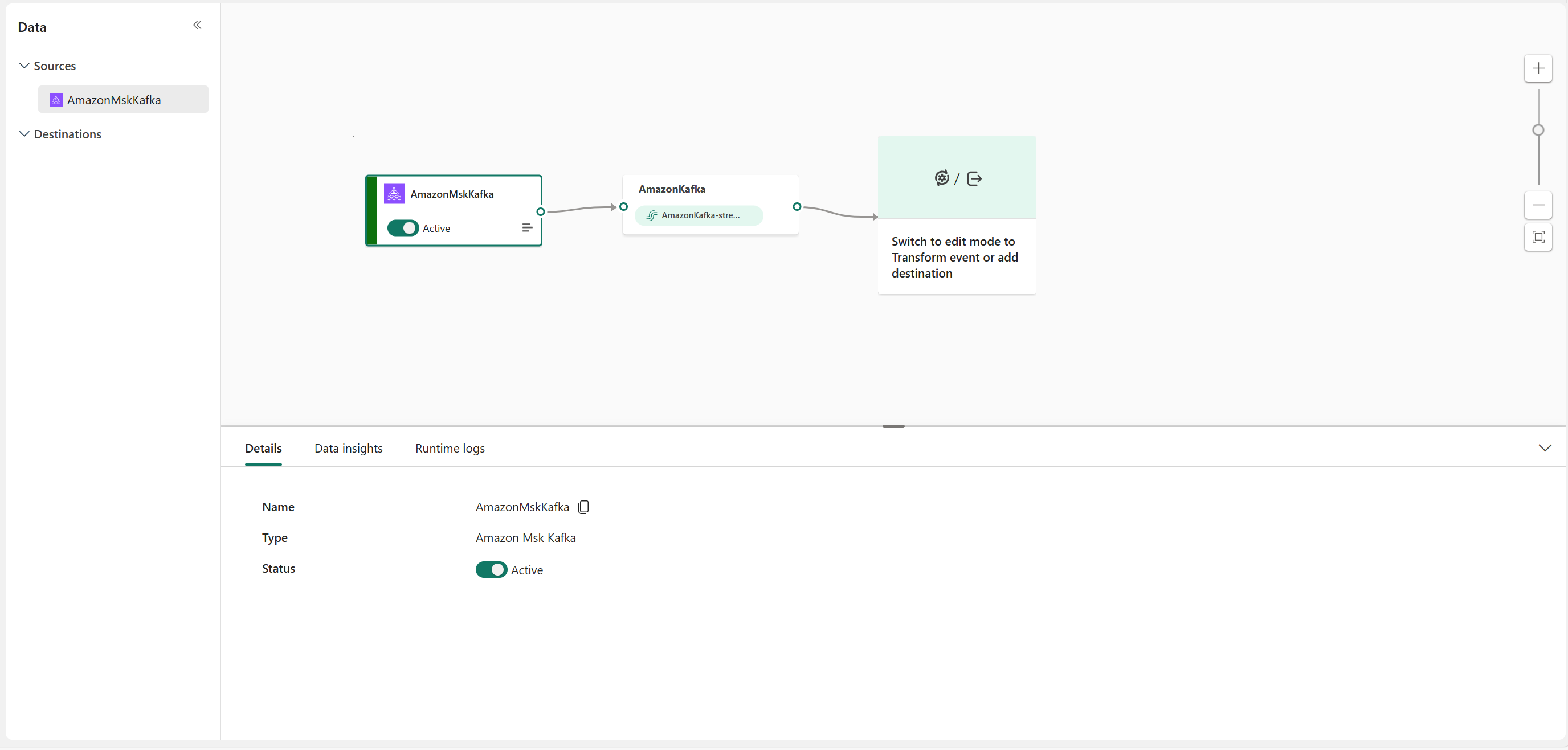

Depois de concluir essas etapas, a origem do Amazon MSK Kafka estará disponível para visualização no Modo de exibição ao vivo.

Conteúdo relacionado

Outros conectores:

- Amazon Kinesis Data Streams

- Azure Cosmos DB

- Hubs de eventos do Azure

- Hub IoT do Azure

- Captura de dados de alterações (CDA) com o Banco de Dados SQL do Azure

- Ponto de extremidade personalizado

- Pub/Sub do Google Cloud

- CDA do Banco de Dados MySQL

- CDA do Banco de dados PostgreSQL

- Dados de amostra

- Eventos de Armazenamento de Blobs do Azure

- Evento de espaço de trabalho do Fabric