Opções para obter dados no Fabric Lakehouse

A experiência de obtenção de dados abrange todos os cenários do usuário para trazer dados para o lakehouse, como:

- Conectar-se a um SQL Server existente e copiar dados para a tabela Delta no lakehouse.

- Carregar arquivos do computador.

- Copiar e mesclar várias tabelas de outros lakehouses em uma nova tabela Delta.

- Conectar-se a uma fonte de streaming para obter dados em um lakehouse.

- Referenciar dados sem copiá-los de outros lakehouses internas ou fontes externas.

Diferentes maneiras de carregar dados em um lakehouse

No Microsoft Fabric, há algumas maneiras de obter dados em um lakehouse:

- Upload de arquivo do computador local

- Executar uma ferramenta de cópia em pipelines

- Configurar um fluxo de dados

- Bibliotecas do Apache Spark no código do notebook

- Transmitir eventos em tempo real com o Eventstream

- Obter dados do Eventhouse

Upload de arquivo local

Você também pode carregar dados armazenados em seu computador local. Você pode fazer isso diretamente no Lakehouse Explorer.

Copiar ferramenta em pipelines

A ferramenta Copiar é uma solução de Integração de Dados altamente escalonável que permite que você se conecte a diferentes fontes de dados e carregue os dados no formato original ou converta-os em uma tabela Delta. A ferramenta Copiar faz parte das atividades de pipelines que você pode modificar de várias maneiras, como agendamento ou gatilho com base em um evento. Para obter mais informações, consulte Como copiar dados usando a atividade de cópia.

Fluxos de dados

Para usuários familiarizados com fluxos de dados do Power BI, a mesma ferramenta está disponível para carregar dados em seu lakehouse. Você pode acessá-lo rapidamente na opção "Obter dados" do Lakehouse Explorer e obter dados de mais de 200 conectores. Para obter mais informações, consulte Início rápido: Crie seu primeiro fluxo de dados para obter e transformar dados.

Código do notebook

Você pode usar bibliotecas do Spark disponíveis para se conectar diretamente a uma fonte de dados, carregar dados em um quadro de dados e salvá-los em um lakehouse. Esse método é a maneira mais aberta de carregar dados no lakehouse que o código do usuário está gerenciando totalmente.

Observação

Tabelas Delta externas criadas com código Spark não ficarão visíveis para o ponto de extremidade de análise do SQL. Use atalhos no Espaço de tabela para tornar as tabelas Delta externas visíveis para o ponto de extremidade de análise do SQL. Para saber como criar um atalho, consulte Criar um atalho para arquivos ou tabelas.

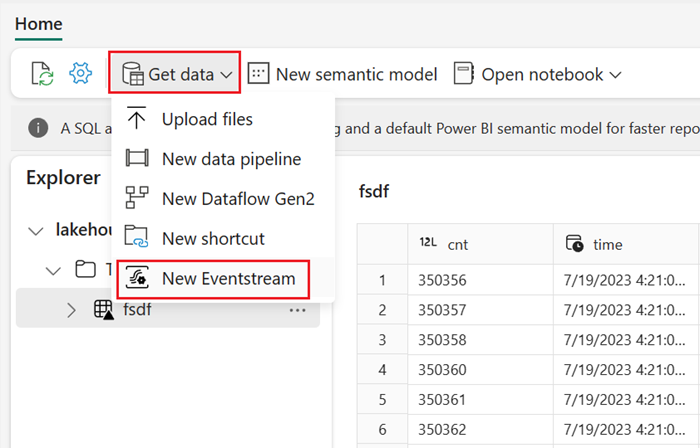

Transmitir eventos em tempo real com o Eventstream

Com o Eventstream, você poderá obter, processar e rotear eventos em tempo real de grandes volumes de uma ampla variedade de fontes.

Para visualizar como adicionar lakehouse como um destino para o Eventstream, consulte Obter dados do Eventstream em um lakehouse.

Para obter um desempenho de streaming ideal transmita dados do Eventstream para um Eventhouse e habilite a disponibilidade do OneLake.

Obter dados do Eventhouse

Ao habilitar a disponibilidade do OneLake em dados em um Eventhouse, uma tabela Delta é criada no OneLake. Esta tabela Delta pode ser acessada por um lakehouse usando um atalho. Para obter mais informações, consulte Atalhos do teclado. Para obter mais informações, consulte Disponibilidade de Eventhouse do OneLake.

Considerações ao escolher a abordagem para carregar dados

| Caso de uso | Recomendação |

|---|---|

| Carregamento de arquivo pequeno do computador local | Usar carregamento de arquivo local |

| Dados pequenos ou conector específico | Usar Fluxos de dados |

| Fonte de dados grande | Usar a ferramenta Copiar em pipelines |

| Transformações de dados complexos | Usar código do Notebook |

| Dados de streaming | Usar o Eventstream para transmitir dados ao Eventhouse, habilitar a disponibilidade do OneLake e criar um atalho do Lakehouse |

| Dados de série temporal | Obter dados do Eventhouse |

Conteúdo relacionado

- Explorar os dados em seu lakehouse com um notebook

- Início Rápido: como criar seu primeiro pipeline para copiar dados

- Como copiar dados usando a atividade de cópia

- Migrar dados do BD do SQL do Azure para o Lakehouse por meio do assistente de cópia

- Adicionar um destino do lakehouse ao Eventstream

- Disponibilidade do Eventhouse OneLake