Adicionar um destino do lakehouse ao Eventstream

Este artigo mostra como adicionar um lakehouse como destino a um Eventstream nos fluxos de eventos do Microsoft Fabric. Para desempenho otimizado de streaming e consultas em tempo real, considere transmitir dados para um Eventhouse com Adicionar destino Eventhouse a um Eventstream e, em seguida, habilitar Disponibilidade do Eventhouse OneLake.

Observação

Agora, os recursos aprimorados estão habilitados por padrão ao criar os Eventstreams. Caso tenha os Eventstreams que foram criados usando recursos padrão, esses Eventstreams continuarão a funcionar. Você ainda pode editá-los e usá-los como de costume. Recomendamos que você crie um novo Eventstream para substituir os Eventstreams padrão para que você possa usufruir de recursos adicionais e benefícios de Eventstreams aprimorados.

Importante

Há uma imposição de esquema para gravar dados em uma tabela de destino do lakehouse. Todas as novas gravações na tabela devem ser compatíveis com o esquema da tabela de destino no momento da gravação, garantindo a qualidade dos dados.

Ao gravar a saída em uma nova tabela delta, o esquema da tabela é criado com base no primeiro registro. Todos os registros dos dados de saída são projetados no esquema da tabela existente.

Se os dados recebidos tiverem colunas que não estejam no esquema da tabela existente, as colunas extras não serão incluídas nos dados gravados na tabela. Da mesma forma, se faltarem colunas nos dados recebidos que estão no esquema da tabela existente, as colunas ausentes gravam na tabela com os valores definidos como nulo.

Pré-requisitos

- Acesso a um espaço de trabalho no modo de licença de capacidade do Fabric (ou) no modo de licença de Avaliação com permissões de Colaborador ou superior.

- Acesso ao workspace onde o lakehouse está localizado com permissões de Colaborador ou superiores.

Observação

O número máximo de origens e destinos para um fluxo de eventos é 11.

Adicionar um lakehouse como destino

Para adicionar um destino do lakehouse a um Eventstream padrão ou derivado, siga as etapas a seguir.

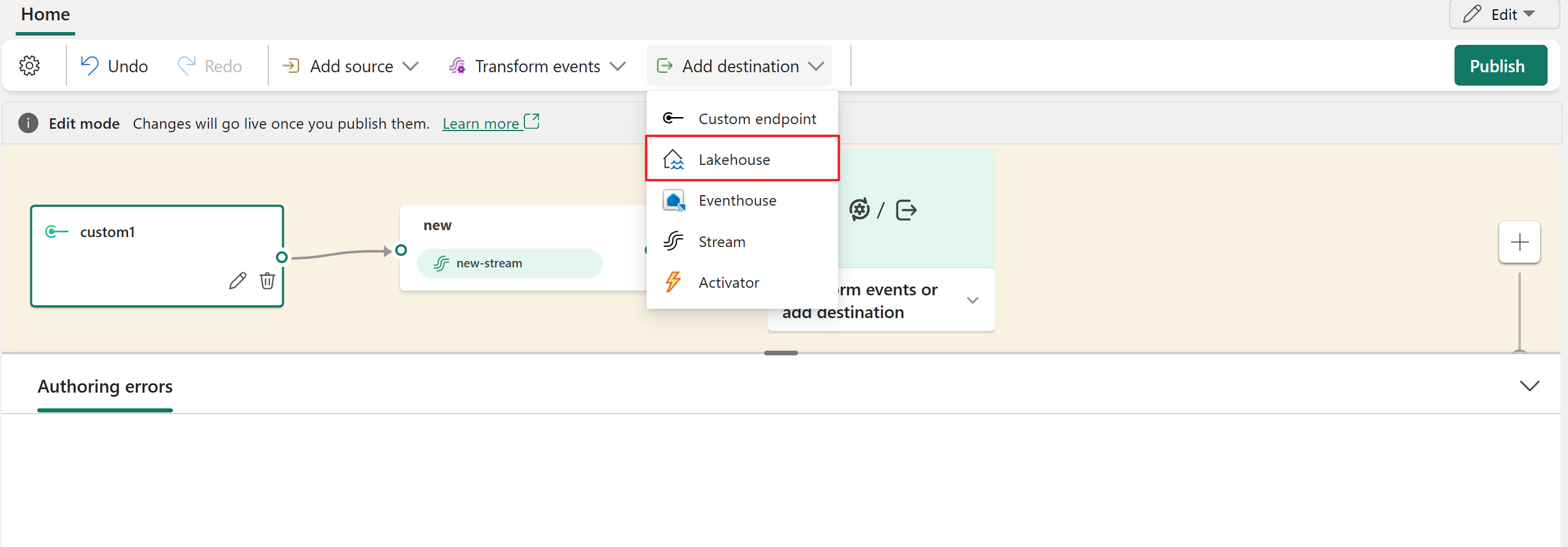

No Modo de edição do Eventstream, selecione Adicionar destino na faixa de opções e escolha Lakehouse na lista suspensa.

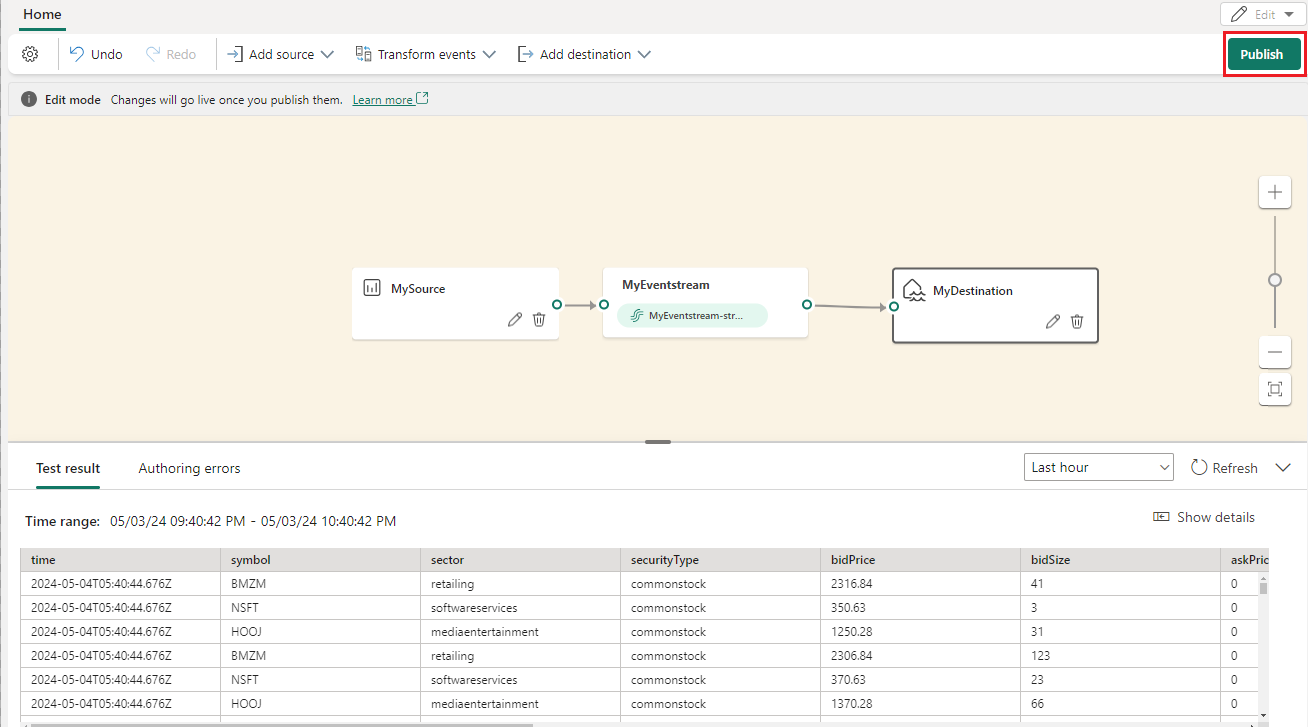

Conecte o Node do lakehouse ao Node ou operador do fluxo.

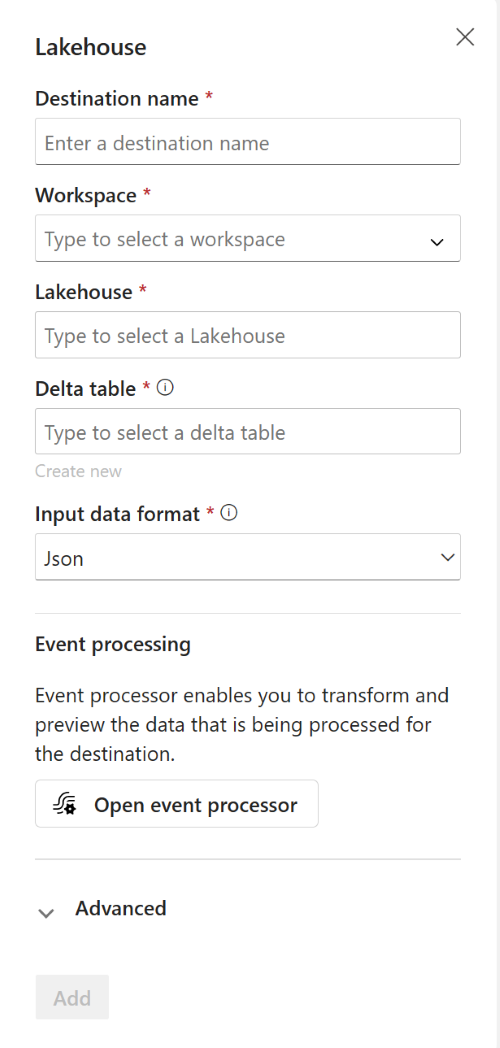

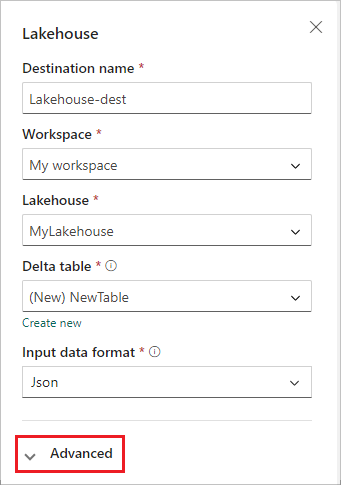

Na tela de configuração do Lakehouse, preencha as seguintes informações:

- Inserir um Nome de destino.

- Selecione o Espaço de trabalho que contém o lakehouse.

- Selecione um Lakehouse existente no espaço de trabalho especificado.

- Selecione uma Tabela delta existente ou crie uma para receber dados.

- Selecione o Formato de dados de entrada enviados ao lakehouse. Os formatos de dados com suporte são JSON, Avro e CSV (com cabeçalho).

Selecione Avançado.

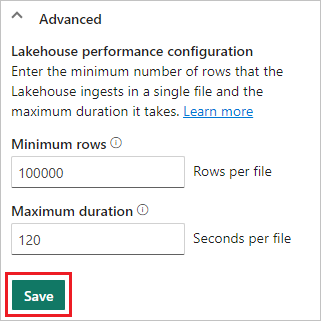

Dois modos de ingestão estão disponíveis para um destino de lakehouse. Com base no seu cenário, configure esses modos para otimizar como os fluxos de eventos do Fabric gravam no lakehouse.

Linhas mínimas é o número mínimo de linhas que o lakehouse ingere em um único arquivo. O mínimo é 1 linha e o máximo é 2 milhões de linhas por arquivo. Quanto menor o número mínimo de linhas, mais arquivos o lakehouse cria durante a ingestão.

Duração máxima é a duração máxima que o lakehouse leva para ingerir um único arquivo. O mínimo é de 1 minuto e o máximo é de 2 horas. Quanto maior a duração, mais linhas são ingeridas em um arquivo.

Selecione Salvar.

Para implementar o destino do lakehouse recém-adicionado, selecione Publicar.

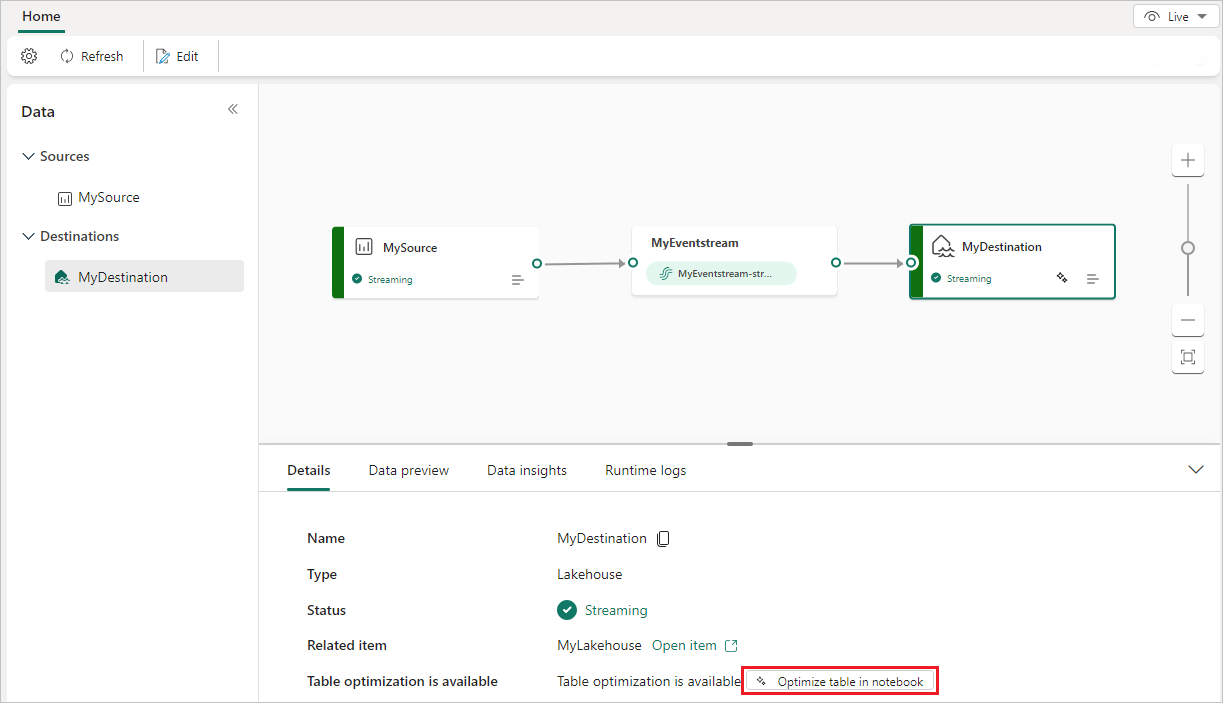

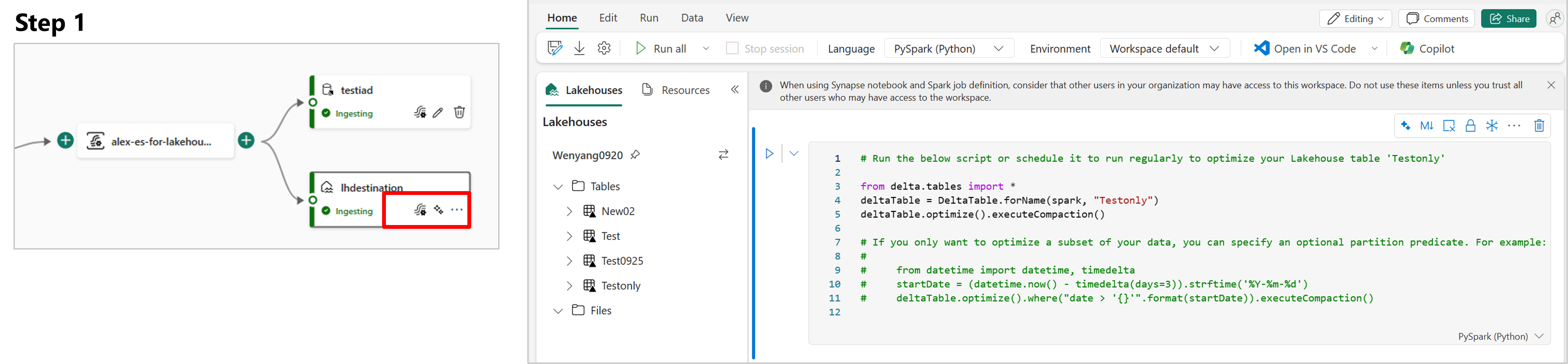

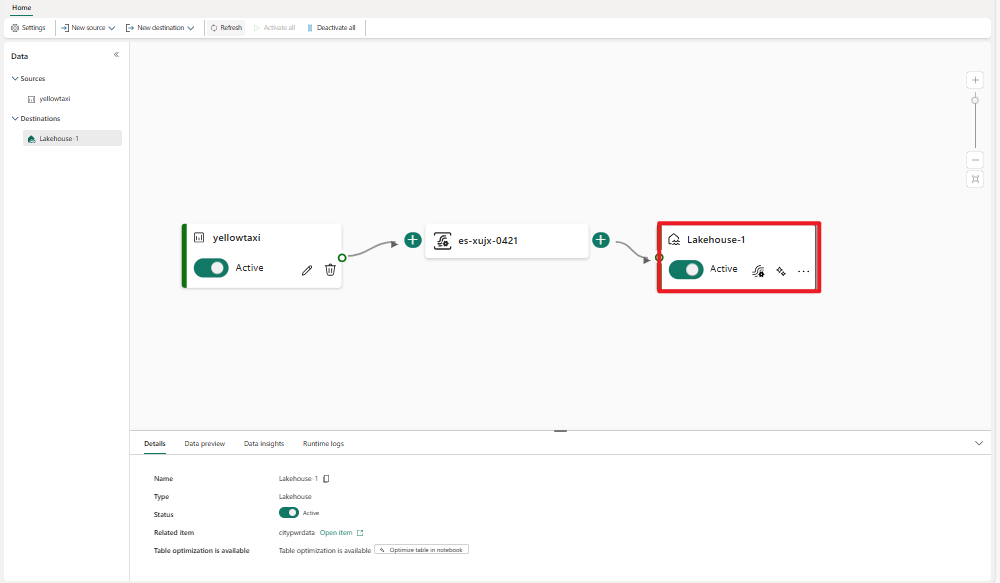

Depois de concluir essas etapas, o destino do lakehouse fica disponível para visualização na Exibição ao vivo. No painel Detalhes, você pode selecionar o atalho Otimizar tabela no notebook para iniciar um trabalho do Apache Spark em um notebook, que consolida os pequenos arquivos de streaming na tabela de destino do lakehouse.

Conteúdo relacionado

Para saber como adicionar outros destinos a um Eventstream, confira os seguintes artigos:

Pré-requisitos

Antes de começar, você deve concluir os seguintes pré-requisitos:

- Acesso a um espaço de trabalho no modo de licença de capacidade do Fabric (ou) no modo de licença de Avaliação com permissões de Colaborador ou superior.

- Obtenha acesso a um workspace com permissões de Colaborador ou superior no local em que seu lakehouse está localizado.

Observação

O número máximo de origens e destinos para um fluxo de eventos é 11.

Adicionar um lakehouse como destino

Se você tiver uma lakehouse criada em seu workspace, siga estas etapas para adicionar o lakehouse ao seu fluxo de eventos como destino:

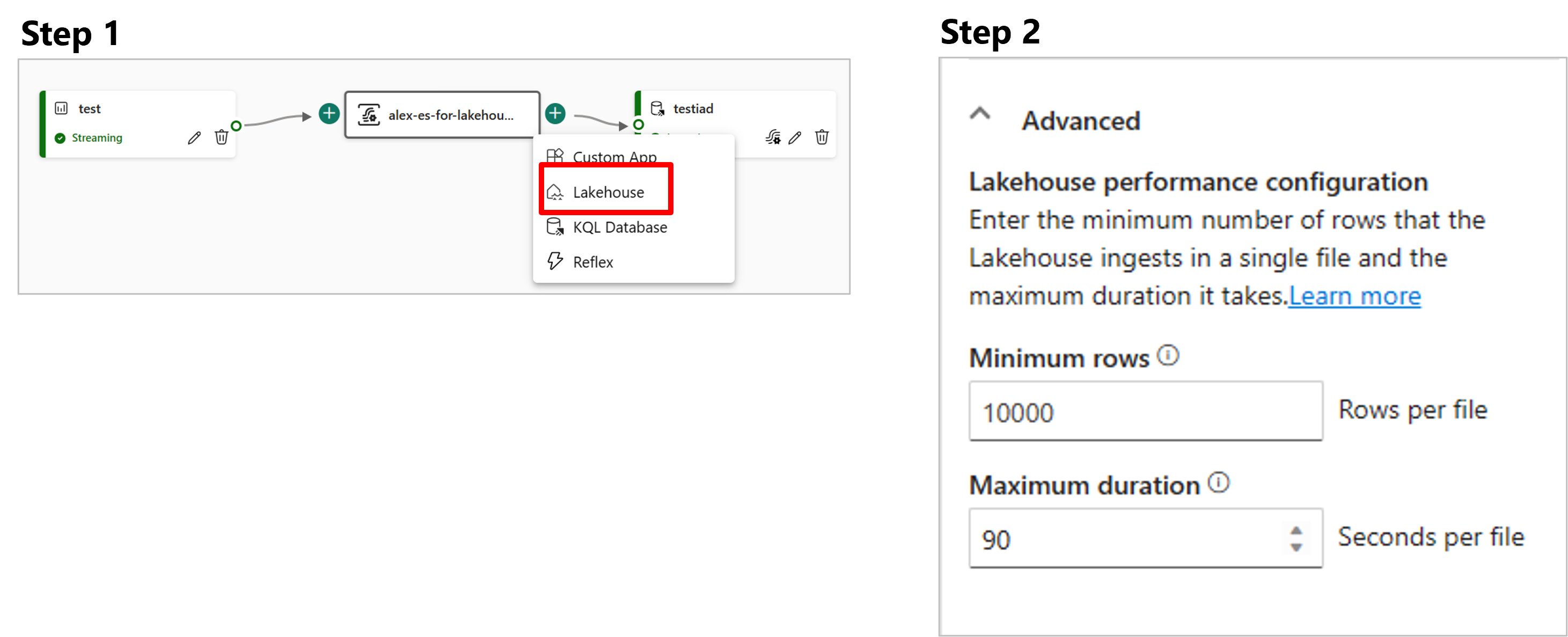

Selecione Novo destino na faixa de opções ou "+" na tela principal do editor e, em seguida, selecione Lakehouse. A tela de configuração de destino do Lakehouse é exibida.

Insira um nome para o destino do fluxo de eventos e preencha as informações sobre o lakehouse.

Lakehouse: selecione um lakehouse existente no workspace especificado.

Tabela delta: selecione uma tabela delta existente ou crie uma nova para receber dados.

Observação

Ao gravar dados na tabela lakehouse, há uma imposição de esquema. Isso significa que as novas gravações em uma tabela devem ser compatíveis com o esquema da tabela de destino no momento da gravação, garantindo a qualidade dos dados.

Todos os registros dos dados de saída são projetados no esquema da tabela existente. Ao gravar a saída em uma nova tabela delta, o esquema da tabela é criado com base no primeiro registro. Se os dados de entrada tiverem uma coluna adicional em comparação com o esquema da tabela existente, eles gravam na tabela sem incluir a coluna extra. Por outro lado, se os dados de entrada não tiverem uma coluna em comparação com o esquema de tabela existente, ele grava na tabela com o valor da coluna definido como nulo.

Formato dos dados de entrada: selecione o formato para os dados (dados de entrada) enviados para o lakehouse.

Observação

Os formatos de dados de eventos de entrada com suporte são JSON, Avro e CSV (com cabeçalho).

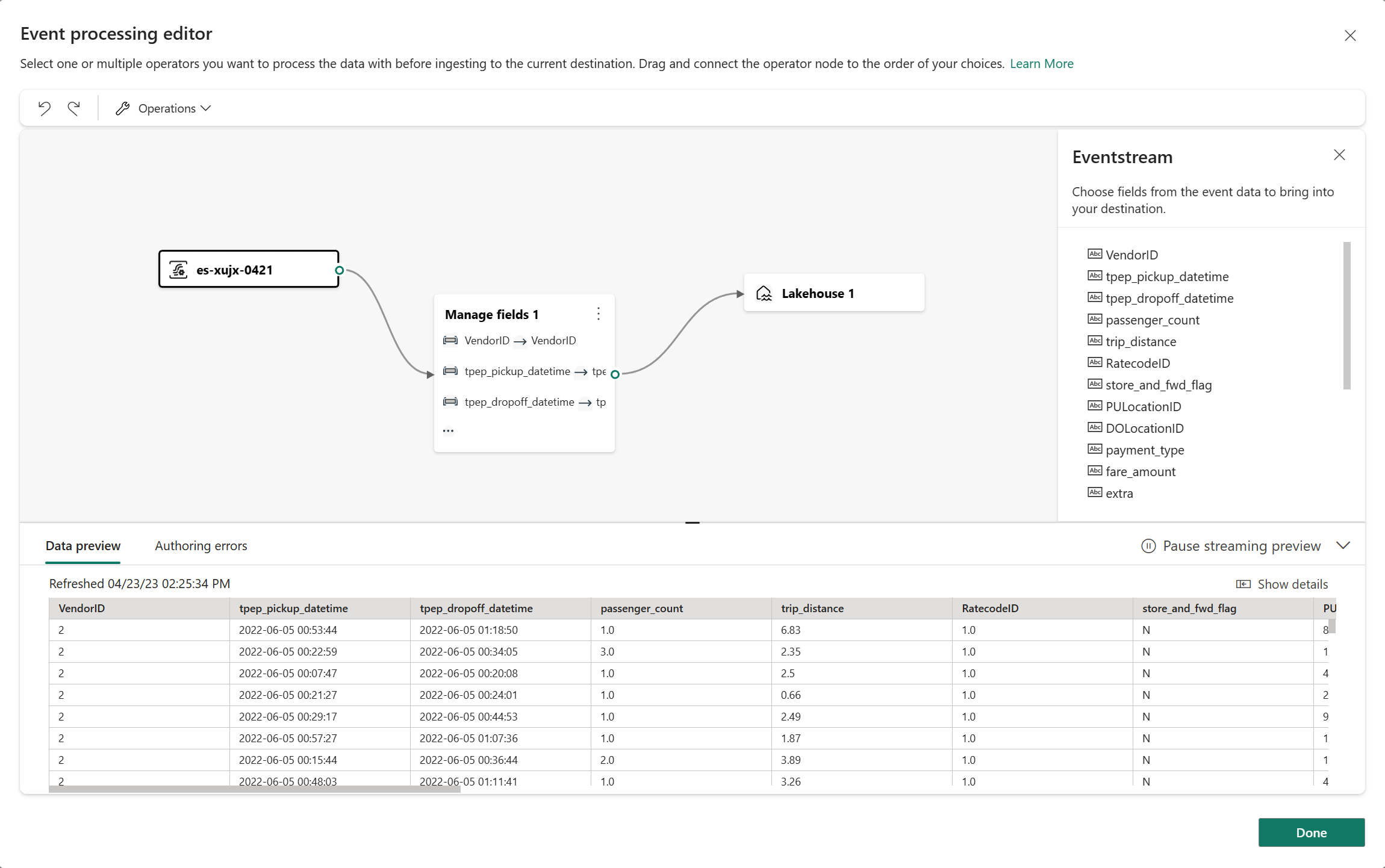

Processamento de eventos: você pode usar o editor de processamento de eventos para especificar como os dados devem ser processados antes de serem enviados ao lakehouse. Selecione Abrir processador de eventos para abrir o editor de processamento de eventos. Para saber mais sobre o processamento em tempo real usando o processador de eventos, consulte Processar dados de eventos com o editor de processador de eventos. Quando terminar de usar o editor, selecione Concluído para retornar à tela de configuração de destino do Lakehouse .

Dois modos de ingestão estão disponíveis para um destino de lakehouse. Selecione um desses modos para otimizar como o recurso de fluxos de eventos do Fabric é gravado no lakehouse com base em seu cenário.

Linhas por arquivo – o número mínimo de linhas que o Lakehouse ingere em um único arquivo. Quanto menor o número mínimo de linhas, mais arquivos o Lakehouse criará durante a ingestão. O mínimo é de 1 linha. O máximo é de 2 milhões de linhas por arquivo.

Duração – a duração máxima que o Lakehouse levaria para ingerir um único arquivo. Quanto maior a duração, mais linhas serão ingeridas em um arquivo. O mínimo é de 1 minuto e o máximo é de 2 horas.

Selecione Adicionar para adicionar o destino do lakehouse.

Atalho de otimização de tabela disponível dentro do destino de lakehouse. Essa solução facilita a inicialização de um trabalho do Spark em um Notebook, que consolida esses pequenos arquivos de streaming dentro da tabela Lakehouse de destino.

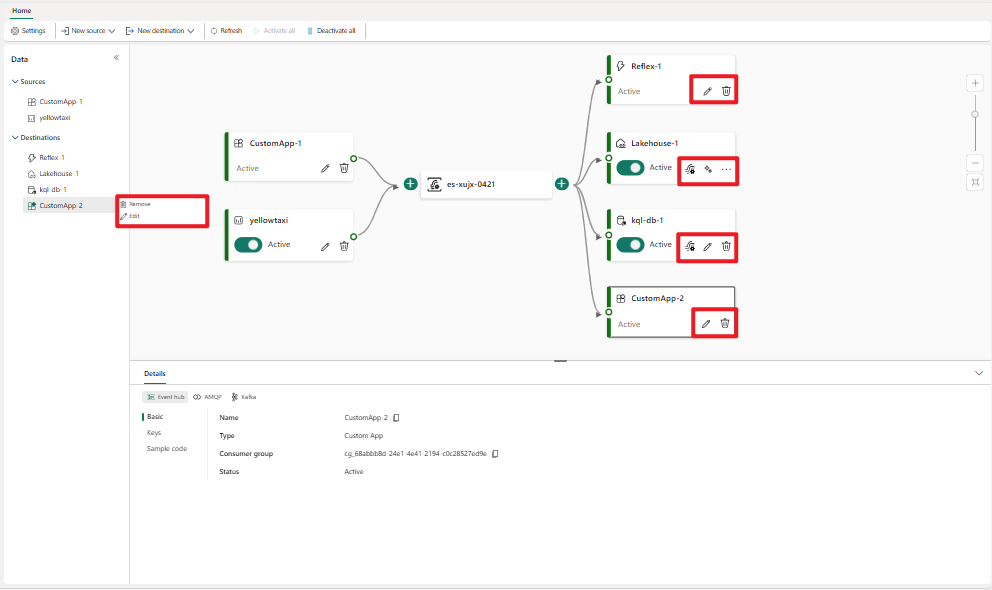

Um destino de lakehouse aparece na tela, com um indicador de status giratório. O sistema leva alguns minutos para alterar o status para Active.

Gerenciar um destino

Editar/remover: você pode editar ou remover um destino de fluxo de eventos por meio do painel de navegação ou da tela.

Ao selecionar Editar, o painel de edição é aberto à direita do editor principal. Você pode modificar a configuração como desejar, inclusive a lógica de transformação de eventos, por meio do editor do processador de eventos.

Conteúdo relacionado

Para saber como adicionar outros destinos a um Eventstream, confira os seguintes artigos: