Kompleksowe scenariusze nauki o danych: wprowadzenie i architektura

Ten zestaw samouczków przedstawia przykładowy scenariusz end-to-end w ramach doświadczenia nauki danych w Fabric. Każdy krok można zaimplementować od pozyskiwania, czyszczenia i przygotowywania danych do trenowania modeli uczenia maszynowego i generowania szczegółowych informacji, a następnie korzystać z tych szczegółowych informacji przy użyciu narzędzi do wizualizacji, takich jak usługa Power BI.

Jeśli dopiero zaczynasz korzystać z usługi Microsoft Fabric, zobacz Co to jest usługa Microsoft Fabric?.

Wprowadzenie

Cykl życia projektu nauki o danych zwykle obejmuje (często iteracyjne) następujące kroki:

- Zrozumienie biznesu

- Pozyskiwanie danych

- Eksploracja, czyszczenie, przygotowywanie i wizualizacja danych

- Trenowanie modelu i śledzenie eksperymentów

- Ocenianie modelu i generowanie szczegółowych informacji.

Cele i kryteria sukcesu każdego etapu zależą od współpracy, udostępniania danych i dokumentacji. Doświadczenie nauki o danych na platformie Fabric składa się z wielu funkcji opracowanych w sposób natywny, które umożliwiają współpracę, pozyskiwanie danych, udostępnianie i korzystanie z nich w sposób płynny.

W tych samouczkach pełnisz rolę analityka danych, który otrzymał zadanie eksplorowania, czyszczenia i przekształcania zestawu danych zawierającego stan zmian 10 000 klientów w banku. Następnie utworzysz model uczenia maszynowego, aby przewidzieć, którzy klienci bankowi prawdopodobnie odejdą.

Dowiesz się, jak wykonywać następujące działania:

- Notatniki Fabric służą do obsługi scenariuszy nauki o danych.

- Importuj dane do jeziorka danych Fabric, używając Apache Spark.

- Załaduj istniejące dane z tabel Delta w usłudze Lakehouse.

- Czyszczenie i przekształcanie danych przy użyciu narzędzi opartych na platformie Apache Spark i języku Python.

- Tworzenie eksperymentów i uruchomień w celu trenowania różnych modeli uczenia maszynowego.

- Rejestrować i śledzić wytrenowane modele przy użyciu MLflow i Fabric UI.

- Uruchamianie oceniania na dużą skalę i zapisywanie przewidywań i wyników wnioskowania w lakehouse.

- Wizualizowanie przewidywań w usłudze Power BI przy użyciu usługi DirectLake.

Architektura

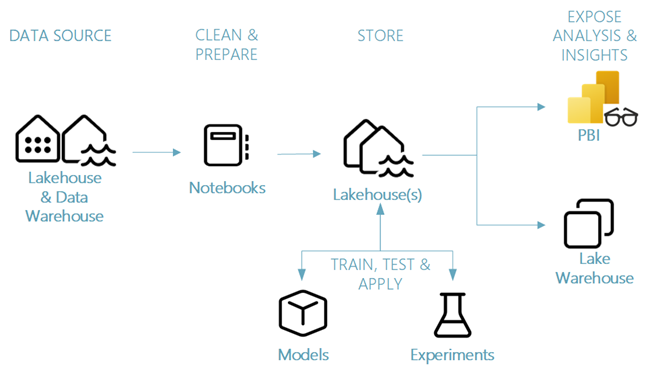

W tej serii samouczków prezentujemy uproszczony scenariusz nauki o danych, który obejmuje:

- pobieranie danych z zewnętrznego źródła danych.

- Badanie i oczyszczanie danych.

- Trenowanie i rejestrowanie modeli uczenia maszynowego.

- Wykonaj skoring wsadowy i zapisz prognozy.

- Wizualizacja wyników przewidywania w usłudze Power BI.

Różne składniki scenariusza nauki o danych

źródła danych — Fabric ułatwia oraz szybko łączy się z usługami Azure Data Services, innymi platformami chmurowymi i lokalnymi źródłami danych w celu pobierania z nich danych. Za pomocą notesów Fabric można pozyskiwać dane z wbudowanego Lakehouse, magazynu danych, modeli semantycznych oraz różnych niestandardowych źródeł danych obsługiwanych przez platformę Apache Spark i Python. Ta seria samouczków koncentruje się na pozyskiwaniu i wczytywaniu danych z architektury Lakehouse.

Eksplorowanie, czyszczenie i przygotowywanie — środowisko nauki o danych w usłudze Fabric obsługuje czyszczenie danych, przekształcanie, eksplorację i cechowanie przy użyciu wbudowanych środowisk na platformie Spark, a także narzędzi opartych na języku Python, takich jak Data Wrangler i Biblioteka SemPy. W tym samouczku przedstawiono eksplorację danych przy użyciu biblioteki języka Python seaborn oraz czyszczenia i przygotowywania danych przy użyciu platformy Apache Spark.

Modele i eksperymenty — Fabric umożliwia trenowanie, ocenianie i ocenę modeli uczenia maszynowego przy użyciu wbudowanych elementów eksperymentów i modeli z bezproblemową integracją z MLflow na potrzeby śledzenia eksperymentów i rejestracji/wdrażania modelu. Platforma udostępnia również funkcje prognozowania za pomocą modeli na dużą skalę (PREDICT) w celu uzyskania i udostępniania wglądów biznesowych.

Storage — Fabric standaryzuje na Delta Lake, co oznacza, że wszystkie silniki Fabric mogą wchodzić w interakcję z tym samym zestawem danych przechowywanym w lakehouse. Ta warstwa magazynu umożliwia przechowywanie zarówno danych ze strukturą, jak i bez struktury, które obsługują zarówno magazyn oparty na plikach, jak i format tabelaryczny. Dostęp do zestawów danych i plików przechowywanych można łatwo uzyskać za pośrednictwem wszystkich elementów środowiska usługi Fabric, takich jak notesy i potoki.

Prezentuj analizę i wnioski — dane z Lakehouse mogą być używane przez Power BI, wiodące w branży narzędzie do analizy biznesowej w celach raportowania i wizualizacji. Dane przechowywane w lakehouse można również wizualizować w notatnikach przy użyciu natywnych bibliotek wizualizacji Spark lub Python, takich jak matplotlib, seaborn, plotlyi nie tylko. Dane można również wizualizować przy użyciu biblioteki SemPy, która obsługuje wbudowane, szczegółowe wizualizacje dla semantycznego modelu danych, zależności i ich naruszeń oraz przypadków użycia klasyfikacji i regresji.