Kompleksowe scenariusze usługi Data Factory: wprowadzenie i architektura

Ten samouczek pomaga przyspieszyć proces oceny usługi Data Factory w usłudze Microsoft Fabric, zapewniając szczegółowe wskazówki dotyczące scenariusza pełnej integracji danych w ciągu jednej godziny. Po ukończeniu tego samouczka poznasz wartości i kluczowe możliwości usługi Data Factory oraz dowiesz się, jak ukończyć typowy scenariusz integracji danych.

Omówienie: Dlaczego usługa Data Factory w usłudze Microsoft Fabric?

Ta sekcja pomaga ogólnie zrozumieć rolę sieci szkieletowej, a rola usługi Data Factory odgrywa w niej rolę.

Omówienie wartości usługi Microsoft Fabric

Usługa Microsoft Fabric zapewnia jednorazowy sklep dla wszystkich potrzeb analitycznych dla każdego przedsiębiorstwa. Obejmuje ona pełne spektrum usług, w tym przenoszenie danych, usług data lake, inżynierię danych, integrację danych i naukę o danych, analizę w czasie rzeczywistym i analizę biznesową. W przypadku sieci szkieletowej nie ma potrzeby łączenia różnych usług od wielu dostawców. Zamiast tego użytkownicy korzystają z kompleksowego, wysoce zintegrowanego, pojedynczego i kompleksowego produktu, który jest łatwy do zrozumienia, dołączania, tworzenia i obsługi.

Omówienie wartości usługi Data Factory w usłudze Microsoft Fabric

Usługa Data Factory w sieci szkieletowej łączy łatwość korzystania z dodatku Power Query z skalowaniem i mocą usługi Azure Data Factory. Łączy najlepsze z obu produktów w ujednolicone środowisko. Celem jest upewnienie się, że Integracja danych w fabryce działa dobrze zarówno dla deweloperów danych obywatelskich, jak i profesjonalnych. Zapewnia ona środowiska przygotowywania i przekształcania danych z małą ilością kodu z obsługą sztucznej inteligencji, transformację w skali petabajtów, setki łączników z łącznością hybrydową, wielochmurową. Usługa Purview zapewnia ład, a funkcje usługi obejmują zobowiązania dotyczące danych/operacji w skali przedsiębiorstwa, ciągłą integrację/ciągłe wdrażanie, zarządzanie cyklem życia aplikacji i monitorowanie.

Wprowadzenie — omówienie trzech kluczowych funkcji usługi Data Factory

- Pozyskiwanie danych: działanie Kopiuj w potokach umożliwia przenoszenie danych petabajtów ze setek źródeł danych do usługi Data Lakehouse w celu dalszego przetwarzania.

- Przekształcanie i przygotowywanie danych: Przepływ danych Gen2 udostępnia interfejs z małą ilością kodu do przekształcania danych przy użyciu przekształceń danych 300+ z możliwością załadowania przekształconych wyników do wielu miejsc docelowych, takich jak bazy danych Azure SQL Database, Lakehouse i inne.

- Kompleksowa automatyzacja przepływu integracji: potoki zapewniają aranżację działań, które obejmują działania kopiowania, przepływu danych i notesu oraz nie tylko. Dzięki temu można zarządzać wszystkimi działaniami w jednym miejscu. Działania w potoku można połączyć w łańcuch, aby działały sekwencyjnie lub działać niezależnie.

W tym przypadku użycia kompleksowej integracji danych nauczysz się:

- Jak pozyskiwać dane przy użyciu asystenta kopiowania w potoku

- Jak przekształcić dane przy użyciu przepływu danych bez użycia kodu lub napisać własny kod w celu przetworzenia danych za pomocą działania skryptu lub notesu

- Jak zautomatyzować cały całościowy przepływ integracji danych przy użyciu potoku z wyzwalaczami i elastycznymi działaniami przepływu sterowania.

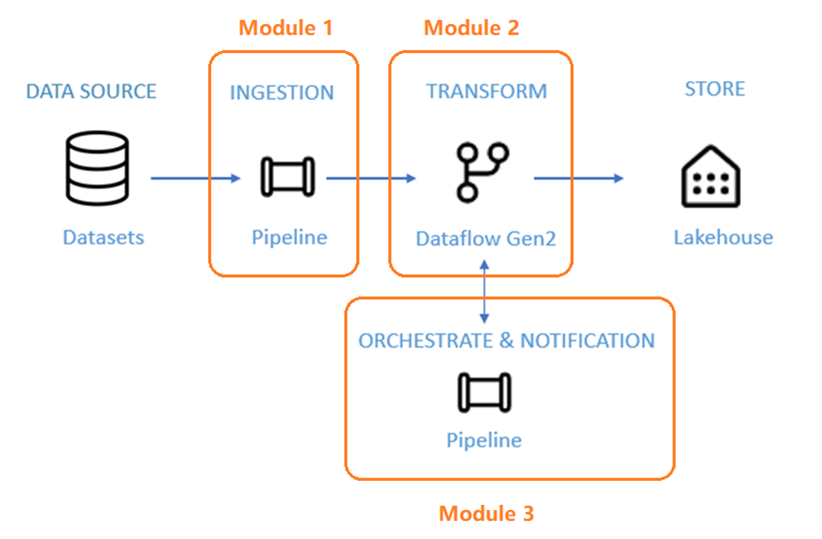

Architektura

W ciągu następnych 50 minut będziesz mieć zadanie ukończenia kompleksowego scenariusza integracji danych. Obejmuje to pozyskiwanie nieprzetworzonych danych z magazynu źródłowego do tabeli Bronze usługi Lakehouse, przetwarzanie wszystkich danych, przenoszenie ich do tabeli Gold usługi Data Lakehouse, wysyłanie wiadomości e-mail w celu powiadomienia o zakończeniu wszystkich zadań, a na koniec skonfigurowanie całego przepływu do uruchomienia zgodnie z harmonogramem.

Scenariusz jest podzielony na trzy moduły:

- Moduł 1. Tworzenie potoku za pomocą usługi Data Factory w celu pozyskiwania nieprzetworzonych danych z magazynu obiektów blob do tabeli z brązu w usłudze Data Lakehouse.

- Moduł 2. Przekształcanie danych za pomocą przepływu danych w usłudze Data Factory w celu przetworzenia danych pierwotnych z tabeli Bronze i przeniesienia ich do tabeli Gold w usłudze Data Lakehouse.

- Moduł 3. Ukończ pierwszą podróż integracji danych, aby wysłać wiadomość e-mail z powiadomieniem o zakończeniu wszystkich zadań, a na koniec skonfiguruj cały przepływ do uruchomienia zgodnie z harmonogramem.

Przykładowy zestaw danych NYC-Taxi jest używany jako źródło danych na potrzeby samouczka. Po zakończeniu będziesz w stanie uzyskać wgląd w dzienne rabaty dotyczące taryf taksówek przez określony okres czasu przy użyciu usługi Data Factory w usłudze Microsoft Fabric.

Powiązana zawartość

W tym wprowadzeniu do naszego kompleksowego samouczka dotyczącego pierwszej integracji danych przy użyciu usługi Data Factory w usłudze Microsoft Fabric przedstawiono następujące informacje:

- Wartość i rola usługi Microsoft Fabric

- Wartość i rola usługi Data Factory w sieci szkieletowej

- Najważniejsze funkcje usługi Data Factory

- Czego nauczysz się w tym samouczku

Przejdź teraz do następnej sekcji, aby utworzyć potok danych.