Moduł 1: Tworzenie potoku za pomocą usługi Data Factory

Czas działania tego modułu wynosi 10 minut, przetwarzając nieprzetworzone dane z magazynu źródłowego do tabeli Bronze w data Lakehouse przy użyciu działania kopiowania w potoku.

Ogólne kroki w module 1 są następujące:

- Tworzenie potoku danych.

- Użyj działania kopiowania w potoku, aby załadować przykładowe dane do usługi Data Lakehouse.

Tworzenie potoku danych

Wymagane jest konto dzierżawy usługi Microsoft Fabric z aktywną subskrypcją. Utwórz bezpłatne konto.

Upewnij się, że masz obszar roboczy z włączoną usługą Microsoft Fabric: Utwórz obszar roboczy.

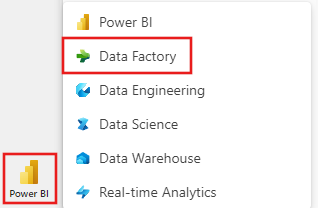

Zaloguj się do usługi Power BI.

Wybierz domyślną ikonę usługi Power BI w lewym dolnym rogu ekranu, a następnie wybierz pozycję Fabric.

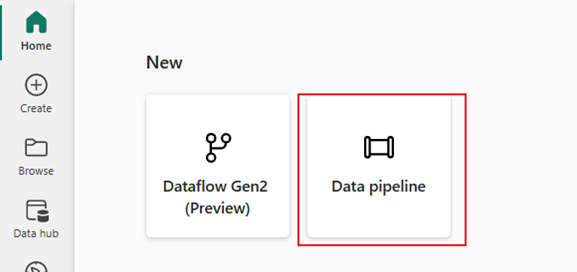

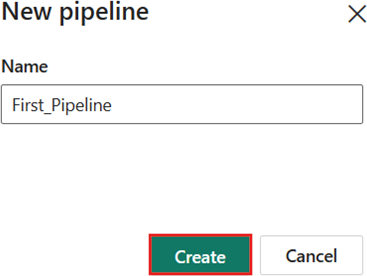

Wybierz obszar roboczy na karcie Obszary robocze , a następnie wybierz pozycję + Nowy elementi wybierz pozycję Potok danych. Podaj nazwę rury. Następnie wybierz pozycję Utwórz.

Ładowanie przykładowych danych do usługi Data Lakehouse za pomocą działania kopiowania w potoku

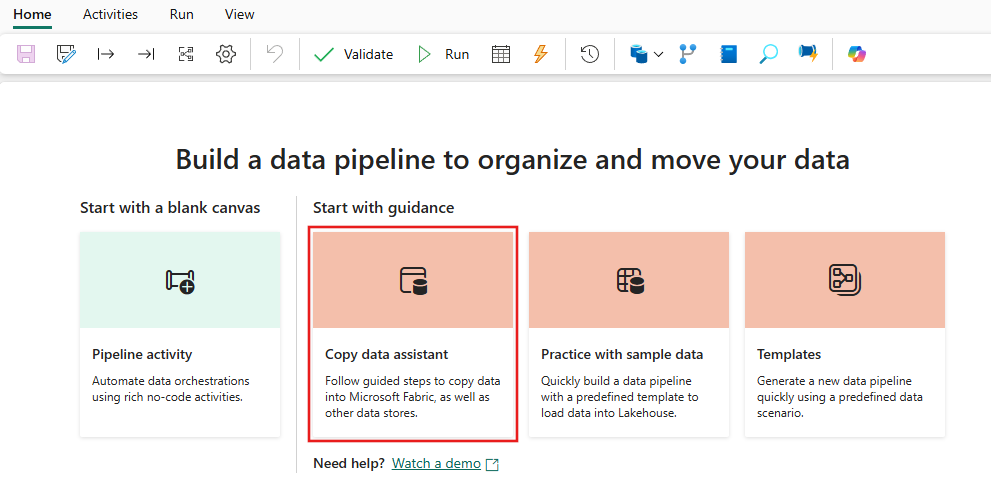

Krok 1. Konfigurowanie działania kopiowania za pomocą asystenta kopiowania.

Wybierz Asystent kopiowania danych, aby otworzyć narzędzie asystenta kopiowania.

Krok 2. Konfigurowanie ustawień w asystencie kopiowania.

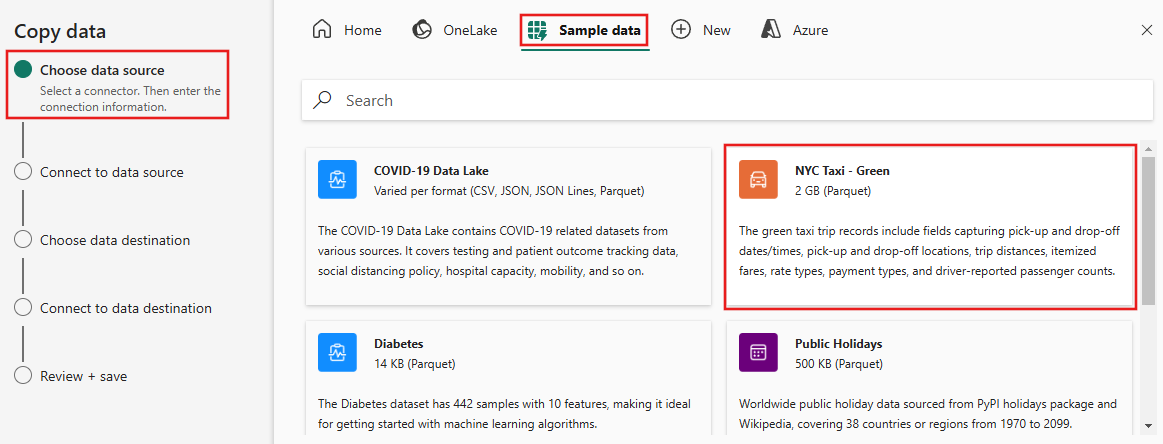

Okno dialogowe kopiowania danych jest wyświetlane z wyróżnionym pierwszym krokiem, Wybierz źródło danych. Wybierz Przykładowe dane z opcji w górnej części okna dialogowego, a następnie wybierz NYC Taxi - Green.

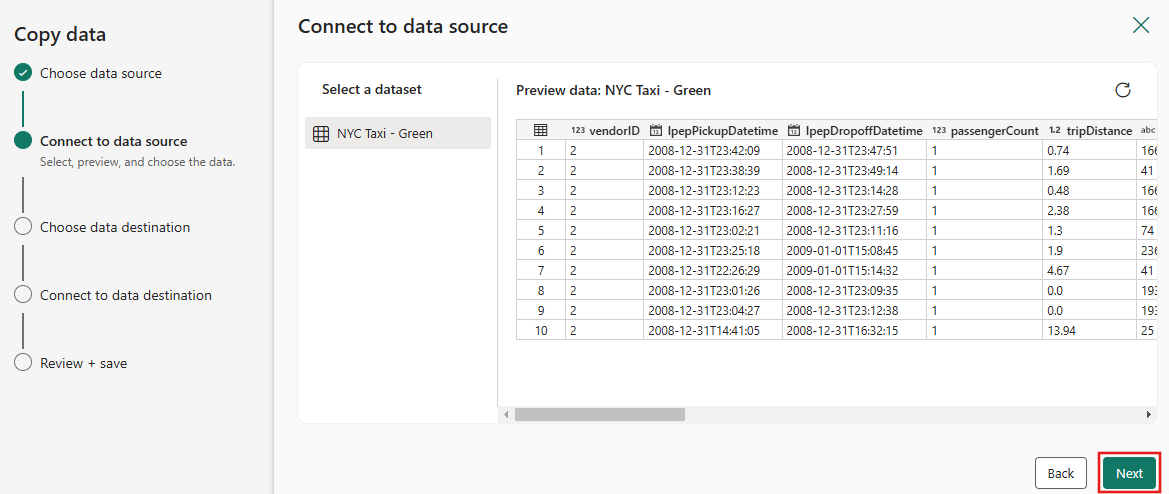

Podgląd źródła danych pojawi się następnie na stronie Połącz ze źródłem danych. Przejrzyj, a następnie wybierz Dalej.

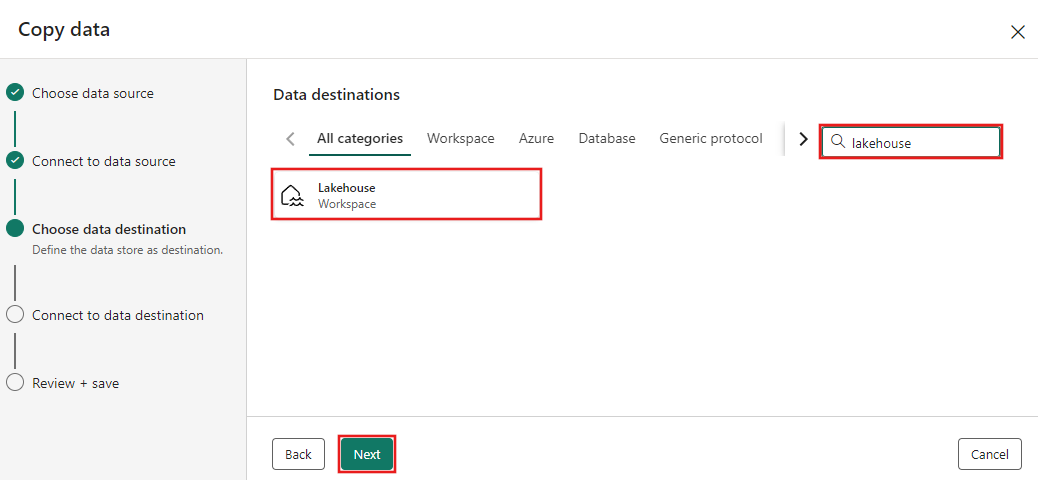

W Wybierz miejsce docelowe danych kroku asystenta kopiowania wybierz pozycję Lakehouse, a następnie Dalej.

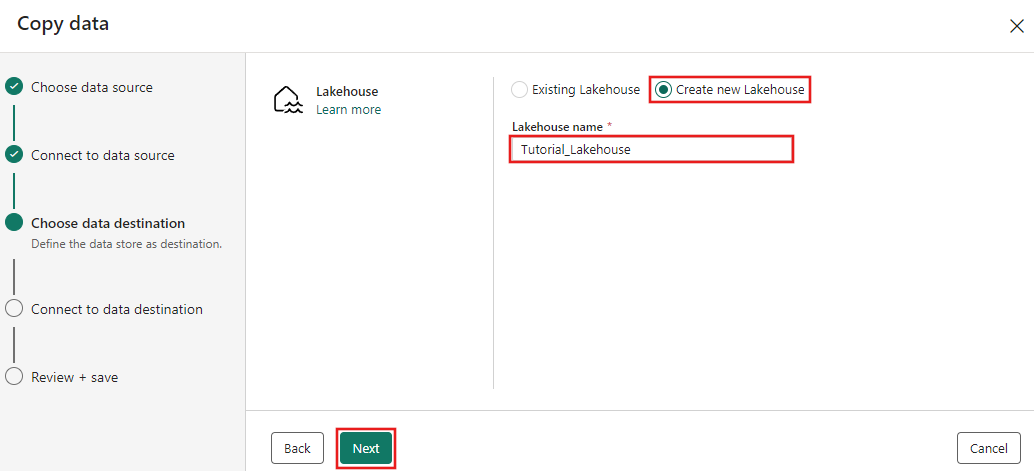

Wybierz pozycję Utwórz nową usługę Lakehouse na wyświetlonej stronie konfiguracji miejsca docelowego danych i wprowadź nazwę nowej usługi Lakehouse. Następnie ponownie wybierz pozycję Dalej.

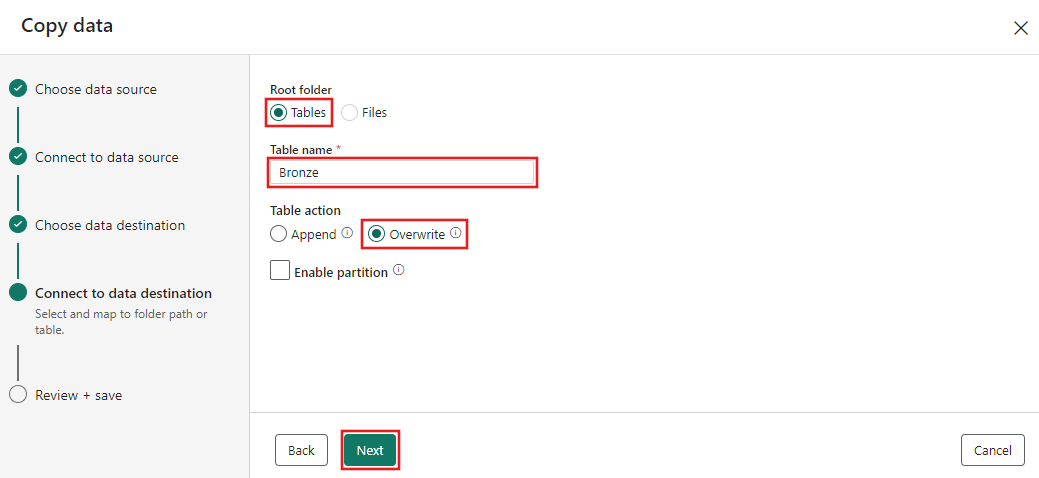

Skonfiguruj teraz szczegóły dotyczące miejsca docelowego Lakehouse na stronie Wybierz i zamapuj na ścieżkę folderu lub tabeli.. Wybierz Tabele dla folderu głównego , podaj nazwę tabeli, a następnie wybierz opcję Zastąp. Nie zaznaczaj pola wyboru Włącz partycję, które jest wyświetlane po wybraniu akcji Zastąp tabelę.

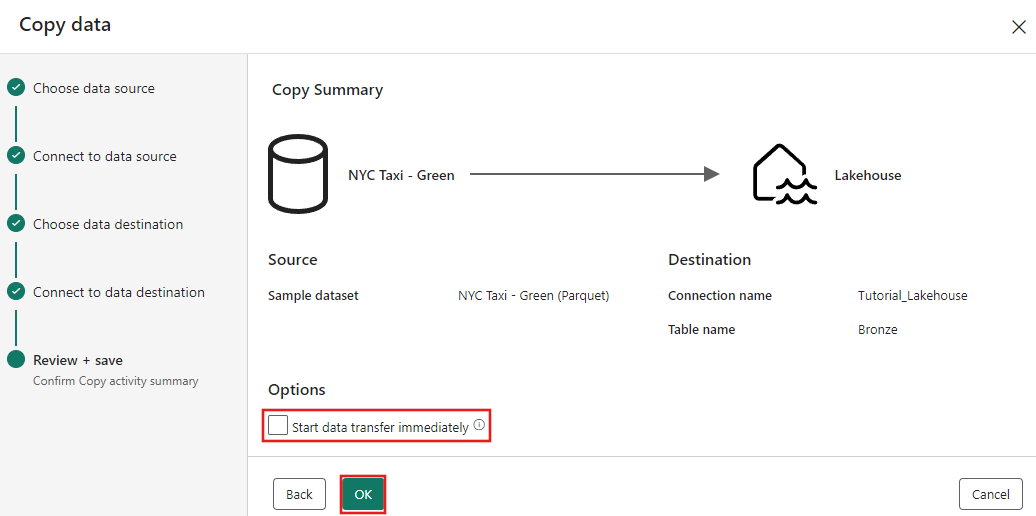

Na koniec na stronie Sprawdź i zapisz asystenta kopiowania danych przejrzyj konfigurację. Na potrzeby tego samouczka usuń zaznaczenie pola wyboru Rozpocznij transfer danych natychmiast, ponieważ uruchamiamy działanie ręcznie w następnym kroku. Następnie wybierz pozycję OK.

Krok 3. Uruchamianie i wyświetlanie wyników działania kopiowania.

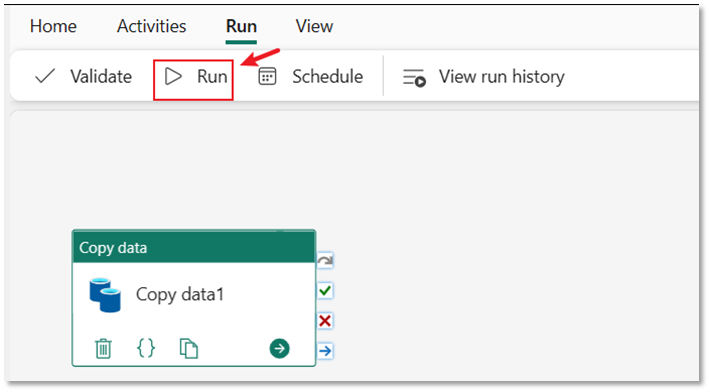

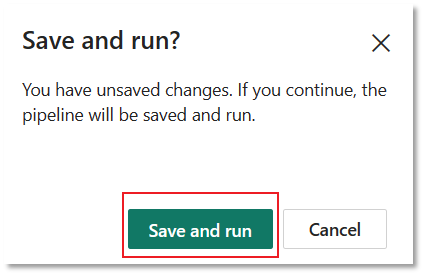

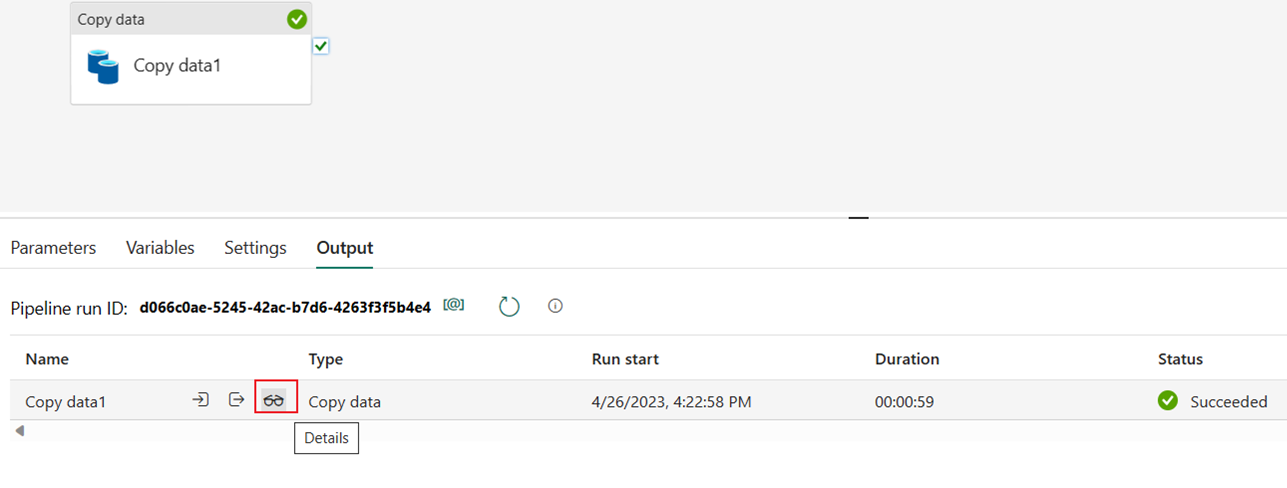

Wybierz kartę Uruchom w edytorze pipeline. Następnie wybierz przycisk Uruchom, a następnie, gdy pojawi się monit, wybierz Zapisz i uruchom, aby uruchomić działanie Kopiowania.

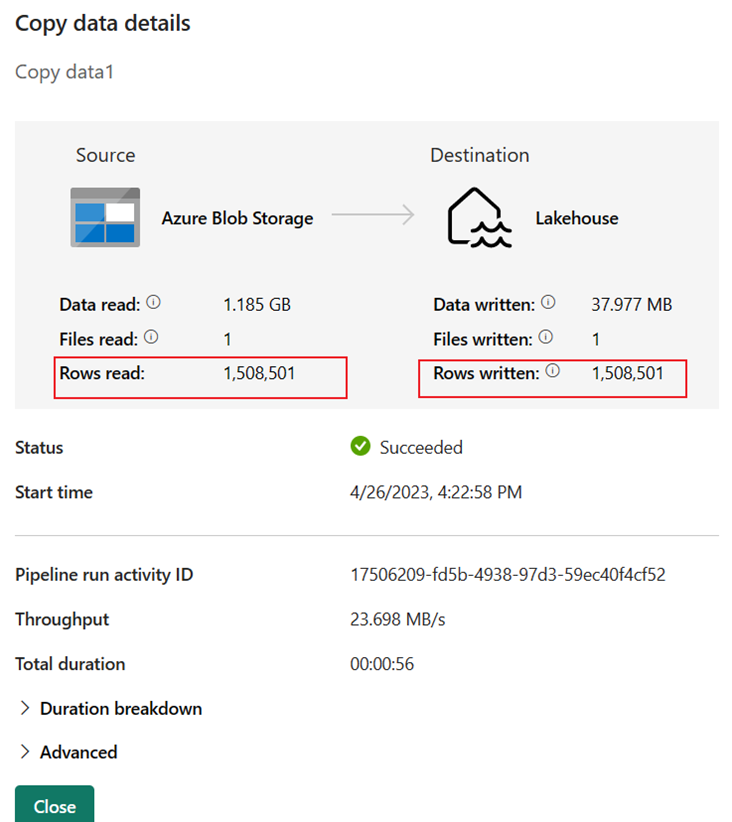

Możesz monitorować przebieg i sprawdzać wyniki na karcie Dane wyjściowe poniżej kanwy potoku. Wybierz ikonę szczegółów przebiegu (ikona "okularów", która pojawia się po najechaniu kursorem na przebieg potoku), aby wyświetlić szczegóły przebiegu.

Szczegóły przebiegu pokazują 1 508 501 wierszy odczytanych i zapisanych.

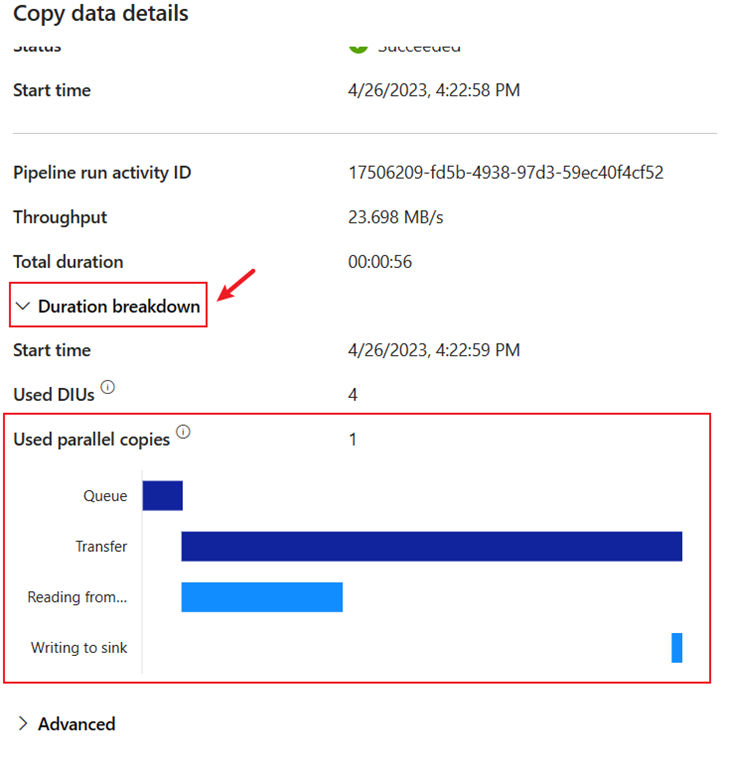

Rozwiń sekcję Podział czasu trwania, aby zobaczyć czas trwania każdego etapu aktywności kopiowania. Po przejrzeniu szczegółów kopii wybierz pozycję Zamknij.

Powiązana zawartość

W tym pierwszym module do naszego kompleksowego samouczka dotyczącego pierwszej integracji danych przy użyciu usługi Data Factory w usłudze Microsoft Fabric przedstawiono sposób wykonywania następujących czynności:

- Tworzenie potoku danych.

- Dodaj zadanie kopiowania do przepływu.

- Użyj przykładowych danych i utwórz usługę Data Lakehouse, aby przechowywać dane w nowej tabeli.

- Uruchom potok i wyświetl jego szczegóły i podział czasu trwania.

Przejdź teraz do następnej sekcji, aby utworzyć przepływ danych.