Krok 3. Curate an Evaluation Set from stakeholder feedback (Tworzenie zestawu oceny na podstawie opinii uczestników projektu)

przepływ pracy

Zobacz repozytorium GitHub, aby zapoznać się z przykładowym kodem w tej sekcji.

Oczekiwany czas: 10–60 minut. Czas różni się w zależności od jakości odpowiedzi dostarczonych przez uczestników projektu. Jeśli odpowiedzi są niechlujne lub zawierają wiele nieistotnych zapytań, musisz poświęcić więcej czasu na filtrowanie i czyszczenie danych.

Przegląd i oczekiwany wynik

Ten krok spowoduje uruchomienie zestawu ewaluacyjnego z opiniami dostarczonymi przez uczestników projektu przy użyciu aplikacji Przegląd. Należy pamiętać, że możesz uruchomić zestaw oceny z pytaniami, więc nawet jeśli uczestnicy projektu rozmawiali tylko z aplikacją, a nie przesyłali opinii, możesz wykonać ten krok.

Aby zapoznać się ze schematem zestawu oceny agenta, zobacz Schemat danych wejściowych oceny agenta. Do pól w tym schemacie odwołuje się pozostała część tej sekcji.

Na końcu tego kroku będziesz mieć zestaw oceny zawierający następujące elementy:

- Żądania z kciukiem w górę 👍:

-

request: zgodnie z wprowadzonym przez użytkownika. -

expected_response: Odpowiedź edytowana przez użytkownika. Jeśli użytkownik nie edytował odpowiedzi, odpowiedź wygenerowana przez model.

-

- Żądania z kciukiem w dół 👎:

-

request: zgodnie z wprowadzonym przez użytkownika. -

expected_response: Odpowiedź edytowana przez użytkownika. Jeśli użytkownik nie edytował odpowiedzi, odpowiedź ma wartość null.

-

- Żądania bez opinii (bez kciuka w górę 👍 lub kciuka w dół 👎)

-

request: zgodnie z wprowadzonym przez użytkownika.

-

W przypadku wszystkich żądań, jeśli użytkownik wybierze kciuk 👍 w górę dla fragmentu retrieved_contextz , element doc_uri tego fragmentu jest uwzględniony w expected_retrieved_context pytaniu.

Ważne

Usługa Databricks zaleca, aby zestaw oceny zawierał co najmniej 30 pytań, aby rozpocząć pracę. Przeczytaj dogłębną analizę zestawu ewaluacyjnego , aby dowiedzieć się więcej o tym, czym jest „dobry” zestaw ewaluacyjny.

Wymagania

- Uczestnicy projektu wykorzystali weryfikację koncepcji i przekazali opinię.

- Wszystkie wymagania z poprzednich kroków.

Instrukcje

- Otwórz notes 04_create_evaluation_set i kliknij pozycję Uruchom wszystko.

- Sprawdź zestaw oceny, aby zrozumieć uwzględnione dane. Należy sprawdzić, czy zestaw oceny zawiera reprezentatywny i trudny zestaw pytań. Dostosuj zestaw oceny zgodnie z potrzebami.

- Domyślnie zestaw danych oceny jest zapisywany w tabeli Delty skonfigurowanej w

EVALUATION_SET_FQNw notesie 00_global_config.

Następny krok

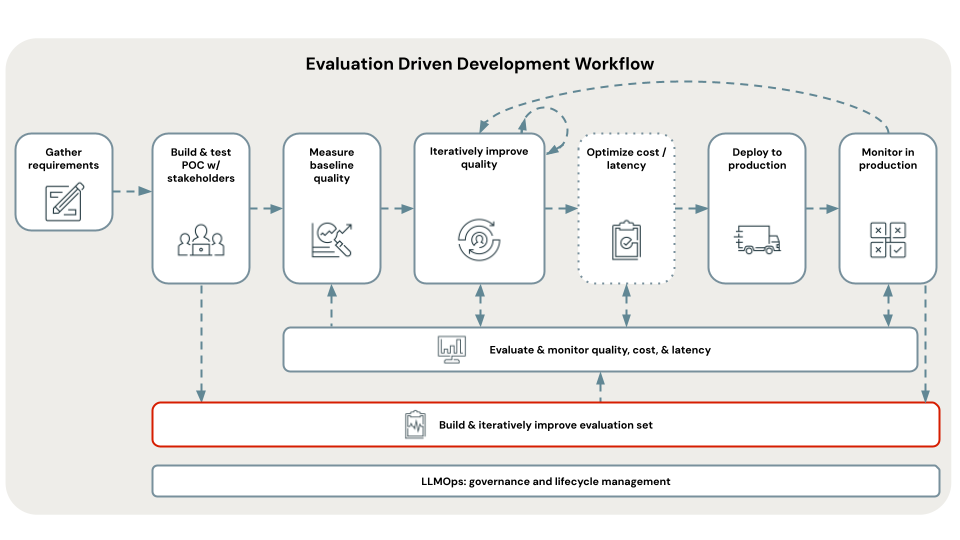

Teraz, gdy masz zestaw ewaluacyjny, użyj go, aby ocenić jakość, koszt i opóźnienie aplikacji POC. Zobacz Krok 4. Oceń jakość weryfikacji koncepcji.

< Poprzedni: Krok 2. Wdrażanie weryfikacji koncepcji i zbieranie opinii