Krok 2. Wdrażanie weryfikacji koncepcji w celu zbierania opinii uczestników projektu

Na końcu tego kroku wdrożysz aplikację Do przeglądu oceny agenta, która umożliwia uczestnikom projektu testowanie i przekazywanie opinii na temat weryfikacji koncepcji. Szczegółowe dzienniki użycia uczestników projektu i ich opinie będą przepływać do tabel delta w usłudze Lakehouse.

Wymagania

- Wykonaj krok 1. Klonowanie repozytorium kodu i tworzenie kroków obliczeniowych

- Dane z wymagań wstępnych: zbierz wymagania są dostępne w usłudze Lakehouse w woluminie wykazu aparatu Unity.

Zobacz repozytorium GitHub, aby zapoznać się z przykładowym kodem w tej sekcji.

Weryfikacja koncepcji aplikacji RAG

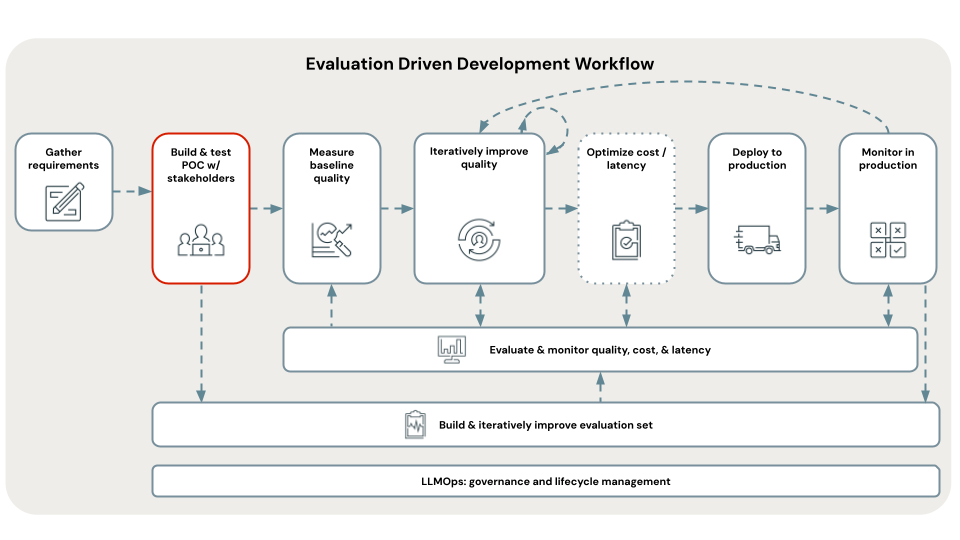

Pierwszym krokiem w opracowywaniu opartym na ocenie jest utworzenie weryfikacji koncepcji. Weryfikacja koncepcji oferuje następujące korzyści:

- Zapewnia kierunkowy wgląd w wykonalność przypadku użycia za pomocą programu RAG

- Umożliwia zbieranie początkowych opinii od uczestników projektu, co z kolei umożliwia utworzenie pierwszej wersji zestawu oceny

- Ustanawia punkt odniesienia pomiaru jakości, aby rozpocząć iterowanie od

Usługa Databricks zaleca utworzenie weryfikacji koncepcji przy użyciu najprostszej architektury RAG i zalecanych wartości domyślnych usługi Databricks dla każdego parametru.

To zalecenie jest spowodowane tym, że istnieją setki możliwych kombinacji parametrów, które można dostroić w aplikacji RAG. Możesz łatwo spędzić tygodnie dostrajania tych, ale jeśli to zrobisz, zanim będzie można systematycznie ocenić RAG, skończysz w tym, co jest określane jako pętla pętli poomów iteracji na ustawieniach, ale bez sposobu, aby obiektywnie wiedzieć, czy dokonałeś poprawy — wszystko, podczas gdy uczestnicy siedzą wokół niecierpliwie czeka na przegląd.

Szablony weryfikacji koncepcji w tym samouczku zostały zaprojektowane z myślą o iteracji jakości. Są one sparametryzowane na podstawie tego, co pokazał zespół badawczy usługi Databricks, są ważne, aby dostroić się w celu poprawy jakości RAG. Te szablony nie są "3 wierszami kodu, które magicznie tworzą rag", ale są dobrze ustrukturyzowaną aplikacją RAG, którą można dostosować pod kątem jakości w poniższych krokach przepływu pracy programowania opartego na ocenie.

Dzięki temu można szybko wdrożyć weryfikację koncepcji, ale szybko przejść do iteracji jakości bez konieczności ponownego zapisywania kodu.

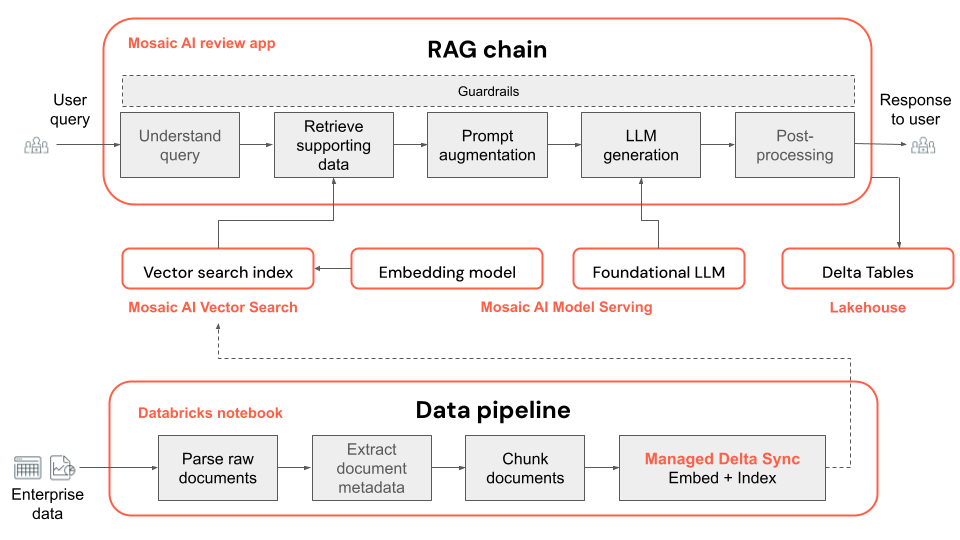

Poniżej przedstawiono architekturę techniczną aplikacji POC:

Uwaga

Domyślnie poC używa modeli open source dostępnych w narzędziu Mosaic AI Foundation Model Serving. Jednak ze względu na to, że poC używa usługi Mozaika AI Model Serving, która obsługuje dowolny model podstawowy, użycie innego modelu jest łatwe — wystarczy skonfigurować ten model w usłudze modelu, a następnie zastąpić embedding_endpoint_name element i llm_endpoint_name w notesie00_config.

- Postępuj zgodnie z tematem Aprowizowanie interfejsów API modelu podstawowego przepływności dla innych modeli typu open source dostępnych w witrynie Databricks Marketplace.

- Postępuj zgodnie z Create_OpenAI_External_Model notesem lub modelami zewnętrznymi w usłudze Mosaic AI Model Serving dla obsługiwanych modeli hostowanych przez inne firmy, takich jak Azure OpenAI, OpenAI, Cohere, Anthropic i Google Gemini.

Kroki wdrażania weryfikacji koncepcji w celu zbierania opinii

W poniższych krokach pokazano, jak uruchomić i wdrożyć aplikację sztucznej inteligencji generującej weryfikację koncepcji. Po wdrożeniu uzyskasz adres URL do aplikacji do przeglądu, którą możesz udostępnić uczestnikom projektu w celu zebrania opinii.

Otwórz folder kodu POC w A_POC_app na podstawie typu danych:

- W przypadku plików PDF użyj pdf_uc_volume.

- W przypadku plików programu PowerPoint użyj pptx_uc_volume.

- W przypadku plików DOCX użyj docx_uc_volume.

- Pliki JSON z tekstem, znaczników markdown, zawartością HTML i metadanymi używają json_uc_volume

Jeśli dane nie spełniają jednego z powyższych wymagań, możesz dostosować funkcję analizowania (

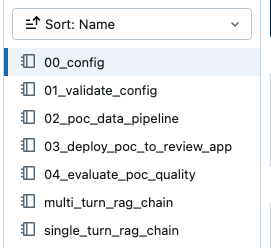

parser_udf) w02_poc_data_pipelinepowyższych katalogach weryfikacji koncepcji, aby pracować z typami plików.W folderze WERYFIKACJI koncepcji są widoczne następujące notesy:

Uwaga

Te notesy są względne względem wybranej weryfikacji koncepcji. Jeśli na przykład zostanie wyświetlone odwołanie do

00_configelementu i wybrano poleceniepdf_uc_volume, możesz znaleźć odpowiedni00_confignotes pod adresem A_POC_app/pdf_uc_volume/00_config.Opcjonalnie przejrzyj parametry domyślne.

00_configOtwórz notes w katalogu POC, który został wybrany powyżej, aby wyświetlić domyślne parametry aplikacji weryfikacji koncepcji dla potoku danych i łańcucha RAG.Ważne

Zalecane parametry domyślne usługi Databricks nie są idealne, ale są miejscem do rozpoczęcia. Następne kroki tego przepływu pracy przeprowadzą Cię przez iterację tych parametrów.

Zweryfikuj konfigurację.

Uruchom polecenie ,

01_validate_configaby sprawdzić, czy konfiguracja jest prawidłowa, a wszystkie zasoby są dostępne. Plikrag_chain_config.yamlzostanie wyświetlony w katalogu, który jest używany do wdrażania aplikacji.Uruchom potok danych.

Potok danych weryfikacji koncepcji to notes usługi Databricks oparty na platformie Apache Spark.

02_poc_data_pipelineOtwórz notes i naciśnij pozycję Uruchom wszystko, aby uruchomić potok. Potok wykonuje następujące czynności:- Ładuje nieprzetworzone dokumenty z woluminu UC

- Analizuje każdy dokument, zapisując wyniki w tabeli delty

- Fragmentuje każdy dokument, zapisując wyniki w tabeli delty

- Osadza dokumenty i tworzy indeks wektorowy przy użyciu funkcji Wyszukiwania wektorów mozaiki sztucznej inteligencji

Metadane, takie jak tabele wyjściowe i konfiguracja, dotyczące potoku danych są rejestrowane w usłudze MLflow:

Możesz sprawdzić dane wyjściowe, wyszukując linki do danych wyjściowych tabel delty lub indeksów wektorowych w dolnej części notesu:

Vector index: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>_poc_chunked_docs_gold_index Output tables: Bronze Delta Table w/ raw files: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>__poc_raw_files_bronze Silver Delta Table w/ parsed files: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>__poc_parsed_docs_silver Gold Delta Table w/ chunked files: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>__poc_chunked_docs_goldWdróż łańcuch weryfikacji koncepcji w aplikacji przeglądu.

Domyślny łańcuch weryfikacji koncepcji to wielowężny łańcuch RAG konwersacji utworzony przy użyciu biblioteki LangChain.

Uwaga

Łańcuch weryfikacji koncepcji używa rejestrowania opartego na kodzie MLflow. Aby dowiedzieć się więcej na temat rejestrowania opartego na kodzie, zobacz Rejestrowanie i rejestrowanie agentów sztucznej inteligencji.

Otwieranie notesu

03_deploy_poc_to_review_appUruchom każdą komórkę notesu.

Ślad platformy MLflow pokazuje, jak działa aplikacja POC. Dostosuj pytanie wejściowe do pytania, które jest istotne dla twojego przypadku użycia, i uruchom ponownie komórkę, aby "sprawdzić klimat" aplikacji.

Zmodyfikuj domyślne instrukcje, aby dotyczyły twojego przypadku użycia. Są one wyświetlane w aplikacji Przegląd.

instructions_to_reviewer = f"""## Instructions for Testing the {RAG_APP_NAME}'s Initial Proof of Concept (PoC) Your inputs are invaluable for the development team. By providing detailed feedback and corrections, you help us fix issues and improve the overall quality of the application. We rely on your expertise to identify any gaps or areas needing enhancement. 1. **Variety of Questions**: - Please try a wide range of questions that you anticipate the end users of the application will ask. This helps us ensure the application can handle the expected queries effectively. 2. **Feedback on Answers**: - After asking each question, use the feedback widgets provided to review the answer given by the application. - If you think the answer is incorrect or could be improved, please use "Edit Answer" to correct it. Your corrections will enable our team to refine the application's accuracy. 3. **Review of Returned Documents**: - Carefully review each document that the system returns in response to your question. - Use the thumbs up/down feature to indicate whether the document was relevant to the question asked. A thumbs up signifies relevance, while a thumbs down indicates the document was not useful. Thank you for your time and effort in testing {RAG_APP_NAME}. Your contributions are essential to delivering a high-quality product to our end users.""" print(instructions_to_reviewer)Uruchom komórkę wdrożenia, aby uzyskać link do aplikacji Przegląd.

Review App URL: https://<your-workspace-url>.databricks.com/ml/review/<uc-catalog>.<uc-schema>.<uc-model-name>/<uc-model-version>

Przyznaj poszczególnym użytkownikom uprawnienia dostępu do aplikacji Przegląd.

Aby udzielić dostępu użytkownikom spoza usługi Databricks, wykonaj kroki opisane w temacie Konfigurowanie uprawnień do korzystania z aplikacji przeglądu.

Przetestuj aplikację Przegląd, zadając sobie kilka pytań i przesyłając opinię.

Uwaga

Ślady MLflow i opinie użytkownika z aplikacji przeglądu są wyświetlane w tabelach delty w skonfigurowanym schemacie wykazu. Wyświetlenie dzienników w tych tabelach delty może potrwać do 2 godzin.

Udostępnianie aplikacji przeglądowej uczestnikom projektu

Teraz możesz udostępnić swoją aplikację POC RAG swoim uczestnikom projektu, aby uzyskać swoją opinię.

Ważne

Usługa Databricks sugeruje dystrybucję weryfikacji koncepcji do co najmniej trzech uczestników projektu i zadawanie im 10–20 pytań. Ważne jest, aby wiele uczestników projektu przetestowało weryfikację koncepcji, dzięki czemu możesz mieć zróżnicowany zestaw perspektyw do uwzględnienia w zestawie oceny.

Następny krok

Przejdź do kroku 3. Curate an Evaluation Set from stakeholder feedback (Tworzenie zestawu oceny na podstawie opinii uczestników projektu).

< Poprzedni: Krok 1. Klonowanie repozytorium i tworzenie zasobów obliczeniowych

Dalej: Krok 3. Curate an evaluation set (Curate an evaluation set) >