Krok 4. Ocena jakości weryfikacji koncepcji

Zobacz repozytorium GitHub, aby zapoznać się z przykładowym kodem w tej sekcji.

Oczekiwany czas: 5–60 minut. Czas różni się w zależności od liczby pytań w zestawie oceny. W przypadku 100 pytań ocena trwa około 5 minut.

Przegląd i oczekiwany wynik

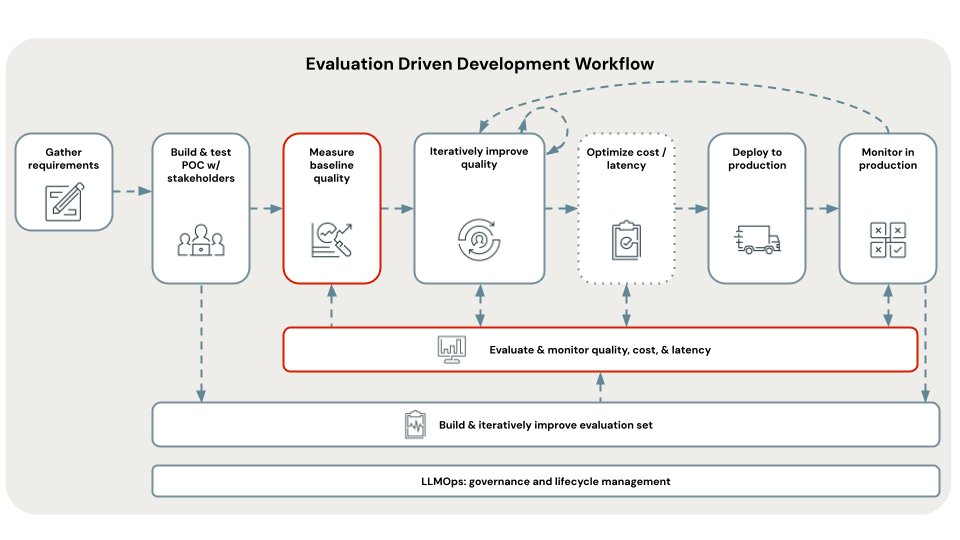

W tym kroku użyto właśnie wyselekcjonowanego zestawu ewaluacyjnego, aby ocenić aplikację Proof of Concept i ustalić wyjściową jakość, koszty i opóźnienie. Wyniki oceny są używane przez następny krok, aby zidentyfikować główną przyczynę problemów z jakością.

Ocena jest przeprowadzana przy użyciu Mosaic AI Agent Evaluation i rozpatrując kompleksowo wszystkie aspekty jakości, kosztów i opóźnień opisanych w sekcji dotyczącej metryk tego samouczka.

Zagregowane metryki i ocena poszczególnych pytań w zestawie oceny są rejestrowane w usłudze MLflow. Aby uzyskać szczegółowe informacje, zobacz Dane wyjściowe oceny.

Wymagania

- Zestaw ewaluacyjny jest dostępny.

- Wszystkie wymagania z poprzednich kroków.

Instrukcje

- Otwórz notes w wybranym katalogu WERYFIKACJI

05_evaluate_poc_qualitykoncepcji, a następnie kliknij pozycję Uruchom wszystko. - Sprawdź wyniki oceny w notesie lub przy użyciu biblioteki MLflow. Jeśli wyniki spełniają wymagania dotyczące jakości, możesz przejść bezpośrednio do pozycji Wdrażanie i monitorowanie. Ponieważ aplikacja weryfikacji koncepcji jest oparta na usłudze Databricks, jest gotowa do wdrożenia w skalowalnym, gotowym do produkcji interfejsie API REST.

Następny krok

Korzystając z tej podstawowej oceny jakości weryfikacji koncepcji, zidentyfikuj główne przyczyny wszelkich problemów z jakością i iteracyjne rozwiązywanie tych problemów w celu ulepszenia aplikacji. Zobacz Krok 5. Zidentyfikuj główną przyczynę problemów z jakością.

< poprzedni: Krok 3. Zbierz zestaw oceny

Dalej: Krok 5. Wcięcie głównych przyczyn problemów z jakością >