Ocena aplikacji generacyjnych sztucznej inteligencji

Ważne

Elementy oznaczone (wersja zapoznawcza) w tym artykule są obecnie dostępne w publicznej wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone. Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

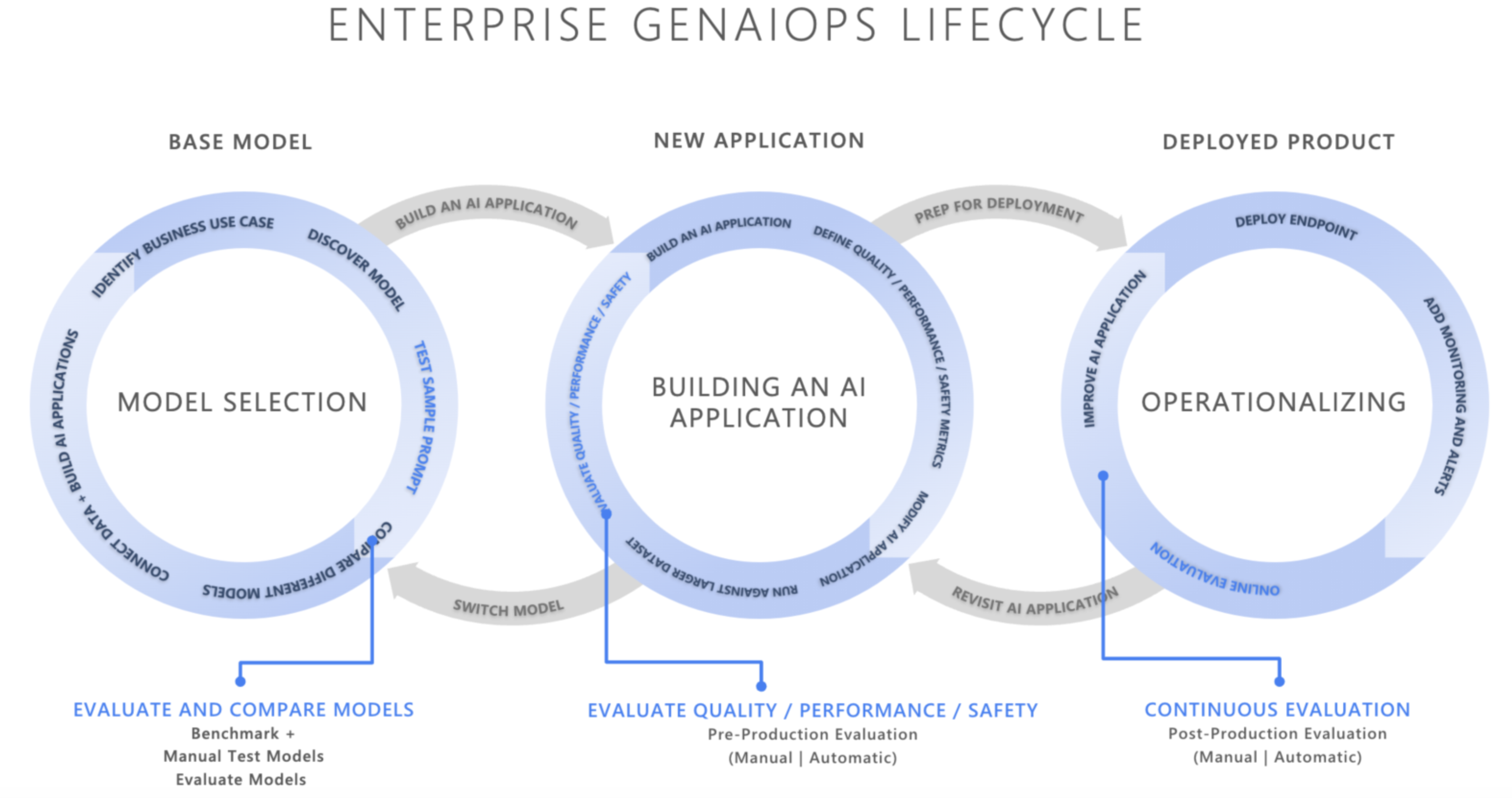

W szybko zmieniającym się środowisku sztucznej inteligencji integracja operacji generowania sztucznej inteligencji (GenAIOps) przekształca sposób tworzenia i wdrażania aplikacji sztucznej inteligencji przez organizacje. Ponieważ firmy coraz częściej korzystają ze sztucznej inteligencji w celu zwiększenia podejmowania decyzji, poprawy doświadczeń klientów i wprowadzania innowacji, nie można przecenić znaczenia solidnej struktury oceny. Ocena jest istotnym składnikiem cyklu życia generowania sztucznej inteligencji w celu budowania zaufania i zaufania do aplikacji skoncentrowanych na sztucznej inteligencji. Jeśli nie zostały starannie zaprojektowane, aplikacje te mogą produkować dane wyjściowe, które są sprodukowane i nieprzyziemne w kontekście, nieistotne lub niespójne, co skutkuje złymi doświadczeniami klientów, utrwalanie stereotypów społecznych, promowanie dezinformacji, uwidacznianie organizacji złośliwych ataków lub szeroką gamę innych negatywnych skutków.

Ewaluatorzy są przydatnymi narzędziami do oceny częstotliwości i ważności zagrożeń związanych z zawartością lub niepożądanych zachowań w odpowiedziach sztucznej inteligencji. Wykonywanie iteracyjnych, systematycznych ocen z odpowiednimi ewaluatorami może pomóc zespołom mierzyć i rozwiązywać potencjalne problemy z jakością odpowiedzi, bezpieczeństwem lub bezpieczeństwem w całym cyklu projektowania sztucznej inteligencji, od początkowego wyboru modelu poprzez monitorowanie poprodukcyjne. Ocena w środowisku produkcyjnym cyklu życia operacji genAI.

Dzięki zrozumieniu i wdrożeniu skutecznych strategii oceny na każdym etapie organizacje mogą zapewnić, że ich rozwiązania sztucznej inteligencji nie tylko spełniają początkowe oczekiwania, ale także dostosowują się i rozwijają się w rzeczywistych środowiskach. Przyjrzyjmy się, jak ocena mieści się w trzech krytycznych etapach cyklu życia sztucznej inteligencji

Wybór modelu podstawowego

Pierwszy etap cyklu życia sztucznej inteligencji obejmuje wybranie odpowiedniego modelu podstawowego. Modele generowania sztucznej inteligencji różnią się znacznie pod względem możliwości, mocnych stron i ograniczeń, dlatego ważne jest określenie, który model najlepiej odpowiada konkretnemu przypadku użycia. Podczas oceny modelu podstawowego można "rozejrzeć się", aby porównać różne modele, testując ich dane wyjściowe pod kątem zestawu kryteriów istotnych dla aplikacji.

Kluczowe zagadnienia na tym etapie mogą obejmować:

- Dokładność/jakość: Jak dobrze model generuje odpowiednie i spójne odpowiedzi?

- Wydajność określonych zadań: czy model może obsłużyć typ monitów i zawartości wymaganej dla danego przypadku użycia? Jak jest jego opóźnienie i koszt?

- Stronniczości i zagadnienia etyczne: Czy model generuje jakiekolwiek dane wyjściowe, które mogą utrwalać lub promować szkodliwe stereotypy?

- Ryzyko i bezpieczeństwo: Czy istnieją jakiekolwiek zagrożenia związane z generowaniem niebezpiecznej lub złośliwej zawartości przez model?

Możesz eksplorować testy porównawczeusługi Azure AI Foundry, aby oceniać i porównywać modele publicznie dostępnych zestawów danych, a jednocześnie ponownie wygenerować wyniki testów porównawczych na własnych danych. Alternatywnie możesz ocenić jeden z wielu podstawowych modeli generowania sztucznej inteligencji za pomocą zestawu AZURE AI Evaluation SDK, jak pokazano, zobacz Przykład Ocena punktów końcowych modelu.

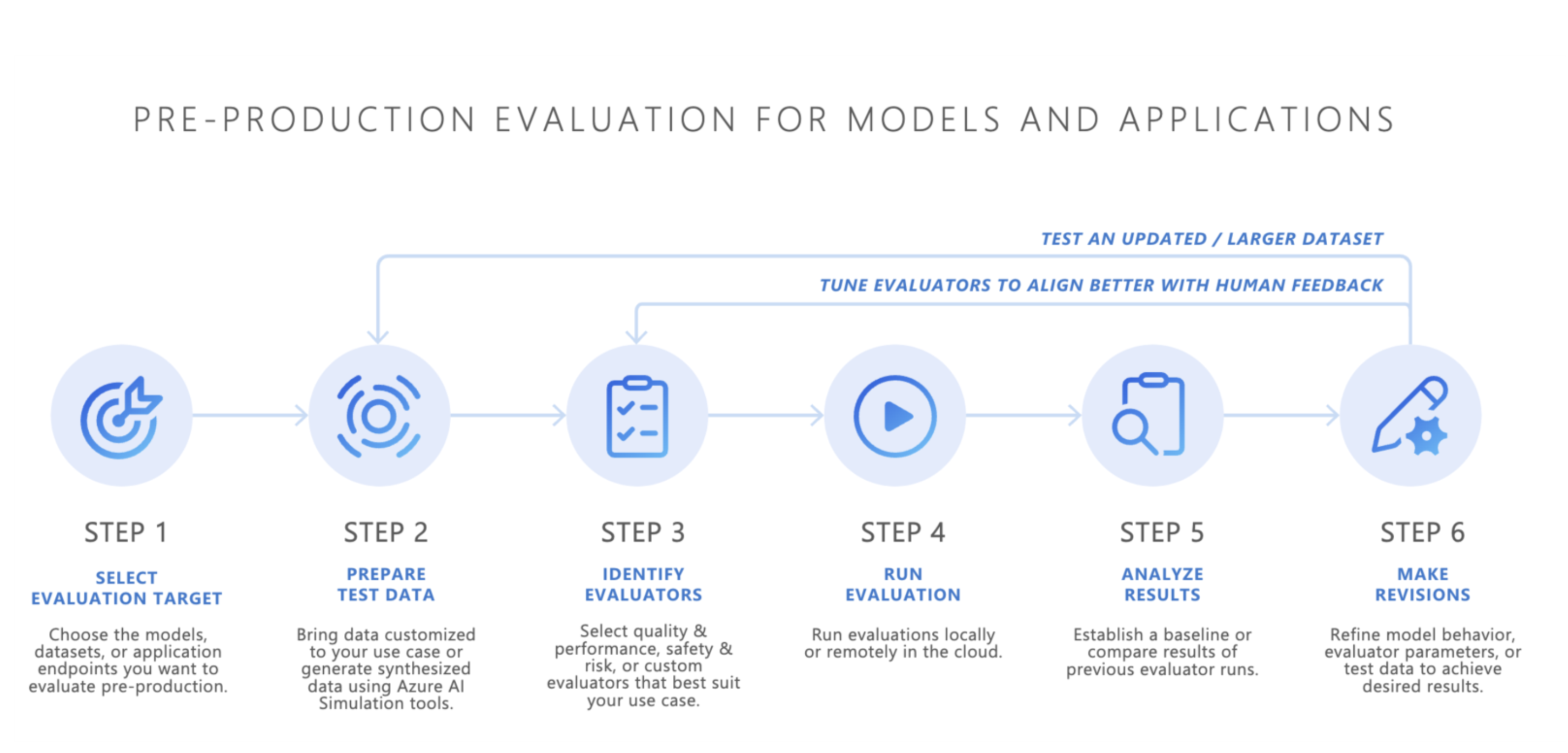

Ocena przedprodukcyjny

Po wybraniu modelu podstawowego następnym krokiem jest opracowanie aplikacji sztucznej inteligencji — takiej jak czatbot oparty na sztucznej inteligencji, aplikacja do pobierania rozszerzonej generacji (RAG), aplikacja agenta sztucznej inteligencji lub inne narzędzie do generowania sztucznej inteligencji. Po rozpoczęciu opracowywania rozpoczyna się ocena przedprodukcyjny. Przed wdrożeniem aplikacji w środowisku produkcyjnym rygorystyczne testowanie jest niezbędne, aby upewnić się, że model jest naprawdę gotowy do rzeczywistego użycia.

Ocena przedprodukcyjny obejmuje:

- Testowanie przy użyciu zestawów danych oceny: te zestawy danych symulują realistyczne interakcje użytkowników, aby upewnić się, że aplikacja sztucznej inteligencji działa zgodnie z oczekiwaniami.

- Identyfikowanie przypadków brzegowych: znajdowanie scenariuszy, w których jakość odpowiedzi aplikacji sztucznej inteligencji może ulec pogorszeniu lub generować niepożądane dane wyjściowe.

- Ocena niezawodności: zapewnienie, że model może obsłużyć szereg odmian wejściowych bez znaczących spadków jakości lub bezpieczeństwa.

- Mierzenie kluczowych metryk: Metryki, takie jak uziemienie odpowiedzi, istotność i bezpieczeństwo, są oceniane w celu potwierdzenia gotowości do produkcji.

Etap przedprodukcyjny działa jako ostateczna kontrola jakości, co zmniejsza ryzyko wdrożenia aplikacji sztucznej inteligencji, która nie spełnia żądanych standardów wydajności lub bezpieczeństwa.

- Przynieś własne dane: możesz ocenić aplikacje sztucznej inteligencji w środowisku przedprodukcyjnym przy użyciu własnych danych ewaluacyjnych za pomocą narzędzia Azure AI Foundry lub obsługiwanych ewaluatorów zestawu AZURE AI Evaluation SDK , w tym oceny jakości generacji, bezpieczeństwa lub niestandardowych ewaluatorów oraz wyświetlić wyniki za pośrednictwem portalu azure AI Foundry.

- Symulatory: jeśli nie masz danych ewaluacyjnych (danych testowych), symulatory zestawu SDK oceny sztucznej inteligencji platformy Azure mogą pomóc, generując zapytania dotyczące tematu lub niepożądane. Te symulatory testuje odpowiedź modelu na zapytania podobne do sytuacji lub ataki (przypadki brzegowe).

- Symulator niepożądany wprowadza zapytania, które naśladują potencjalne zagrożenia bezpieczeństwa lub próbują złamać zabezpieczenia, pomagając zidentyfikować ograniczenia i przygotować model pod kątem nieoczekiwanych warunków.

- Symulatory odpowiednie dla kontekstu generują typowe, istotne konwersacje , których oczekujesz od użytkowników do testowania jakości odpowiedzi.

Alternatywnie możesz również użyć widżetu oceny rozwiązania Azure AI Foundry do testowania generowanych aplikacji sztucznej inteligencji.

Po osiągnięciu zadowalających wyników można wdrożyć aplikację sztucznej inteligencji w środowisku produkcyjnym.

Monitorowanie po produkcji

Po wdrożeniu aplikacja sztucznej inteligencji wchodzi w fazę oceny poprodukcyjnej, znaną również jako ocena online lub monitorowanie. Na tym etapie model jest osadzony w rzeczywistym produkcie i odpowiada na rzeczywiste zapytania użytkowników. Monitorowanie zapewnia, że model nadal zachowuje się zgodnie z oczekiwaniami i dostosowuje się do wszelkich zmian w zachowaniu użytkownika lub zawartości.

- Ciągłe śledzenie wydajności: Regularne mierzenie odpowiedzi aplikacji sztucznej inteligencji przy użyciu kluczowych metryk w celu zapewnienia spójnej jakości danych wyjściowych.

- Reagowanie na zdarzenia: szybkie reagowanie na wszelkie szkodliwe, niesprawiedliwe lub niewłaściwe dane wyjściowe, które mogą wystąpić podczas rzeczywistego użycia.

Stale monitorując zachowanie aplikacji sztucznej inteligencji w środowisku produkcyjnym, można utrzymywać wysokiej jakości środowiska użytkownika i szybko rozwiązywać wszelkie problemy, które występują.

Podsumowanie

GenAIOps polega na ustanowieniu niezawodnego i powtarzalnego procesu zarządzania aplikacjami generowania sztucznej inteligencji w całym cyklu życia. Ocena odgrywa istotną rolę na każdym etapie, od wyboru modelu podstawowego, poprzez testowanie przedprodukcyjne, do ciągłego monitorowania poprodukcyjnego. Systematycznie mierząc ryzyko i udoskonalając systemy sztucznej inteligencji na każdym etapie, zespoły mogą tworzyć generowanie rozwiązań sztucznej inteligencji, które nie są tylko zaawansowane, ale także wiarygodne i bezpieczne w rzeczywistym użyciu.

Ściągawka:

| Purpose | Przetwarzaj | Parametry |

|---|---|---|

| Co oceniasz? | Identyfikowanie lub tworzenie odpowiednich ewaluatorów |

-

Jakość i wydajność ( przykładowy notes jakości i wydajności) - Bezpieczeństwo i zabezpieczenia (przykładowy notes bezpieczeństwa i zabezpieczeń) - Niestandardowy (niestandardowy przykładowy notes) |

| Jakich danych należy użyć? | Przekazywanie lub generowanie odpowiedniego zestawu danych |

Ogólny symulator pomiaru jakości i wydajności (ogólny przykładowy notes symulatora) - Symulator niepożądany do mierzenia bezpieczeństwa i zabezpieczeń (przykładowy notes symulatora niepożądanego) |

| Jakie zasoby powinny przeprowadzić ocenę? | Uruchamianie oceny | - Uruchamianie lokalne — Zdalne uruchamianie chmury |

| Jak działa mój model/aplikacja? | Analizowanie wyników | Wyświetlanie zagregowanych wyników, wyświetlanie szczegółów, szczegóły oceny, porównywanie przebiegów oceny |

| Jak mogę ulepszyć? | Wprowadzanie zmian w modelu, aplikacji lub ewaluatorach | - Jeśli wyniki oceny nie były zgodne z opiniami ludzkimi, dostosuj ewaluatora. - Jeśli wyniki oceny są dostosowane do opinii człowieka, ale nie spełniają progów jakości/bezpieczeństwa, zastosuj ukierunkowane środki zaradcze. |

Powiązana zawartość

- Ocena generowanych aplikacji sztucznej inteligencji za pośrednictwem placu zabaw

- Ocena generowanych aplikacji sztucznej inteligencji przy użyciu zestawu AZURE AI Foundry SDK lub portalu

- Metryki oceny i monitorowania dla generowania sztucznej inteligencji

- Uwaga dotycząca przejrzystości dla ocen bezpieczeństwa rozwiązania Azure AI Foundry