Testy porównawcze modelu w portalu usługi Azure AI Foundry

Ważne

Elementy oznaczone (wersja zapoznawcza) w tym artykule są obecnie dostępne w publicznej wersji zapoznawczej. Ta wersja zapoznawcza jest udostępniana bez umowy dotyczącej poziomu usług i nie zalecamy korzystania z niej w przypadku obciążeń produkcyjnych. Niektóre funkcje mogą być nieobsługiwane lub ograniczone. Aby uzyskać więcej informacji, zobacz Uzupełniające warunki korzystania z wersji zapoznawczych platformy Microsoft Azure.

W portalu azure AI Foundry możesz porównać testy porównawcze między modelami i zestawami danych dostępnymi w branży, aby zdecydować, który z nich spełnia Twój scenariusz biznesowy. Możesz bezpośrednio uzyskać dostęp do szczegółowych wyników testów porównawczych w katalogu modeli. Niezależnie od tego, czy masz już na uwadze modele, czy eksplorujesz modele, dane porównawcze w usłudze Azure AI umożliwiają szybkie i wydajne podejmowanie świadomych decyzji.

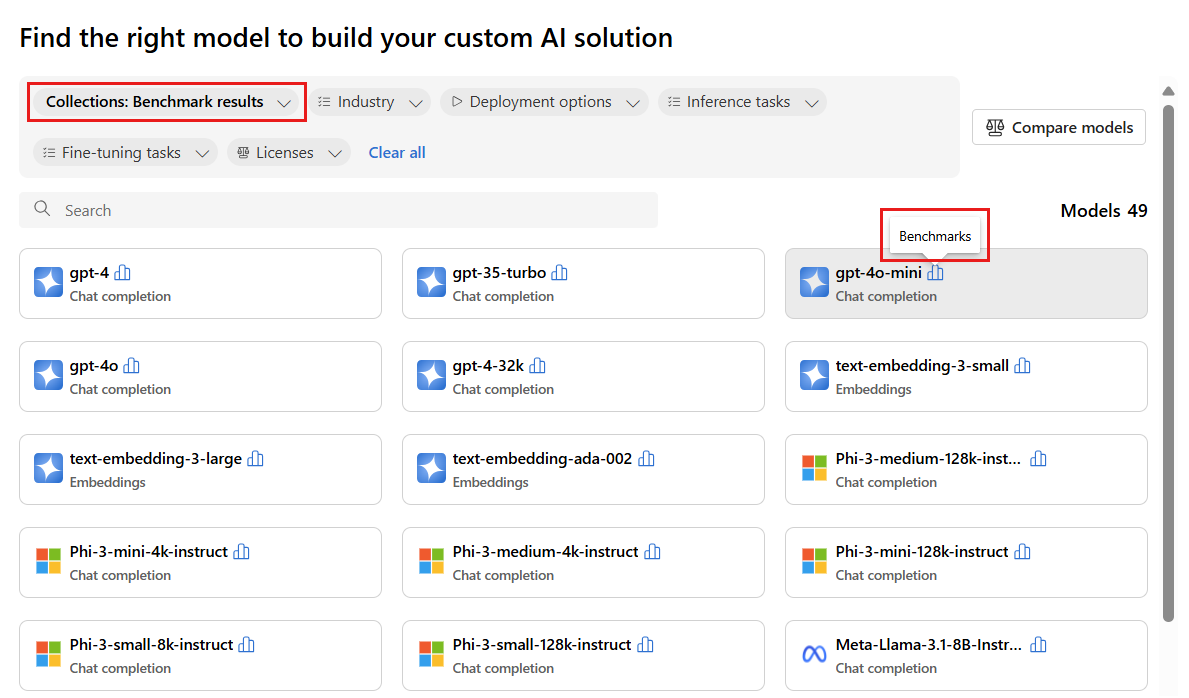

Usługa Azure AI obsługuje testy porównawcze modeli dla wybranych modeli, które są popularne i najczęściej używane. Obsługiwane modele mają ikonę testów porównawczych , która wygląda jak histogram. Te modele można znaleźć w katalogu modeli, korzystając z filtru Kolekcje i wybierając pozycję Wyniki testu porównawczego. Następnie możesz użyć funkcji wyszukiwania, aby znaleźć określone modele.

Testy porównawcze modelu ułatwiają podejmowanie świadomych decyzji dotyczących zrównoważonego rozwoju modeli i zestawów danych przed zainicjowaniem jakiegokolwiek zadania. Testy porównawcze to wyselekcjonowana lista najlepszych modeli dla zadania na podstawie kompleksowego porównania metryk porównawczych. Usługa Azure AI Foundry udostępnia następujące testy porównawcze dla modeli na podstawie kolekcji wykazu modeli:

- Testy porównawcze w dużych modelach językowych (LLM) i modelach małych języków (SLM)

- Testy porównawcze między modelami osadzania

Benchmarking of LLMs and SLMs

Testy porównawcze modelu oceniają llMs i SLMs w następujących kategoriach: jakość, wydajność i koszt. Testy porównawcze są regularnie aktualizowane, gdy nowe metryki i zestawy danych są dodawane do istniejących modeli, a nowe modele są dodawane do wykazu modeli.

Kontrola

Usługa Azure AI ocenia jakość llMs i SLMs w różnych metrykach pogrupowanych w dwie główne kategorie: dokładność i metryki wspomagane monitem:

Dla metryki dokładności:

| Metryczne | opis |

|---|---|

| Dokładność | Wyniki dokładności są dostępne na poziomie zestawu danych i modelu. Na poziomie zestawu danych wynik jest średnią wartością metryki dokładności obliczonej na wszystkich przykładach w zestawie danych. Używana metryka dokładności jest exact-match we wszystkich przypadkach z wyjątkiem zestawu danych HumanEval , który używa pass@1 metryki. Dokładne dopasowanie porównuje wygenerowany tekst modelu z prawidłową odpowiedzią zgodnie z zestawem danych, zgłaszając go, jeśli wygenerowany tekst odpowiada dokładnie i zero w przeciwnym razie. pass@1 Metryka mierzy proporcję rozwiązań modelu, które przechodzą zestaw testów jednostkowych w zadaniu generowania kodu. Na poziomie modelu współczynnik dokładności jest średnią dokładności na poziomie zestawu danych dla każdego modelu. |

W przypadku metryk asystowanych po wyświetleniu monitu:

| Metryczne | opis |

|---|---|

| Spójności | Spójność ocenia, jak dobrze model językowy może wygenerować dane wyjściowe, które przepływa płynnie, odczytuje naturalnie i przypomina język przypominający człowieka. |

| Płynność | Płynność ocenia biegłość językową przewidywanej odpowiedzi na generowanie sztucznej inteligencji. Ocenia, jak dobrze wygenerowany tekst jest zgodny z regułami gramatycznymi, strukturami składniowymi i odpowiednim użyciem słownictwa, co skutkuje poprawną językowo i naturalnie brzmiącymi odpowiedziami. |

| GPTSimilarity | GPTSimilarity to miara, która kwantyfikuje podobieństwo między zdaniem podstawy prawdy (lub dokumentem) a wyrokiem przewidywania wygenerowanym przez model sztucznej inteligencji. Metryka jest obliczana przez pierwsze osadzanie na poziomie zdania przy użyciu interfejsu API osadzania zarówno dla podstawowej prawdy, jak i przewidywania modelu. Te osadzania reprezentują wielowymiarowe reprezentacje wektorów zdań, przechwytując ich semantyczne znaczenie i kontekst. |

| Uziemienie | Groundedness mierzy, jak dobrze generowane odpowiedzi modelu językowego są zgodne z informacjami ze źródła danych wejściowych. |

| Stopień zgodności | Istotność mierzy zakres, w jakim wygenerowane odpowiedzi modelu językowego są odpowiednie i bezpośrednio związane z podanymi pytaniami. |

Usługa Azure AI wyświetla również indeks jakości w następujący sposób:

| Indeks | opis |

|---|---|

| Indeks jakości | Indeks jakości jest obliczany przez skalowanie w dół GPTSimilarity między zerem a jednym, a następnie średnie z metrykami dokładności. Wyższe wartości indeksu jakości są lepsze. |

Indeks jakości reprezentuje średni wynik odpowiedniej podstawowej metryki (dokładności, ponownego skalowania GPTSimilarity) ponad 15 standardowych zestawów danych i jest dostarczany w skali od zera do jednego.

Indeks jakości stanowi dwie kategorie metryk:

- Dokładność (na przykład dokładne dopasowanie lub

pass@k). Zakresy od zera do jednego. - Metryki oparte na monitach (na przykład GPTSimilarity, uziemienie, spójność, płynność i istotność). Zakresy od jednego do pięciu.

Stabilność wartości indeksu jakości zapewnia wskaźnik ogólnej jakości modelu.

Wydajność

Metryki wydajności są obliczane jako agregacja w ciągu 14 dni na podstawie 24 szlaków (dwóch żądań na szlak) wysyłanych codziennie z jednogodzinnym interwałem między każdym szlakiem. Dla każdego żądania do punktu końcowego modelu są używane następujące parametry domyślne:

| Parametr | Wartość | Dotyczy |

|---|---|---|

| Region (Region) | Wschodnie stany USA/Wschodnie stany USA 2 | Bezserwerowe interfejsy API i interfejsy Azure OpenAI |

| Limit szybkości tokenów na minutę (TPM) | 30 tys. (180 obr./min na podstawie usługi Azure OpenAI) N/A (bezserwerowe interfejsy API) |

W przypadku modeli usługi Azure OpenAI wybór jest dostępny dla użytkowników z zakresami limitów szybkości na podstawie typu wdrożenia (standard, globalny, globalny i tak dalej). W przypadku bezserwerowych interfejsów API to ustawienie jest abstrakcyjne. |

| Liczba żądań | Dwa żądania w szlaku dla każdej godziny (24 szlaki dziennie) | Bezserwerowe interfejsy API, Azure OpenAI |

| Liczba tras/przebiegów | 14 dni z 24 trasami dziennie na 336 biegach | Bezserwerowe interfejsy API, Azure OpenAI |

| Długość monitu/kontekstu | Umiarkowana długość | Bezserwerowe interfejsy API, Azure OpenAI |

| Liczba przetworzonych tokenów (umiarkowana) | Współczynnik 80:20 dla tokenów wejściowych do tokenów wyjściowych, czyli 800 tokenów wejściowych do 200 tokenów wyjściowych. | Bezserwerowe interfejsy API, Azure OpenAI |

| Liczba współbieżnych żądań | Jedno (żądania są wysyłane sekwencyjnie jeden po drugim) | Bezserwerowe interfejsy API, Azure OpenAI |

| Data | Syntetyczne (monity wejściowe przygotowane z tekstu statycznego) | Bezserwerowe interfejsy API, Azure OpenAI |

| Region (Region) | Wschodnie stany USA/Wschodnie stany USA 2 | Bezserwerowe interfejsy API i interfejsy Azure OpenAI |

| Typ wdrożenia | Standardowa | Dotyczy tylko usługi Azure OpenAI |

| Przesyłanie strumieniowe | Prawda | Dotyczy bezserwerowych interfejsów API i interfejsów Azure OpenAI. W przypadku modeli wdrożonych za pośrednictwem zarządzanych zasobów obliczeniowych ustaw wartość max_token = 1 w celu replikacji scenariusza przesyłania strumieniowego, który umożliwia obliczanie metryk, takich jak całkowity czas pierwszego tokenu (TTFT) dla zarządzanych obliczeń. |

| Tokenizer | Pakiet Tiktoken (Azure OpenAI) Przytulanie identyfikatora modelu rozpoznawania twarzy (bezserwerowe interfejsy API) |

Przytulanie identyfikatora modelu rozpoznawania twarzy (bezserwerowe interfejsy API platformy Azure) |

Wydajność usług LLM i SLM jest oceniana w następujących metrykach:

| Metryczne | opis |

|---|---|

| Średnia opóźnienia | Średni czas w sekundach przetwarzania żądania obliczony na wiele żądań. Aby obliczyć tę metrykę, wysyłamy żądanie do punktu końcowego co godzinę, przez dwa tygodnie i obliczamy średnią. |

| Opóźnienie P50 | 50. wartość percentylu (mediana) opóźnienia (czas między żądaniem a odebraniem całej odpowiedzi z pomyślnym kodem). Na przykład po wysłaniu żądania do punktu końcowego 50% żądań jest ukończonych w ciągu "x" sekund, a wartość "x" jest miarą opóźnienia. |

| Opóźnienie P90 | 90. wartość percentylu opóźnienia (czas potrzebny między żądaniem a odebraniem całej odpowiedzi z pomyślnym kodem). Na przykład po wysłaniu żądania do punktu końcowego 90% żądań jest ukończonych w ciągu "x" sekund, a "x" jest pomiarem opóźnienia. |

| Opóźnienie P95 | 95. wartość percentylu opóźnienia (czas potrzebny między żądaniem a odebraniem całej odpowiedzi z pomyślnym kodem). Na przykład po wysłaniu żądania do punktu końcowego 95% żądań jest ukończonych w ciągu "x" sekund, a wartość "x" jest miarą opóźnienia. |

| Opóźnienie P99 | 99. wartość percentylu opóźnienia (czas potrzebny między żądaniem a odebraniem całej odpowiedzi z pomyślnym kodem). Na przykład po wysłaniu żądania do punktu końcowego 99% żądań jest ukończonych w ciągu "x" sekund, a wartość "x" jest miarą opóźnienia. |

| Przepływność GTPS | Wygenerowane tokeny na sekundę (GTPS) to liczba tokenów wyjściowych generowanych na sekundę od momentu wysłania żądania do punktu końcowego. |

| Przepływność TTPS | Łączna liczba tokenów na sekundę (TTPS) to liczba łącznych tokenów przetworzonych na sekundę, w tym zarówno z monitu wejściowego, jak i wygenerowanych tokenów wyjściowych. |

| Opóźnienie TTFT | Łączny czas pierwszego tokenu (TTFT) to czas potrzebny na pierwszy token w odpowiedzi, która ma zostać zwrócona z punktu końcowego po włączeniu przesyłania strumieniowego. |

| Czas między tokenami | Ta metryka to czas między odebranych tokenów. |

Usługa Azure AI wyświetla również indeksy wydajności dla opóźnień i przepływności w następujący sposób:

| Indeks | opis |

|---|---|

| Indeks opóźnienia | Średni czas pierwszego tokenu. Niższe wartości są lepsze. |

| Indeks przepływności | Średnie wygenerowane tokeny na sekundę. Wyższe wartości są lepsze. |

W przypadku metryk wydajności, takich jak opóźnienie lub przepływność, czas pierwszego tokenu i wygenerowane tokeny na sekundę zapewniają lepsze ogólne poczucie typowej wydajności i zachowania modelu. Odświeżamy nasze numery wydajności w regularnych okresach.

Koszt

Obliczenia kosztów są szacowane przy użyciu punktu końcowego modelu LLM lub SLM hostowanego na platformie azure AI. Usługa Azure AI obsługuje wyświetlanie kosztów bezserwerowych interfejsów API i modeli usługi Azure OpenAI. Ponieważ te koszty mogą ulec zmianie, odświeżymy obliczenia kosztów zgodnie z regularnym cyklem.

Koszt usług LLM i SLM jest oceniany w następujących metrykach:

| Metryczne | opis |

|---|---|

| Koszt na tokeny wejściowe | Koszt wdrożenia bezserwerowego interfejsu API dla 1 miliona tokenów wejściowych |

| Koszt na tokeny wyjściowe | Koszt wdrożenia bezserwerowego interfejsu API dla 1 miliona tokenów wyjściowych |

| Szacowany koszt | Koszt sumy kosztu za tokeny wejściowe i koszt na tokeny wyjściowe z współczynnikiem 3:1. |

Usługa Azure AI wyświetla również indeks kosztów w następujący sposób:

| Indeks | opis |

|---|---|

| Indeks kosztów | Szacowany koszt. Niższe wartości są lepsze. |

Testowanie porównawcze modeli osadzania

Testy porównawcze modelu oceniają modele osadzania na podstawie jakości.

Kontrola

Jakość modeli osadzania jest oceniana w następujących metrykach:

| Metryczne | opis |

|---|---|

| Dokładność | Dokładność jest proporcją prawidłowych przewidywań wśród całkowitej liczby przetworzonych przewidywań. |

| Wynik F1 | Wynik F1 jest średnią ważoną dokładności i kompletności, gdzie najlepszą wartością jest jedna (doskonała precyzja i kompletność), a najgorsze jest zero. |

| Średnia precyzja (MAP) | USŁUGA MAP ocenia jakość systemów klasyfikacji i rekomendacji. Mierzy zarówno znaczenie sugerowanych elementów, jak i to, jak dobry jest system w umieszczaniu bardziej odpowiednich elementów u góry. Wartości mogą wahać się od zera do jednego, a im wyższa mapa MAP, tym lepiej system może umieścić odpowiednie elementy na liście. |

| Znormalizowany zysk skumulowany z rabatem (NDCG) | NDCG ocenia zdolność algorytmu uczenia maszynowego do sortowania elementów na podstawie istotności. Porównuje klasyfikacje z idealną kolejnością, w której wszystkie odpowiednie elementy znajdują się na początku listy, gdzie k jest długością listy podczas oceniania jakości klasyfikacji. W naszych testach porównawczych k=10 wskazywana przez metrykę ndcg_at_10, co oznacza, że przyjrzymy się 10 wierzchołków. |

| Dokładność | Precyzja mierzy zdolność modelu do prawidłowego identyfikowania wystąpień określonej klasy. Precyzja pokazuje, jak często model uczenia maszynowego jest poprawny podczas przewidywania klasy docelowej. |

| Korelacja Spearman | Korelacja Spearman oparta na podobieństwie cosinusu jest obliczana przez najpierw obliczenie podobieństwa cosinus między zmiennymi, a następnie klasyfikowanie tych wyników i używanie klasyfikacji do obliczenia korelacji Spearman. |

| Miara V | Miara V to metryka używana do oceny jakości klastrowania. Miara V jest obliczana jako średnia harmoniczna homogeniczności i kompletności, zapewniając równowagę między nimi w celu uzyskania znaczącego wyniku. Możliwe wyniki leżą od zera do jednego, a jeden jest całkowicie kompletny etykietowanie. |

Obliczanie wyników

Indywidualne wyniki

Wyniki testów porównawczych pochodzą z publicznych zestawów danych, które są często używane do oceny modelu językowego. W większości przypadków dane są hostowane w repozytoriach GitHub obsługiwanych przez twórców lub kuratorów danych. Potoki oceny sztucznej inteligencji platformy Azure pobierają dane ze swoich oryginalnych źródeł, wyodrębniają monity z każdego przykładowego wiersza, generują odpowiedzi modelu, a następnie obliczają odpowiednie metryki dokładności.

Tworzenie monitów jest zgodne z najlepszymi rozwiązaniami dla każdego zestawu danych, zgodnie z dokumentem wprowadzającym zestaw danych i standardy branżowe. W większości przypadków każdy monit zawiera kilka zdjęć, czyli kilka przykładów pełnych pytań i odpowiedzi na podstawy modelu zadania. Potoki oceny tworzą zdjęcia, próbkując pytania i odpowiedzi na podstawie części danych, które są przechowywane na podstawie oceny.