Delta Lake-logboeken in Warehouse in Microsoft Fabric

Van toepassing op:✅ Warehouse in Microsoft Fabric

Warehouse in Microsoft Fabric bestaat uit open bestandsindelingen. Gebruikerstabellen worden opgeslagen in parquet-bestandsindeling en Delta Lake-logboeken worden gepubliceerd voor alle gebruikerstabellen.

De Delta Lake-logboeken openen directe toegang tot de gebruikerstabellen van het magazijn voor elke engine die Delta Lake-tabellen kan lezen. Deze toegang is beperkt tot alleen-lezen om ervoor te zorgen dat de gebruikersgegevens de ACID-transactienaleving behouden. Alle invoegingen, updates en verwijderingen voor de gegevens in de tabellen moeten worden uitgevoerd via het magazijn. Zodra een transactie is doorgevoerd, wordt een systeemachtergrondproces gestart om het bijgewerkte Delta Lake-logboek voor de betrokken tabellen te publiceren.

OneLake-pad ophalen

In de volgende stappen wordt beschreven hoe u het OneLake-pad kunt ophalen uit een tabel in een magazijn:

Open Warehouse in uw Microsoft Fabric-werkruimte.

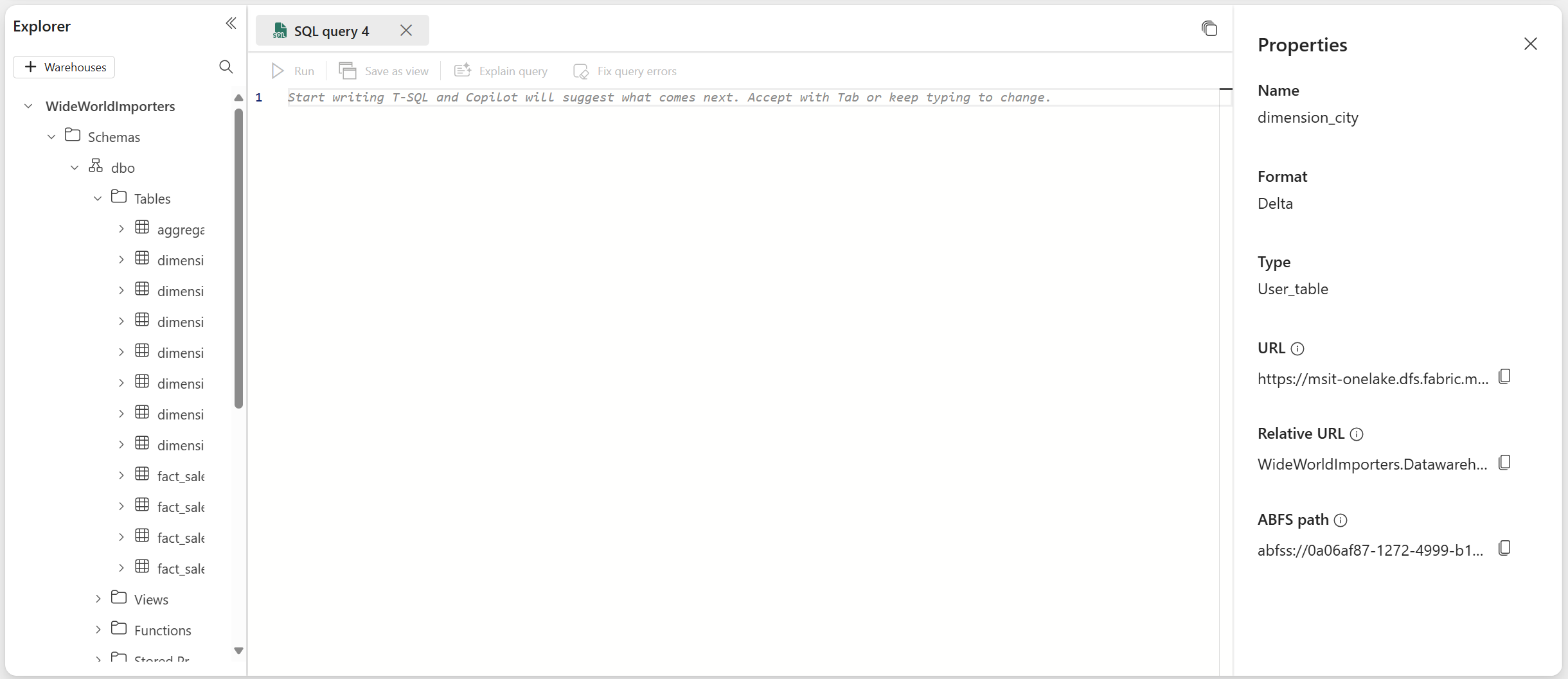

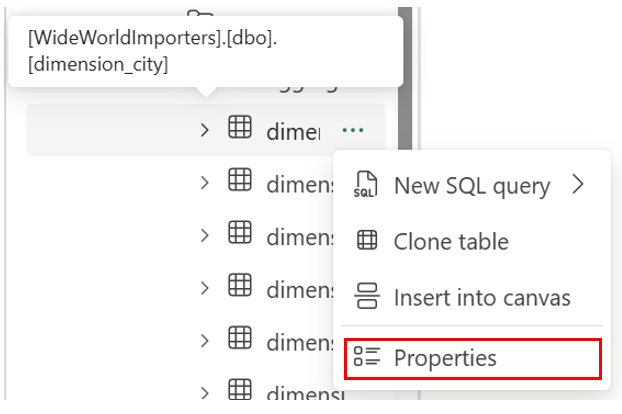

In de Objectverkenner vindt u meer opties (...) in een geselecteerde tabel in de map Tabellen. Selecteer het menu Eigenschappen .

In het deelvenster Eigenschappen worden de volgende gegevens weergegeven in het deelvenster Eigenschappen :

- Naam

- Notatie

- Type

- URL

- Relatief pad

- ABFS-pad

How to get Delta Lake logs path (Delta Lake-logboekpad ophalen)

U kunt Delta Lake-logboeken vinden via de volgende methoden:

Delta Lake-logboeken kunnen worden opgevraagd via snelkoppelingen die zijn gemaakt in een lakehouse. U kunt de bestanden weergeven met behulp van een Microsoft Fabric Spark Notebook of de Lakehouse Explorer in Fabric Data-engineer ing in de Microsoft Fabric-portal.

Delta Lake-logboeken vindt u via Azure Storage Explorer, via Spark-verbindingen zoals de Direct Lake-modus van Power BI of met behulp van een andere service die deltatabellen kan lezen.

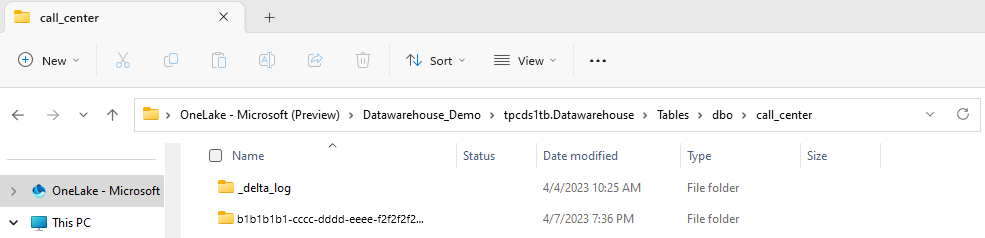

Delta Lake-logboeken vindt u in de

_delta_logmap van elke tabel via OneLake Explorer in Windows, zoals wordt weergegeven in de volgende schermopname.

Het publiceren van Delta Lake-logboeken onderbreken

Het publiceren van Delta Lake-logboeken kan indien nodig worden onderbroken en hervat. Wanneer het publiceren is onderbroken, ziet Microsoft Fabric-engines die tabellen buiten het magazijn lezen de gegevens zoals deze vóór de pauze waren. Het zorgt ervoor dat rapporten stabiel en consistent blijven, waarbij gegevens uit alle tabellen worden weergegeven zoals ze bestonden voordat er wijzigingen in de tabellen werden aangebracht. Zodra uw gegevensupdates zijn voltooid, kunt u de publicatie van Delta Lake Log hervatten om alle recente gegevenswijzigingen zichtbaar te maken voor andere analytische engines. Een ander gebruiksvoorbeeld voor het onderbreken van het publiceren van Delta Lake-logboeken is wanneer gebruikers geen interoperabiliteit met andere rekenprogramma's in Microsoft Fabric nodig hebben, omdat dit kan helpen besparen op de rekenkosten.

De syntaxis voor het onderbreken en hervatten van het publiceren van Delta Lake-logboeken is als volgt:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED | AUTO

Voorbeeld: Delta Lake-logboekpublicatie onderbreken en hervatten

Gebruik het volgende codefragment om het publiceren van Delta Lake-logboeken te onderbreken:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED

Query's naar magazijntabellen in het huidige magazijn van andere Microsoft Fabric-engines (bijvoorbeeld query's van een Lakehouse) geven nu een versie van de gegevens weer zoals deze was voordat delta lake-logboekpublicatie werd onderbroken. Magazijnquery's bevatten nog steeds de nieuwste versie van gegevens.

Als u het publiceren van Delta Lake-logboeken wilt hervatten, gebruikt u het volgende codefragment:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = AUTO

Wanneer de status weer wordt gewijzigd in AUTO, publiceert de Fabric Warehouse-engine logboeken van alle recente wijzigingen in tabellen in het magazijn, zodat andere analytische engines in Microsoft Fabric de nieuwste versie van gegevens kunnen lezen.

De status van het publiceren van Delta Lake-logboeken controleren

Gebruik het volgende codefragment om de huidige status van het publiceren van Delta Lake-logboeken op alle magazijnen voor de huidige werkruimte te controleren:

SELECT [name], [DATA_LAKE_LOG_PUBLISHING_DESC] FROM sys.databases

Beperkingen

- Tabelnamen kunnen alleen worden gebruikt door Spark en andere systemen als ze alleen deze tekens bevatten: A-Z a-z 0-9 en onderstrepingstekens.

- Kolomnamen die worden gebruikt door Spark en andere systemen kunnen niet het volgende bevatten:

- Ruimten

- tabbladen

- Regelteruglooptekens

- [

- ,

- ;

- {

- }

- (

- )

- =

- ]