MLOps en GenAIOps voor AI-workloads in Azure

AI-workloadbewerkingen zijn gecentreerd op de curatie van gegevens en het verbruik van die gegevens. Bewerkingen zorgen voor efficiëntie bij het bereiken en onderhouden van de kwaliteit, betrouwbaarheid, beveiliging, ethiek en andere standaarden die u prioriteert voor de workload.

De workloadtaken kunnen worden onderverdeeld in drie hoofdgebieden: toepassingsontwikkeling, gegevensverwerking en AI-modelbeheer. Elke categorie moet gebruikmaken van bewezen operationele methodologieën, zoals DevOps, DataOps, MLOps en GenAIOps.

DevOps-activiteiten hebben betrekking op het volledige levenscyclusbeheer van toepassingen via geautomatiseerde CI/CD-pijplijnen (continue integratie en continue implementatie) en bewaking. Voor AI-workloads is de gegevenspijplijn echter een van de kernonderdelen. DataOps, een specialisatie van DevOps, richt zich op het beheren van de levenscyclus van gegevens door processen zoals gegevensextractie, transformatie en laden (ETL/ELT) te stroomlijnen. DataOps-professionals meten doorgaans de prestaties van de gegevensstroom en de werkzaamheid van het opschonen van gegevens en het bewaken van de pijplijn op afwijkingen.

AI-workloads zijn inherent niet-deterministisch. Veel AI-modellen zijn gevoelig voor het produceren van verschillende antwoorden voor hetzelfde onderzoek tijdens deductie. Deze workloads hebben processen nodig die kunnen worden beheerd en aangepast aan de onvoorspelbaarheid van AI-uitvoer. DataOps wordt uitgebreid naar MLOps, waarmee machine learning-werkstromen worden geïmplementeerd voor modeltraining en -tests. GenAIOps, een gespecialiseerde subset van MLOps, is gericht op generatieve AI-oplossingen. Het omvat taken zoals modeldetectie en het verfijnen van vooraf getrainde modellen met verrijkte gegevens.

Operationele activiteiten overlappen vaak en de verschillende methodologieën zijn van toepassing op verschillende graden. In discriminerende AI speelt DataOps bijvoorbeeld een belangrijke rol, terwijl DevOps-activiteiten minder prominent zijn. In generatieve AI is operationele uitmuntendheid daarentegen zwaarder afhankelijk van DevOps dan DataOps.

Hoe dan ook, het algemene doel is het leveren van mogelijkheden met efficiënte bewerkingen gedurende de gehele ontwikkelingslevenscyclus. De verwachte resultaten zijn:

- Herhaalbare processen met consistente resultaten.

- Langdurige nauwkeurigheid van de modellen in de loop van de tijd.

- Effectief beheer dat risico's minimaliseert.

- Wijzigingsbeheerprocessen voor aanpassing aan modeldrift.

Automatisering en bewaking zijn uw belangrijkste operationele strategieën om deze doelen te bereiken.

U moet ook gestandaardiseerde processen voor AI-onderdelen instellen, voor routine, ongeplande en noodoperaties, en de juiste traceringsmechanismen hebben. Zonder deze processen loopt u het risico op:

- Herhaalde fouten en niet-reproducibiliteit in gegevensverwerking, modelhosting, grondgegevensbeheer en andere taken.

- Lage kwaliteit of verouderde gegevens die worden gebruikt voor modeltraining en verfijning.

- Dit heeft gevolgen voor het vertrouwen van eindgebruikers in het systeem, in het ergste geval dat leidt tot juridische, nalevings- of beveiligingsproblemen.

U moet gevestigde processen implementeren met de juiste set hulpprogramma's. Er zijn gespecialiseerde hulpprogramma's beschikbaar voor het beheren van AI-/machine learning-werkstromen in omgevingen.

Dit artikel richt zich op de ontwerpstrategie voor bewerkingen en biedt aanbevelingen voor hulpprogramma's.

Aanbevelingen

Hier volgt een samenvatting van de aanbevelingen in dit artikel.

| Aanbeveling | Beschrijving |

|---|---|

| Ontwerp een efficiënte levenscyclus van workloadbewerkingen. | Op basis van de onderdelen van uw AI-workload zijn verschillende operationele fasen van toepassing op de levenscyclus. Het is belangrijk dat u de aanbevolen procedures begrijpt die relevant zijn voor uw scenario en de hulpprogramma's die voor u beschikbaar zijn om ze te implementeren. Neem de tijd om meer te weten te komen over en de belangrijkste aanbevelingen voor alle onderdelen van uw workload te implementeren. ▪ DataOps ▪ MLOps ▪ GenAIOps ▪ Monitoring |

| Automatiseer alles. | Automatisering zorgt voor herhaalbaarheid en efficiëntie in de levenscyclus van een workload. Hoewel DevOps-processen een belangrijke bijdrager zijn, zijn er extra stappen die u moet uitvoeren om uw modellen efficiënt te bouwen, testen, valideren en implementeren. ▪ Automatisering |

| Gebruik waar mogelijk implementatiepijplijnen. | Implementatiepijplijnen kunnen u helpen herhaalbare infrastructuurimplementaties te leveren of code continu te integreren. Ze zijn ook een uitstekend hulpmiddel voor het maken en/of valideren van modellen voordat ze naar productie worden gepromoot. Door implementatiepijplijnen te implementeren, kunt u de betrouwbaarheid en de algehele gebruikerservaring van uw workload verbeteren. ▪ Implementatiepijplijnen |

| Voorkom drift en verval in uw modellen. | U moet u beschermen tegen modelverval en -drift, terwijl u ook een gestructureerd proces hebt waarmee u nieuwe modelwijzigingen op een gecontroleerde manier kunt accepteren. Door de aanbevelingen voor modelonderhoud te volgen, kunt u voldoen aan het beleid, onverwachte gebruikerservaringen voorkomen en een actuelere service bieden. ▪ Modelonderhoud |

Levenscyclus van workloadbewerkingen

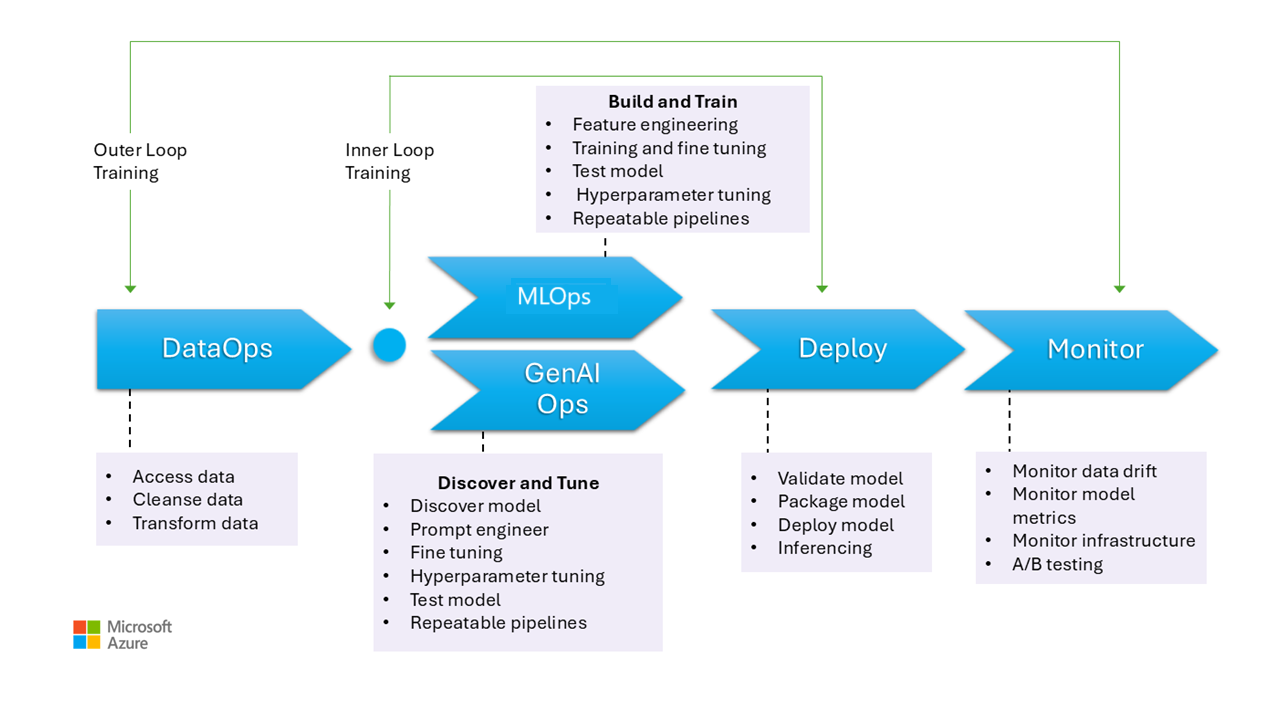

Deze afbeelding illustreert de operationele fasen voor AI-modellen, waaronder het verzamelen van gegevens, het opschonen van gegevens om inconsistenties of fouten te elimineren en gegevens te transformeren in een analyseerbare indeling. Deze fasen zijn relevant voor het trainen van zowel discriminerende modellen als grondgegevens in generatieve modellen. De specifieke use case van trainingsgeneratieve modellen wordt echter niet weergegeven in deze afbeelding. Deze use case valt buiten het bereik van dit artikel.

De fasen van MLOps en GenAIOps zijn vergelijkbaar. Het belangrijkste verschil is dat in het geval van GenAIOps de focus verschuift van training tot het selecteren van het juiste model, prompt engineering en het opnemen van domeinspecifieke kennis door middel van fine-tuning of implementatie van Retrieval Augmented Generation (RAG).

Zelfs de fasen voor het implementeren en bewaken zijn redelijk vergelijkbaar.

In de volgende secties worden de algemene operationele procedures beschreven. Ze hebben betrekking op elke fase van de levenscyclus, van preproductie tot productie.

DataOps

Gegevens worden samengevoegd uit verschillende productiegegevensbronnen en worden vervolgens vooraf verwerkt om fouten en inconsistenties te verwijderen en ontbrekende waarden te verwerken. Ten slotte wordt het getransformeerd en genormaliseerd in een geschikte indeling voor training of verrijking. Aspecten van het ontwerp worden beschreven in de artikelen trainingsgegevens en grondgegevens .

De processen voor gegevensbewerkingen tijdens deze fase moeten efficiënt zijn, omdat het verwerken van grote hoeveelheden gegevens uit meerdere bronnen en complexe gegevenspijplijnen lastig kan zijn. De benaderingen die u moet uitvoeren, moeten ervoor zorgen dat deze fase gegevens van hoge kwaliteit produceert. Bewaak deze fase om de voortgang van de acceptabele kwaliteitsbalk bij te houden.

U moet er ook voor zorgen dat gegevens veilig zijn, gezien het feit dat de gegevens afkomstig zijn van productie. Zorg ervoor dat lagere omgevingen, zoals Dev/Test, net zo veilig zijn als productie om beveiligingsproblemen te voorkomen.

Notitie

Verwerk gegevens van slechte kwaliteit door te investeren in uitgebreide gegevensschoonmaak tijdens de eerste fasen. Profiteer van de bekende analysepatronen, zoals medal networking, data mesh en functiearchieven, om upstreamverwerkingstaken uit te voeren. Als de upstream-fasen ineffectief zijn, moet u de kwaliteit tijdens de downstreamfasen verbeteren, wat leidt tot hogere workloadkosten omdat gegevensvoorbereiding plaatsvindt tijdens elke fase.

Zie de volgende artikelen voor meer informatie over gegevensverwerkingstaken:

Hulpprogramma's

U wordt aangeraden de hulpprogramma's voor gegevensindeling van uw workload te standaardiseren. De hulpprogramma's moeten een gegevenspijplijn kunnen bieden die activiteiten kan groeperen en die ingebouwde automatisering heeft.

Een Azure Data Factory-pijplijn kan een eerste keuze zijn. Het kan veel gegevensbronnen efficiënt verbinden en verwerken. U kunt ook Azure Synapse Analytics overwegen, waarbij big data en datawarehousing worden gecombineerd en data lakes, Apache Spark en Azure Synapse SQL worden ondersteund. Het kan ook worden geïntegreerd met Data Factory voor ETL.

Voor het voorbereiden van trainingsgegevens bieden Azure Machine Learning-pijplijnen gespecialiseerde functies waarmee taken zoals het verzamelen en verwerken van gegevens kunnen worden geautomatiseerd.

Opensource-technologieën zoals Pandas (voor gegevensvoorbereiding) en Scrapy zijn populaire keuzes.

MLOps

Modeltraining is het proces van het selecteren van de juiste algoritmen en het verstrekken van vooraf verwerkte historische gegevens en waarnemingen om het model in staat te stellen patronen te leren en voorspellingen te doen.

Het trainen van het model (functie-engineering) en het afstemmen van hyperparameters zijn iteratieve processen en ze zijn duur. Tijdens elke iteratie volgen gegevenswetenschappers resultaten met combinaties van gegevens, code en parameters. Gebruik herhaalbare pijplijnen om experimenten met minimale handmatige inspanning bij te houden totdat het juiste nauwkeurigheidsniveau is bereikt.

Een andere operationele uitdaging is het inrichten en schalen van gespecialiseerde rekenresources waar experimenten worden uitgevoerd. Bovendien moet u modellen efficiënt verpakken en publiceren.

Teams kunnen beginnen met ontwikkeling op basis van de gebruikersinterface om uitdagingen te verminderen en naarmate ze meer vertrouwen krijgen, kunt u overstappen op een op code gebaseerde benadering.

Hulpprogramma's

U wordt aangeraden hulpprogramma's te gebruiken waarmee machine learning-experimenten kunnen worden bijgehouden door details vast te leggen, zoals codeversies, omgevingen, parameters, uitvoeringen en resultaten. MLflow is een dergelijk opensource-framework. Overweeg het gebruik van Azure Machine Learning-werkruimten, die compatibel zijn met MLflow en een gestroomlijnde werkstroom bieden waarmee gegevenswetenschappers productiviteit en reproduceerbaarheid in hun projecten kunnen beheren. Als u codeontwikkeling wilt beheren met broncodebeheer, integreert u de machine learning-pijplijn met broncodebeheer, zoals GitHub, of gebruikt u bestandsshares.

Het hosten van compute kan ook invloed hebben op uw keuze van een werkstroomorchestrator. Als uw toepassing wordt gehost in Azure Kubernetes Service (AKS), kunt u Overwegen Om Kubeflow te gebruiken.

Als u Azure Machine Learning overweegt, raden we u aan om te beginnen met het perspectief van het Azure Well-Architected Framework op Machine Learning om ervoor te zorgen dat u begrijpt hoe het product u kan helpen met de kwaliteitsproblemen van het Well-Architected Framework van de workload.

Een deel van het voordeel van het proces is het optimaliseren van persoonlijke tijd. Gegevenswetenschappers hebben doorgaans specifieke hulpprogramma's en SDK's nodig om experimentele gegevensanalyse (EDA) en experimenten van hun werkstations effectief uit te voeren. Evalueer of vooraf gemaakte opties in Azure Machine Learning geschikt zijn. Zo niet, slaat u werkstationconfiguratie op of onderhoudt u goedgekeurde VM-installatiekopieën voor dit werk. Een voorbeeld van een installatiekopieën die u als uitgangspunt kunt gebruiken, is de Datawetenschap Virtual Machine (DSVM).

In bepaalde gevallen is het gebruik van VM's mogelijk niet toegestaan door beleid. Zoek naar alternatieven, zoals het toevoegen van Microsoft Dev Box en Azure Virtual Desktop. U kunt ook Docker gebruiken voor bootstrapmachines die vooraf gemaakte installatiekopieën bevatten.

Naarmate deze fase zich verder ontwikkeld en u uitgebreide experimenten nodig hebt, gaat u naar beheerde rekeninstanties en geeft u de voorkeur aan opties die zijn geïntegreerd als onderdeel van de werkstroom. Evalueer of u Azure Machine Learning-rekeninstanties kunt gebruiken voor training en deductie voor ontwikkelings- en testdoeleinden. De rekenclusters kunnen grote gegevenssets en complexe modellen verwerken.

Azure Machine Learning biedt zowel op code gebaseerde oplossingen via de SDK als opties voor weinig code, zoals geautomatiseerde machine learning en de visuele ontwerpfunctie. De Python SDK biedt meerdere manieren om modellen te trainen, elk met verschillende functies. Machine Learning ondersteunt ook geavanceerde optimalisatie- en gedistribueerde computingtechnologieën zoals DE ORTModule, DeepSpeed en LoRA van ONNX Runtime Training om het trainingsproces te versnellen.

GenAIOps

Belangrijke activiteiten tijdens deze fase beginnen met het detecteren en evalueren van bestaande modellen om een model te identificeren dat vooraf is getraind voor de specifieke use case. Dit is een iteratief proces. Nadat u een geschikt model hebt gevonden, kan het voordeel hebben dat het wordt verfijnd voor domeinspecifieke aarding, wat ook iteratieve stappen omvat en een bepaald niveau van indeling vereist.

Voor het integreren en implementeren van modellen zijn speciale hulpprogramma's en procedures vereist die verder gaan dan traditionele MLOps-mogelijkheden, waaronder het organiseren van modellen, vectorindexen, prompts en codeblokken.

Hulpprogramma's

Als u detectietaken wilt aanpakken, profiteert u van modelcatalogussen die modellen van verschillende providers bevatten. Met de modelcatalogus in de Azure AI Foundry Portal kunt u evalueren uit gecureerde verzamelingen en modellen efficiënt implementeren.

Azure Machine Learning-promptstroom kan helpen bij het ontwikkelen van indelingscode, het inschakelen van prototypen, experimenteren, itereren en prompt-engineering. Deze stromen kunnen worden geïmplementeerd in beheerde Azure Machine Learning-eindpunten. Evalueer of u de stromen kunt uitvoeren en implementeren met uw bestaande CI/CD-pijplijntechnologie.

Implementatie

Tijdens deze fase wordt het model geïmplementeerd op een hosting- en deductieplatform of de servicelaag van AI-workloads. De API's moeten worden verpakt als een schaalbare container. Het containerplatform kan een beheerd compute- of aangepast hostingplatform zijn. Operationele procedures moeten een veilige implementatie garanderen en terugdraaiacties inschakelen.

Begin met PaaS (Platform as a Service) en serverloze oplossingen zoals Azure OpenAI Service om de acceptatie en het beheer te vereenvoudigen. Overweeg om de serverloze API van Azure Machine Learning te gebruiken voor het aggregeren van eindpunttoegang. Beheerde rekenclusters zijn een haalbare optie voor geavanceerde behoeften. Zelfhosting op AKS is een andere optie. Zorg ervoor dat u de juiste grootte hebt voor uw rekenproces en dat u de juiste isolatie van andere werkbelastingen behoudt. U kunt ook opties overwegen, zoals het volledig hosten van uw model als IaaS (Infrastructure as a Service). IaaS biedt flexibiliteit, maar kan operationele lasten toevoegen. Deze opties worden beschreven in het toepassingsplatform.

Deze fase biedt de laatste kans om problemen te ondervangen voordat u het model naar productie verplaatst. Testprocessen moeten validatiestappen bevatten om ervoor te zorgen dat het model is geconfigureerd voor voorspellingen zoals verwacht.

U moet het model integreren in de bestaande productieomgeving door progressieve blootstellingsprocessen te volgen en side-by-side implementaties te gebruiken. Het canary-model is een veelgebruikte manier om nieuwe modellen uit te rollen. Met deze methode wordt het gebruikersbestand geleidelijk verhoogd. Blauwgroene implementatie is een andere methode.

Hulpprogramma's

U kunt Azure Machine Learning-pijplijnen of Azure Pipelines gebruiken om uw modellen te implementeren voor deductie. Machine Learning biedt verschillende functies voor vereenvoudigde bewerkingen, waaronder het inrichten van knooppunten, besturingssysteemupdates, automatisch schalen, bewaking en geïsoleerde virtuele netwerken.

Machine Learning biedt ook ondersteuning voor blauwgroene implementatie, waardoor één eindpunt meerdere implementaties kan bevatten.

Als u andere hostingplatforms gebruikt, zoals Azure Container Apps of Azure-app Service, bent u verantwoordelijk voor de bewerkingen, waaronder inrichten en schalen. Gebruik Azure DevOps, GitHub-pijplijnen of uw keuze voor CI/CD-technologie in die gevallen.

Controleren

Bewaking is een belangrijke strategie en wordt in alle fasen toegepast. Het is een doorlopend proces en fungeert als invoer voor kwaliteitspoorten die ervoor zorgen dat AI-workloads grondig worden getest om consistentie en betrouwbaarheid gedurende de gehele ontwikkelingslevenscyclus te behouden. Modellen moeten vanuit zowel operationele als gegevenswetenschapsperspectief worden bewaakt.

We raden u ten zeerste aan een DataOps inner loop-bewakingsproces te hebben dat de nabijheid van een acceptatiekwaliteitsbalk meet en controleert op afwijkingen.

Voor vooraf getrainde modellen is het ook belangrijk om gegevensdrift en prestaties te bewaken, met een primaire focus op relevantie. Evalueer de invoer (prompts) en de uitvoer (voltooiingen) om ervoor te zorgen dat ze relevant en nauwkeurig zijn. Houd ook rekening met beveiligingsrisico's, zoals pogingen om het gedrag van het model te manipuleren via schadelijke prompts. Zorg ervoor dat er grondige con tentmodus ration is die gegevens in beide richtingen inspecteert en ongepaste inhoud filtert. Deze overwegingen worden beschreven in het ontwerpgebied ResponsibleAI.

Na de implementatie zijn bewakingsbewerkingen nodig om problemen zoals modelverval op te lossen. Modellen kunnen verlopen vanwege wijzigingen in gegevens of externe wijzigingen waardoor het model irrelevante resultaten kan produceren. Als proactieve meting kunt u geautomatiseerde processen gebruiken voor continue bewaking en evalueren en opnieuw trainen om de nauwkeurigheid en relevantie te behouden. Daarnaast moet u de metrische gegevens van de infrastructuur en werkbelasting bewaken, net als bij elke andere workload, om optimale prestaties en betrouwbaarheid te garanderen. Zie Testen voor modelverval voor meer informatie.

Hulpprogramma's

Investeer in hulpprogramma's die het gemakkelijker maken om metrische gegevens te verzamelen van deductie-eindpunten, zoals Azure Machine Learning-gegevensverzamelaar.

U hebt ook waarneembaarheid nodig van modelprestaties, gegevensdrift en veiligheid en kwaliteit voor generatieve AI.

Lees deze artikelen voor meer informatie:

Automation

AI-workloads zijn complex omdat de algehele levenscyclus veel rollen, frequente wijzigingen en onderling gerelateerde stappen omvat. Handmatige processen kunnen gevoelig zijn voor fouten en inconsistenties. Automatisering bij het hosten van gegevensverwerkingsmodellen zorgt voor herhaalbaarheid en efficiëntie. Automatisering is niet altijd vereist, maar het is een effectieve manier om deze complexiteiten te beheren. Hier volgen enkele use cases waarin automatisering risico's kan beperken:

In tegenstelling tot traditionele code-implementatie vereisen niet-deterministische modellen en oplossingen in AI/machine learning iteratieve experimenten en training. Wanneer meerdere teams samenwerken, kan automatisering, als een manier om gestandaardiseerde processen af te dwingen, consistentie, reproduceerbaarheid en effectieve samenwerking tussen datawetenschappers, technici en operationele teams behouden.

De levenscyclus van het model omvat twee hoofdtypen training:

Onlinetraining bevat regelmatig recente gegevens in het model, soms dagelijks, om ervoor te zorgen dat beslissingen zijn gebaseerd op de meest recente informatie. Deze training is geïntegreerd in de workload, zodat het model continu wordt bijgewerkt als onderdeel van het reguliere proces.

Offlinetraining traint het model minder vaak, waardoor er een langere tussenruimte tussen updates ontstaat. Het trainingsproces is gescheiden van de hoofdworkload en wordt asynchroon uitgevoerd. Nadat het nieuwe model gereed is, wordt het vervolgens geïntegreerd in het systeem.

Betrouwbaarheid kan worden aangetast als updates niet vaak voorkomen. Als een update wordt gemist, kan deze worden uitgesteld zonder grote problemen. Dit concept is ook van toepassing op grondgegevens. Als u bijvoorbeeld RAG gebruikt, moet u beslissen of u recente gegevens moet gebruiken of als iets oudere gegevens voldoende zijn. Beide scenario's hebben betrekking op de behoefte aan actuele informatie met de praktische updatefrequentie. U moet online training uitvoeren via automatisering vanwege de frequentie en betrouwbaarheid die vereist zijn. Voor offlinetraining moet u, vanwege de vereiste frequentie, automatisering rechtvaardigen door een kosten-batenanalyse uit te voeren. Daarnaast kunt u offlinetrainingen uitvoeren met goedkopere resources, zoals offlinehardware.

Traditionele DevOps-processen worden doorgaans beïnvloed door structurele wijzigingen. In AI en machine learning worden modellen echter getraind op productiegegevens. Modelverval vormt een aanzienlijk risico en kan leiden tot verminderde prestaties in de loop van de tijd als het niet wordt bewaakt. Geautomatiseerde verzameling en analyse van metrische prestatiegegevens, waarschuwingen en het opnieuw trainen van modellen zijn vereist om de effectiviteit van het model te behouden. Gebruik automatisering op een manier waarmee u wijzigingen in gegevens- en modelafhankelijkheden kunt detecteren om op elk gewenst moment een duidelijk inzicht te krijgen in de huidige status.

Modellen kunnen worden getraind met twee verschillende benaderingen.

- De modellen worden getraind in de ontwikkelomgeving met volledige productiegegevens en alleen het artefact wordt gepromoveerd via omgevingen. Deze aanpak kan de rekenkosten verlagen, maar vereist een strakkere beveiliging voor het verwerken van productiegegevens in de lagere omgevingen en is mogelijk niet mogelijk in alle organisaties.

- Het model wordt getraind in elke omgeving. Codepromotie kan helpen bij stabiliteit omdat trainingscode wordt beoordeeld en getest in de lagere omgevingen, maar de rekenkosten verhoogt.

Aan beide benaderingen kleven voor- en nadelen. Het kiezen van de juiste benadering is afhankelijk van de prioriteiten van uw organisatie en de SDLC-procedures (Software Development Life Cycle) van uw organisatie. Ongeacht de methode zijn grondige tests en evaluatie van het model voordat de productie-implementatie essentieel is

Uw automatiseringscode moet gegevensherkomst bevatten ter ondersteuning van controlebaarheid door een duidelijke record van fasen voor gegevensverwerking te bieden. Deze record helpt u bij het beheren van verwachtingen en stelt u in staat om te laten zien hoe beslissingen zijn genomen, zodat u eventuele zorgen over resultaten kunt oplossen.

Implementatiepijplijnen

Bij AI-/machine learning-workloads omvat modelontwikkeling het maken, valideren en promoten van modellen voor het modelhostingplatform. Het is belangrijk om implementatiepijplijnen te hebben die complexe werkstromen stroomlijnen met betrekking tot gegevensverwerking, functie-engineering, modeltraining of uitbreiding en implementatie naar productie. Gezien de niet-deterministische aard van AI, waardoor processen ondoorzichtig worden, moet u kwalitatieve tests opnemen in releasepijplijnen en bewakingssystemen.

Hoewel MLOps en GenAIOps verschillende AI-activiteiten en kerntechnologieën kunnen vereisen, blijven de onderliggende concepten vergelijkbaar met die van DevOps. We raden u aan best practices toe te passen op basis van uw bestaande DevOps-processen. Integreer AI-activiteiten in de bestaande pijplijnen van uw workload.

Ai-workloads hebben doorgaans betrekking op traditionele code-implementaties. U kunt ervoor kiezen om modelimplementatie naast de code of afzonderlijk in een eigen levenscyclus af te handelen. De vroegere aanpak heeft de voorkeur. Wees voorbereid op het verpakken van modellen en deductie-eindpunten met workloadimplementatie om AI-bewerkingen voornamelijk gericht te houden op gegevensvoorbereiding, training/fine-tuning, grounding data management en bewaking.

Evalueer opnieuw hoe de volgende assets kunnen worden afgestemd op de volledige MLOps- en GenAIOps-levenscyclus, van preproductie tot productie:

- Hulpprogramma's voor Infrastructuur als code (IaC)

- CI/CD-pijplijnen

- De waarneembaarheidsstack voor het bijhouden en identificeren van problemen

Hulpprogramma's

U kunt Azure Pipelines en GitHub Actions-werkstromen, die vaak worden gebruikt voor CI/CD, uitbreiden naar machine learning-modellen. Ze helpen bij het implementeren van machine learning-infrastructuur, aangepaste workloadonderdelen, indelingscode en modellen. Combineer Azure Machine Learning-pijplijnen met Azure DevOps- of GitHub-pijplijnen. Zie Azure Pipelines gebruiken met Azure Machine Learning voor meer informatie.

Twee belangrijke factoren zijn van invloed op uw keuze van de juiste combinatie van hulpprogramma's: use case en mogelijkheden. Azure Machine Learning-pijplijnen zijn bijvoorbeeld ideaal voor de indeling die wordt uitgevoerd door gegevenswetenschappers. Het heeft een uitgebreide functieset die ondersteuning biedt voor hergebruik, caching en meer. Zie welke Azure-pijplijntechnologie moet ik gebruiken voor hulpprogramma's.

Modelonderhoud

Het AI/ML-landschap is concurrerend met doorlopende innovatie. Nieuwe modellen komen regelmatig voor, nieuwe use cases worden ontdekt en nieuwe gegevensbronnen worden beschikbaar. Als gevolg hiervan is modelverval een veelvoorkomende uitdaging.

Om te voorkomen dat modelprestaties afnemen of in de loop van de tijd afdrijven, moet u geautomatiseerde processen implementeren voor continue bewaking, evaluatie en hertraining. Voorbeeld:

Een modelcatalogus onderhouden. Automatiseer het proces van het detecteren van nieuwe modellen en het bijwerken van de catalogus.

Aanpassen aan nieuwe gebruiksvoorbeelden. Als er nieuwe gebruiksvoorbeelden worden toegevoegd aan de workloadvereisten, verwacht u de query's en past u de logica voor gegevensverwerking dienovereenkomstig aan.

Nieuwe gegevensbronnen opnemen. Als nieuwe gegevensbronnen de voorspellende kracht of relevantie van uw model kunnen verbeteren, werkt u de pijplijn voor gegevensopname bij om verbinding te maken met en gegevens op te halen uit deze bronnen.

Beoordeel de naleving van wettelijke vereisten. Wanneer u zich aanpast aan nieuwe mogelijkheden, moet u ervoor zorgen dat wijzigingen geldig blijven binnen de beperkingen van de organisatie- of externe nalevingsstandaarden.

Implementeer een formeel proces voor het bijhouden van continue verbetering en neem zelfverbetering op als subproces binnen die cyclus.

Continue evolutie

Controleer en verbeter de activiteiten regelmatig en moedig innovatie aan.

Het MLOps-volwassen model verloopt van handmatige processen tot volledige automatisering. Begin met handmatige builds en bewaking en integreer geautomatiseerde toepassings builds, trainingsomgevingen en implementatie in fasen, zoals gerechtvaardigd door uitgebreide metrische gegevens. Zie mlOps-volwassenheidsmodel voor meer informatie.

De genAIOps-volwassenheidsniveaus gaan van basismodellen naar gestructureerde implementatie, waarbij gebruik wordt gemaakt van geautomatiseerde optimalisatietechnieken. Zie Uw vervaldatum voor GenAIOps verdergaan voor meer informatie.