Verantwoorde AI in Azure-workloads

Het doel van verantwoorde AI bij het ontwerpen van workloads is ervoor te zorgen dat het gebruik van AI-algoritmen eerlijke, transparanteen inclusieveis. Microsoft Azure Well-Architected Framework-beveiligingsprincipes zijn onderling verbonden en richten zich op vertrouwelijkheid en integriteit. Er moeten beveiligingsmaatregelen worden getroffen om de privacy van gebruikers te behouden, gegevens te beschermen en de integriteit van het ontwerp te waarborgen. Het ontwerp mag niet worden misbruikt voor onbedoelde doeleinden.

In AI-workloads gebruiken modellen vaak ondoorzichtige logica om beslissingen te nemen. Gebruikers moeten de functionaliteit van het systeem vertrouwen en vertrouwen hebben dat modellen deze beslissingen op verantwoorde wijze nemen. Onacceptabel gedrag, zoals manipulatie, inhoudsvergiftiging, IP-inbreuk en ge fabriceerde reacties, moet worden voorkomen.

Overweeg een use-case waarin een media-entertainmentbedrijf aanbevelingen wil doen met behulp van AI-modellen. Als het bedrijf geen verantwoorde AI en de juiste beveiligingsprotocollen implementeert, kan een slechte actor de controle over de modellen overnemen. Het model kan inhoud aanbevelen die schade veroorzaakt. Voor de organisatie kan dit gedrag leiden tot merkschade, onveilige omgevingen en juridische problemen. Daarom is het handhaven van passende waakzaamheid gedurende de levenscyclus van het systeem essentieel en ononderhandelbaar.

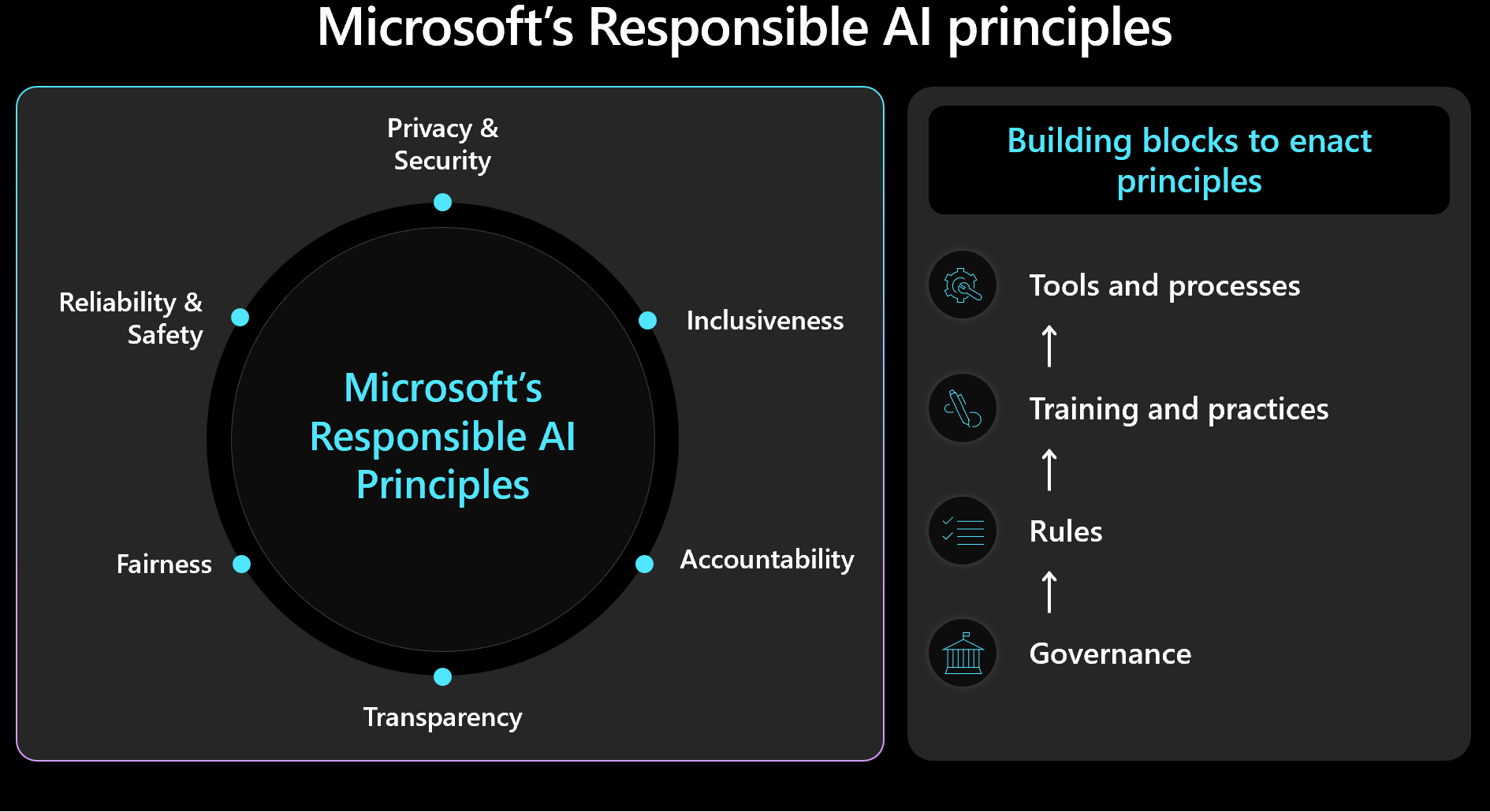

U moet prioriteit geven aan beveiligings- en workloadbeheer en menselijke resultaten in gedachten houden wanneer u ontwerpbeslissingen neemt. Raak vertrouwd met het Microsoft-framework voor verantwoorde AI- en zorg ervoor dat u de principes van het framework in uw ontwerp meet en implementeert. In de volgende afbeelding ziet u de belangrijkste concepten van het framework.

Belangrijk

De nauwkeurigheid van voorspellingen en de metrische gegevens voor verantwoorde AI zijn doorgaans onderling verbonden. Door de nauwkeurigheid van een model te verbeteren, kunt u de redelijkheid en afstemming met de realiteit verbeteren. Verantwoordelijke AI is vaak afgestemd op nauwkeurigheid, maar alleen nauwkeurigheid bevat niet alle veiligheidsoverwegingen. Het is van cruciaal belang om deze principes op verantwoorde wijze te valideren.

Dit artikel bevat aanbevelingen over verantwoorde besluitvorming, het valideren van gebruikersinvoer en het garanderen van een veilige gebruikerservaring. Het biedt ook richtlijnen over gegevensbeveiliging om gebruikersgegevens te beschermen.

Aanbevelingen

De volgende tabel bevat een overzicht van de aanbevelingen in dit artikel.

| Aanbeveling | Beschrijving |

|---|---|

| Beleid ontwikkelen dat morele praktijken afdwingt in elke fase van de levenscyclus. | Voeg controlelijstitems toe die expliciet de veiligheidsvereisten aangeven en die zijn afgestemd op de workloadcontext. Voorbeelden hiervan zijn transparantie van gebruikersgegevens, toestemmingsconfiguratie en procedures voor het afhandelen van het recht om te worden vergeten (RTBF). ▪ Uw beleid ontwikkelen voor verantwoorde AI- ▪ Afdwingen van governance op beleid voor verantwoorde AI |

| Gebruikersgegevens beveiligen met het doel om de privacy te maximaliseren. | Verzamel alleen wat nodig is en met de juiste gebruikerstoestemming. Pas technische besturingselementen toe om de profielen van gebruikers, hun gegevens en toegang tot die gegevens te beveiligen. ▪ gebruikersgegevens op de juiste wijze verwerken ▪ Binnenkomende en uitgaande gegevens controleren |

| AI-beslissingen helder en begrijpelijk houden. | Leg duidelijk uit hoe aanbevelingsalgoritmen werken. Gebruikers inzicht geven in gegevensgebruik en algoritmische beslissingen om hen te helpen het proces te begrijpen en erop te vertrouwen. ▪ De gebruikerservaring veilig maken |

Beleid ontwikkelen voor verantwoorde AI

Documenteer uw benadering voor verantwoord AI-gebruik. Vermeld expliciet beleidsregels die u toepast in elke fase van de levenscyclus, zodat het workloadteam de verantwoordelijkheden begrijpt. Microsoft-standaarden voor verantwoorde AI bieden richtlijnen, maar u moet definiëren wat deze richtlijnen specifiek betekenen voor uw context.

Het beleid moet bijvoorbeeld controlelijstitems bevatten voor mechanismen die transparantie van gebruikersgegevens en toestemmingsconfiguratie ondersteunen. In het ideale geval moeten deze mechanismen toestaan dat gebruikers zich afmelden voor gegevensopname. Gegevenspijplijnen, analyses, modeltraining en andere fasen moeten die keuze respecteren. Een ander voorbeeld zijn procedures voor het afhandelen van de RTBF. Neem contact op met de ethische afdeling en het juridische team van uw organisatie om weloverwogen beslissingen te nemen.

Maak transparant beleid voor gegevensgebruik en algoritmebeslissing om gebruikers te helpen het proces te begrijpen en te vertrouwen. Documenteer deze beslissingen om een duidelijke geschiedenis te behouden voor mogelijke toekomstige juridische procedures.

Verantwoorde AI-implementatie omvat drie belangrijke rollen: het onderzoeksteam, het beleidsteam en het technische team. Samenwerking tussen deze teams moet operationeel zijn. Als uw organisatie een bestaand team heeft, gebruikt u hun werk. Anders kunt u deze procedures zelf instellen.

Elk team moet zijn eigen verantwoordelijkheden hebben. Bijvoorbeeld:

Het onderzoeksteam voert risicodetectie uit door advies te geven over de richtlijnen van de organisatie, industriestandaarden, wetten, voorschriften en bekende tactieken van rode teams.

Het beleidsteam ontwikkelt beleidsregels die specifiek zijn voor de workload. Ze bevatten richtlijnen van de bovenliggende organisatie en overheidsvoorschriften.

Het technische team implementeert het beleid in hun processen en producten. Het team valideert en test op naleving.

Elk team formaliseert de richtlijnen, maar het workloadteam moet verantwoordelijk zijn voor zijn eigen gedocumenteerde procedures. Het team moet duidelijk eventuele extra stappen of opzettelijke afwijkingen documenteren om ervoor te zorgen dat er geen dubbelzinnigheid is over wat is toegestaan. Het team moet ook transparant zijn over mogelijke tekortkomingen of onverwachte resultaten in de oplossing.

Het afdwingen van governance op beleid voor verantwoorde AI

Ontwerp uw workload om te voldoen aan organisatie- en regelgevingsbeheer. Als transparantie bijvoorbeeld een organisatievereiste is, bepaalt u hoe deze van toepassing is op uw workload. Identificeer gebieden in uw ontwerp, levenscyclus, code of andere onderdelen waar u transparantiefuncties moet introduceren om aan die standaard te voldoen.

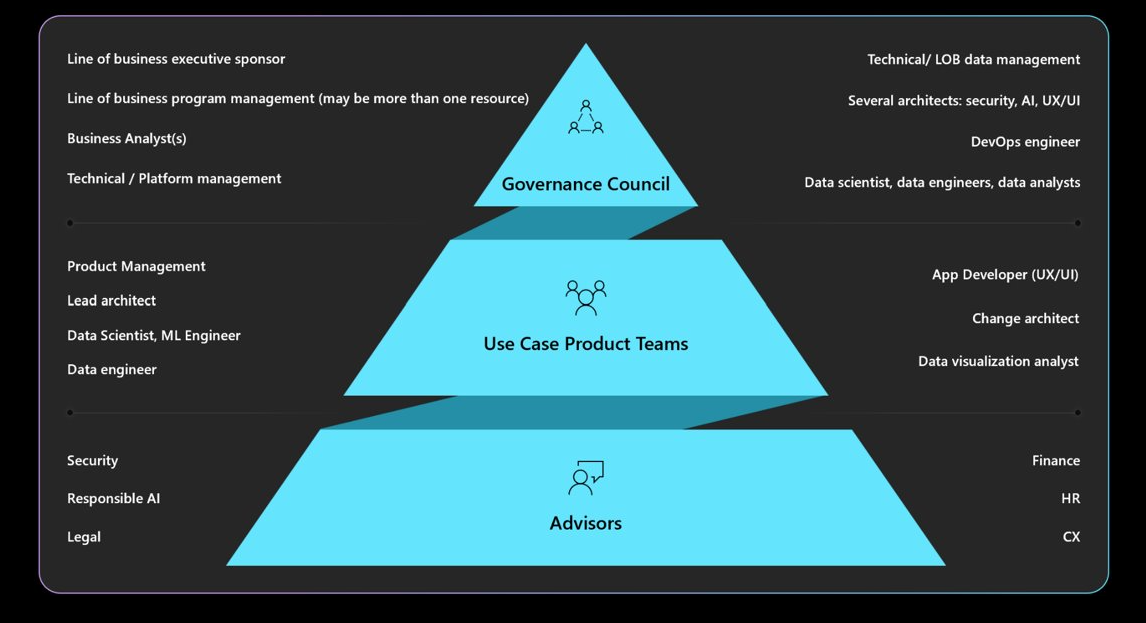

Inzicht in de vereiste governance, verantwoordelijkheid, beoordelingsborden en rapportagemandaten. Zorg ervoor dat uw governanceraad de werkbelastingontwerpen goedkeurt en aftekent om herontwerpen te voorkomen en de risico's op veiligheids- of privacyproblemen te beperken. Mogelijk moet u meerdere goedkeuringslagen doorlopen. In het volgende diagram ziet u een typische governancestructuur in een organisatie.

Zie Een verantwoorde AI-strategie definiërenvoor meer informatie over organisatiebeleid en goedkeurders.

De gebruikerservaring veilig maken

Gebruikerservaringen moeten zijn gebaseerd op brancherichtlijnen. Gebruik de Microsoft Human-AI Experiences Design Library, die principes bevat en implementatierichtlijnen biedt. Het bevat ook voorbeelden van Microsoft-producten en andere industriële bronnen.

Er zijn workloadverantwoordelijkheden gedurende de levenscyclus van gebruikersinteractie. Ze beginnen met de bedoeling van een gebruiker om het systeem te gebruiken en ze blijven gedurende een sessie en tijdens eventuele onderbrekingen die systeemfouten veroorzaken. Houd rekening met de volgende procedures:

Maak transparantie. Gebruikers op de hoogte stellen van hoe het systeem reacties op hun query genereert.

Voeg koppelingen toe naar gegevensbronnen die door het model worden geraadpleegd voor voorspellingen. Deze praktijk verhoogt het vertrouwen van gebruikers door de oorsprong van de informatie weer te geven. Gegevensontwerp moet deze bronnen bevatten in de metagegevens. Wanneer de orchestrator in een uitgebreide toepassing voor ophalen bijvoorbeeld een zoekopdracht uitvoert, worden er 20 documentsegmenten opgehaald en worden de bovenste 10 segmenten als context naar het model verzonden. De top 10 segmenten behoren tot drie verschillende documenten. De gebruikersinterface kan vervolgens verwijzen naar deze drie brondocumenten wanneer het antwoord van het model wordt weergegeven. Deze transparantie verhoogt het vertrouwen van gebruikers.

Transparantie wordt belangrijker wanneer u agents gebruikt, die fungeren als tussenpersonen tussen front-endinterfaces en back-endsystemen. In een ticketsysteem interpreteert de indelingscode bijvoorbeeld de intentie van de gebruiker en maakt API-aanroepen (Application Programming Interface) naar agents om de benodigde informatie op te halen. Door deze interacties beschikbaar te maken, kan de gebruiker op de hoogte worden van de acties van het systeem.

Voor geautomatiseerde werkstromen die meerdere agents bevatten, maakt u logboekbestanden die elke stap registreren. Logboekbestanden kunnen u helpen bij het identificeren en corrigeren van fouten. Ze geven gebruikers ook een uitleg over beslissingen, die transparantie operationeel maken.

Let op

Wanneer u aanbevelingen voor transparantie implementeert, voorkomt u dat de gebruiker te veel informatie heeft. Neem een geleidelijke benadering door minimale verstorende UI-methoden te gebruiken.

Geef bijvoorbeeld knopinfo weer die een betrouwbaarheidsscore van het model weergeeft. U kunt koppelingen opnemen, zoals koppelingen naar brondocumenten, die gebruikers kunnen selecteren voor meer informatie. Met deze door de gebruiker geïnitieerde methode blijft de gebruikersinterface niet-onderbreekbaar en kunnen gebruikers alleen meer informatie zoeken als ze ervoor kiezen.

Feedback verzamelen. Feedbackmechanismen implementeren.

Vermijd overweldigende gebruikers met uitgebreide vragenlijsten na elk antwoord. Gebruik in plaats daarvan snelle en eenvoudige feedbackmechanismen, zoals duim omhoog of duim omlaag, of een beoordelingssysteem voor specifieke aspecten van het antwoord op een schaal van 1 tot 5. Deze methoden helpen het systeem in de loop van de tijd te verbeteren en gedetailleerde feedback mogelijk te maken zonder intrusief te zijn. Houd rekening met mogelijke redelijkheidsproblemen in feedback, omdat er mogelijk secundaire redenen zijn achter reacties van gebruikers.

Het implementeren van een feedbackmechanisme is van invloed op de architectuur vanwege de noodzaak van gegevensopslag. Behandel feedback zoals gebruikersgegevens en pas zo nodig niveaus van privacybeheer toe.

U kunt niet alleen feedback geven, maar ook feedback verzamelen over de effectiviteit van de gebruikerservaring. Verzamel metrische gegevens over betrokkenheid via uw bewakingsstack van het systeem.

Veiligheidsmaatregelen voor inhoud operationeel maken

Integreer inhoudsveiligheid in elke fase van de AI-levenscyclus met behulp van aangepaste oplossingscode, geschikte hulpprogramma's en effectieve beveiligingsprocedures. Houd rekening met de volgende strategieën:

Gegevens anoniem maken. Naarmate gegevens van opname naar training of evaluatie worden verplaatst, implementeert u controles onderweg om het risico op lekken van persoonlijke gegevens te minimaliseren en blootstelling van onbewerkte gebruikersgegevens te voorkomen.

Inhoud modereren. Gebruik de API voor inhoudsveiligheid waarmee aanvragen en antwoorden in realtime worden geëvalueerd. Zorg ervoor dat deze API's bereikbaar zijn.

Bedreigingen identificeren en beperken. Pas bekende beveiligingsprocedures toe op uw AI-scenario's. Voer bijvoorbeeld bedreigingsmodellering uit en documenteer vervolgens de bedreigingen en hoe u ze hebt beperkt. Typische beveiligingsprocedures, zoals rode teamoefeningen, zijn van toepassing op AI-workloads. Rode teams kunnen testen of modellen kunnen worden gemanipuleerd om schadelijke inhoud te genereren. Deze activiteiten moeten worden geïntegreerd in AI-bewerkingen.

Voor meer informatie, zie Plan red teaming voor grote taalmodellen en hun toepassingen.

Gebruik de juiste metrische gegevens. Gebruik metrische gegevens waarmee het gedrag van het model effectief wordt gemeten. Metrische gegevens variëren, afhankelijk van het type AI-model. In sommige gevallen is het meten van generatieve modellen mogelijk niet van toepassing op regressiemodellen. Een model voorspelt bijvoorbeeld de levensverwachting en de resultaten zijn van invloed op de verzekeringstarieven. Getrouwheidsproblemen in dit model kunnen leiden tot getrouwheidsgerelateerde schade. Dit probleem komt voort uit afwijkingen in kerntests voor metrische gegevens, omdat metrische gegevens voor redelijkheid en nauwkeurigheid doorgaans onderling zijn verbonden. Verbeter de nauwkeurigheid om eerlijkheidsgerelateerde schade te verminderen.

Voeg de juiste instrumentatie toe. Resultaten van AI-modellen moeten kunnen worden uitgelegd. U moet rechtvaardigen en traceren hoe deducties worden gemaakt, inclusief de trainingsgegevens, de berekende kenmerken en de grondgegevens. In discriminerende AI kunt u stap voor stap beslissingen rechtvaardigen. Voor generatieve modellen kan het uitleggen van resultaten echter complex zijn. Documenteer het besluitvormingsproces om potentiële juridische implicaties aan te pakken en transparantie te bieden.

U moet dit aspect van de uitleg in de hele LEVENSCYCLUS van AI implementeren. Gegevens opschonen, herkomst, selectiecriteria en verwerking zijn essentiële fasen waar beslissingen moeten worden bijgehouden.

Hulpprogramma's

Integreer hulpprogramma's voor inhoudsveiligheid en gegevenstraceerbaarheid, zoals Microsoft Purview-. Azure AI Content Safety API's kunnen worden aangeroepen vanuit uw test om het testen van inhoudsveiligheid te vergemakkelijken.

Azure AI Foundry biedt metrische gegevens die het gedrag van het model evalueren. Zie Evaluatie- en bewakingsgegevens voor generatieve AI voor meer informatie.

Zie voor trainingsmodellen de metriek die Azure Machine Learning biedt.

Binnenkomende en uitgaande gegevens controleren

Promptinjectieaanvallen, zoals jailbreaking, zijn een veelvoorkomende zorg voor AI-workloads. In dit geval proberen sommige gebruikers het model te misbruiken voor onbedoelde doeleinden. Om de veiligheid te waarborgen, gegevens inspecteren om aanvallen te voorkomen en ongepaste inhoud te filteren. Pas deze analyse toe op zowel de invoer van de gebruiker als de antwoorden van het systeem om een grondige inhoudsbeheer in binnenkomende stromen en uitgaande stromen te garanderen.

In sommige gevallen moet u meerdere model-aanroepen uitvoeren, zoals via Azure OpenAI Service, om één clientaanvraag uit te voeren. In deze scenario's kan het toepassen van veiligheidscontroles op inhoud voor elke aanroep kostbaar en onnodig zijn. Overweeg het centraliseren van die werkzaamheden in de architectuur en tegelijkertijd de beveiliging als een verantwoordelijkheid aan de serverzijde te houden. Stel dat een architectuur een gateway heeft vóór het eindpunt van de modeldeductie om specifieke back-endmogelijkheden te offloaden. U kunt die gateway ontwerpen voor het afhandelen van inhoudsveiligheidscontroles voor aanvragen en antwoorden die de back-end mogelijk niet van nature ondersteunt. Hoewel een gateway een algemene oplossing is, kan een orkestratielaag deze taken effectief uitvoeren in eenvoudigere architecturen. In beide gevallen kunt u deze controles selectief toepassen wanneer dat nodig is, waardoor de prestaties en kosten worden geoptimaliseerd.

Inspecties moeten multimodaal zijn en verschillende formaten omvatten. Wanneer u multimodale invoer gebruikt, zoals afbeeldingen, is het belangrijk om ze te analyseren op verborgen berichten die schadelijk of gewelddadig kunnen zijn. Deze berichten zijn mogelijk niet direct zichtbaar, zodat ze zorgvuldig moeten worden gecontroleerd. Gebruik hiervoor hulpprogramma's zoals Content Safety-API's.

Om te helpen bij het afdwingen van privacy- en gegevensbeveiligingsbeleid, inspecteert u gebruikersgegevens en grondgegevens voor naleving van privacyvoorschriften. Zorg ervoor dat de gegevens zijn opgeschoond of gefilterd terwijl deze door het systeem stromen. Gegevens uit eerdere gesprekken van klantenondersteuning kunnen bijvoorbeeld dienen als basisgegevens. Deze gegevens moeten worden opgeschoond voordat ze opnieuw worden gebruikt.

Gebruikersgegevens op de juiste manier verwerken

Verantwoorde procedures omvatten zorgvuldige verwerking van gebruikersgegevensbeheer. Dit beheer omvat het weten wanneer gegevens moeten worden gebruikt en wanneer u moet voorkomen dat gebruikersgegevens worden gebruikt.

Oefen deductie zonder gebruikersgegevens te delen. Als u gebruikersgegevens veilig wilt delen met andere organisaties voor inzichten, gebruikt u een clearinghouse-model. In dit scenario bieden organisaties gegevens aan een vertrouwde partner die het model traint met behulp van de geaggregeerde gegevens. Vervolgens kunnen alle instellingen dit model gebruiken en inzichten delen zonder afzonderlijke gegevenssets weer te geven. Het doel is om de deductiemogelijkheden van het model te gebruiken zonder gedetailleerde trainingsgegevens te delen.

Promoot diversiteit en inclusiviteit. Wanneer gebruikersgegevens nodig zijn, gebruik een breed scala aan gegevens, inclusief genres en makers die ondervertegenwoordigd zijn, om eerlijkheidsgerelateerde schade te verminderen. Implementeer functies die gebruikers aanmoedigen om nieuwe en gevarieerde inhoud te verkennen. Bewaak het gebruik doorlopend en pas aanbevelingen aan om te voorkomen dat één inhoudstype te veel wordt weergegeven.

Respecteer de RTBF. Vermijd het gebruik van gebruikersgegevens indien mogelijk. Zorg ervoor dat de RTBF wordt nageleefd door de nodige maatregelen te treffen om ervoor te zorgen dat gebruikersgegevens zorgvuldig worden verwijderd.

Om naleving te waarborgen, kunnen er aanvragen zijn om gebruikersgegevens uit het systeem te verwijderen. Voor kleinere modellen kunt u gebruikersgegevens verwijderen door het model opnieuw te trainen met behulp van gegevens die persoonlijke gegevens uitsluiten. Voor grotere modellen, die kunnen bestaan uit verschillende kleinere, onafhankelijk getrainde modellen, is het proces complexer en zijn de kosten en inspanning aanzienlijk. Zoek juridische en ethische richtlijnen voor het afhandelen van deze situaties en zorg ervoor dat u de richtlijnen in uw beleid voor verantwoorde AI-opneemt.

Gegevens op verantwoorde wijze bewaren. Wanneer het verwijderen van gegevens niet mogelijk is, vraagt u expliciete gebruikerstoestemming voor het verzamelen van gegevens en geeft u duidelijk privacybeleid op. Verzamel en bewaar alleen gegevens wanneer dit absoluut noodzakelijk is. Zorg ervoor dat er bewerkingen worden uitgevoerd om gegevens agressief te verwijderen wanneer deze niet meer nodig zijn. U kunt bijvoorbeeld de chatgeschiedenis wissen zodra dit praktisch is en gevoelige gegevens anoniem maken voordat ze worden bewaard. Gebruik geavanceerde versleutelingsmethoden voor deze gegevens in rust.

Ondersteun uitlegbaarheid. Traceer beslissingen in het systeem om uitlegvereisten te ondersteunen. Ontwikkel duidelijke uitleg over hoe aanbevelingsalgoritmen werken. Geef gebruikers inzicht in waarom specifieke inhoud aan hen wordt aanbevolen. Het doel is ervoor te zorgen dat AI-workloads en hun resultaten transparant en rechtvaardig zijn door te beschrijven hoe ze beslissingen nemen, welke gegevens ze gebruiken en hoe modellen zijn getraind.

Gebruikersgegevens versleutelen. Invoergegevens moeten in elke fase van de pijplijn voor gegevensverwerking worden versleuteld vanaf het moment dat de gebruiker gegevens invoert. Deze fasen omvatten gegevens als ze van het ene punt naar het andere bewegen, gegevens die worden opgeslagen en gegevens die, indien nodig, worden geïnterpreteerd. Balans tussen beveiliging en functionaliteit en doel om gegevens gedurende de hele levenscyclus privé te houden.

Sterke toegangscontroles bieden. Verschillende typen identiteiten hebben mogelijk toegang tot gebruikersgegevens. Implementeer op rollen gebaseerd toegangsbeheer voor zowel het besturingsvlak als het gegevensvlak, zodat gebruikers- en systeem-naar-systeemcommunicatie worden behandeld.

Behoud de juiste gebruikerssegmentatie om privacy te beschermen. Microsoft 365 Copilot kan bijvoorbeeld zoeken en antwoorden geven op basis van de specifieke documenten en e-mailberichten van een gebruiker, terwijl alleen inhoud die relevant is voor die gebruiker, toegankelijk is.

Beperk het oppervlak. Een fundamentele strategie van de pijler Well-Architected Framework Security is het minimaliseren van het aanvalsoppervlak en het versterken van resources. U moet deze strategie toepassen op standaardprocedures voor eindpuntbeveiliging door API-eindpunten nauw te beheren, alleen essentiële gegevens weer te geven en overbodige informatie in reacties te voorkomen. Balans tussen de ontwerpkeuze tussen flexibiliteit en controle.

Zorg ervoor dat er geen anonieme eindpunten zijn. Over het algemeen moet u voorkomen dat gebruikers meer controle hebben dan nodig is. In de meeste scenario's hoeven gebruikers geen hyperparameters aan te passen, behalve in experimentele omgevingen. Voor typische gebruiksvoorbeelden, zoals interactie met een virtuele agent, moeten gebruikers alleen essentiële aspecten beheren om de beveiliging te waarborgen door onnodig beheer te beperken.

Zie Toepassingsontwerp voor AI-workloads in Azurevoor meer informatie.