Inhoud filteren in De Azure AI Foundry-portal

Azure AI Foundry bevat een inhoudsfiltersysteem dat naast kernmodellen en DALL-E-modellen voor het genereren van installatiekopieën werkt.

Belangrijk

Het inhoudsfiltersysteem wordt niet toegepast op prompts en voltooiingen die worden verwerkt door het Whisper-model in Azure OpenAI Service. Meer informatie over het Fluistermodel in Azure OpenAI.

Hoe het werkt

Dit inhoudsfiltersysteem wordt mogelijk gemaakt door Azure AI Content Safety en werkt door zowel de promptinvoer- als voltooiingsuitvoer uit te voeren via een ensemble van classificatiemodellen die zijn gericht op het detecteren en voorkomen van de uitvoer van schadelijke inhoud. Variaties in API-configuraties en toepassingsontwerp kunnen van invloed zijn op voltooiingen en dus filtergedrag.

Met Azure OpenAI-modelimplementaties kunt u het standaardinhoudsfilter gebruiken of uw eigen inhoudsfilter maken (verderop beschreven). Het standaardinhoudsfilter is ook beschikbaar voor andere tekstmodellen die worden samengesteld door Azure AI in de modelcatalogus, maar aangepaste inhoudsfilters zijn nog niet beschikbaar voor deze modellen. Modellen die beschikbaar zijn via Models as a Service , zijn standaard ingeschakeld voor inhoudsfiltering en kunnen niet worden geconfigureerd.

Taalondersteuning

De inhoudsfiltermodellen zijn getraind en getest op de volgende talen: Engels, Duits, Japans, Spaans, Frans, Italiaans, Portugees en Chinees. De service kan echter in veel andere talen werken, maar de kwaliteit kan variëren. In alle gevallen moet u uw eigen tests uitvoeren om ervoor te zorgen dat deze werkt voor uw toepassing.

Risicofilters voor inhoud (invoer- en uitvoerfilters)

De volgende speciale filters werken voor zowel invoer als uitvoer van generatieve AI-modellen:

Categorieën

| Categorie | Beschrijving |

|---|---|

| Haten | De haatcategorie beschrijft taalaanvallen of toepassingen die pejoratieve of discriminerende taal omvatten met verwijzing naar een persoon of identiteitsgroep op basis van bepaalde differentiërende kenmerken van deze groepen, waaronder maar niet beperkt tot ras, etniciteit, nationaliteit, genderidentiteit en expressie, seksuele oriëntatie, religie, immigratiestatus, vaardigheidsstatus, persoonlijk uiterlijk en lichaamsgrootte. |

| Seksueel | De seksuele categorie beschrijft taal met betrekking tot anatomische organen en geslachtsdelen, romantische relaties, handelingen die worden weergegeven in erotische of genegenheidsvoorwaarden, fysieke seksuele handelingen, waaronder die afgebeeld als een aanval of een gedwongen seksuele gewelddadige daad tegen wil, prostitutie, pornografie en misbruik. |

| Geweld | De categorie geweld beschrijft taal met betrekking tot fysieke acties die bedoeld zijn om iemand of iets te kwetsen, verwonden, beschadigen of doden; beschrijft wapens, enz. |

| Zelfschade | In de categorie zelfschade wordt de taal beschreven die betrekking heeft op fysieke acties die bedoeld zijn om opzettelijk pijn te doen, verwonden of schade toebrengen aan het lichaam of om zichzelf te doden. |

Ernstniveaus

| Categorie | Beschrijving |

|---|---|

| Safe | Inhoud kan betrekking hebben op geweld, zelfbeschadiging, seksueel of haatcategorieën, maar de termen worden gebruikt in het algemeen, journalistische, wetenschappelijke, medische en vergelijkbare professionele contexten, die geschikt zijn voor de meeste doelgroepen. |

| Beperkt | Inhoud die vooroordelen, beoordelings- of meningsweergaven uitdrukt, omvat aanstootgevend taalgebruik, stereotiep, use cases die een fictieve wereld verkennen (bijvoorbeeld gaming, literatuur) en afbeeldingen met een lage intensiteit. |

| Gemiddeld | Inhoud die gebruikmaakt van aanstootgevende, beledigende, beledigende, intimiderende of vernederende taal voor specifieke identiteitsgroepen, bevat afbeeldingen van het zoeken en uitvoeren van schadelijke instructies, fantasieën, verheerlijking, bevordering van schade bij gemiddelde intensiteit. |

| Hoog | Inhoud die expliciete en ernstige schadelijke instructies, acties, schade of misbruik weergeeft; omvat goedkeuring, verheerlijking of bevordering van ernstige schadelijke handelingen, extreme of illegale vormen van schade, radicalisering of niet-onsensuele machtsuitwisseling of misbruik. |

Andere invoerfilters

U kunt ook speciale filters inschakelen voor generatieve AI-scenario's:

- Jailbreak-aanvallen: Jailbreak-aanvallen zijn gebruikersprompts die zijn ontworpen om het Generatieve AI-model te veroorzaken in het vertonen van gedrag dat is getraind om de regels die zijn ingesteld in het systeembericht te vermijden of te verbreken.

- Indirecte aanvallen: indirecte aanvallen, ook wel indirecte promptaanvallen of aanvallen tussen domeinprompts genoemd, zijn een potentieel beveiligingsprobleem waarbij derden schadelijke instructies plaatsen in documenten die het Generatieve AI-systeem kan openen en verwerken.

Andere uitvoerfilters

U kunt ook de volgende speciale uitvoerfilters inschakelen:

- Beschermd materiaal voor tekst: Beveiligde materiaaltekst beschrijft bekende tekstinhoud (bijvoorbeeld liedteksten, artikelen, recepten en geselecteerde webinhoud) die kan worden uitgevoerd door grote taalmodellen.

- Beveiligd materiaal voor code: met beveiligde materiaalcode wordt broncode beschreven die overeenkomt met een set broncode uit openbare opslagplaatsen, die kan worden uitgevoerd door grote taalmodellen zonder de juiste bronvermelding van bronopslagplaatsen.

- Geaardheid: Het aardingsdetectiefilter detecteert of de tekstreacties van grote taalmodellen (LLM's) worden geaard in de bronmaterialen die door de gebruikers worden geleverd.

Een inhoudsfilter maken in Azure AI Foundry

Voor elke modelimplementatie in Azure AI Foundry kunt u het standaardinhoudsfilter rechtstreeks gebruiken, maar misschien wilt u meer controle hebben. U kunt bijvoorbeeld een filter strenger of flexibeler maken of geavanceerdere mogelijkheden inschakelen, zoals promptschilden en beveiligde materiaaldetectie.

Tip

Voor hulp bij inhoudsfilters in uw Azure AI Foundry-project kunt u meer lezen op Azure AI Foundry-inhoudsfilters.

Volg deze stappen om een inhoudsfilter te maken:

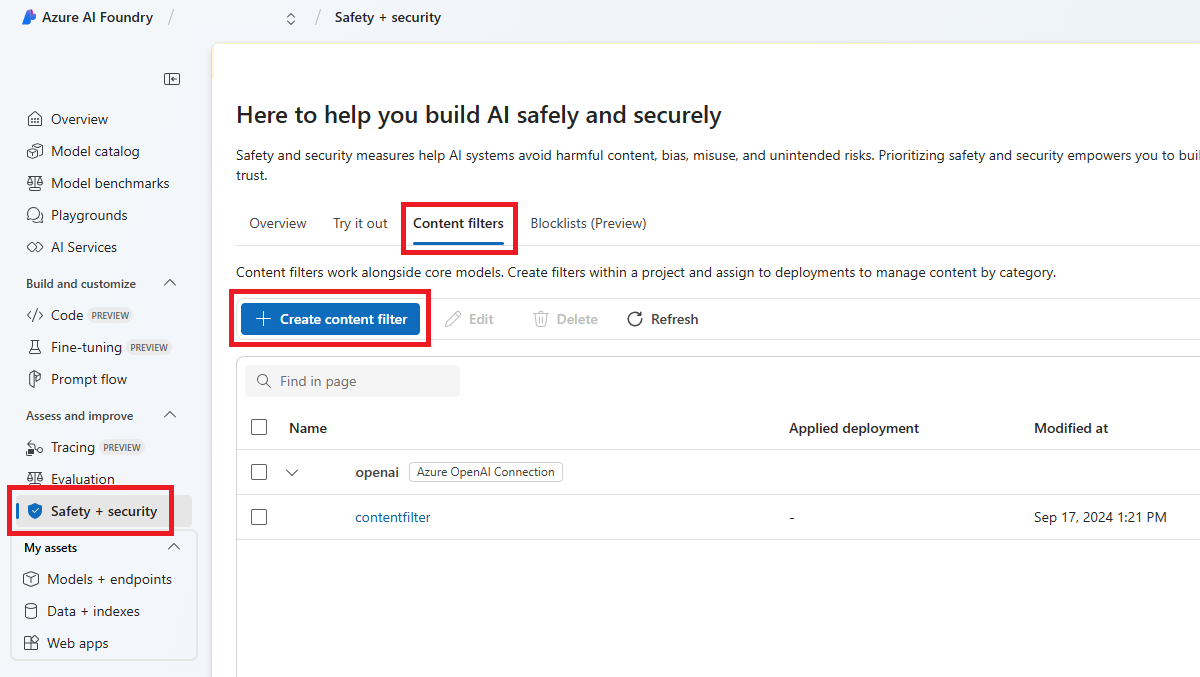

Ga naar Azure AI Foundry en navigeer naar uw project. Selecteer vervolgens de pagina Veiligheid en beveiliging in het linkermenu en selecteer het tabblad Inhoudsfilters .

Selecteer + Inhoudsfilter maken.

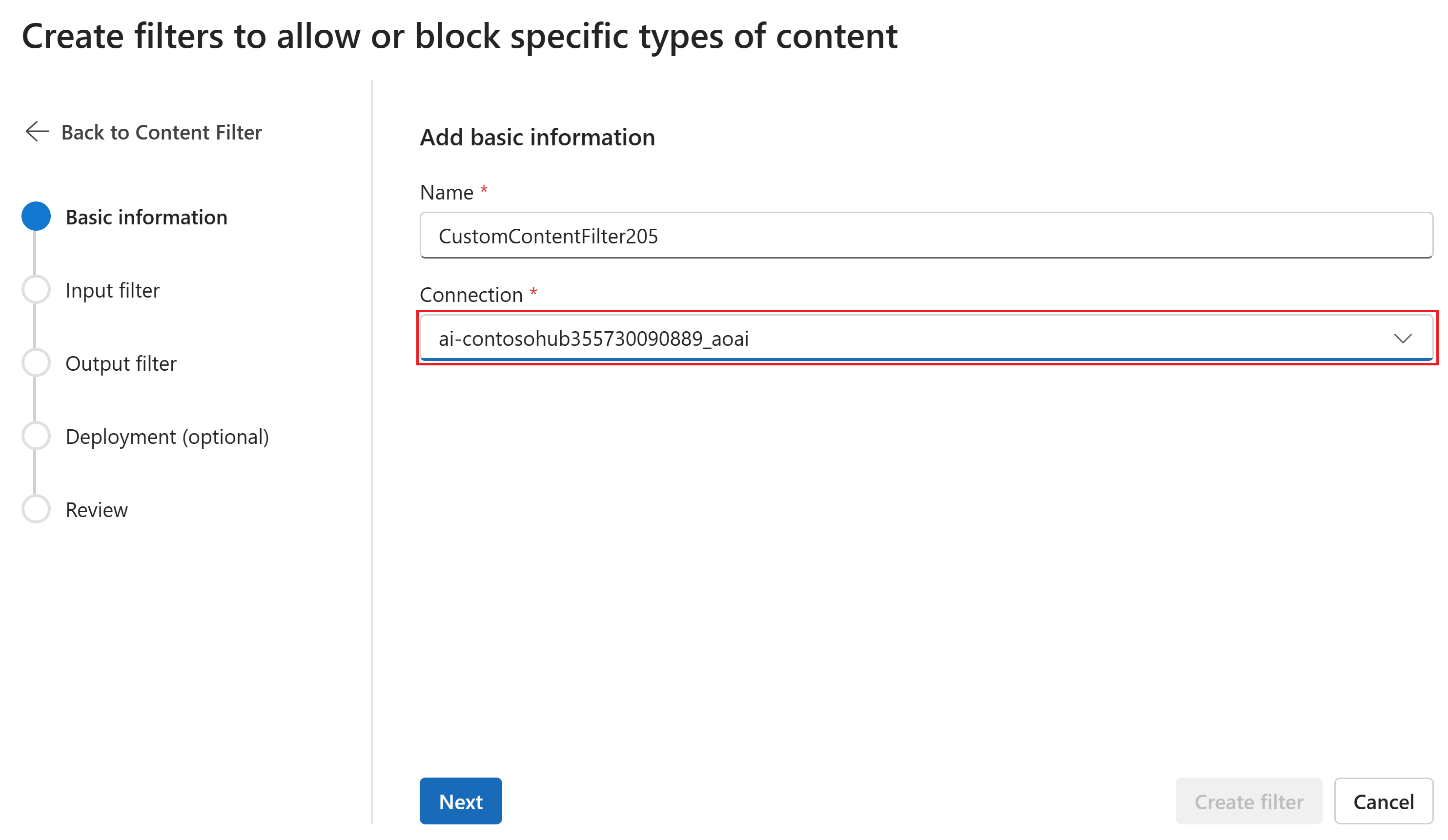

Voer op de pagina Basisgegevens een naam in voor de configuratie van het filteren van inhoud. Selecteer een verbinding om aan het inhoudsfilter te koppelen. Selecteer Volgende.

U kunt nu de invoerfilters (voor gebruikersprompts) en uitvoerfilters (voor voltooiing van het model) configureren.

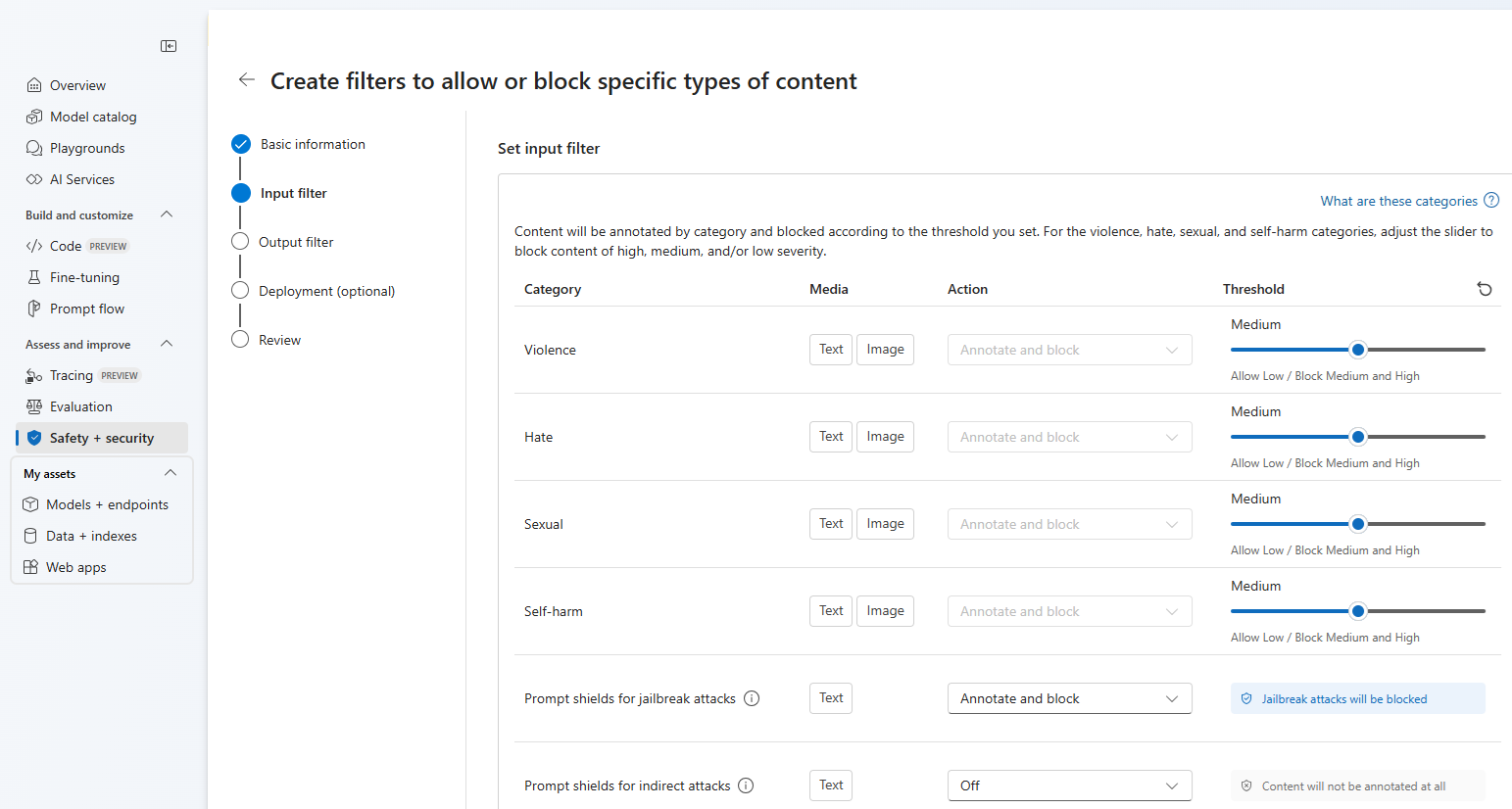

Op de pagina Invoerfilters kunt u het filter voor de invoerprompt instellen. Voor de eerste vier inhoudscategorieën zijn er drie ernstniveaus die kunnen worden geconfigureerd: Laag, Gemiddeld en Hoog. U kunt de schuifregelaars gebruiken om de ernstdrempel in te stellen als u bepaalt dat voor uw toepassing of gebruiksscenario andere filters zijn vereist dan de standaardwaarden. Met sommige filters, zoals promptschilden en beveiligde materiaaldetectie, kunt u bepalen of het model aantekeningen moet maken en/of inhoud moet blokkeren. Als u Aantekeningen selecteren, wordt alleen het respectieve model uitgevoerd en worden aantekeningen geretourneerd via api-antwoord, maar wordt inhoud niet gefilterd. Naast aantekeningen kunt u er ook voor kiezen om inhoud te blokkeren.

Als uw use-case is goedgekeurd voor gewijzigde inhoudsfilters, ontvangt u volledige controle over configuraties voor inhoudsfilters en kunt u ervoor kiezen om filteren gedeeltelijk of volledig uit te schakelen of aantekeningen alleen in te schakelen voor de categorieën inhoudsschade (geweld, haat, seksueel en zelfbeschadiging).

Inhoud wordt geannoteerd op categorie en geblokkeerd volgens de drempelwaarde die u hebt ingesteld. Voor de categorieën geweld, haat, seksueel en zelfschadigen, past u de schuifregelaar aan om inhoud van hoog, gemiddeld of laag ernst te blokkeren.

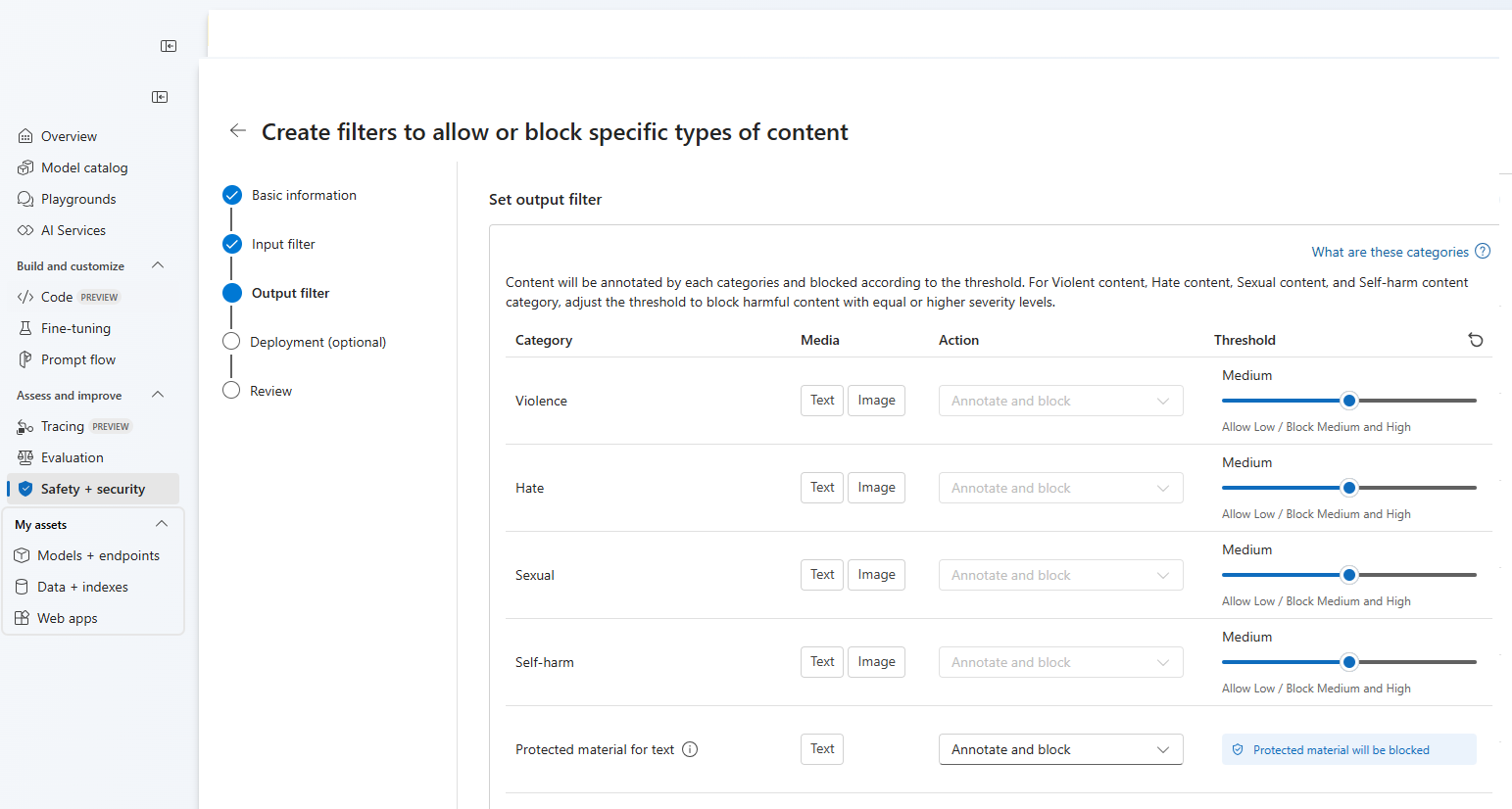

Op de pagina Uitvoerfilters kunt u het uitvoerfilter configureren dat wordt toegepast op alle uitvoerinhoud die door uw model wordt gegenereerd. Configureer de afzonderlijke filters zoals voorheen. Deze pagina biedt ook de optie Streamingmodus, waarmee u inhoud in bijna realtime kunt filteren terwijl deze wordt gegenereerd door het model, waardoor de latentie wordt verminderd. Wanneer u klaar bent, selecteert u Volgende.

Inhoud wordt geannoteerd door elke categorie en geblokkeerd volgens de drempelwaarde. Voor gewelddadige inhoud, haat inhoud, seksuele inhoud en inhoudscategorie die zelf schade toebrengt, past u de drempelwaarde aan om schadelijke inhoud met gelijke of hogere ernstniveaus te blokkeren.

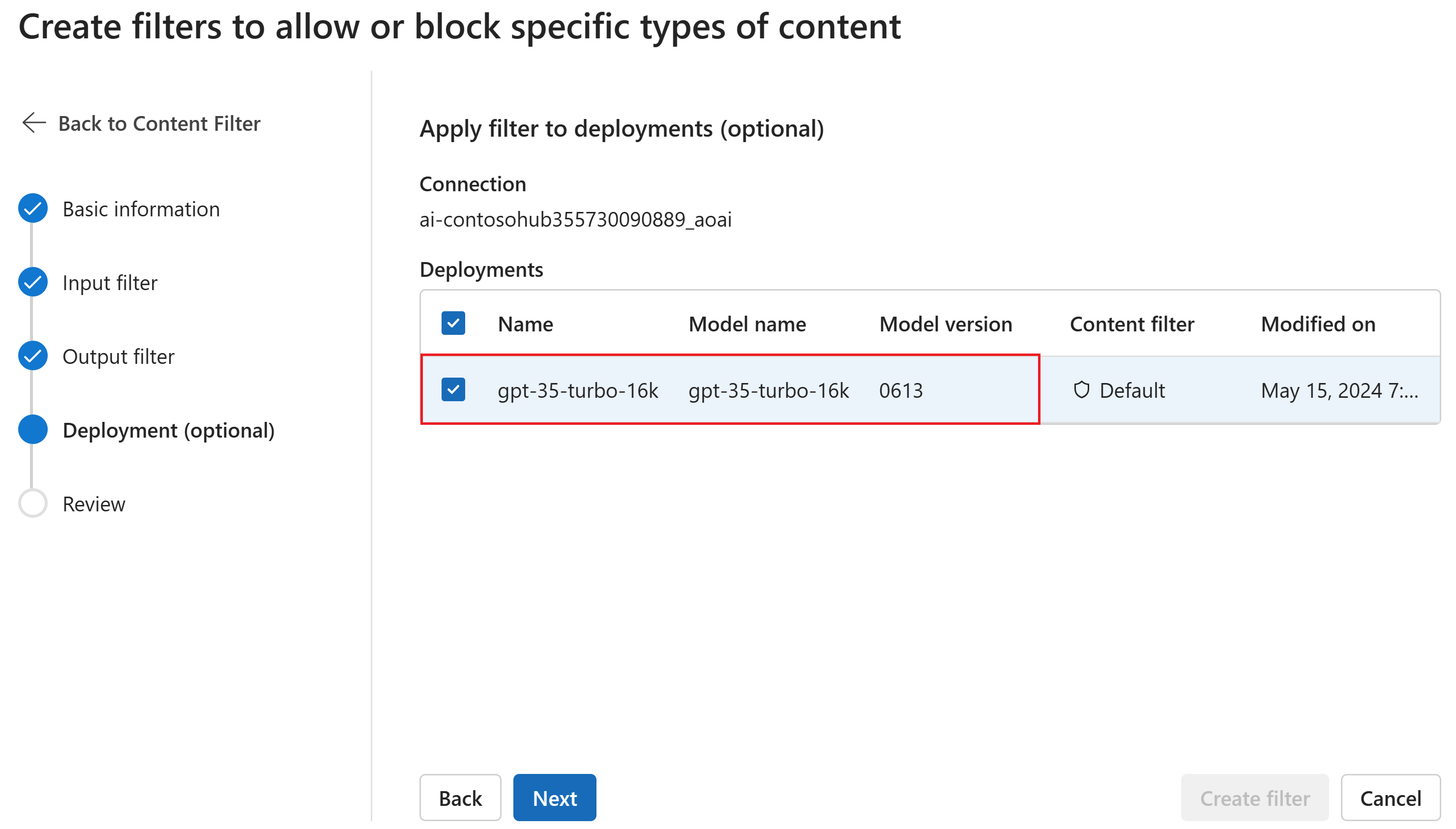

U kunt eventueel op de pagina Implementatie het inhoudsfilter koppelen aan een implementatie. Als voor een geselecteerde implementatie al een filter is gekoppeld, moet u bevestigen dat u deze wilt vervangen. U kunt het inhoudsfilter ook later koppelen aan een implementatie. Selecteer Maken.

Configuraties voor inhoudsfilters worden gemaakt op hubniveau in de Azure AI Foundry-portal. Meer informatie over de configuratiemogelijkheden vindt u in de documentatie van de Azure OpenAI-service.

Controleer de instellingen op de pagina Controleren en selecteer vervolgens Filter maken.

Een blokkering als filter gebruiken

U kunt een bloklijst toepassen als een invoer- of uitvoerfilter, of beide. Schakel de optie Bloklijst in op de pagina Invoerfilter en/of Uitvoerfilter . Selecteer een of meer blokkeringen in de vervolgkeuzelijst of gebruik de ingebouwde blokkeringslijst voor grof taalgebruik. U kunt meerdere bloklijsten combineren in hetzelfde filter.

Een inhoudsfilter toepassen

Het proces voor het maken van filters biedt u de mogelijkheid om het filter toe te passen op de gewenste implementaties. U kunt inhoudsfilters ook op elk gewenst moment wijzigen of verwijderen uit uw implementaties.

Volg deze stappen om een inhoudsfilter toe te passen op een implementatie:

Ga naar Azure AI Foundry en selecteer een project.

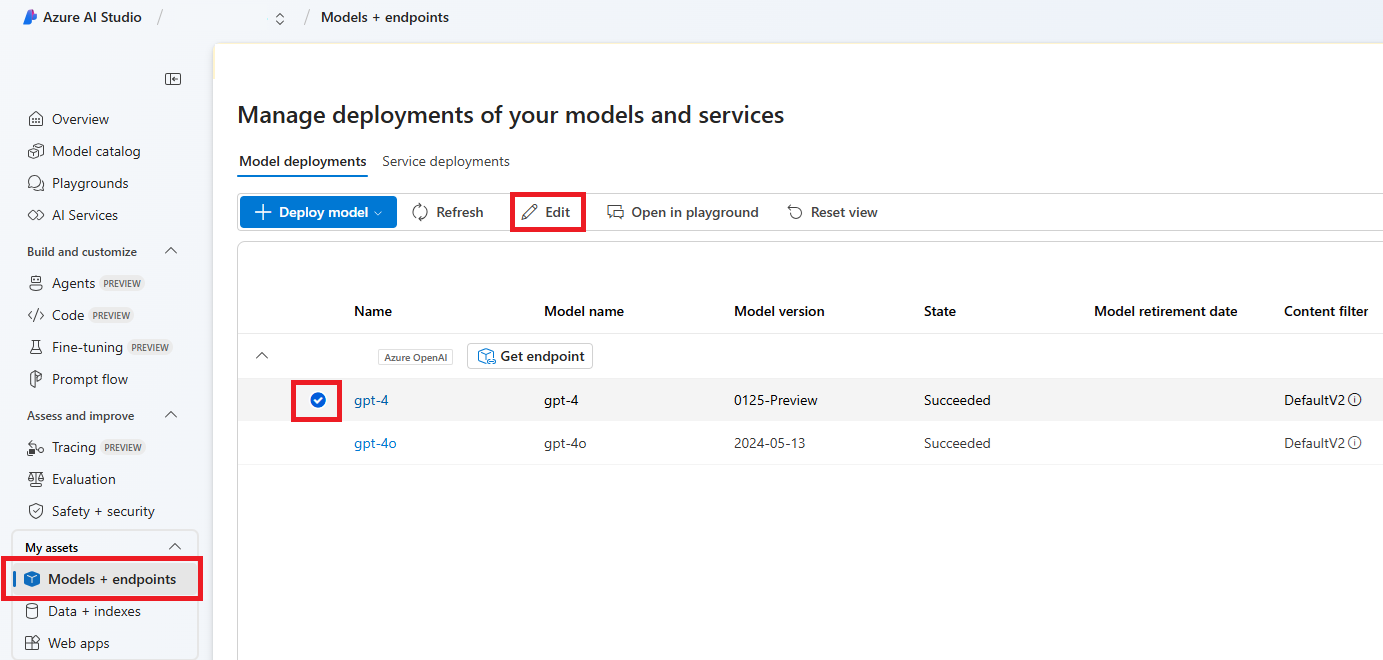

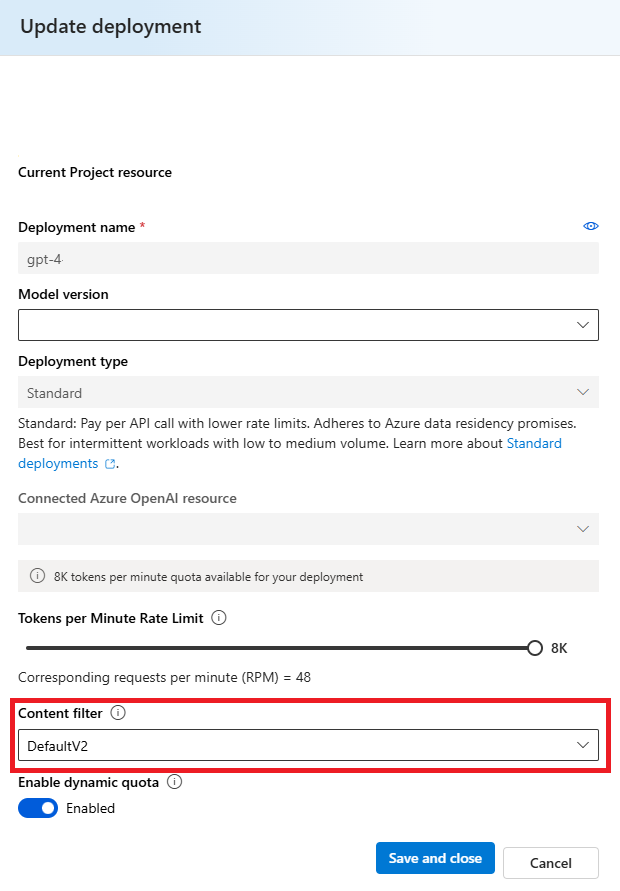

Selecteer Modellen en eindpunten in het linkerdeelvenster en kies een van uw implementaties en selecteer vervolgens Bewerken.

Selecteer in het venster Update-implementatie het inhoudsfilter dat u wilt toepassen op de implementatie. Selecteer Vervolgens Opslaan en sluiten.

U kunt indien nodig ook een configuratie van een inhoudsfilter bewerken en verwijderen. Voordat u een configuratie voor inhoudsfiltering verwijdert, moet u de toewijzing ongedaan maken en vervangen door een implementatie op het tabblad Implementaties .

U kunt nu naar de speeltuin gaan om te testen of het inhoudsfilter werkt zoals verwacht.

Configureerbaarheid (preview)

De standaardconfiguratie voor inhoudsfiltering voor de GPT-modelreeks is ingesteld op filteren op de drempelwaarde voor gemiddelde ernst voor alle vier inhoudsschadecategorieën (haat, geweld, seksueel en zelfschade) en is van toepassing op zowel prompts (tekst, multimodale tekst/afbeelding) als voltooiingen (tekst). Dit betekent dat inhoud die wordt gedetecteerd op ernstniveau gemiddeld of hoog, wordt gefilterd, terwijl inhoud op ernstniveau laag niet wordt gefilterd door de inhoudsfilters. Voor DALL-E is de standaarddrempel voor ernst ingesteld op laag voor zowel prompts (tekst) als voltooiingen (afbeeldingen), zodat inhoud op ernstniveau laag, gemiddeld of hoog wordt gefilterd.

Met de configureerbaarheidsfunctie kunnen klanten de instellingen, afzonderlijk voor prompts en voltooiingen, aanpassen om inhoud voor elke inhoudscategorie op verschillende ernstniveaus te filteren, zoals beschreven in de onderstaande tabel:

| Ernst gefilterd | Configureerbaar voor prompts | Configureerbaar voor voltooiingen | Omschrijvingen |

|---|---|---|---|

| Laag, gemiddeld, hoog | Ja | Ja | Striktste filterconfiguratie. Inhoud die is gedetecteerd op ernstniveaus laag, gemiddeld en hoog, wordt gefilterd. |

| Gemiddeld, hoog | Ja | Ja | Inhoud die is gedetecteerd op ernstniveau laag, wordt niet gefilterd, inhoud op gemiddeld en hoog wordt gefilterd. |

| Hoog | Ja | Ja | Inhoud die is gedetecteerd op ernstniveaus laag en gemiddeld, wordt niet gefilterd. Alleen inhoud op ernstniveau hoog wordt gefilterd. Vereist goedkeuring1. |

| Geen filters | Indien goedgekeurd1 | Indien goedgekeurd1 | Er wordt geen inhoud gefilterd, ongeacht het ernstniveau dat is gedetecteerd. Vereist goedkeuring1. |

1 Voor Azure OpenAI-modellen hebben alleen klanten die zijn goedgekeurd voor aangepaste inhoudsfilters volledige controle over inhoudsfilters, waaronder het configureren van inhoudsfilters op ernstniveau hoog of het uitschakelen van inhoudsfilters. Aanvragen voor gewijzigde inhoudsfilters via deze formulieren: Beperkte toegangsbeoordeling van Azure OpenAI: Gewijzigde inhoudsfilters en Gewijzigde misbruikcontrole.

Klanten zijn verantwoordelijk voor het garanderen dat toepassingen die Azure OpenAI integreren, voldoen aan de gedragscode.

Volgende stappen

- Meer informatie over de onderliggende modellen die Azure OpenAI mogelijk maken.

- Azure AI Foundry-inhoudsfiltering wordt mogelijk gemaakt door Azure AI Content Safety.

- Meer informatie over het begrijpen en beperken van risico's die zijn gekoppeld aan uw toepassing: Overzicht van verantwoorde AI-procedures voor Azure OpenAI-modellen.

- Meer informatie over het evalueren van uw generatieve AI-modellen en AI-systemen via Azure AI Evaluation.