Databricks Runtime 7.4 (EoS)

Notitie

Ondersteuning voor deze Databricks Runtime-versie is beëindigd. Zie de geschiedenis van einde van ondersteuning voor de einddatum van de ondersteuning. Zie de releaseversies en compatibiliteit van Databricks Runtime voor alle ondersteunde Databricks Runtime-versies.

Databricks heeft deze versie uitgebracht in november 2020.

De volgende releaseopmerkingen bevatten informatie over Databricks Runtime 7.4, mogelijk gemaakt door Apache Spark 3.0.

Nieuwe functies

In deze sectie:

- Delta Lake-functies en -verbeteringen

- Automatisch laden biedt nu ondersteuning voor het delegeren van installatie van bestandsmeldingsbronnen aan beheerders

- Met nieuwe

USAGEbevoegdheden hebben beheerders meer controle over bevoegdheden voor gegevenstoegang - DBFS FUSE nu ingeschakeld voor clusters met passthrough

Delta Lake-functies en -verbeteringen

Deze release biedt de volgende Delta Lake-functies en -verbeteringen:

- Met de nieuwe API kan Delta Lake controleren of gegevens die aan een tabel zijn toegevoegd, voldoen aan beperkingen

- Met de nieuwe API kunt u een Delta-tabel terugdraaien naar een oudere versie van de tabel

- Nieuwe beginversie staat alleen de meest recente wijzigingen in een Delta Lake-streamingbron toe

- Verbeterde stabiliteit van

OPTIMIZE

Met de nieuwe API kan Delta Lake controleren of gegevens die aan een tabel zijn toegevoegd, voldoen aan beperkingen

Delta Lake ondersteunt CHECK nu beperkingen. Wanneer dit is opgegeven, controleert Delta Lake automatisch of de gegevens die aan een tabel zijn toegevoegd, voldoen aan de opgegeven expressie.

Gebruik de ALTER TABLE ADD CONSTRAINTS opdracht om beperkingen toe te voegenCHECK. Zie Beperkingen voor Azure Databricks voor meer informatie.

Met de nieuwe API kunt u een Delta-tabel terugdraaien naar een oudere versie van de tabel

U kunt uw Delta-tabellen nu terugdraaien naar oudere versies met behulp van de RESTORE opdracht:

SQL

RESTORE <table> TO VERSION AS OF n;

RESTORE <table> TO TIMESTAMP AS OF 'yyyy-MM-dd HH:mm:ss';

Python

from delta.tables import DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp('yyyy-MM-dd')

Scala

import io.delta.tables.DeltaTable

DeltaTable.forName(spark, "table_name").restoreToVersion(n)

DeltaTable.forName(spark, "table_name").restoreToTimestamp("yyyy-MM-dd")

RESTORE maakt een nieuwe doorvoering die alle wijzigingen in de tabel terugdraait sinds de versie die u wilt herstellen. Alle bestaande gegevens en metagegevens worden hersteld, waaronder het schema, beperkingen, streamingtransactie-id's, COPY INTO metagegevens en de versie van het tabelprotocol. Zie Een Delta-tabel herstellen voor meer informatie.

Nieuwe beginversie staat alleen de meest recente wijzigingen in een Delta Lake-streamingbron toe

Als u alleen de meest recente wijzigingen wilt retourneren, geeft u op startingVersion als latest. Zie Beginpositie opgeven voor meer informatie.

Verbeterde stabiliteit van OPTIMIZE

OPTIMIZE (zonder partitiepredicaten) kan worden geschaald naar uitvoering op tabellen met tientallen miljoenen kleine bestanden. Voorheen kon het Apache Spark-stuurprogramma onvoldoende geheugen hebben en OPTIMIZE zou het niet voltooien.OPTIMIZE verwerkt nu zeer grote tabellen met tientallen miljoenen bestanden.

Automatisch laden biedt nu ondersteuning voor het delegeren van installatie van bestandsmeldingsbronnen aan beheerders

Met een nieuwe Scala-API kunnen beheerders bronnen voor bestandsmeldingen instellen voor Automatisch laden. Data engineers kunnen nu hun AutoLoader-streams gebruiken met minder machtigingen door de eerste resource-instelling te delegeren aan hun beheerders. Zie Bronnen voor bestandsmeldingen handmatig configureren of beheren.

Met nieuwe USAGE bevoegdheden hebben beheerders meer controle over bevoegdheden voor gegevenstoegang

Als u een actie wilt uitvoeren op een object in een database, moet u nu de USAGE bevoegdheid voor die database krijgen, naast de bevoegdheden die nodig zijn om de actie uit te voeren. De USAGE bevoegdheid wordt verleend voor een database of een catalogus. Met de introductie van de USAGE bevoegdheid kan een eigenaar van een tabel niet langer eenzijdig besluiten om deze te delen met een andere gebruiker. De gebruiker moet ook de USAGE bevoegdheid hebben voor de database die de tabel bevat.

In werkruimten waarvoor toegangsbeheer voor tabellen is ingeschakeld, heeft de users groep automatisch de USAGE bevoegdheid voor de hoofdmap CATALOG.

Zie GEBRUIKsbevoegdheden voor meer informatie.

DBFS FUSE nu ingeschakeld voor clusters met passthrough

U kunt nu lezen en schrijven vanuit DBFS met behulp van de FUSE-koppeling op /dbfs/ wanneer u een cluster met hoge gelijktijdigheid gebruikt dat is ingeschakeld voor referentiepassthrough. Reguliere koppelingen worden ondersteund. Koppelingen waarvoor passthrough-referenties zijn vereist, worden niet ondersteund.

Verbeteringen

Spark SQL ondersteunt IFF en CHARINDEX als synoniemen voor IF en POSITION

In Databricks Runtime IF() is een synoniem voor CASE WHEN <cond> THEN <expr1> ELSE <expr2> END

Databricks Runtime ondersteunt IFF() nu als synoniem voor IF()

SELECT IFF(c1 = 1, 'Hello', 'World'), c1 FROM (VALUES (1), (2)) AS T(c1)

=> (Hello, 1)

(World, 2)

CHARINDEX is een alternatieve naam voor de POSITION functie. CHARINDEX zoekt de positie van het eerste exemplaar van een tekenreeks in een andere tekenreeks met een optionele startindex.

VALUES(CHARINDEX('he', 'hello from hell', 2))

=> 12

Meerdere uitvoer per cel die standaard is ingeschakeld voor Python-notebooks

Databricks Runtime 7.1 heeft ondersteuning geïntroduceerd voor meerdere uitvoer per cel in Python-notebooks (en %python-cellen in niet-Python-notebooks), maar u moest de functie voor uw notebook inschakelen. Deze functie is standaard ingeschakeld in Databricks Runtime 7.4. Zie Meerdere uitvoer per cel weergeven.

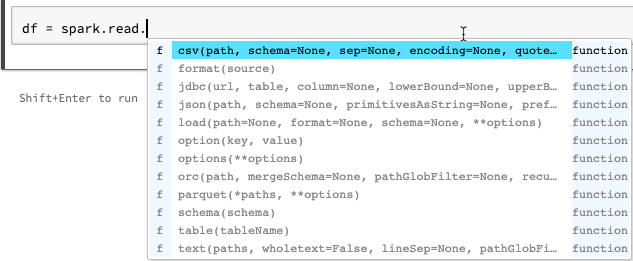

Verbeteringen voor automatisch aanvullen voor Python-notebooks

Automatisch aanvullen voor Python toont aanvullende typegegevens die zijn gegenereerd op basis van statische analyse van de code met behulp van de Jedi-bibliotheek. U kunt op de Tab-toets drukken om een lijst met opties weer te geven.

Verbeterde display spark ML-vectoren in preview van Spark DataFrame

De display notatie toont nu labels voor vectortype (sparse of dicht), lengte, indexen (voor sparse vectoren) en waarden.

Andere oplossingen

- Er is een probleem opgelost met pickling in

collections.namedtuplenotebooks. - Er is een probleem opgelost met het kiezen van interactief gedefinieerde klassen en methoden.

- Er is een fout opgelost waardoor aanroepen

mlflow.start_run()mislukken op passthrough of clusters die zijn ingeschakeld voor toegangsbeheer voor tabellen.

Bibliotheekupgrades

- Bijgewerkte Python-bibliotheken:

- jedi heeft een upgrade uitgevoerd van 0.14.1 naar 0.17.2.

- koalas bijgewerkt van 1.2.0 naar 1.3.0.

- parso bijgewerkt van 0.5.2 naar 0.7.0.

- Er zijn verschillende geïnstalleerde R-bibliotheken bijgewerkt. Zie Geïnstalleerde R-bibliotheken.

Apache Spark

Databricks Runtime 7.4 bevat Apache Spark 3.0.1. Deze release bevat alle Spark-oplossingen en -verbeteringen die zijn opgenomen in Databricks Runtime 7.3 LTS (EoS) en de volgende aanvullende bugfixes en verbeteringen in Spark:

- [SPARK-33170] [SQL] SQL-configuratie toevoegen om het gedrag van snel mislukken in FileFormatWriter te beheren

- [SPARK-33136] [SQL] Fout gewisselde parameter in V2WriteCommand.outputResolved herstellen

- [SPARK-33134] [SQL] Gedeeltelijke resultaten alleen retourneren voor hoofd-JSON-objecten

- [SPARK-33038] [SQL] AQE-eerste en huidige abonnement combineren...

- [SPARK-33118] [SQL] TIJDELIJKE TABEL MAKEN mislukt met locatie

- [SPARK-33101] [ML] LibSVM-indeling hadoop-configuratie van DS-opties doorgeven aan het onderliggende HDFS-bestandssysteem

- [SPARK-33035] [SQL] Hiermee worden de verouderde vermeldingen van kenmerktoewijzing bijgewerkt in QueryPlan#transformUpWithNewOutput

- [SPARK-33091] [SQL] Vermijd het gebruik van kaart in plaats van foreach om mogelijk neveneffect te voorkomen bij bellers van OrcUtils.readCatalystSchema

- [SPARK-33073] [PYTHON] Foutafhandeling van Pandas naar pijlconversiefouten verbeteren

- [SPARK-33043] [ML] Handle spark.driver.maxResultSize=0 in RowMatrix heuristic computation

- [SPARK-29358] [SQL] Als unionByName optioneel ontbrekende kolommen doorvoeren met null-waarden

- [SPARK-32996] [WEB-UI] Lege ExecutorMetrics afhandelen in ExecutorMetricsJsonSerializer

- [SPARK-32585] [SQL] Scala-inventarisatie in ScalaReflection ondersteunen

- [SPARK-33019] [CORE] Spark.hadoop.mapreduce.fileoutputcommitter.algorithm.version=1 standaard gebruiken

- [SPARK-33018] [SQL] Probleem met schattingsstatistieken oplossen als kind 0 bytes heeft

- [SPARK-32901] [CORE] Geheugen niet toewijzen tijdens het overlopen van OnveiligeExternalSorter

- [SPARK-33015] [SQL] MillisToDays() gebruiken in de regel ComputeCurrentTime

- [SPARK-33015] [SQL] De huidige datum slechts één keer berekenen

- [SPARK-32999] [SQL] Gebruik Utils.getSimpleName om te voorkomen dat u een ongeldige klassenaam in TreeNode raakt

- [SPARK-32659] [SQL] Matrix uitzenden in plaats van Set in InSubqueryExec

- [SPARK-32718] [SQL] Overbodige trefwoorden voor intervaleenheden verwijderen

- [SPARK-32886] [WEBUI] fix 'undefined' link in de gebeurtenistijdlijnweergave

- [SPARK-32898] [CORE] Foute executorRunTime oplossen wanneer de taak is gedood voordat de echte start is gestart

- [SPARK-32635] [SQL] Een nieuwe testcase toevoegen in de katalysatormodule

- [SPARK-32930] [CORE] Afgeschafte isFile-/isDirectory-methoden vervangen

- [SPARK-32906] [SQL] Struct-veldnamen mogen niet veranderen na het normaliseren van floats

- [SPARK-24994] [SQL] UnwrapCastInBinaryComparison optimizer toevoegen om integrale letterlijke gegevens te vereenvoudigen

- [SPARK-32635] [SQL] Vouwbare doorgifte herstellen

- [SPARK-32738] [CORE] Verminder het aantal actieve threads als er een fatale fout optreedt in

Inbox.process - [SPARK-32900] [CORE] OnveiligeExternalSorter toestaan om over te lopen wanneer er null-waarden zijn

- [SPARK-32897] [PYTHON] Geen waarschuwing over afschaffing weergeven bij SparkSession.builder.getOrCreate

- [SPARK-32715] [CORE] Geheugenlek oplossen wanneer delen van broadcast niet kunnen worden opgeslagen

- [SPARK-32715] [CORE] Geheugenlek oplossen wanneer delen van broadcast niet kunnen worden opgeslagen

- [SPARK-32872] [CORE] Voorkomen dat BytesToBytesMap op MAX_CAPACITY de groeidrempel overschrijdt

- [SPARK-32876] [SQL] Standaard terugvalversies wijzigen in 3.0.1 en 2.4.7 in HiveExternalCatalogVersionsSuite

- [SPARK-32840] [SQL] Ongeldige intervalwaarde kan gewoon kleven met de eenheid

- [SPARK-32819] [SQL] parameter ignoreNullability moet recursief zijn

- [SPARK-32832] [SS] Use CaseInsensitiveMap for DataStreamReader/Writer options

- [SPARK-32794] [SS] Probleem met zeldzame hoekcases in microbatch-engine opgelost met enkele stateful query's + no-data-batches + V1-bronnen

- [SPARK-32813] [SQL] Standaardconfiguratie ophalen van parquetSource vectorized reader als er geen actieve SparkSession

- [SPARK-32823] [WEBINTERFACE] De rapportage van de hoofdgebruikersinterfacebronnen herstellen

- [SPARK-32824] [CORE] Het foutbericht verbeteren wanneer de gebruiker de .amount in een resourceconfiguratie vergeet

- [SPARK-32614] [SQL] Verwerking van opmerkingen niet toepassen als 'opmerking' niet is uitgeschakeld voor CSV

- [SPARK-32638] [SQL] Corrigeert verwijzingen bij het toevoegen van aliassen in WidenSetOperationTypes

- [SPARK-32810] [SQL] CSV-/JSON-gegevensbronnen moeten globbing-paden voorkomen bij het uitstellen van het schema

- [SPARK-32815] [ML] Fout bij het laden van libSVM-gegevensbronnen in bestandspaden met glob-metacharacters oplossen

- [SPARK-32753] [SQL] Alleen tags kopiëren naar knooppunt zonder tags

- [SPARK-32785] [SQL] Interval met zwevende delen mag niet null opleveren

- [SPARK-32764] [SQL] -0.0 moet gelijk zijn aan 0,0

- [SPARK-32810] [SQL] CSV-/JSON-gegevensbronnen moeten globbing-paden voorkomen bij het uitstellen van het schema

- [SPARK-32779] [SQL] Vermijd het gebruik van gesynchroniseerde API van SessionCatalog in withClient-stroom. Dit leidt tot DeadLock

- [SPARK-32791] [SQL] Metrische gegevens van niet-gepartitioneerde tabellen mogen geen dynamische tijd voor het verwijderen van partities hebben

- [SPARK-32767] [SQL] Bucket join moet werken als spark.sql.shuffle.partitions groter is dan bucketnummer

- [SPARK-32788] [SQL] Niet-gepartitioneerde tabelscan mag geen partitiefilter hebben

- [SPARK-32776] [SS] Limiet in streaming mag niet worden geoptimaliseerd door PropagateEmptyRelation

- [SPARK-32624] [SQL] Regressie herstellen in CodegenContext.addReferenceObj op geneste Scala-typen

- [SPARK-32659] [SQL] Test verbeteren voor het verwijderen van DPP op niet-atomisch type

- [SPARK-31511] [SQL] BytesToBytesMap iterators thread-safe maken

- [SPARK-32693] [SQL] Twee dataframes vergelijken met hetzelfde schema, behalve de eigenschap nullable

- [SPARK-28612] [SQL] Juiste methode-document van DataFrameWriterV2.replace()

Onderhoudsupdates

Zie onderhoudsupdates voor Databricks Runtime 7.4.

Systeemomgeving

- Besturingssysteem: Ubuntu 18.04.5 LTS

- Java: Zulu 8.48.0.53-CA-linux64 (build 1.8.0_265-b11)

- Scala: 2.12.10

- Python: 3.7.5

- R: R versie 3.6.3 (2020-02-29)

- Delta Lake 0.7.0

Geïnstalleerde Python-bibliotheken

| Bibliotheek | Versie | Bibliotheek | Versie | Bibliotheek | Versie |

|---|---|---|---|---|---|

| asn1crypto | 1.3.0 | backcall | 0.1.0 | boto3 | 1.12.0 |

| botocore | 1.15.0 | certifi | 2020.6.20 | cffiffi | 1.14.0 |

| chardet | 3.0.4 | cryptografie | 2.8 | wielrijder | 0.10.0 |

| Cython | 0.29.15 | decorateur | 4.4.1 | docutils | 0.15.2 |

| invoerpunten | 0,3 | idna | 2.8 | ipykernel | 5.1.4 |

| ipython | 7.12.0 | ipython-genutils | 0.2.0 | jedi | 0.17.2 |

| jmespath | 0.10.0 | joblib | 0.14.1 | jupyter-client | 5.3.4 |

| jupyter-core | 4.6.1 | kiwisolver | 1.1.0 | koala's | 1.3.0 |

| matplotlib | 3.1.3 | numpy | 1.18.1 | Pandas | 1.0.1 |

| parso | 0.7.0 | Patsy | 0.5.1 | pexpect | 4.8.0 |

| pickleshare | 0.7.5 | pit | 20.0.2 | prompt-toolkit | 3.0.3 |

| psycopg2 | 2.8.4 | ptyprocess | 0.6.0 | pyarrow | 1.0.1 |

| pycparser | 2.19 | Pygments | 2.5.2 | PyGObject | 3.26.1 |

| pyOpenSSL | 19.1.0 | pyparsing | 2.4.6 | PySocks | 1.7.1 |

| python-apt | 1.6.5+ubuntu0.3 | python-dateutil | 2.8.1 | pytz | 2019.3 |

| pyzmq | 18.1.1 | requests | 2.22.0 | s3transfer | 0.3.3 |

| scikit-learn | 0.22.1 | scipy | 1.4.1 | seaborn | 0.10.0 |

| setuptools | 45.2.0 | Zes | 1.14.0 | ssh-import-id | 5.7 |

| statsmodels | 0.11.0 | tornado | 6.0.3 | traitlets | 4.3.3 |

| upgrades zonder toezicht | 0,1 | urllib3 | 1.25.8 | virtualenv | 16.7.10 |

| wcwidth | 0.1.8 | wiel | 0.34.2 |

Geïnstalleerde R-bibliotheken

R-bibliotheken worden geïnstalleerd vanuit Microsoft CRAN-momentopname op XXXX-XX-XX.

| Bibliotheek | Versie | Bibliotheek | Versie | Bibliotheek | Versie |

|---|---|---|---|---|---|

| askpass | 1.1 | assertthat | 0.2.1 | backports | 1.1.8 |

| base | 3.6.3 | base64enc | 0.1-3 | BH | 1.72.0-3 |

| bit | 1.1-15.2 | bit64 | 0.9-7 | blob | 1.2.1 |

| opstarten | 1.3-25 | brouwsel | 1.0-6 | bezem | 0.7.0 |

| beller | 3.4.3 | caret | 6.0-86 | cellranger | 1.1.0 |

| Chron | 2.3-55 | class | 7.3-17 | cli | 2.0.2 |

| clipr | 0.7.0 | cluster | 2.1.0 | codetools | 0.2-16 |

| colorspace | 1.4-1 | commonmark | 1,7 | compiler | 3.6.3 |

| configuratie | 0,3 | covr | 3.5.0 | Crayon | 1.3.4 |

| Overspraak | 1.1.0.1 | curl | 4.3 | data.table | 1.12.8 |

| gegevenssets | 3.6.3 | DBI | 1.1.0 | dbplyr | 1.4.4 |

| Desc | 1.2.0 | devtools | 2.3.0 | verteren | 0.6.25 |

| dplyr | 0.8.5 | DT | 0,14 | beletselteken | 0.3.1 |

| evaluate | 0,14 | fansi | 0.4.1 | farver | 2.0.3 |

| fastmap | 1.0.1 | forcats | 0.5.0 | foreach | 1.5.0 |

| buitenlands | 0.8-76 | smeden | 0.2.0 | Fs | 1.4.2 |

| Generics | 0.0.2 | ggplot2 | 3.3.2 | Gh | 1.1.0 |

| git2r | 0.27.1 | glmnet | 3.0-2 | globals | 0.12.5 |

| lijm | 1.4.1 | Gower | 0.2.2 | afbeeldingen | 3.6.3 |

| grDevices | 3.6.3 | rooster | 3.6.3 | gridExtra | 2.3 |

| gsubfn | 0,7 | gtable | 0.3.0 | haven | 2.3.1 |

| highr | 0,8 | Hms | 0.5.3 | htmltools | 0.5.0 |

| htmlwidgets | 1.5.1 | httpuv | 1.5.4 | httr | 1.4.1 |

| hwriter | 1.3.2 | hwriterPlus | 1.0-3 | ini | 0.3.1 |

| ipred | 0.9-9 | isoband | 0.2.2 | Iterators | 1.0.12 |

| jsonlite | 1.7.0 | KernSmooth | 2.23-17 | breiwerk | 1,29 |

| Labeling | 0,3 | later | 1.1.0.1 | latwerk | 0.20-41 |

| lava | 1.6.7 | lazyeval | 0.2.2 | levenscyclus | 0.2.0 |

| lubridate | 1.7.9 | magrittr | 1.5 | Markdown | 1.1 |

| MASSA | 7.3-53 | Matrix | 1.2-18 | memoise | 1.1.0 |

| methoden | 3.6.3 | mgcv | 1.8-33 | Mime | 0,9 |

| ModelMetrics | 1.2.2.2 | modeller | 0.1.8 | munsell | 0.5.0 |

| nlme | 3.1-149 | nnet | 7.3-14 | numDeriv | 2016.8-1.1 |

| openssl | 1.4.2 | parallel | 3.6.3 | pilaar | 1.4.6 |

| pkgbuild | 1.1.0 | pkgconfig | 2.0.3 | pkgload | 1.1.0 |

| plogr | 0.2.0 | plyr | 1.8.6 | loven | 1.0.0 |

| prettyunits | 1.1.1 | Proc | 1.16.2 | processx | 3.4.3 |

| prodlim | 2019.11.13 | Voortgang | 1.2.2 | Beloften | 1.1.1 |

| Proto | 1.0.0 | ps | 1.3.3 | purrr | 0.3.4 |

| r2d3 | 0.2.3 | R6 | 2.4.1 | randomForest | 4.6-14 |

| rappdirs | 0.3.1 | rcmdcheck | 1.3.3 | RColorBrewer | 1.1-2 |

| Rcpp | 1.0.5 | leesbewerking | 1.3.1 | readxl | 1.3.1 |

| recepten | 0.1.13 | Rematch | 1.0.1 | opnieuw overeenkomen2 | 2.1.2 |

| Afstandsbedieningen | 2.1.1 | reprex | 0.3.0 | hervorm2 | 1.4.4 |

| Rex | 1.2.0 | rjson | 0.2.20 | rlang | 0.4.7 |

| rmarkdown | 2.3 | RODBC | 1.3-16 | roxygen2 | 7.1.1 |

| rpart | 4.1-15 | rprojroot | 1.3-2 | Rserve | 1.8-7 |

| RSQLite | 2.2.0 | rstudioapi | 0,11 | rversions | 2.0.2 |

| rvest | 0.3.5 | weegschaal | 1.1.1 | selectr | 0.4-2 |

| sessioninfo | 1.1.1 | vorm | 1.4.4 | glanzend | 1.5.0 |

| sourcetools | 0.1.7 | sparklyr | 1.3.1 | SparkR | 3.0.0 |

| ruimtelijk | 7.3-11 | Splines | 3.6.3 | sqldf | 0.4-11 |

| SQUAREM | 2020.3 | Stats | 3.6.3 | stats4 | 3.6.3 |

| stringi | 1.4.6 | stringr | 1.4.0 | overleving | 3.2-7 |

| sys | 3.3 | tcltk | 3.6.3 | TeachingDemos | 2.10 |

| testthat | 2.3.2 | tibble | 3.0.3 | tidyr | 1.1.0 |

| tidyselect | 1.1.0 | tidyverse | 1.3.0 | timeDate | 3043.102 |

| tinytex | 0,24 | tools | 3.6.3 | usethis | 1.6.1 |

| utf8 | 1.1.4 | utils | 3.6.3 | uuid | 0.1-4 |

| vctrs | 0.3.1 | viridisLite | 0.3.0 | snor | 0,4 |

| withr | 2.2.0 | xfun | 0,15 | xml2 | 1.3.2 |

| xopen | 1.0.0 | xtable | 1.8-4 | yaml | 2.2.1 |

Geïnstalleerde Java- en Scala-bibliotheken (Scala 2.12-clusterversie)

| Groeps-id | Artefact-id | Versie |

|---|---|---|

| antlr | antlr | 2.7.7 |

| com.amazonaws | amazon-kinesis-client | 1.12.0 |

| com.amazonaws | aws-java-sdk-autoscaling | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudformation | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudfront | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudhsm | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudsearch | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudtrail | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudwatch | 1.11.655 |

| com.amazonaws | aws-java-sdk-cloudwatchmetrics | 1.11.655 |

| com.amazonaws | aws-java-sdk-codedeploy | 1.11.655 |

| com.amazonaws | aws-java-sdk-cognitoidentity | 1.11.655 |

| com.amazonaws | aws-java-sdk-cognitosync | 1.11.655 |

| com.amazonaws | aws-java-sdk-config | 1.11.655 |

| com.amazonaws | aws-java-sdk-core | 1.11.655 |

| com.amazonaws | aws-java-sdk-datapipeline | 1.11.655 |

| com.amazonaws | aws-java-sdk-directconnect | 1.11.655 |

| com.amazonaws | aws-java-sdk-directory | 1.11.655 |

| com.amazonaws | aws-java-sdk-dynamodb | 1.11.655 |

| com.amazonaws | aws-java-sdk-ec2 | 1.11.655 |

| com.amazonaws | aws-java-sdk-ecs | 1.11.655 |

| com.amazonaws | aws-java-sdk-efs | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticache | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticbeanstalk | 1.11.655 |

| com.amazonaws | aws-java-sdk-elasticloadbalancing | 1.11.655 |

| com.amazonaws | aws-java-sdk-elastictranscoder | 1.11.655 |

| com.amazonaws | aws-java-sdk-emr | 1.11.655 |

| com.amazonaws | aws-java-sdk-glacier | 1.11.655 |

| com.amazonaws | aws-java-sdk-iam | 1.11.655 |

| com.amazonaws | aws-java-sdk-importexport | 1.11.655 |

| com.amazonaws | aws-java-sdk-kinesis | 1.11.655 |

| com.amazonaws | aws-java-sdk-kms | 1.11.655 |

| com.amazonaws | aws-java-sdk-lambda | 1.11.655 |

| com.amazonaws | aws-java-sdk-logs | 1.11.655 |

| com.amazonaws | aws-java-sdk-machinelearning | 1.11.655 |

| com.amazonaws | aws-java-sdk-opsworks | 1.11.655 |

| com.amazonaws | aws-java-sdk-rds | 1.11.655 |

| com.amazonaws | aws-java-sdk-redshift | 1.11.655 |

| com.amazonaws | aws-java-sdk-route53 | 1.11.655 |

| com.amazonaws | aws-java-sdk-s3 | 1.11.655 |

| com.amazonaws | aws-java-sdk-ses | 1.11.655 |

| com.amazonaws | aws-java-sdk-simpledb | 1.11.655 |

| com.amazonaws | aws-java-sdk-simpleworkflow | 1.11.655 |

| com.amazonaws | aws-java-sdk-sns | 1.11.655 |

| com.amazonaws | aws-java-sdk-sqs | 1.11.655 |

| com.amazonaws | aws-java-sdk-ssm | 1.11.655 |

| com.amazonaws | aws-java-sdk-storagegateway | 1.11.655 |

| com.amazonaws | aws-java-sdk-sts | 1.11.655 |

| com.amazonaws | aws-java-sdk-support | 1.11.655 |

| com.amazonaws | aws-java-sdk-swf-libraries | 1.11.22 |

| com.amazonaws | aws-java-sdk-workspaces | 1.11.655 |

| com.amazonaws | jmespath-java | 1.11.655 |

| com.chuusai | shapeless_2.12 | 2.3.3 |

| com.clearspring.analytics | stroom | 2.9.6 |

| com.databricks | Rserve | 1.8-3 |

| com.databricks | jets3t | 0.7.1-0 |

| com.databricks.scalapb | compilerplugin_2.12 | 0.4.15-10 |

| com.databricks.scalapb | scalapb-runtime_2.12 | 0.4.15-10 |

| com.esotericsoftware | kryo-gearceerd | 4.0.2 |

| com.esotericsoftware | minlog | 1.3.0 |

| com.fasterxml | klasgenoot | 1.3.4 |

| com.fasterxml.jackson.core | jackson-annotaties | 2.10.0 |

| com.fasterxml.jackson.core | jackson-core | 2.10.0 |

| com.fasterxml.jackson.core | jackson-databind | 2.10.0 |

| com.fasterxml.jackson.dataformat | jackson-dataformat-cbor | 2.10.0 |

| com.fasterxml.jackson.datatype | jackson-datatype-joda | 2.10.0 |

| com.fasterxml.jackson.module | jackson-module-paranamer | 2.10.0 |

| com.fasterxml.jackson.module | jackson-module-scala_2.12 | 2.10.0 |

| com.github.ben-manes.cafeïne | cafeïne | 2.3.4 |

| com.github.fommil | jniloader | 1.1 |

| com.github.fommil.netlib | kern | 1.1.2 |

| com.github.fommil.netlib | native_ref-java | 1.1 |

| com.github.fommil.netlib | native_ref-java-natives | 1.1 |

| com.github.fommil.netlib | native_system-java | 1.1 |

| com.github.fommil.netlib | native_system-java-natives | 1.1 |

| com.github.fommil.netlib | netlib-native_ref-linux-x86_64-natives | 1.1 |

| com.github.fommil.netlib | netlib-native_system-linux-x86_64-natives | 1.1 |

| com.github.joshelser | dropwizard-metrics-hadoop-metrics2-reporter | 0.1.2 |

| com.github.luben | zstd-jni | 1.4.4-3 |

| com.github.wendykierp | JTransforms | 3.1 |

| com.google.code.findbugs | jsr305 | 3.0.0 |

| com.google.code.gson | gson | 2.2.4 |

| com.google.flatbuffers | flatbuffers-java | 1.9.0 |

| com.google.guava | guave | 15.0 |

| com.google.protobuf | protobuf-java | 2.6.1 |

| com.h2database | h2 | 1.4.195 |

| com.helger | profiler | 1.1.1 |

| com.jcraft | jsch | 0.1.50 |

| com.jolbox | bonecp | 0.8.0.RELEASE |

| com.lihaoyi | sourcecode_2.12 | 0.1.9 |

| com.microsoft.azure | azure-data-lake-store-sdk | 2.2.8 |

| com.microsoft.sqlserver | mssql-jdbc | 8.2.1.jre8 |

| com.ning | compress-lzf | 1.0.3 |

| com.sun.mail | javax.mail | 1.5.2 |

| com.tdunning | json | 1.8 |

| com.thoughtworks.paranamer | paranamer | 2.8 |

| com.trueaccord.lenses | lenses_2.12 | 0.4.12 |

| com.twitter | chill-java | 0.9.5 |

| com.twitter | chill_2.12 | 0.9.5 |

| com.twitter | util-app_2.12 | 7.1.0 |

| com.twitter | util-core_2.12 | 7.1.0 |

| com.twitter | util-function_2.12 | 7.1.0 |

| com.twitter | util-jvm_2.12 | 7.1.0 |

| com.twitter | util-lint_2.12 | 7.1.0 |

| com.twitter | util-registry_2.12 | 7.1.0 |

| com.twitter | util-stats_2.12 | 7.1.0 |

| com.typesafe | configuratie | 1.2.1 |

| com.typesafe.scala-logging | scala-logging_2.12 | 3.7.2 |

| com.univocity | univocity-parsers | 2.9.0 |

| com.zaxxer | HikariCP | 3.1.0 |

| commons-beanutils | commons-beanutils | 1.9.4 |

| commons-cli | commons-cli | 1.2 |

| commons-codec | commons-codec | 1,10 |

| commons-collections | commons-collections | 3.2.2 |

| commons-configuratie | commons-configuratie | 1.6 |

| commons-dbcp | commons-dbcp | 1.4 |

| commons-digester | commons-digester | 1.8 |

| commons-fileupload | commons-fileupload | 1.3.3 |

| commons-httpclient | commons-httpclient | 3.1 |

| commons-io | commons-io | 2.4 |

| commons-lang | commons-lang | 2.6 |

| commons-logging | commons-logging | 1.1.3 |

| commons-net | commons-net | 3.1 |

| commons-pool | commons-pool | 1.5.4 |

| info.ganglia.gmetric4j | gmetric4j | 1.0.10 |

| io.airlift | aircompressor | 0.10 |

| io.dropwizard.metrics | metrische gegevenskern | 4.1.1 |

| io.dropwizard.metrics | metrische gegevensgrafiet | 4.1.1 |

| io.dropwizard.metrics | metrische statuscontroles | 4.1.1 |

| io.dropwizard.metrics | metrics-jetty9 | 4.1.1 |

| io.dropwizard.metrics | metrics-jmx | 4.1.1 |

| io.dropwizard.metrics | metrics-json | 4.1.1 |

| io.dropwizard.metrics | metrics-jvm | 4.1.1 |

| io.dropwizard.metrics | metrics-servlets | 4.1.1 |

| io.netty | netty-all | 4.1.47.Final |

| jakarta.annotatie | jakarta.annotation-api | 1.3.5 |

| jakarta.validation | jakarta.validation-api | 2.0.2 |

| jakarta.ws.rs | jakarta.ws.rs-api | 2.1.6 |

| javax.activation | activering | 1.1.1 |

| javax.el | javax.el-api | 2.2.4 |

| javax.jdo | jdo-api | 3.0.1 |

| javax.servlet | javax.servlet-api | 3.1.0 |

| javax.servlet.jsp | jsp-api | 2.1 |

| javax.transaction | jta | 1.1 |

| javax.transaction | transaction-api | 1.1 |

| javax.xml.bind | jaxb-api | 2.2.2 |

| javax.xml.stream | stax-api | 1.0-2 |

| javolution | javolution | 5.5.1 |

| jline | jline | 2.14.6 |

| joda-time | joda-time | 2.10.5 |

| log4j | apache-log4j-extra's | 1.2.17 |

| log4j | log4j | 1.2.17 |

| net.razorvine | pyrolite | 4.30 |

| net.sf.jpam | jpam | 1.1 |

| net.sf.opencsv | opencsv | 2.3 |

| net.sf.supercsv | super-CSV | 2.2.0 |

| net.snowflake | snowflake-ingest-sdk | 0.9.6 |

| net.snowflake | snowflake-jdbc | 3.12.8 |

| net.snowflake | spark-snowflake_2.12 | 2.8.1-spark_3.0 |

| net.sourceforge.f2j | arpack_combined_all | 0,1 |

| org.acplt.remotetea | remotetea-oncrpc | 1.1.2 |

| org.antlr | ST4 | 4.0.4 |

| org.antlr | antlr-runtime | 3.5.2 |

| org.antlr | antlr4-runtime | 4.7.1 |

| org.antlr | tekenreekstemplate | 3.2.1 |

| org.apache.ant | ant | 1.9.2 |

| org.apache.ant | ant-jsch | 1.9.2 |

| org.apache.ant | ant-launcher | 1.9.2 |

| org.apache.arrow | pijlnotatie | 0.15.1 |

| org.apache.arrow | pijlgeheugen | 0.15.1 |

| org.apache.arrow | pijlvector | 0.15.1 |

| org.apache.avro | avro | 1.8.2 |

| org.apache.avro | avro-ipc | 1.8.2 |

| org.apache.avro | avro-mapred-hadoop2 | 1.8.2 |

| org.apache.commons | commons-compress | 1.8.1 |

| org.apache.commons | commons-crypto | 1.0.0 |

| org.apache.commons | commons-lang3 | 3.9 |

| org.apache.commons | commons-math3 | 3.4.1 |

| org.apache.commons | commons-text | 1.6 |

| org.apache.curator | curator-client | 2.7.1 |

| org.apache.curator | curator-framework | 2.7.1 |

| org.apache.curator | curator-recepten | 2.7.1 |

| org.apache.derby | Derby | 10.12.1.1 |

| org.apache.directory.api | api-asn1-api | 1.0.0-M20 |

| org.apache.directory.api | api-util | 1.0.0-M20 |

| org.apache.directory.server | apacheds-i18n | 2.0.0-M15 |

| org.apache.directory.server | apacheds-kerberos-codec | 2.0.0-M15 |

| org.apache.hadoop | hadoop-aantekeningen | 2.7.4 |

| org.apache.hadoop | hadoop-auth | 2.7.4 |

| org.apache.hadoop | hadoop-client | 2.7.4 |

| org.apache.hadoop | hadoop-common | 2.7.4 |

| org.apache.hadoop | hadoop-hdfs | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-app | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-common | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-core | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-jobclient | 2.7.4 |

| org.apache.hadoop | hadoop-mapreduce-client-shuffle | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-api | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-client | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-common | 2.7.4 |

| org.apache.hadoop | hadoop-yarn-server-common | 2.7.4 |

| org.apache.hive | hive-beeline | 2.3.7 |

| org.apache.hive | hive-cli | 2.3.7 |

| org.apache.hive | hive-common | 2.3.7 |

| org.apache.hive | hive-exec-core | 2.3.7 |

| org.apache.hive | hive-jdbc | 2.3.7 |

| org.apache.hive | hive-llap-client | 2.3.7 |

| org.apache.hive | hive-llap-common | 2.3.7 |

| org.apache.hive | hive-metastore | 2.3.7 |

| org.apache.hive | hive-serde | 2.3.7 |

| org.apache.hive | hive-shims | 2.3.7 |

| org.apache.hive | hive-storage-api | 2.7.1 |

| org.apache.hive | hive-vector-code-gen | 2.3.7 |

| org.apache.hive.shims | hive-shims-0.23 | 2.3.7 |

| org.apache.hive.shims | hive-shims-common | 2.3.7 |

| org.apache.hive.shims | hive-shims-scheduler | 2.3.7 |

| org.apache.htrace | htrace-core | 3.1.0-incubating |

| org.apache.httpcomponents | httpclient | 4.5.6 |

| org.apache.httpcomponents | httpcore | 4.4.12 |

| org.apache.ivy | klimop | 2.4.0 |

| org.apache.orc | orc-core | 1.5.10 |

| org.apache.orc | orc-mapreduce | 1.5.10 |

| org.apache.orc | orc-shims | 1.5.10 |

| org.apache.parquet | parquet-column | 1.10.1-databricks6 |

| org.apache.parquet | parquet-common | 1.10.1-databricks6 |

| org.apache.parquet | parquet-codering | 1.10.1-databricks6 |

| org.apache.parquet | parquet-indeling | 2.4.0 |

| org.apache.parquet | parquet-hadoop | 1.10.1-databricks6 |

| org.apache.parquet | parquet-jackson | 1.10.1-databricks6 |

| org.apache.thrift | libfb303 | 0.9.3 |

| org.apache.thrift | libthrift | 0.12.0 |

| org.apache.velocity | snelheid | 1.5 |

| org.apache.xbean | xbean-asm7-gearceerd | 4.15 |

| org.apache.yetus | aantekeningen voor doelgroepen | 0.5.0 |

| org.apache.zookeeper | zookeeper | 3.4.14 |

| org.codehaus.jackson | jackson-core-asl | 1.9.13 |

| org.codehaus.jackson | jackson-jaxrs | 1.9.13 |

| org.codehaus.jackson | jackson-mapper-asl | 1.9.13 |

| org.codehaus.jackson | jackson-xc | 1.9.13 |

| org.codehaus.janino | commons-compiler | 3.0.16 |

| org.codehaus.janino | janino | 3.0.16 |

| org.datanucleus | datanucleus-api-jdo | 4.2.4 |

| org.datanucleus | datanucleus-core | 4.1.17 |

| org.datanucleus | datanucleus-rdbms | 4.1.19 |

| org.datanucleus | javax.jdo | 3.2.0-m3 |

| org.eclipse.jetty | jetty-client | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-vervolg | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-http | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-io | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-jndi | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-plus | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-proxy | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-security | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-server | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-servlet | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-servlets | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-util | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-webapp | 9.4.18.v20190429 |

| org.eclipse.jetty | jetty-xml | 9.4.18.v20190429 |

| org.fusesource.leveldbjni | leveldbjni-all | 1.8 |

| org.glassfish.hk2 | hk2-api | 2.6.1 |

| org.glassfish.hk2 | hk2-locator | 2.6.1 |

| org.glassfish.hk2 | hk2-utils | 2.6.1 |

| org.glassfish.hk2 | osgi-resource-locator | 1.0.3 |

| org.glassfish.hk2.external | aopalliance opnieuw verpakt | 2.6.1 |

| org.glassfish.hk2.external | jakarta.inject | 2.6.1 |

| org.glassfish.jersey.containers | jersey-container-servlet | 2.30 |

| org.glassfish.jersey.containers | jersey-container-servlet-core | 2.30 |

| org.glassfish.jersey.core | jersey-client | 2.30 |

| org.glassfish.jersey.core | jersey-common | 2.30 |

| org.glassfish.jersey.core | jersey-server | 2.30 |

| org.glassfish.jersey.inject | jersey-hk2 | 2.30 |

| org.glassfish.jersey.media | jersey-media-jaxb | 2.30 |

| org.hibernate.validator | sluimerstand-validator | 6.1.0.Final |

| org.javassist | javassist | 3.25.0-GA |

| org.jboss.logging | jboss-logging | 3.3.2.Final |

| org.jdbi | jdbi | 2.63.1 |

| org.joda | joda-convert | 1,7 |

| org.jodd | jodd-core | 3.5.2 |

| org.json4s | json4s-ast_2.12 | 3.6.6 |

| org.json4s | json4s-core_2.12 | 3.6.6 |

| org.json4s | json4s-jackson_2.12 | 3.6.6 |

| org.json4s | json4s-scalap_2.12 | 3.6.6 |

| org.lz4 | lz4-java | 1.7.1 |

| org.mariadb.jdbc | mariadb-java-client | 2.1.2 |

| org.objenesis | objenesis | 2.5.1 |

| org.postgresql | postgresql | 42.1.4 |

| org.roaringbitmap | RoaringBitmap | 0.7.45 |

| org.roaringbitmap | Shims | 0.7.45 |

| org.rocksdb | rocksdbjni | 6.2.2 |

| org.rosuda.REngine | REngine | 2.1.0 |

| org.scala-lang | scala-compiler_2.12 | 2.12.10 |

| org.scala-lang | scala-library_2.12 | 2.12.10 |

| org.scala-lang | scala-reflect_2.12 | 2.12.10 |

| org.scala-lang.modules | scala-collection-compat_2.12 | 2.1.1 |

| org.scala-lang.modules | scala-parser-combinators_2.12 | 1.1.2 |

| org.scala-lang.modules | scala-xml_2.12 | 1.2.0 |

| org.scala-sbt | test-interface | 1.0 |

| org.scalacheck | scalacheck_2.12 | 1.14.2 |

| org.scalactic | scalactic_2.12 | 3.0.8 |

| org.scalanlp | breeze-macros_2.12 | 1.0 |

| org.scalanlp | breeze_2.12 | 1.0 |

| org.scalatest | scalatest_2.12 | 3.0.8 |

| org.slf4j | jcl-over-slf4j | 1.7.30 |

| org.slf4j | jul-to-slf4j | 1.7.30 |

| org.slf4j | slf4j-api | 1.7.30 |

| org.slf4j | slf4j-log4j12 | 1.7.30 |

| org.spark-project.spark | ongebruikt | 1.0.0 |

| org.springframework | spring-core | 4.1.4.RELEASE |

| org.springframework | spring-test | 4.1.4.RELEASE |

| org.threeten | threeten-extra | 1.5.0 |

| org.tukaani | xz | 1.5 |

| org.typelevel | algebra_2.12 | 2.0.0-M2 |

| org.typelevel | katten-kernel_2.12 | 2.0.0-M4 |

| org.typelevel | machinist_2.12 | 0.6.8 |

| org.typelevel | macro-compat_2.12 | 1.1.1 |

| org.typelevel | spire-macros_2.12 | 0.17.0-M1 |

| org.typelevel | spire-platform_2.12 | 0.17.0-M1 |

| org.typelevel | spire-util_2.12 | 0.17.0-M1 |

| org.typelevel | spire_2.12 | 0.17.0-M1 |

| org.xerial | sqlite-jdbc | 3.8.11.2 |

| org.xerial.snappy | snappy-java | 1.1.7.5 |

| org.yaml | snakeyaml | 1,24 |

| oro | oro | 2.0.8 |

| pl.edu.icm | JLargeArrays | 1.5 |

| software.amazon.ion | ion-java | 1.0.2 |

| stax | stax-api | 1.0.1 |

| xmlenc | xmlenc | 0,52 |