Gegevens kopiëren en transformeren in Microsoft Fabric Lakehouse met behulp van Azure Data Factory of Azure Synapse Analytics

VAN TOEPASSING OP: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Probeer Data Factory uit in Microsoft Fabric, een alles-in-één analyseoplossing voor ondernemingen. Microsoft Fabric omvat alles, van gegevensverplaatsing tot gegevenswetenschap, realtime analyses, business intelligence en rapportage. Meer informatie over het gratis starten van een nieuwe proefversie .

Microsoft Fabric Lakehouse is een platform voor gegevensarchitectuur voor het opslaan, beheren en analyseren van gestructureerde en ongestructureerde gegevens op één locatie. Als u naadloze toegang tot gegevens wilt krijgen in alle rekenengines in Microsoft Fabric, gaat u naar Lakehouse en Delta Tables voor meer informatie. Standaard worden gegevens geschreven naar Lakehouse Table in V-Order en kunt u naar Delta Lake-tabeloptimalisatie en V-Order gaan voor meer informatie.

In dit artikel wordt beschreven hoe u Copy-activiteit gebruikt om gegevens van en naar Microsoft Fabric Lakehouse te kopiëren en Gegevensstroom te gebruiken om gegevens te transformeren in Microsoft Fabric Lakehouse. Lees het inleidende artikel voor Azure Data Factory of Azure Synapse Analytics voor meer informatie.

Ondersteunde mogelijkheden

Deze Microsoft Fabric Lakehouse-connector wordt ondersteund voor de volgende mogelijkheden:

| Ondersteunde mogelijkheden | IR |

|---|---|

| Copy-activiteit (bron/sink) | (1) (2) |

| Toewijzingsgegevensstroom (bron/sink) | (1) |

| Activiteit Lookup | (1) (2) |

| GetMetadata-activiteit | (1) (2) |

| Activiteit verwijderen | (1) (2) |

(1) Azure Integration Runtime (2) Zelf-hostende Integration Runtime

Aan de slag

Als u de kopieeractiviteit wilt uitvoeren met een pijplijn, kunt u een van de volgende hulpprogramma's of SDK's gebruiken:

- Het hulpprogramma voor het kopiëren van gegevens

- Azure Portal

- De .NET-SDK

- De Python-SDK

- Azure PowerShell

- De REST API

- Een Azure Resource Manager-sjabloon

Een gekoppelde Microsoft Fabric Lakehouse-service maken met behulp van de gebruikersinterface

Gebruik de volgende stappen om een gekoppelde Microsoft Fabric Lakehouse-service te maken in de gebruikersinterface van Azure Portal.

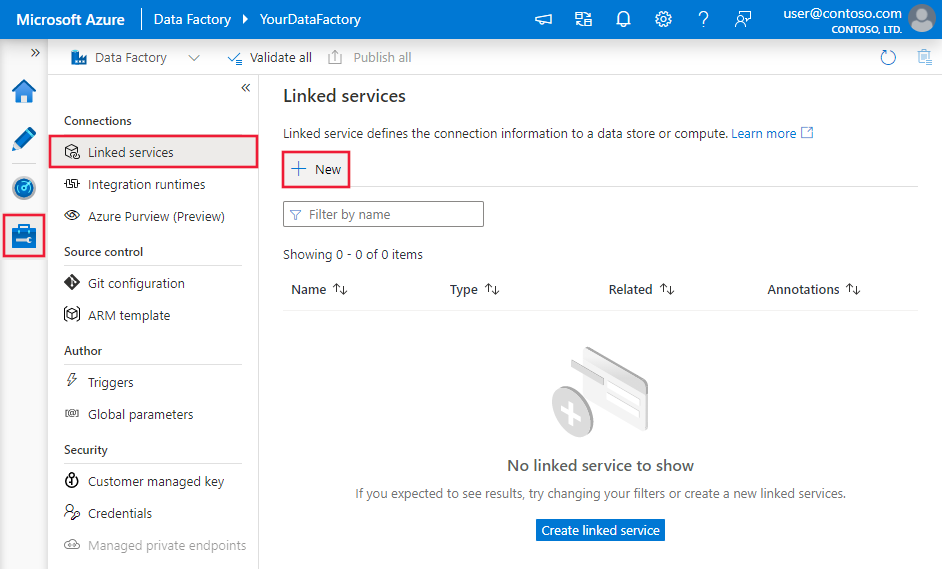

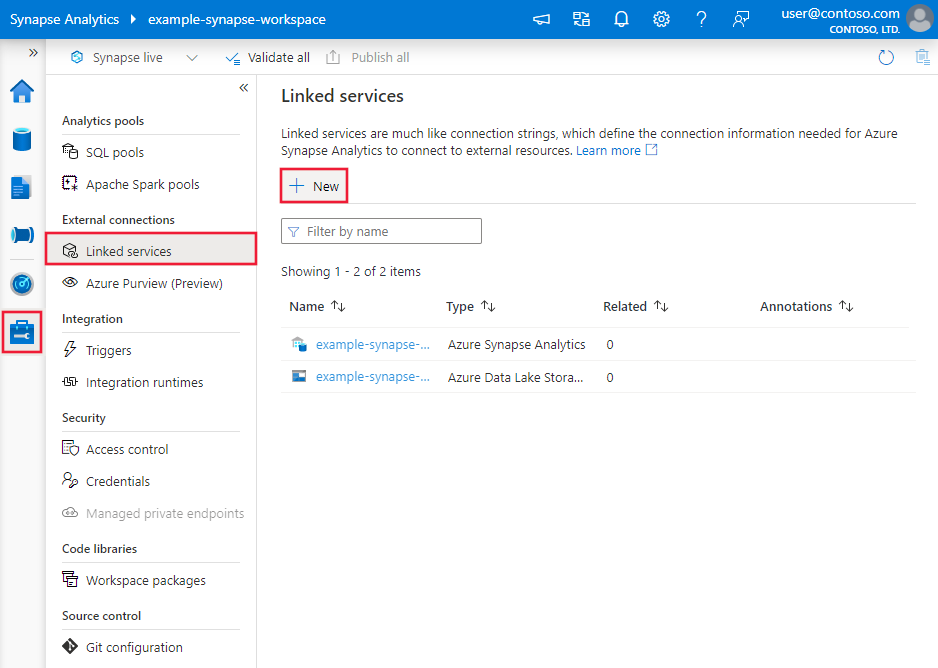

Blader naar het tabblad Beheren in uw Azure Data Factory- of Synapse-werkruimte en selecteer Gekoppelde services en selecteer vervolgens Nieuw:

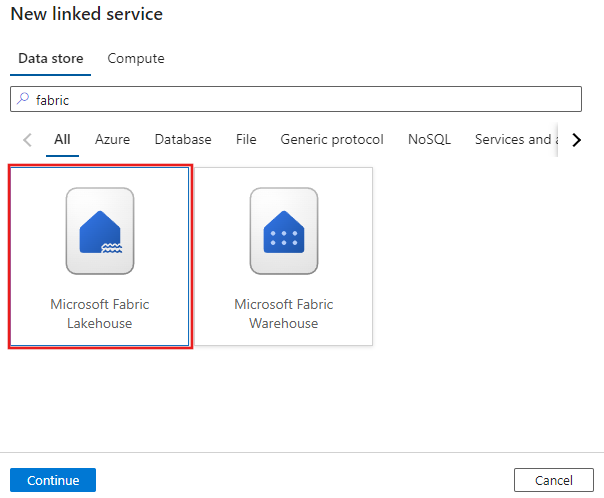

Zoek naar Microsoft Fabric Lakehouse en selecteer de connector.

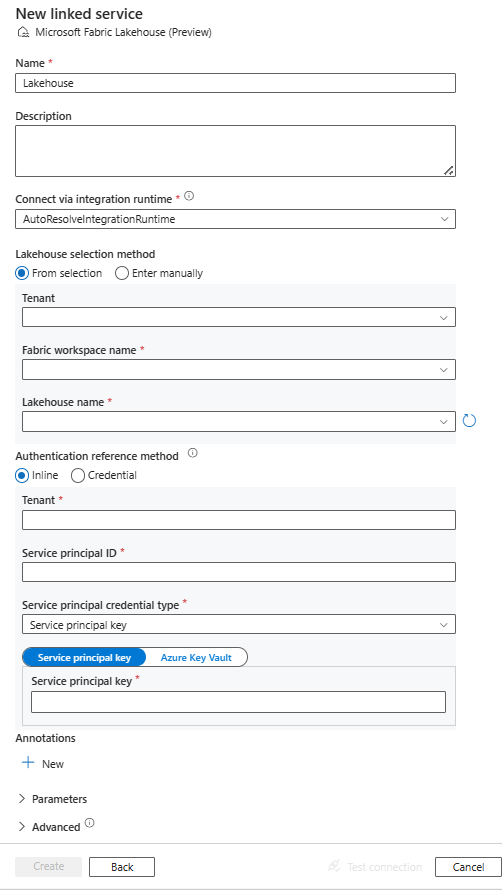

Configureer de servicedetails, test de verbinding en maak de nieuwe gekoppelde service.

Configuratiedetails van connector

De volgende secties bevatten details over eigenschappen die worden gebruikt om Data Factory-entiteiten te definiëren die specifiek zijn voor Microsoft Fabric Lakehouse.

Eigenschappen van gekoppelde service

De Microsoft Fabric Lakehouse-connector ondersteunt de volgende verificatietypen. Zie de bijbehorende secties voor meer informatie:

Verificatie van service-principal

Volg deze stappen om verificatie van de service-principal te gebruiken.

Registreer een toepassing bij het Microsoft Identity Platform en voeg een clientgeheim toe. Noteer daarna deze waarden, die u gebruikt om de gekoppelde service te definiëren:

- Toepassings-id (client), de id van de service-principal in de gekoppelde service.

- Waarde van clientgeheim, de sleutel van de service-principal in de gekoppelde service.

- Tenant-id

Verdeel de service-principal ten minste de rol Inzender in de Microsoft Fabric-werkruimte. Volg vervolgens deze stappen:

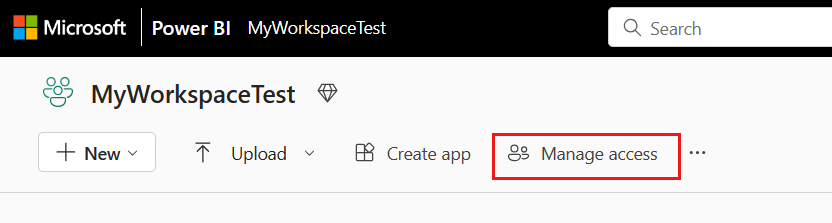

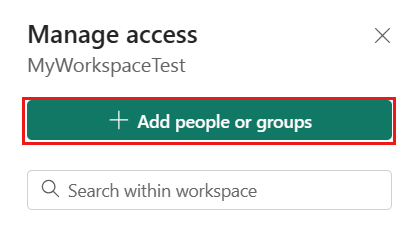

Ga naar uw Microsoft Fabric-werkruimte en selecteer Toegang beheren op de bovenste balk. Selecteer Vervolgens Personen of groepen toevoegen.

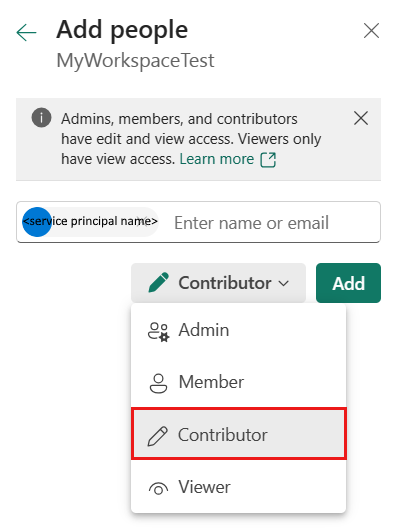

Voer in het deelvenster Personen toevoegen de naam van uw service-principal in en selecteer uw service-principal in de vervolgkeuzelijst.

Notitie

De service-principal wordt niet weergegeven in de lijst Personen toevoegen, tenzij de instellingen van de Power BI-tenant toegang tot Fabric-API's inschakelen.

Geef de rol op als Inzender of hoger (Beheerder, Lid) en selecteer Vervolgens Toevoegen.

Uw service-principal wordt weergegeven in het deelvenster Toegang beheren.

Deze eigenschappen worden ondersteund voor de gekoppelde service:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De eigenschap type moet worden ingesteld op Lakehouse. | Ja |

| workspaceId | De werkruimte-id van Microsoft Fabric. | Ja |

| artifactId | De object-id van Microsoft Fabric Lakehouse. | Ja |

| tenant | Geef de tenantgegevens (domeinnaam of tenant-id) op waaronder uw toepassing zich bevindt. Haal deze op door de muis in de rechterbovenhoek van Azure Portal te bewegen. | Ja |

| servicePrincipalId | Geef de client-id van de toepassing op. | Ja |

| servicePrincipalCredentialType | Het referentietype dat moet worden gebruikt voor verificatie van de service-principal. Toegestane waarden zijn ServicePrincipalKey en ServicePrincipalCert. | Ja |

| servicePrincipalCredential | De referenties van de service-principal. Wanneer u ServicePrincipalKey als referentietype gebruikt, geeft u de waarde van het clientgeheim van de toepassing op. Markeer dit veld als SecureString om het veilig op te slaan of verwijs naar een geheim dat is opgeslagen in Azure Key Vault. Wanneer u ServicePrincipalCert als referentie gebruikt, verwijst u naar een certificaat in Azure Key Vault en zorgt u ervoor dat het certificaatinhoudstype PKCS #12 is. |

Ja |

| connectVia | De Integration Runtime die moet worden gebruikt om verbinding te maken met het gegevensarchief. U kunt de Azure Integration Runtime of een zelf-hostende Integration Runtime gebruiken als uw gegevensarchief zich in een particulier netwerk bevindt. Als dit niet is opgegeven, wordt de standaard Azure Integration Runtime gebruikt. | Nee |

Voorbeeld: verificatie van de service-principalsleutel gebruiken

U kunt ook een service-principalsleutel opslaan in Azure Key Vault.

{

"name": "MicrosoftFabricLakehouseLinkedService",

"properties": {

"type": "Lakehouse",

"typeProperties": {

"workspaceId": "<Microsoft Fabric workspace ID>",

"artifactId": "<Microsoft Fabric Lakehouse object ID>",

"tenant": "<tenant info, e.g. microsoft.onmicrosoft.com>",

"servicePrincipalId": "<service principal id>",

"servicePrincipalCredentialType": "ServicePrincipalKey",

"servicePrincipalCredential": {

"type": "SecureString",

"value": "<service principal key>"

}

},

"connectVia": {

"referenceName": "<name of Integration Runtime>",

"type": "IntegrationRuntimeReference"

}

}

}

Eigenschappen van gegevensset

De Microsoft Fabric Lakehouse-connector ondersteunt twee typen gegevenssets. Dit zijn microsoft Fabric Lakehouse Files-gegevensset en Microsoft Fabric Lakehouse Table-gegevensset. Zie de bijbehorende secties voor meer informatie.

Microsoft Fabric Lakehouse Files-gegevensset

Microsoft Fabric Lakehouse-connector ondersteunt de volgende bestandsindelingen. Raadpleeg elk artikel voor op indeling gebaseerde instellingen.

- Avro-indeling

- Binaire indeling

- Tekstindeling met scheidingstekens

- JSON-indeling

- ORC-indeling

- Parquet-indeling

De volgende eigenschappen worden ondersteund onder location instellingen in de op indeling gebaseerde Microsoft Fabric Lakehouse Files-gegevensset:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De typeeigenschap onder location in de gegevensset moet worden ingesteld op LakehouseLocation. |

Ja |

| folderPath | Het pad naar een map. Als u een jokerteken wilt gebruiken om mappen te filteren, slaat u deze instelling over en geeft u deze op in de instellingen van de activiteitsbron. | Nee |

| fileName | De bestandsnaam onder het opgegeven folderPath. Als u een jokerteken wilt gebruiken om bestanden te filteren, slaat u deze instelling over en geeft u deze op in de instellingen van de activiteitsbron. | Nee |

Voorbeeld:

{

"name": "DelimitedTextDataset",

"properties": {

"type": "DelimitedText",

"linkedServiceName": {

"referenceName": "<Microsoft Fabric Lakehouse linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"location": {

"type": "LakehouseLocation",

"fileName": "<file name>",

"folderPath": "<folder name>"

},

"columnDelimiter": ",",

"compressionCodec": "gzip",

"escapeChar": "\\",

"firstRowAsHeader": true,

"quoteChar": "\""

},

"schema": [ < physical schema, optional, auto retrieved during authoring > ]

}

}

Microsoft Fabric Lakehouse Table-gegevensset

De volgende eigenschappen worden ondersteund voor microsoft Fabric Lakehouse Table-gegevensset:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De typeeigenschap van de gegevensset moet worden ingesteld op LakehouseTable. | Ja |

| schema | Naam van het schema. Als dit niet is opgegeven, is dbode standaardwaarde . |

Nee |

| table | De naam van de tabel. De tabelnaam moet ten minste één teken lang zijn, zonder '/' of '\', geen volgpunt en geen voorloop- of volgspaties. | Ja |

Voorbeeld:

{

"name": "LakehouseTableDataset",

"properties": {

"type": "LakehouseTable",

"linkedServiceName": {

"referenceName": "<Microsoft Fabric Lakehouse linked service name>",

"type": "LinkedServiceReference"

},

"typeProperties": {

"schema": "<schema_name>",

"table": "<table_name>"

},

"schema": [< physical schema, optional, retrievable during authoring >]

}

}

Eigenschappen van de kopieeractiviteit

De eigenschappen van de kopieeractiviteit voor de gegevensset Microsoft Fabric Lakehouse Files en microsoft Fabric Lakehouse Table verschillen. Zie de bijbehorende secties voor meer informatie.

- Microsoft Fabric Lakehouse Files in Copy-activiteit

- Microsoft Fabric Lakehouse Table in Copy-activiteit

Zie Copy-activiteit configuraties en pijplijnen en activiteiten voor een volledige lijst met secties en eigenschappen die beschikbaar zijn voor het definiëren van activiteiten.

Microsoft Fabric Lakehouse Files in Copy-activiteit

Als u het gegevenssettype Microsoft Fabric Lakehouse Files wilt gebruiken als bron of sink in Copy-activiteit, gaat u naar de volgende secties voor de gedetailleerde configuraties.

Microsoft Fabric Lakehouse Files als brontype

Microsoft Fabric Lakehouse-connector ondersteunt de volgende bestandsindelingen. Raadpleeg elk artikel voor op indeling gebaseerde instellingen.

- Avro-indeling

- Binaire indeling

- Tekstindeling met scheidingstekens

- JSON-indeling

- ORC-indeling

- Parquet-indeling

U hebt verschillende opties voor het kopiëren van gegevens uit Microsoft Fabric Lakehouse met behulp van de gegevensset Microsoft Fabric Lakehouse Files:

- Kopieer vanuit het opgegeven pad dat is opgegeven in de gegevensset.

- Jokertekenfilter tegen mappad of bestandsnaam, zie

wildcardFolderPathenwildcardFileName. - Kopieer de bestanden die zijn gedefinieerd in een bepaald tekstbestand als bestandsset.

fileListPath

De volgende eigenschappen bevinden zich onder storeSettings instellingen in op indeling gebaseerde kopieerbron bij het gebruik van de gegevensset Microsoft Fabric Lakehouse Files:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De eigenschap type onder storeSettings moet worden ingesteld op LakehouseReadSettings. |

Ja |

| Zoek de bestanden die u wilt kopiëren: | ||

| OPTIE 1: statisch pad |

Kopieer de map/het bestandspad dat is opgegeven in de gegevensset. Als u alle bestanden uit een map wilt kopiëren, moet u ook opgeven wildcardFileName als *. |

|

| OPTIE 2: jokerteken - jokertekenFolderPath |

Het pad naar de map met jokertekens om bronmappen te filteren. Toegestane jokertekens zijn: * (komt overeen met nul of meer tekens) en ? (komt overeen met nul of één teken); gebruik ^ deze optie om te ontsnappen als de naam van de map een jokerteken heeft of dit escape-teken bevat. Bekijk meer voorbeelden in voorbeelden van mappen en bestandsfilters. |

Nee |

| OPTIE 2: jokerteken - wildcardFileName |

De bestandsnaam met jokertekens onder het opgegeven folderPath/wildcardFolderPath om bronbestanden te filteren. Toegestane jokertekens zijn: * (komt overeen met nul of meer tekens) en ? (komt overeen met nul of één teken); gebruik ^ deze optie om te ontsnappen als uw werkelijke bestandsnaam jokertekens of dit escapeteken bevat. Bekijk meer voorbeelden in voorbeelden van mappen en bestandsfilters. |

Ja |

| OPTIE 3: een lijst met bestanden - fileListPath |

Geeft aan om een bepaalde bestandsset te kopiëren. Wijs een tekstbestand aan met een lijst met bestanden die u wilt kopiëren, één bestand per regel. Dit is het relatieve pad naar het pad dat is geconfigureerd in de gegevensset. Wanneer u deze optie gebruikt, geeft u geen bestandsnaam op in de gegevensset. Bekijk meer voorbeelden in voorbeelden van de lijst met bestanden. |

Nee |

| Aanvullende instellingen: | ||

| recursief | Hiermee wordt aangegeven of de gegevens recursief worden gelezen uit de submappen of alleen uit de opgegeven map. Wanneer recursief is ingesteld op true en de sink een archief op basis van bestanden is, wordt een lege map of submap niet gekopieerd of gemaakt in de sink. Toegestane waarden zijn waar (standaard) en onwaar. Deze eigenschap is niet van toepassing wanneer u configureert fileListPath. |

Nee |

| deleteFilesAfterCompletion | Geeft aan of de binaire bestanden worden verwijderd uit het bronarchief nadat ze naar het doelarchief zijn verplaatst. Het verwijderen van bestanden is per bestand, dus wanneer de kopieeractiviteit mislukt, ziet u dat sommige bestanden al naar het doel zijn gekopieerd en uit de bron zijn verwijderd, terwijl anderen nog steeds in het bronarchief blijven. Deze eigenschap is alleen geldig in het scenario voor het kopiëren van binaire bestanden. De standaardwaarde: false. |

Nee |

| modifiedDatetimeStart | Bestandenfilter op basis van het kenmerk: Laatst gewijzigd. De bestanden worden geselecteerd als de laatste wijzigingstijd groter is dan of gelijk is aan modifiedDatetimeStart en kleiner is dan modifiedDatetimeEnd. De tijd wordt toegepast op utc-tijdzone in de notatie 2018-12-01T05:00:00Z. De eigenschappen kunnen NULL zijn, wat betekent dat er geen bestandskenmerkfilter wordt toegepast op de gegevensset. Wanneer modifiedDatetimeStart een datum/tijd-waarde heeft maar modifiedDatetimeEnd NULL is, betekent dit dat de bestanden waarvan het laatst gewijzigde kenmerk groter is dan of gelijk is aan de datum/tijd-waarde worden geselecteerd. Wanneer modifiedDatetimeEnd de datum/tijd-waarde is, maar modifiedDatetimeStart NULL is, betekent dit dat de bestanden waarvan het kenmerk voor het laatst is gewijzigd kleiner is dan de datum/tijd-waarde wordt geselecteerd.Deze eigenschap is niet van toepassing wanneer u configureert fileListPath. |

Nee |

| modifiedDatetimeEnd | Hetzelfde als hierboven. | Nee |

| enablePartitionDiscovery | Geef voor bestanden die zijn gepartitioneerd op of de partities van het bestandspad moeten worden geparseerd en als andere bronkolommen moeten worden toegevoegd. Toegestane waarden zijn onwaar (standaard) en waar. |

Nee |

| partitionRootPath | Wanneer partitiedetectie is ingeschakeld, geeft u het absolute hoofdpad op om gepartitioneerde mappen als gegevenskolommen te lezen. Als deze niet is opgegeven, is dit standaard - Wanneer u bestandspad gebruikt in de gegevensset of lijst met bestanden op de bron, is het pad naar de partitiehoofdmap dat is geconfigureerd in de gegevensset. - Wanneer u het filter voor jokertekens gebruikt, is het hoofdpad van de partitie het subpad vóór het eerste jokerteken. Stel dat u het pad in de gegevensset configureert als 'root/folder/year=2020/month=08/day=27': - Als u het partitiehoofdpad opgeeft als root/folder/year=2020, genereert de kopieeractiviteit twee kolommen month en day met respectievelijk de waarde 08 en 27, naast de kolommen in de bestanden.- Als het hoofdpad van de partitie niet is opgegeven, wordt er geen extra kolom gegenereerd. |

Nee |

| maxConcurrentConnections | De bovengrens van gelijktijdige verbindingen die tijdens de uitvoering van de activiteit tot stand zijn gebracht met het gegevensarchief. Geef alleen een waarde op wanneer u gelijktijdige verbindingen wilt beperken. | Nee |

Voorbeeld:

"activities": [

{

"name": "CopyFromLakehouseFiles",

"type": "Copy",

"inputs": [

{

"referenceName": "<Delimited text input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "DelimitedTextSource",

"storeSettings": {

"type": "LakehouseReadSettings",

"recursive": true,

"enablePartitionDiscovery": false

},

"formatSettings": {

"type": "DelimitedTextReadSettings"

}

},

"sink": {

"type": "<sink type>"

}

}

}

]

Microsoft Fabric Lakehouse Files als sinktype

Microsoft Fabric Lakehouse-connector ondersteunt de volgende bestandsindelingen. Raadpleeg elk artikel voor op indeling gebaseerde instellingen.

- Avro-indeling

- Binaire indeling

- Tekstindeling met scheidingstekens

- JSON-indeling

- ORC-indeling

- Parquet-indeling

De volgende eigenschappen bevinden zich onder storeSettings instellingen in de op indeling gebaseerde kopiesink wanneer u de gegevensset Microsoft Fabric Lakehouse Files gebruikt:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De typeeigenschap onder storeSettings moet worden ingesteld op LakehouseWriteSettings. |

Ja |

| copyBehavior | Definieert het kopieergedrag wanneer de bron bestanden is uit een gegevensarchief op basis van bestanden. Toegestane waarden zijn: - PreserveHierarchy (standaard): behoudt de bestandshiërarchie in de doelmap. Het relatieve pad van het bronbestand naar de bronmap is identiek aan het relatieve pad van het doelbestand naar de doelmap. - FlattenHierarchy: Alle bestanden uit de bronmap bevinden zich op het eerste niveau van de doelmap. De doelbestanden hebben automatisch gegenereerde namen. - MergeFiles: hiermee worden alle bestanden uit de bronmap samengevoegd tot één bestand. Als de bestandsnaam is opgegeven, is de naam van het samengevoegde bestand de opgegeven naam. Anders is het een automatisch gegenereerde bestandsnaam. |

Nee |

| blockSizeInMB | Geef de blokgrootte op in MB die wordt gebruikt voor het schrijven van gegevens naar Microsoft Fabric Lakehouse. Meer informatie over blok-blobs. De toegestane waarde ligt tussen 4 MB en 100 MB. Standaard bepaalt ADF automatisch de blokgrootte op basis van het type bronarchief en gegevens. Voor niet-binaire kopie in Microsoft Fabric Lakehouse is de standaardblokgrootte 100 MB, zodat deze maximaal 4,75 TB aan gegevens past. Het is mogelijk niet optimaal wanneer uw gegevens niet groot zijn, met name wanneer u zelf-hostende Integration Runtime gebruikt met een slecht netwerk, wat resulteert in een time-out van bewerkingen of prestatieproblemen. U kunt expliciet een blokgrootte opgeven, terwijl blockSizeInMB*50000 groot genoeg is om de gegevens op te slaan, anders mislukt de kopieeractiviteit. |

Nee |

| maxConcurrentConnections | De bovengrens van gelijktijdige verbindingen die tijdens de uitvoering van de activiteit tot stand zijn gebracht met het gegevensarchief. Geef alleen een waarde op wanneer u gelijktijdige verbindingen wilt beperken. | Nee |

| metagegevens | Stel aangepaste metagegevens in wanneer u kopieert naar sink. Elk object onder de metadata matrix vertegenwoordigt een extra kolom. De name naam van de metagegevenssleutel wordt gedefinieerd en de value gegevenswaarde van die sleutel wordt aangegeven. Als de kenmerkfunctie behouden wordt gebruikt, worden de opgegeven metagegevens samengevoegd/overschreven met de metagegevens van het bronbestand.Toegestane gegevenswaarden zijn: - $$LASTMODIFIED: een gereserveerde variabele geeft aan dat de laatste wijzigingstijd van de bronbestanden moet worden opgeslagen. Alleen van toepassing op een bron op basis van bestanden met binaire indeling.-Uitdrukking - Statische waarde |

Nee |

Voorbeeld:

"activities": [

{

"name": "CopyToLakehouseFiles",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Parquet output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "ParquetSink",

"storeSettings": {

"type": "LakehouseWriteSettings",

"copyBehavior": "PreserveHierarchy",

"metadata": [

{

"name": "testKey1",

"value": "value1"

},

{

"name": "testKey2",

"value": "value2"

}

]

},

"formatSettings": {

"type": "ParquetWriteSettings"

}

}

}

}

]

Voorbeelden van map- en bestandsfilters

In deze sectie wordt het resulterende gedrag van het mappad en de bestandsnaam met jokertekenfilters beschreven.

| folderPath | fileName | recursief | Structuur van bronmap en filterresultaat (bestanden vetgedrukt worden opgehaald) |

|---|---|---|---|

Folder* |

(Leeg, standaard gebruiken) | false | MapA File1.csv File2.json Submap1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Folder* |

(Leeg, standaard gebruiken) | true | MapA File1.csv File2.json Submap1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Folder* |

*.csv |

false | MapA File1.csv File2.json Submap1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Folder* |

*.csv |

true | MapA File1.csv File2.json Submap1 File3.csv File4.json File5.csv AnotherFolderB File6.csv |

Voorbeelden van bestandslijsten

In deze sectie wordt het resulterende gedrag beschreven van het gebruik van bestandslijstpad in bron van kopieeractiviteit.

Ervan uitgaande dat u de volgende bronmapstructuur hebt en de bestanden vetgedrukt wilt kopiëren:

| Voorbeeldbronstructuur | Inhoud in FileListToCopy.txt | ADF-configuratie |

|---|---|---|

| bestandssysteem MapA File1.csv File2.json Submap1 File3.csv File4.json File5.csv Metagegevens FileListToCopy.txt |

File1.csv Submap1/File3.csv Submap1/File5.csv |

In gegevensset: - Mappad: FolderAIn bron van kopieeractiviteit: - Pad naar bestandslijst: Metadata/FileListToCopy.txt Het bestandslijstpad verwijst naar een tekstbestand in hetzelfde gegevensarchief met een lijst met bestanden die u wilt kopiëren, één bestand per regel met het relatieve pad naar het pad dat is geconfigureerd in de gegevensset. |

Enkele recursieve en copyBehavior-voorbeelden

In deze sectie wordt het resulterende gedrag van de kopieerbewerking beschreven voor verschillende combinaties van recursieve en copyBehavior-waarden.

| recursief | copyBehavior | Structuur van bronmap | Resulterend doel |

|---|---|---|---|

| true | preserveHierarchy | Map1 Bestand1 Bestand2 Submap1 Bestand3 Bestand4 Bestand5 |

De doelmap1 wordt gemaakt met dezelfde structuur als de bron: Map1 Bestand1 Bestand2 Submap1 Bestand3 Bestand4 Bestand5 |

| true | flattenHierarchy | Map1 Bestand1 Bestand2 Submap1 Bestand3 Bestand4 Bestand5 |

De doelmap1 wordt gemaakt met de volgende structuur: Map1 automatisch gegenereerde naam voor Bestand1 automatisch gegenereerde naam voor File2 automatisch gegenereerde naam voor File3 automatisch gegenereerde naam voor File4 automatisch gegenereerde naam voor File5 |

| true | mergeFiles | Map1 Bestand1 Bestand2 Submap1 Bestand3 Bestand4 Bestand5 |

De doelmap1 wordt gemaakt met de volgende structuur: Map1 File1 + File2 + File3 + File4 + File5-inhoud worden samengevoegd in één bestand met een automatisch gegenereerde bestandsnaam. |

| false | preserveHierarchy | Map1 Bestand1 Bestand2 Submap1 Bestand3 Bestand4 Bestand5 |

De doelmap1 wordt gemaakt met de volgende structuur: Map1 Bestand1 Bestand2 Submap1 met File3, File4 en File5 wordt niet opgehaald. |

| false | flattenHierarchy | Map1 Bestand1 Bestand2 Submap1 Bestand3 Bestand4 Bestand5 |

De doelmap1 wordt gemaakt met de volgende structuur: Map1 automatisch gegenereerde naam voor Bestand1 automatisch gegenereerde naam voor File2 Submap1 met File3, File4 en File5 wordt niet opgehaald. |

| false | mergeFiles | Map1 Bestand1 Bestand2 Submap1 Bestand3 Bestand4 Bestand5 |

De doelmap1 wordt gemaakt met de volgende structuur: Map1 De inhoud van Bestand1 + File2 wordt samengevoegd in één bestand met een automatisch gegenereerde bestandsnaam. automatisch gegenereerde naam voor Bestand1 Submap1 met File3, File4 en File5 wordt niet opgehaald. |

Microsoft Fabric Lakehouse Table in Copy-activiteit

Als u microsoft Fabric Lakehouse Table-gegevensset wilt gebruiken als bron- of sinkgegevensset in Copy-activiteit, gaat u naar de volgende secties voor de gedetailleerde configuraties.

Microsoft Fabric Lakehouse Table als brontype

Als u gegevens uit Microsoft Fabric Lakehouse wilt kopiëren met behulp van de gegevensset Microsoft Fabric Lakehouse Table, stelt u de typeeigenschap in de Copy-activiteit bron in op LakehouseTableSource. De volgende eigenschappen worden ondersteund in de Copy-activiteit bronsectie:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De typeeigenschap van de bron van de kopieeractiviteit moet worden ingesteld op LakehouseTableSource. | Ja |

| timestampAsOf | De tijdstempel om een query uit te voeren op een oudere momentopname. | Nee |

| versionAsOf | De versie om een query uit te voeren op een oudere momentopname. | Nee |

Voorbeeld:

"activities":[

{

"name": "CopyFromLakehouseTable",

"type": "Copy",

"inputs": [

{

"referenceName": "<Microsoft Fabric Lakehouse Table input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "LakehouseTableSource",

"timestampAsOf": "2023-09-23T00:00:00.000Z",

"versionAsOf": 2

},

"sink": {

"type": "<sink type>"

}

}

}

]

Microsoft Fabric Lakehouse Table als sinktype

Als u gegevens wilt kopiëren naar Microsoft Fabric Lakehouse met behulp van microsoft Fabric Lakehouse Table-gegevensset, stelt u de typeeigenschap in de sink copy activity in op LakehouseTableSink. De volgende eigenschappen worden ondersteund in de sectie Copy-activiteit sink:

| Eigenschappen | Beschrijving | Vereist |

|---|---|---|

| type | De typeeigenschap van de bron van de kopieeractiviteit moet worden ingesteld op LakehouseTableSink. | Ja |

Notitie

Gegevens worden standaard geschreven naar Lakehouse Table in V-Order. Ga voor meer informatie naar Optimalisatie van Delta Lake-tabellen en V-Order.

Voorbeeld:

"activities":[

{

"name": "CopyToLakehouseTable",

"type": "Copy",

"inputs": [

{

"referenceName": "<input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<Microsoft Fabric Lakehouse Table output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "<source type>"

},

"sink": {

"type": "LakehouseTableSink",

"tableActionOption ": "Append"

}

}

}

]

Eigenschappen van toewijzingsgegevensstroom

Wanneer u gegevens transformeert in de toewijzingsgegevensstroom, kunt u bestanden of tabellen lezen en schrijven in Microsoft Fabric Lakehouse. Zie de bijbehorende secties voor meer informatie.

- Microsoft Fabric Lakehouse Files in toewijzingsgegevensstroom

- Microsoft Fabric Lakehouse Table in toewijzingsgegevensstroom

Zie de brontransformatie en sinktransformatie in toewijzingsgegevensstromen voor meer informatie.

Microsoft Fabric Lakehouse Files in toewijzingsgegevensstroom

Als u de gegevensset Microsoft Fabric Lakehouse Files wilt gebruiken als bron- of sinkgegevensset in de toewijzingsgegevensstroom, gaat u naar de volgende secties voor de gedetailleerde configuraties.

Microsoft Fabric Lakehouse-bestanden als bron- of sinktype

Microsoft Fabric Lakehouse-connector ondersteunt de volgende bestandsindelingen. Raadpleeg elk artikel voor op indeling gebaseerde instellingen.

Als u een Fabric Lakehouse-connector wilt gebruiken in het type inlinegegevensset, moet u het juiste inlinegegevenssettype voor uw gegevens kiezen. U kunt DelimitedText, Avro, JSON, ORC of Parquet gebruiken, afhankelijk van uw gegevensindeling.

Microsoft Fabric Lakehouse Table in toewijzingsgegevensstroom

Als u microsoft Fabric Lakehouse Table-gegevensset wilt gebruiken als bron- of sinkgegevensset in de toewijzingsgegevensstroom, gaat u naar de volgende secties voor de gedetailleerde configuraties.

Microsoft Fabric Lakehouse Table als brontype

Er zijn geen configureerbare eigenschappen onder bronopties.

Notitie

CDC-ondersteuning voor Lakehouse-tabelbron is momenteel niet beschikbaar.

Microsoft Fabric Lakehouse Table als sinktype

De volgende eigenschappen worden ondersteund in de sectie Mapping Gegevensstroom s sink:

| Name | Beschrijving | Vereist | Toegestane waarden | Eigenschap gegevensstroomscript |

|---|---|---|---|---|

| Bijwerkingsmethode | Wanneer u alleen Invoegen toestaan selecteert of wanneer u naar een nieuwe deltatabel schrijft, ontvangt het doel alle binnenkomende rijen, ongeacht de set Met beleidsregels voor rijen. Als uw gegevens rijen met andere rijbeleidsregels bevatten, moeten ze worden uitgesloten met behulp van een voorgaande filtertransformatie. Wanneer alle updatemethoden zijn geselecteerd, wordt een samenvoeging uitgevoerd, waarbij rijen worden ingevoegd/verwijderd/upserted/bijgewerkt volgens de set Rijbeleid met behulp van een voorgaande transformatie voor het wijzigen van rijen. |

ja |

true of false |

invoegbaar te verwijderen upsertable kan worden bijgewerkt |

| Geoptimaliseerde schrijfbewerking | Behaalt een hogere doorvoer voor schrijfbewerkingen via het optimaliseren van interne shuffle in Spark-uitvoerders. Als gevolg hiervan ziet u mogelijk minder partities en bestanden die groter zijn | nee |

true of false |

optimizedWrite: true |

| Automatisch comprimeren | Nadat een schrijfbewerking is voltooid, voert Spark automatisch de OPTIMIZE opdracht uit om de gegevens opnieuw te ordenen, wat resulteert in meer partities, indien nodig, voor betere leesprestaties in de toekomst |

nee |

true of false |

autoCompact: true |

| Schema samenvoegen | Met de optie Schema samenvoegen kunnen schema's worden ontwikkeld, dat wil gezegd, alle kolommen die aanwezig zijn in de huidige binnenkomende stroom, maar niet in de doel-Delta-tabel, worden automatisch toegevoegd aan het schema. Deze optie wordt ondersteund voor alle updatemethoden. | nee |

true of false |

mergeSchema: true |

Voorbeeld: Microsoft Fabric Lakehouse Table Sink

sink(allowSchemaDrift: true,

validateSchema: false,

input(

CustomerID as string,

NameStyle as string,

Title as string,

FirstName as string,

MiddleName as string,

LastName as string,

Suffix as string,

CompanyName as string,

SalesPerson as string,

EmailAddress as string,

Phone as string,

PasswordHash as string,

PasswordSalt as string,

rowguid as string,

ModifiedDate as string

),

deletable:false,

insertable:true,

updateable:false,

upsertable:false,

optimizedWrite: true,

mergeSchema: true,

autoCompact: true,

skipDuplicateMapInputs: true,

skipDuplicateMapOutputs: true) ~> CustomerTable

Voor fabric Lakehouse-connector op basis van tabellen in het inlinegegevenssettype hoeft u Alleen Delta als gegevenssettype te gebruiken. Hiermee kunt u gegevens lezen en schrijven uit Fabric Lakehouse-tabellen.

Eigenschappen van opzoekactiviteit

Als u meer wilt weten over de eigenschappen, controleert u de lookup-activiteit.

Eigenschappen van GetMetadata-activiteit

Als u meer wilt weten over de eigenschappen, controleert u de Activiteit GetMetadata

Activiteitseigenschappen verwijderen

Als u meer wilt weten over de eigenschappen, controleert u De activiteit Verwijderen

Gerelateerde inhoud

Zie Ondersteunde gegevensarchieven voor een lijst met gegevensarchieven die worden ondersteund als bronnen en sinks door de kopieeractiviteit.