Use-casedefinitie

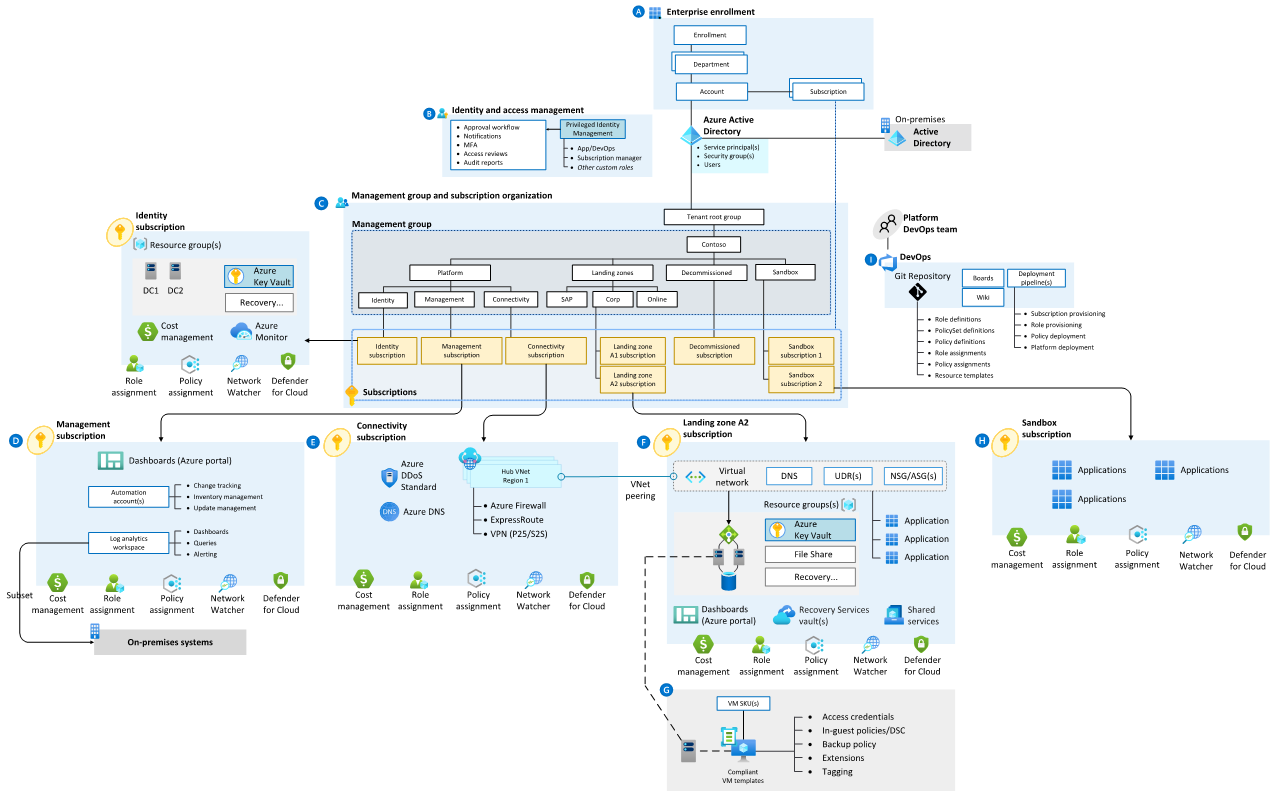

Ter ondersteuning van dit werkvoorbeeld wordt het fictieve bedrijf Contoso gebruikt met een Azure Data Platform op basis van Microsoft Reference Architectures.

Data Service - Onderdeelweergave

Contoso heeft de volgende fundamentele Azure-architectuur geïmplementeerd. Dit is een subset van het enterprise landingszone-ontwerp .

De getallen in de volgende beschrijvingen komen overeen met het bovenstaande diagram.

Azure Foundations van Contoso - Werkstroom

- Enterprise-inschrijving : de bovenste bovenliggende enterprise-inschrijving van Contoso binnen Azure weerspiegelt de commerciële overeenkomst met Microsoft, de organisatieaccountstructuur en beschikbare Azure-abonnementen. Het biedt de factureringsbasis voor abonnementen en hoe de digitale activa worden beheerd.

- Identiteits- en toegangsbeheer : de onderdelen die nodig zijn om identiteits-, verificatie-, resourcetoegangs- en autorisatieservices te bieden in de Azure-omgeving van Contoso.

- Beheergroep en abonnementsorganisatie : een schaalbare groepshiërarchie die is afgestemd op de kernmogelijkheden van het gegevensplatform, waardoor operationalisatie op schaal mogelijk is met behulp van centraal beheerde beveiliging en governance, waarbij workloads duidelijke scheiding hebben. Beheergroepen bieden een beheerbereik boven abonnementen.

- Beheerabonnement : een toegewezen abonnement voor de verschillende functies op beheerniveau die vereist zijn om het gegevensplatform te ondersteunen.

- Connectiviteitsabonnement : een toegewezen abonnement voor de connectiviteitsfuncties van het gegevensplatform, zodat het benoemde services kan identificeren, veilige routering en communicatie tussen interne en externe services kan bepalen.

- Abonnement op landingszone : een-op-veel-abonnementen voor systeemeigen Azure-toepassingen, onlinetoepassingen, interne en externe workloads en resources

- DevOps-platform : het DevOps-platform dat ondersteuning biedt voor de hele Azure-estate. Dit platform bevat de opslagplaats voor broncodebeheer van de code en CI/CD-pijplijnen die geautomatiseerde implementaties van infrastructuur als code (IaC) mogelijk maken.

Notitie

Veel klanten behouden nog steeds een grote IaaS-footprint (Infrastructure as a Service). Het belangrijkste onderdeel dat moet worden toegevoegd, is Azure Site Recovery om herstelmogelijkheden te bieden in IaaS. Site Recovery organiseert en automatiseert de replicatie van Virtuele Azure-machines tussen regio's, on-premises virtuele machines en fysieke servers naar Azure en on-premises machines naar een secundair datacenter.

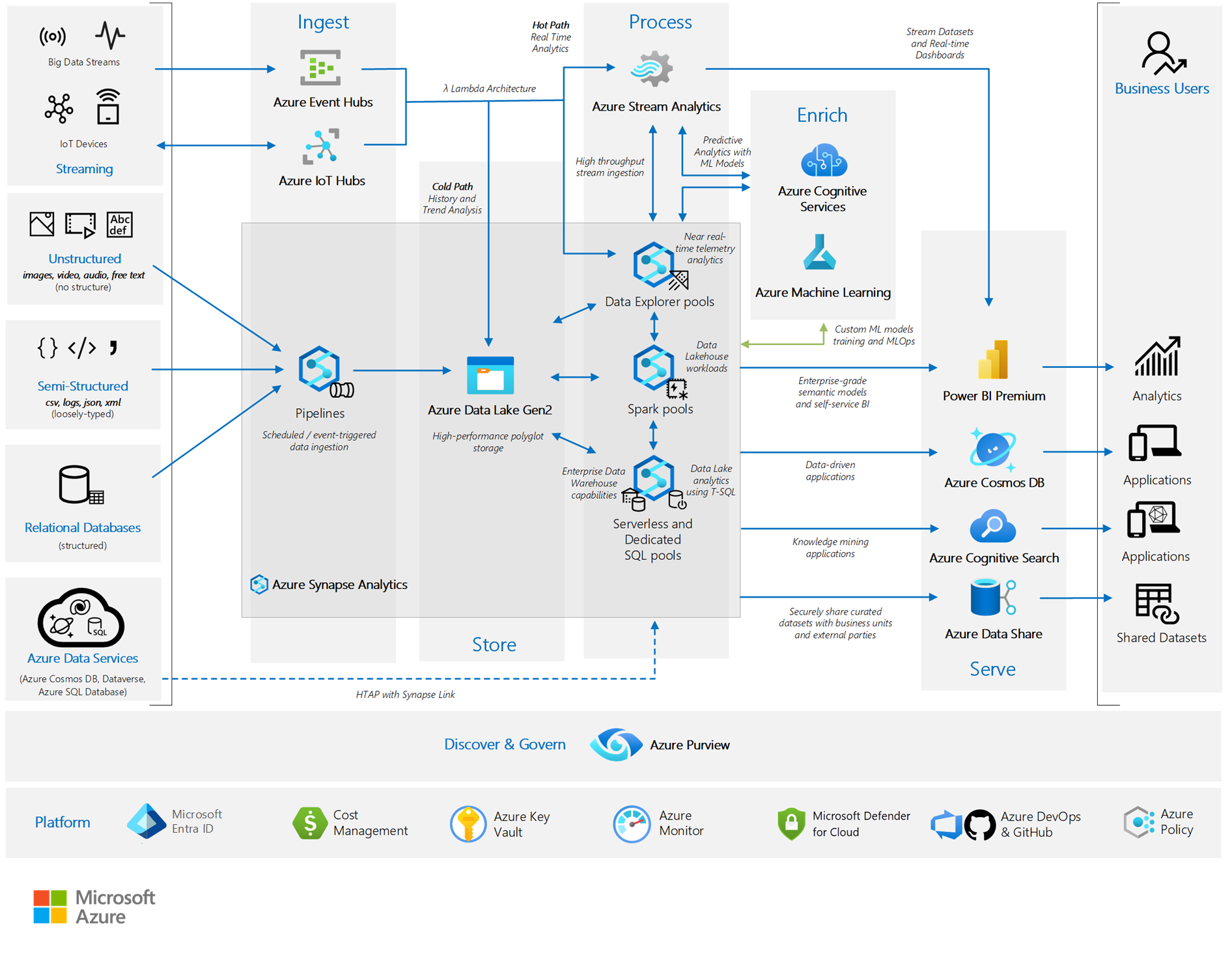

In deze basisstructuur heeft Contoso de volgende elementen geïmplementeerd ter ondersteuning van de bedrijfsinformatiebehoeften, afgestemd op de richtlijnen in Analytics end-to-end met Azure Synapse.

Het gegevensplatform van Contoso

Het gegevensplatform van Contoso

Gegevensplatform van Contoso - Werkstroom

De werkstroom wordt van links naar rechts gelezen na de gegevensstroom:

- Gegevensbronnen : de bronnen of typen gegevens waaruit het gegevensplatform gebruik kan maken.

- Opnemen: de mogelijkheid van het platform om gegevens op te nemen uit verschillende bronnen van verschillende structuur en snelheid. Dit ontwerp weerspiegelt een Lambda-architectuur.

- Store : de mogelijkheid om gegevens veilig op schaal op te slaan die zijn opgenomen op het platform.

- Proces : de mogelijkheid van het platform om gegevens te verwerken, waardoor deze 'geschikt voor doel' zijn voor downstreamprocessen, zoals opschonen, standaardiseren en modelleren. De voorverwerking van gegevens zorgt er doorgaans voor dat deze zich in een 'positie en een voorwaarde bevinden, gereed voor gebruik'.

- Verrijken : de mogelijkheid om gegevens die op het platform worden verwerkt, te verbeteren via statistische, machine learning- of andere modelleringstechnieken of vooraf gebouwde Azure AI-services.

- Server: de mogelijkheid van het platform om gegevens vorm te geven en weer te geven voor downstreamverbruik.

- Gegevensgebruikers : de personen, toepassingen of downstreamprocessen die gegevens verbruiken van de verschillende aanraakpunten van de platformen.

- Ontdek en beheer : de mogelijkheden van het platform om de gegevens te beheren die het bevat, en ervoor te zorgen dat deze geïndexeerd, detecteerbaar/doorzoekbaar, goed beschreven, met volledige herkomst, en transparant is voor de eindgebruikers en het gebruiken van processen.

- Platform : de basis waarop het platform is gebouwd, dat wil gezegd, de Azure-basisbeginselen van Contoso, zoals hierboven beschreven.

Notitie

Voor veel klanten wordt het conceptuele niveau van de gebruikte dataplatform-referentiearchitectuur uitgelijnd, maar de fysieke implementatie kan variëren. ELT-processen (extraheren, laden, transformeren) kunnen bijvoorbeeld worden uitgevoerd via Azure Data Factory en gegevensmodellering door Azure SQL Server. Om dit probleem op te lossen, biedt de sectie Stateful versus stateless onderdelen hieronder richtlijnen.

Voor het dataplatform heeft Contoso de laagst aanbevolen productieservicelagen voor alle onderdelen geselecteerd en heeft besloten om een strategie voor herstel na noodgevallen (DR) opnieuw te implementeren op basis van een operationele kostenminimalisatiebenadering.

De volgende secties bieden een basiskennis van het DR-proces en de levers die beschikbaar zijn voor klanten om dit postuur te verhogen.

Azure-service- en onderdeelweergave

De volgende tabellen bevatten een uitsplitsing van elke Azure-service en elk onderdeel dat wordt gebruikt in het Contoso - Gegevensplatform, met opties voor herstel na noodgeval.

Notitie

De onderstaande secties zijn ingedeeld op stateful versus stateless services.

Stateful basisonderdelen

Microsoft Entra-id inclusief rolrechten

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: Premium P1

- Upliftopties voor herstel na noodgeval: de tolerantie van Microsoft Entra maakt deel uit van de SaaS-aanbieding (Software as a Service).

- Notities

Azure Key Vault

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: N.t.t.

- Opties voor herstel na noodgeval: N/B, gedekt als onderdeel van de Azure-service.

Recovery Services-kluis

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: standaard (geografisch redundante opslag (GRS))

- Opties voor herstel na noodgeval: Als u Herstel tussen regio's inschakelt, wordt gegevensherstel gemaakt in de secundaire, gekoppelde regio.

- Notities

- Hoewel lokaal redundante opslag (LRS) en zone-redundante opslag (ZRS) beschikbaar zijn, zijn configuratieactiviteiten vereist van de standaardinstelling.

Azure DevOps

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: DevOps Services

- Opties voor herstel na noodgeval: DevOps-service en gegevenstolerantie maken deel uit van de SaaS-aanbieding.

- Notities

- DevOps Server als de on-premises aanbieding blijft de verantwoordelijkheid van de klant voor herstel na noodgevallen.

- Als services van derden (SonarCloud, Jfrog Artifactory, Jenkins-buildservers bijvoorbeeld) worden gebruikt, blijven ze de verantwoordelijkheid van de klant voor herstel na een noodgeval.

- Als IaaS-VM's worden gebruikt in de DevOps-hulpprogrammaketen, blijven ze de verantwoordelijkheid van de klant voor herstel na een noodgeval.

Stateless Foundational Components

Abonnementen

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: N.t.t.

- Opties voor herstel na noodgeval: N/B, gedekt als onderdeel van de Azure-service.

Beheergroepen

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: N.t.t.

- Opties voor herstel na noodgeval: N/B, gedekt als onderdeel van de Azure-service.

Azure Monitor

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: N.t.t.

- Opties voor herstel na noodgeval: N/B, gedekt als onderdeel van de Azure-service.

Kostenbeheer

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: N.t.t.

- Opties voor herstel na noodgeval: N/B, gedekt als onderdeel van de Azure-service.

Microsoft Defender voor Cloud

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: N.t.t.

- Opties voor herstel na noodgeval: N/B, gedekt als onderdeel van de Azure-service.

Azure DNS

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: enkele zone - openbaar

- Opties voor dr-uplift: N/B, DNS is standaard maximaal beschikbaar.

Network Watcher

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: N.t.t.

- Opties voor herstel na noodgeval: N/B, gedekt als onderdeel van de Azure-service.

Virtuele netwerken, waaronder subnetten, door de gebruiker gedefinieerde route (UDR) en netwerkbeveiligingsgroepen (NSG)

- Verantwoordelijkheid voor herstel van onderdelen: Contoso

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: N.t.t.

- Opties voor herstel na noodgeval: VNET's kunnen worden gerepliceerd naar de secundaire, gekoppelde regio.

Azure Firewall

- Verantwoordelijkheid voor herstel van onderdelen: Contoso

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: Standard

- Uplift-opties voor herstel na noodgeval: Azure Firewall is standaard maximaal beschikbaar en kan worden gemaakt met Beschikbaarheidszones voor een hogere beschikbaarheid.

Azure DDoS

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: DDoS-netwerkbeveiliging

- Opties voor herstel na noodgeval: N/B, gedekt als onderdeel van de Azure-service.

ExpressRoute-circuit

- Verantwoordelijkheid voor herstel van onderdelen: Contoso, connectiviteitspartner en Microsoft

- Verantwoordelijkheid voor herstel van workload/configuratie: Connectiviteitspartner en Microsoft

- Selectie contoso-SKU: Standard

- Opties voor herstel na noodgeval:

- ExpressRoute kan worden opgetild om persoonlijke peering te gebruiken en een geografisch redundante service te leveren.

- ExpressRoute heeft ook ontwerpen voor hoge beschikbaarheid (HA) die beschikbaar zijn.

- Site-naar-site-VPN-verbinding kan worden gebruikt als back-up voor ExpressRoute.

- Notities

- De ExpressRoute heeft ingebouwde redundantie, waarbij elk circuit bestaat uit twee verbindingen met twee Microsoft Enterprise-randrouters (MSEE's) op een ExpressRoute-locatie vanaf de netwerkrand van de connectiviteitsprovider/client.

- Met een ExpressRoute Premium-circuit hebt u wereldwijd toegang tot alle Azure-regio's.

VPN Gateway

- Verantwoordelijkheid voor herstel van onderdelen: Contoso

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: enkele zone - VpnGw1

- Opties voor herstel na noodgeval: een VPN-gateway kan worden geïmplementeerd in een beschikbaarheidszone met de VPNGw#AZ-SKU's om een zone-redundante service te bieden.

Azure-belastingsverdeling

- Verantwoordelijkheid voor herstel van onderdelen: Contoso

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: Standard

- Opties voor herstel na noodgeval:

- Een load balancer kan worden geconfigureerd voor zoneredundantie binnen een regio met beschikbaarheidszones. Zo ja, dan blijft het gegevenspad behouden zolang één zone binnen de regio in orde blijft.

- Afhankelijk van de primaire regio kan een load balancer voor meerdere regio's worden geïmplementeerd voor een maximaal beschikbare, cross-regionale implementatie.

- Notities

- Azure Traffic Manager is een op DNS gebaseerde load balancer voor verkeer. Deze service ondersteunt de distributie van verkeer voor openbare toepassingen in de wereldwijde Azure-regio's. Deze oplossing biedt bescherming tegen regionale storingen binnen een ontwerp voor hoge beschikbaarheid.

Stateful gegevensplatformservices

Opslagaccount: Azure Data Lake Gen2

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: LRS

- Opties voor herstel na noodgeval: Opslagaccounts hebben een breed scala aan opties voor gegevensredundantie van primaire regioredundantie tot secundaire regioredundantie.

- Notities

- GRS wordt aanbevolen om redundantie op te heffen, waardoor een kopie van de gegevens in de gekoppelde regio wordt geboden.

Azure Event Hubs

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: Standard

- Uplift-opties voor herstel na noodgeval: er kan een Event Hub-naamruimte worden gemaakt waarvoor beschikbaarheidszones zijn ingeschakeld. Deze tolerantie kan worden uitgebreid om een volledige regiostoring met geo-noodherstel te dekken.

- Notities

- Event Hubs geo-noodherstel repliceert standaard geen gegevens, daarom zijn er verschillende overwegingen waarmee u rekening moet houden voor failover en terugval.

Azure IoT Hubs

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: Standard

- Opties voor herstel na noodgeval:

- IoT Hub-tolerantie kan worden opgetild door een cross-regionale HA-implementatie.

- Microsoft biedt de volgende richtlijnen voor ha/dr-opties.

- Notities

- IoT Hub biedt door Microsoft geïnitieerde failover en handmatige failover door gegevens te repliceren naar de gekoppelde regio voor elke IoT-hub.

- IoT Hub biedt hoge beschikbaarheid binnen regio's en gebruikt automatisch een beschikbaarheidszone als deze is gemaakt in een vooraf gedefinieerde set Azure-regio's.

Azure Stream Analytics

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: Standard

- Uplift-opties voor herstel na noodgeval: Hoewel Azure Stream Analytics een volledig beheerd PaaS-aanbod (Platform as a Service) is, biedt het geen automatische geo-failover. Georedundantie kan worden bereikt door identieke Stream Analytics-taken in meerdere Azure-regio's te implementeren.

Azure Machine Learning

- Verantwoordelijkheid voor herstel van onderdelen: Contoso en Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: exemplaren voor algemeen gebruik, D-serie

- Opties voor herstel na noodgeval:

- Azure Machine Learning is afhankelijk van meerdere Azure-services, waarvan sommige worden ingericht in het abonnement van de klant. Als zodanig blijft de klant verantwoordelijk voor de configuratie van hoge beschikbaarheid van deze services.

- Tolerantie kan worden opgetild via een implementatie in meerdere regio's.

- Opmerkingen:

- Azure Machine Learning zelf biedt geen automatische failover of herstel na noodgevallen.

Power BI

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: Power BI Pro

- Opties voor herstel na noodgeval: N/A, de tolerantie van Power BI maakt deel uit van de SaaS-aanbieding.

- Notities

- Power BI bevindt zich in de Office365-tenancy, niet die van Azure.

- Power BI maakt gebruik van Azure Beschikbaarheidszones om Power BI-rapporten, -toepassingen en -gegevens te beveiligen tegen storingen in datacenters.

- In het geval van regionale storingen voert Power BI een failover uit naar een nieuwe regio, meestal op dezelfde geografische locatie, zoals vermeld in het Vertrouwenscentrum van Microsoft.

Azure Cosmos DB

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: Schrijven in één regio met periodieke back-up

- Opties voor herstel na noodgeval:

- Accounts met één regio kunnen de beschikbaarheid verliezen na een regionale storing. Tolerantie kan worden opgetild naar één schrijfregio en ten minste een tweede (lees)regio en kan door de service beheerde failover worden ingeschakeld.

- Het wordt aanbevolen om Azure Cosmos DB-accounts te gebruiken voor productieworkloads om automatische failover in te schakelen. Bij afwezigheid van deze configuratie ondervindt het account verlies van schrijf beschikbaarheid voor alle duur van de storing in de schrijfregio, omdat handmatige failover niet slaagt vanwege een gebrek aan regioverbinding.

- Notities

- Ter bescherming tegen gegevensverlies in een regio biedt Azure Cosmos DB twee verschillende back-upmodi - Periodiek en Doorlopend.

- Regionale failovers worden gedetecteerd en verwerkt in de Azure Cosmos DB-client. Er zijn geen wijzigingen van de toepassing vereist.

- De volgende richtlijnen beschrijven de impact van een regio-storing op basis van de Cosmos DB-configuratie.

Azure Data Share

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: N.t.t.

- Opties voor herstel na noodgeval: de tolerantie van Azure Data Share kan worden opgetild door hoge beschikbaarheidsdistributie in een secundaire regio.

Microsoft Purview

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: N.t.t.

- Uplift-opties voor herstel na noodgeval: N/B

- Notities

- Vanaf oktober 2024 biedt Microsoft Purview geen ondersteuning voor geautomatiseerde bedrijfscontinuïteit en herstel na noodgevallen (BCDR). Totdat deze ondersteuning wordt toegevoegd, is de klant verantwoordelijk voor alle back-up- en herstelactiviteiten.

Stateless data platform-specifieke services

Azure Synapse: Pijplijnen

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: geoptimaliseerde gen2 berekend

- Uplift-opties voor herstel na noodgeval: N/B, Synapse-tolerantie maakt deel uit van het SaaS-aanbod met behulp van de functie voor automatische failover .

- Notities

- Als zelf-hostende gegevenspijplijnen worden gebruikt, blijven ze de verantwoordelijkheid van de klant voor herstel na een noodgeval.

Azure Synapse: Data Explorer-pools

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: geoptimaliseerd, klein (4 kernen)

- Opties voor herstel na noodgeval: N/B, Synapse-tolerantie maakt deel uit van het SaaS-aanbod.

- Notities

- Beschikbaarheidszones zijn standaard ingeschakeld voor Synapse Data Explorer waar beschikbaar.

Azure Synapse: Spark-pools

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: geoptimaliseerd, klein (4 kernen)

- Opties voor herstel na noodgeval: N/B, Synapse-tolerantie maakt deel uit van het SaaS-aanbod.

- Notities

- Op dit moment ondersteunt Azure Synapse Analytics alleen herstel na noodgevallen voor toegewezen SQL-pools en wordt dit niet ondersteund voor Apache Spark-pools.

Azure Synapse: Serverloze en toegewezen SQL-pools

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Contoso

- Selectie contoso-SKU: geoptimaliseerde gen2 berekend

- Opties voor herstel na noodgeval: N/B, Synapse-tolerantie maakt deel uit van het SaaS-aanbod.

- Notities

- Azure Synapse Analytics maakt automatisch momentopnamen gedurende de dag om herstelpunten te maken die zeven dagen beschikbaar zijn.

- Azure Synapse Analytics voert één keer per dag een standaard geo-back-up uit naar een gekoppeld datacenter. Het beoogde herstelpunt (RPO) voor geo-herstel is 24 uur.

- Als zelf-hostende gegevenspijplijnen worden gebruikt, blijven ze de verantwoordelijkheid van klanten voor herstel na een noodgeval.

Azure AI-services (voorheen Cognitive Services)

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: Betalen per gebruik

- Opties voor herstel na noodgeval: N/B, de API's voor AI-services worden gehost door door Microsoft beheerde datacenters.

- Notities

- Als AI-services zijn geïmplementeerd via Docker-containers die door de klant zijn geïmplementeerd, blijft herstel de verantwoordelijkheid van de klant.

Azure AI Search (voorheen Cognitive Search)

- Verantwoordelijkheid voor herstel van onderdelen: Microsoft

- Verantwoordelijkheid voor herstel van werkbelasting/configuratie: Microsoft

- Selectie contoso-SKU: Standard S1

- Opties voor herstel na noodgeval:

- AI Search kan worden verhoogd naar een ha-ontwerp met behulp van replica's in beschikbaarheidszones en regio's.

- Meerdere services in afzonderlijke regio's kunnen de tolerantie verder uitbreiden.

- Notities

- In AI Search wordt bedrijfscontinuïteit (en herstel na noodgevallen) bereikt via meerdere AI-Search-service s.

- er is geen ingebouwd mechanisme voor herstel na noodgevallen. Als continue service is vereist tijdens een onherstelbare fout, is het raadzaam om een tweede service in een andere regio te hebben en een strategie voor geo-replicatie te implementeren om ervoor te zorgen dat indexen volledig redundant zijn voor alle services.

Stateful versus staatloze onderdelen

De snelheid van innovatie in de Microsoft-productsuite en Azure betekent met name dat de onderdelenset die we voor dit werkvoorbeeld hebben gebruikt, snel zal evolueren. Om toekomstbestendig te zijn tegen het bieden van verouderde richtlijnen en deze richtlijnen uit te breiden naar onderdelen die niet expliciet in dit document worden behandeld, bevat de onderstaande sectie een aantal instructies op basis van de grofkorrelige classificatie van de status.

Een onderdeel/service kan worden beschreven als stateful als deze is ontworpen om voorgaande gebeurtenissen of gebruikersinteracties te onthouden. Staatloos betekent dat er geen record van eerdere interacties is en dat elke interactieaanvraag volledig moet worden verwerkt op basis van informatie die ermee wordt geleverd.

Voor een DR-scenario dat vraagt om opnieuw implementeren:

- Onderdelen/services die staatloos zijn, zoals Azure Functions en Azure Data Factory-pijplijnen, kunnen opnieuw worden geïmplementeerd vanuit broncodebeheer met ten minste een betrouwbaarheidstest om beschikbaarheid te valideren voordat ze in het bredere systeem worden geïntroduceerd.

- Onderdelen/services die stateful zijn, zoals Azure SQL Database en opslagaccounts, vereisen meer aandacht.

- Wanneer u het onderdeel aanschaft, wordt de functie voor gegevensredundantie geselecteerd. Deze beslissing is doorgaans gericht op een afweging tussen beschikbaarheid en duurzaamheid met operationele kosten.

- Gegevensarchieven hebben ook een strategie voor gegevensback-up nodig. De functionaliteit voor gegevensredundantie van de onderliggende opslag beperkt dit risico voor sommige ontwerpen, terwijl andere, zoals SQL-databases, een afzonderlijk back-upproces nodig hebben.

- Indien nodig kan het onderdeel opnieuw worden geïmplementeerd vanuit broncodebeheer met een gevalideerde configuratie via een betrouwbaarheidstest.

- Een opnieuw geïmplementeerd gegevensarchief moet zijn gegevensset gerehydrateerd hebben. Rehydratatie kan worden uitgevoerd via gegevensredundantie (indien beschikbaar) of een back-upgegevensset. Wanneer rehydratatie is voltooid, moet deze worden gevalideerd op nauwkeurigheid en volledigheid.

- Afhankelijk van de aard van het back-upproces moeten de back-upgegevenssets mogelijk worden gevalideerd voordat ze worden toegepast. Back-upprocesbeschadiging of -fouten kunnen ertoe leiden dat een eerdere back-up wordt gebruikt in plaats van de meest recente versie die beschikbaar is.

- Elke delta tussen de datum/tijdstempel van het onderdeel en de huidige datum moet worden aangepakt door de gegevensopnameprocessen vanaf dat moment opnieuw uit te voeren of opnieuw af te spelen.

- Zodra de gegevensset van het onderdeel is bijgewerkt, kan deze worden geïntroduceerd in het bredere systeem.

Andere belangrijke services

Deze sectie bevat richtlijnen voor hoge beschikbaarheid (HA) en DR voor andere belangrijke Azure-gegevensonderdelen en -services.

- Azure Databricks - DR-richtlijnen vindt u in de productdocumentatie.

- Azure Analysis Services - HA-richtlijnen vindt u in de productdocumentatie.

- Azure Database for MySQL

- Flexibele server HA-richtlijnen vindt u in de productdocumentatie.

- Richtlijnen voor hoge beschikbaarheid van één server vindt u in de productdocumentatie.

- SQL

- Richtlijnen voor SQL op Azure-VM's vindt u in de productdocumentatie.

- Richtlijnen voor Azure SQL en Azure SQL Managed Instance vindt u in de productdocumentatie.

Volgende stappen

Nu u meer hebt geleerd over de architectuur van het scenario, kunt u meer te weten komen over de details van het scenario.