Modellen benchmarken in de Azure AI Foundry-portal

Belangrijk

Items die in dit artikel zijn gemarkeerd (preview) zijn momenteel beschikbaar als openbare preview. Deze preview wordt aangeboden zonder een service level agreement en we raden deze niet aan voor productieworkloads. Misschien worden bepaalde functies niet ondersteund of zijn de mogelijkheden ervan beperkt. Zie Aanvullende gebruiksvoorwaarden voor Microsoft Azure-previews voor meer informatie.

In dit artikel leert u hoe u benchmarks vergelijkt tussen modellen en gegevenssets, met behulp van het hulpprogramma voor modelbenchmarks in de Azure AI Foundry-portal. U leert ook benchmarkingresultaten te analyseren en benchmarking uit te voeren met uw gegevens. Benchmarking kan u helpen bij het nemen van weloverwogen beslissingen over welke modellen voldoen aan de vereisten voor uw specifieke use case of toepassing.

Vereisten

Een Azure-abonnement met een geldige betalingswijze. Gratis of proefversie van Azure-abonnementen werkt niet. Als u geen Azure-abonnement hebt, maakt u eerst een betaald Azure-account .

Benchmarks voor access-modellen via de modelcatalogus

Azure AI biedt ondersteuning voor modelbenchmarking voor bepaalde modellen die populair en het meest worden gebruikt. Volg deze stappen om gedetailleerde benchmarkingresultaten te gebruiken om modellen rechtstreeks in de azure AI Foundry-modelcatalogus te vergelijken en te selecteren:

- Meld u aan bij Azure AI Foundry.

- Als u nog niet in uw project bent, selecteert u het.

- Selecteer modelcatalogus in het linkernavigatiedeelvenster.

Selecteer het model waarin u geïnteresseerd bent. Selecteer bijvoorbeeld gpt-4o. Met deze actie wordt de overzichtspagina van het model geopend.

Tip

In de modelcatalogus kunt u de modellen weergeven die benchmarking beschikbaar hebben met behulp van het filter Verzamelingen en benchmarkresultaten selecteren. Deze modellen hebben een benchmarkspictogram dat eruitziet als een histogram.

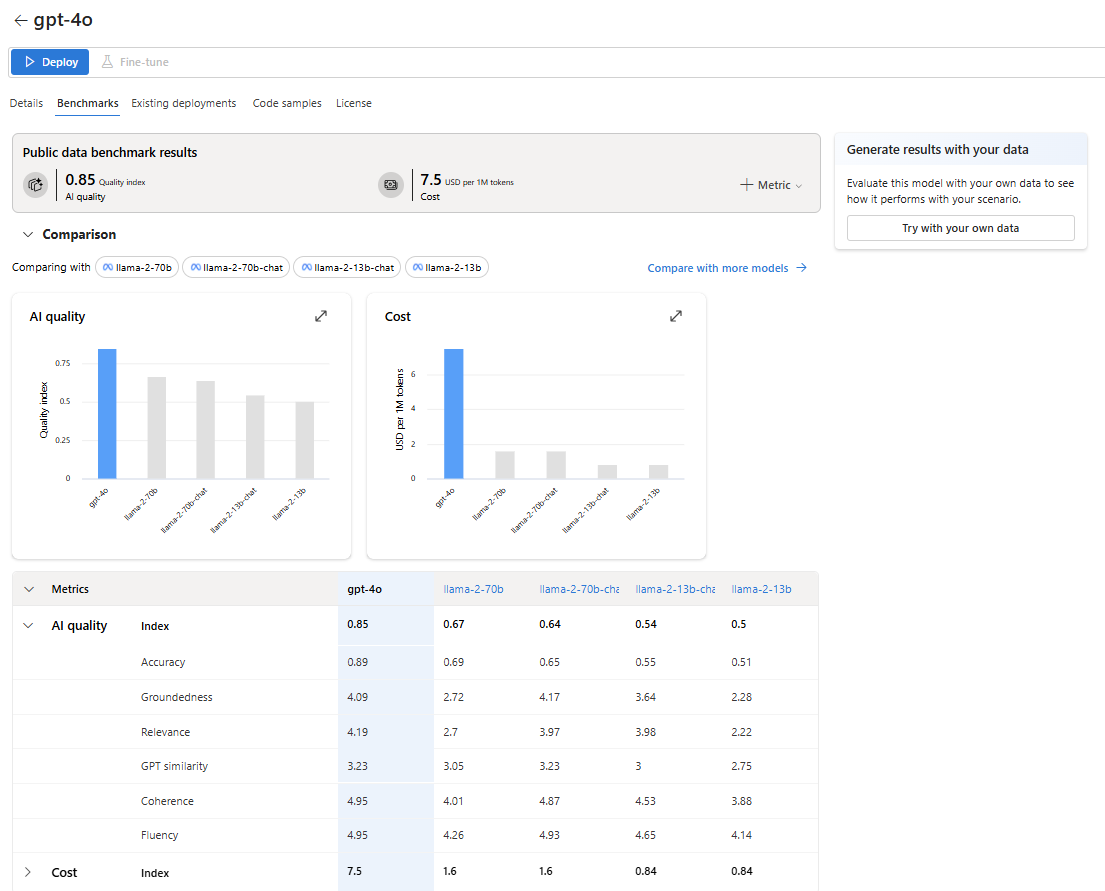

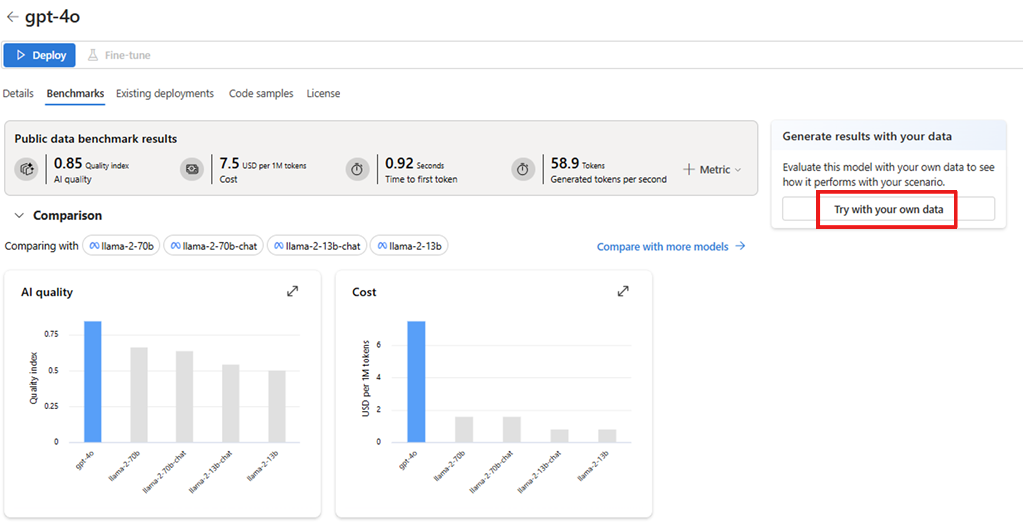

Ga naar het tabblad Benchmarks om de benchmarkresultaten voor het model te controleren.

Ga terug naar de startpagina van de modelcatalogus.

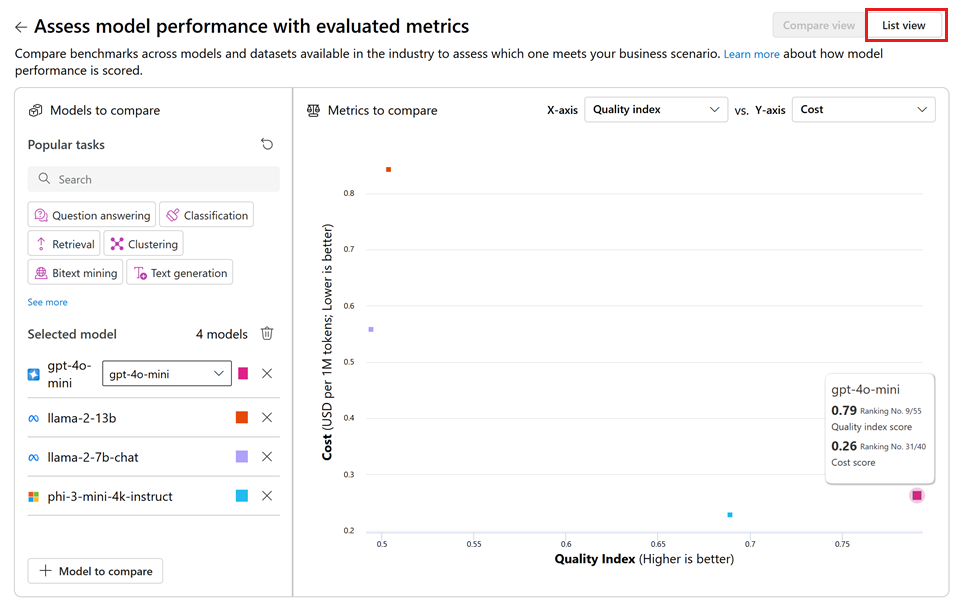

Selecteer Modellen vergelijken op de startpagina van de modelcatalogus om modellen te verkennen met benchmarkondersteuning, hun metrische gegevens te bekijken en de afwegingen tussen verschillende modellen te analyseren. Met deze analyse kunt u uw selectie informeren over het model dat het beste bij uw vereisten past.

Selecteer de gewenste taken en geef de interessedimensies op, zoals AI-kwaliteit versus kosten, om de afwegingen tussen verschillende modellen te evalueren.

U kunt overschakelen naar de lijstweergave voor toegang tot gedetailleerdere resultaten voor elk model.

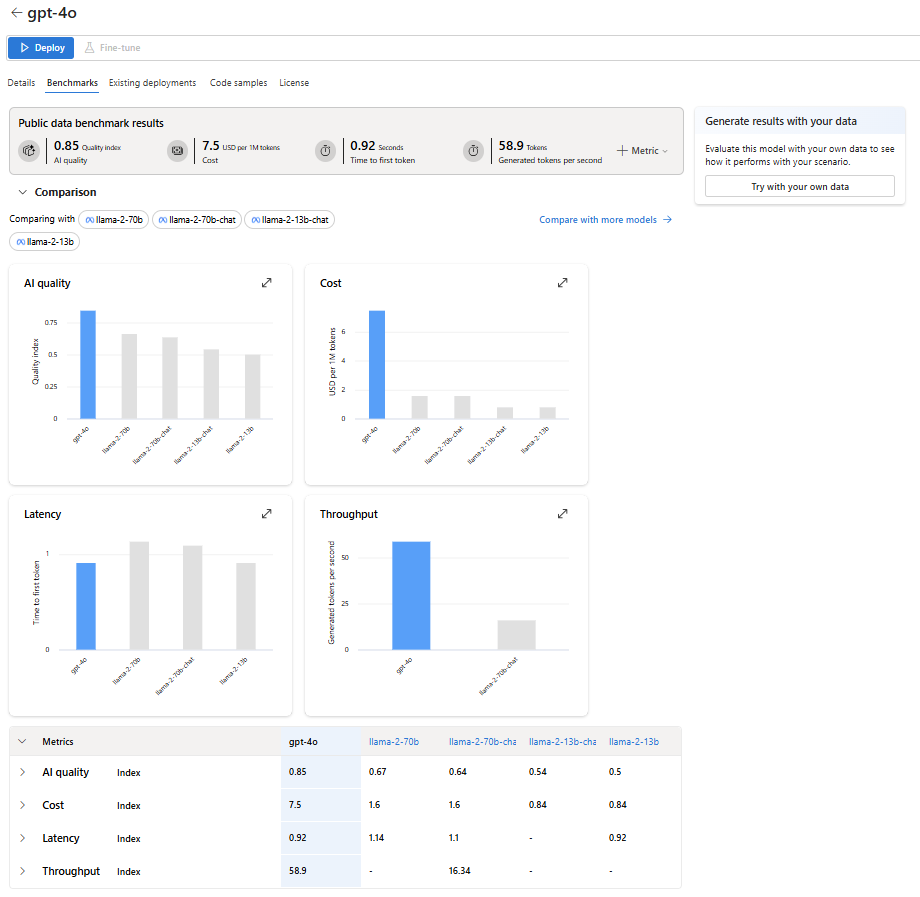

Benchmarkresultaten analyseren

Wanneer u zich op het tabblad Benchmarks bevindt voor een specifiek model, kunt u uitgebreide informatie verzamelen om de benchmarkresultaten beter te begrijpen en te interpreteren, waaronder:

Statistische scores op hoog niveau: Deze scores voor AI-kwaliteit, -kosten, -latentie en -doorvoer bieden een snel overzicht van de prestaties van het model.

Vergelijkende grafieken: in deze grafieken wordt de relatieve positie van het model vergeleken met gerelateerde modellen weergegeven.

Vergelijkingstabel met metrische gegevens: deze tabel bevat gedetailleerde resultaten voor elke metrische waarde.

Azure AI Foundry geeft standaard een gemiddelde index weer voor verschillende metrische gegevens en gegevenssets om een algemeen overzicht van de modelprestaties te bieden.

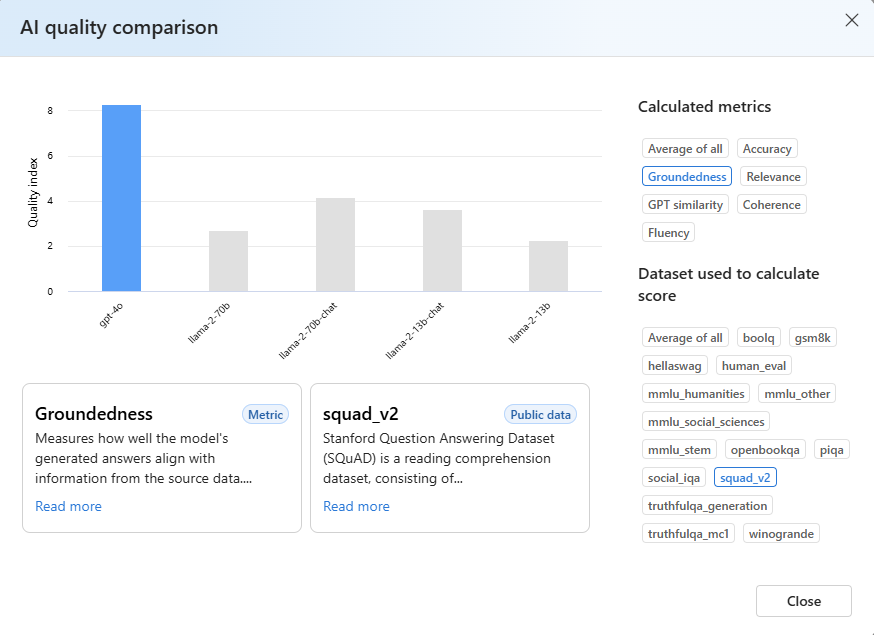

Ga als volgt te werk om toegang te krijgen tot benchmarkresultaten voor een specifieke metrische gegevens en gegevensset:

Selecteer de knop Uitvouwen in de grafiek. De pop-upvergelijkingsgrafiek toont gedetailleerde informatie en biedt meer flexibiliteit voor vergelijking.

Selecteer de gewenste waarde en kies verschillende gegevenssets op basis van uw specifieke scenario. Voor gedetailleerdere definities van de metrische gegevens en beschrijvingen van de openbare gegevenssets die worden gebruikt voor het berekenen van resultaten, selecteert u Meer informatie.

Benchmarkresultaten evalueren met uw gegevens

In de vorige secties werden de benchmarkresultaten weergegeven die door Microsoft zijn berekend met behulp van openbare gegevenssets. U kunt echter proberen om dezelfde set metrische gegevens opnieuw te genereren met uw gegevens.

Ga terug naar het tabblad Benchmarks in de modelkaart.

Selecteer Uitproberen met uw eigen gegevens om het model te evalueren met uw gegevens. Met evaluatie van uw gegevens kunt u zien hoe het model presteert in uw specifieke scenario's.