Databricks 자산 번들 확장 기능

Visual Studio Code용 Databricks 확장은 Azure Databricks 작업, 델타 라이브 테이블 파이프라인 및 MLOps 스택에 CI/CD 모범 사례를 적용하기 위해 Databricks 자산 번들을 쉽게 정의, 배포 및 실행할 수 있는 Visual Studio Code 내의 추가 기능을 제공합니다. Databricks 자산 번들이란?을 참조하세요.

Visual Studio Code용 Databricks 확장을 설치하려면 Visual Studio Code용 Databricks 확장 설치를 참조하세요.

프로젝트에서 Databricks 자산 번들 지원

Visual Studio Code용 Databricks 확장은 Databricks 자산 번들 프로젝트에 다음 기능을 추가합니다.

- AuthType 프로필 선택을 포함하여 Visual Studio Code UI를 통해 Databricks 자산 번들의 간편한 인증 및 구성 Visual Studio Code 에서의 Databricks 확장에 대한 권한 설정을 참조하세요.

- 번들 대상 환경 간에 빠르게 전환할 수 있는 Databricks 확장 패널의 대상 선택기입니다. 대상 배포 작업 영역 변경을 참조 하세요.

- 확장 패널의 번들에서 작업 클러스터 재정의 옵션을 사용하여 쉽게 클러스터를 재정의할 수 있습니다.

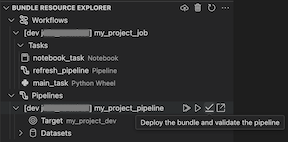

- Visual Studio Code UI를 사용하여 번들 리소스를 찾아보고, 로컬 Databricks 자산 번들의 리소스를 한 번의 클릭으로 원격 Azure Databricks 작업 영역에 배포하고, Visual Studio Code에서 작업 영역에 배포된 리소스로 직접 이동할 수 있는 번들 리소스 탐색기 보기입니다. 번들 리소스 탐색기를 참조하세요.

- Visual Studio Code UI를 사용하여 번들 변수를 찾아보고 편집할 수 있는 번들 변수 뷰입니다. 번들 변수 보기를 참조 하세요.

번들 리소스 탐색기

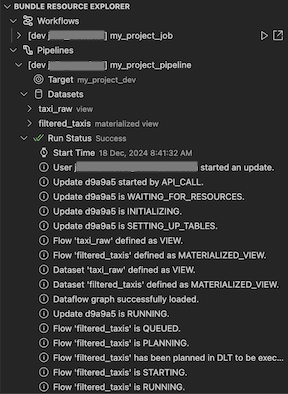

Visual Studio Code용 Databricks 확장의 번들 리소스 탐색기 보기는 프로젝트의 번들 구성에 있는 리소스 정의를 사용하여 파이프라인 데이터 세트 및 해당 스키마를 포함한 리소스를 표시합니다. 또한 리소스를 배포 및 실행하고, 파이프라인의 부분 업데이트를 유효성 검사 및 수행하고, 파이프라인 실행 이벤트 및 진단을 보고, 원격 Azure Databricks 작업 영역에서 리소스로 이동할 수 있습니다. 번들 구성 리소스에 대한 자세한 내용은 리소스를 참조 하세요.

예를 들어 간단한 작업 정의가 제공됩니다.

resources:

jobs:

my-notebook-job:

name: "My Notebook Job"

tasks:

- task_key: notebook-task

existing_cluster_id: 1234-567890-abcde123

notebook_task:

notebook_path: notebooks/my-notebook.py

확장의 번들 리소스 탐색기 보기에는 Notebook 작업 리소스가 표시됩니다.

작업 배포 및 실행

번들을 배포하려면 클라우드(번들 배포) 아이콘을 클릭합니다.

작업을 실행하려면 번들 리소스 탐색기 보기에서 작업의 이름(이 예제의 내 Notebook 작업)을 선택합니다. 다음으로 재생(번들 배포 및 리소스 실행) 아이콘을 클릭합니다.

실행 중인 작업을 보려면 번들 리소스 탐색기 보기에서 작업 이름을 확장하고 실행 상태를 클릭한 다음 링크(외부에서 링크 열기) 아이콘을 클릭합니다.

파이프라인 문제 유효성 검사 및 진단

파이프라인의 경우 파이프라인을 선택한 다음 확인(번들을 배포하고 파이프라인유효성 검사) 아이콘을 선택하여 유효성 검사 및 부분 업데이트를 트리거할 수 있습니다. 실행 이벤트가 표시되고 Visual Studio Code 문제 패널 내에서 오류를 진단할 수 있습니다.

유효성을 검사합니다.

유효성을 검사합니다.

번들 변수 보기

Visual Studio Code용 Databricks 확장의 번들 변수 뷰 보기에는 번들 구성에 정의된 모든 사용자 지정 변수 및 관련 설정이 표시됩니다. 번들 변수 뷰를 사용하여 직접 변수를 정의할 수도 있습니다. 이러한 값은 번들 구성 파일에 설정된 값을 재정의합니다. 사용자 지정 변수에 대한 자세한 내용은 사용자 지정 변수를 참조 하세요.

예를 들어 확장의 번들 변수 뷰 보기 에는 다음이 표시됩니다.

이 번들 구성에 정의된 변수 my_custom_var 의 경우:

variables:

my_custom_var:

description: "Max workers"

default: "4"

resources:

jobs:

my_job:

name: my_job

tasks:

- task_key: notebook_task

job_cluster_key: job_cluster

notebook_task:

notebook_path: ../src/notebook.ipynb

job_clusters:

- job_cluster_key: job_cluster

new_cluster:

spark_version: 13.3.x-scala2.12

node_type_id: i3.xlarge

autoscale:

min_workers: 1

max_workers: ${var.my_custom_var}