Microsoft Fabric の Data Engineering ワークスペース管理設定

適用対象:✅ Microsoft Fabric でのデータ エンジニアリングとデータ サイエンス

Microsoft Fabric でワークスペースを作成すると、そのワークスペースに関連付けられたスターター プールが自動的に作成されます。 Microsoft Fabric における簡易セットアップでは、ノードやマシンのサイズを選択する必要はありません。これらのオプションはバックグラウンドで設定されます。 この構成では、ユーザーがコンピューティングの設定を気にする必要がなく、多くの一般的なシナリオにおいて、初めて Apache Spark ジョブを使用し実行する際により迅速に (5 から 10 秒) Apache Spark セッションを開始できます。 特定のコンピューティング要件がある高度なシナリオの場合は、カスタム Apache Spark プールを作成し、パフォーマンスのニーズに基づいてノードのサイズを設定できます。

ワークスペースでの Apache Spark 設定を変更するには、そのワークスペースに対する管理者ロールが必要です。 詳しくは、「ワークスペースのロール」をご覧ください。

ワークスペースに関連付けられているプールの Spark 設定を管理するには:

ワークスペースで [ワークスペースの設定] に移動し、[データ エンジニアリング/サイエンス] オプションを選択してメニューを展開します。

左側のメニューに [Spark コンピューティング] オプションが表示されます。

Note

既定のプールをスターター プールからカスタム Spark プールに変更すると、セッションの開始時間が長くなる (3 分程度) 場合があります。

プール

ワークスペースの既定のプール

自動的に作成されたスターター プールを使用することも、ワークスペースのカスタム プールを作成することもできます。

スターター プール: エクスペリエンスの高速化のために自動的に作成された、事前ハイドレートされたライブ プール。 これらのクラスターは中程度のサイズです。 スターター プールは、購入した Fabric の容量 SKU に基づいて、既定の構成に設定されます。 管理者は、Spark ワークロードのスケール要件に基づいて、最大ノードと Executor をカスタマイズできます。 詳細については、「スターター プールの構成」を参照してください。

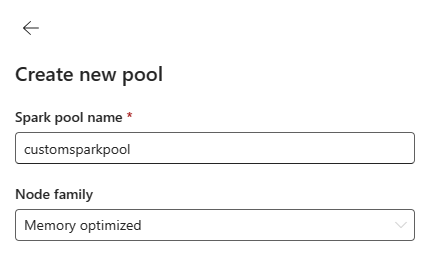

カスタム Spark プール: ご自分の Spark ジョブ要件に基づいて、ノードのサイズ設定、自動スケーリング、Executor の動的割り当てができます。 カスタム Spark プールを作成するには、容量管理者が、[容量管理] 設定の [Spark コンピューティング] セクションで [カスタマイズされたワークスペース プール] オプションを有効にする必要があります。

Note

カスタマイズされたワークスペース プールの容量レベル制御は、既定で有効になっています。 詳細については、「Fabric 容量のデータ エンジニアリングとデータ サイエンスの設定を構成および管理する」を参照してください。

管理者は、[新しいプール] オプションを選択して、コンピューティング要件に基づいてカスタム Spark プールを作成できます。

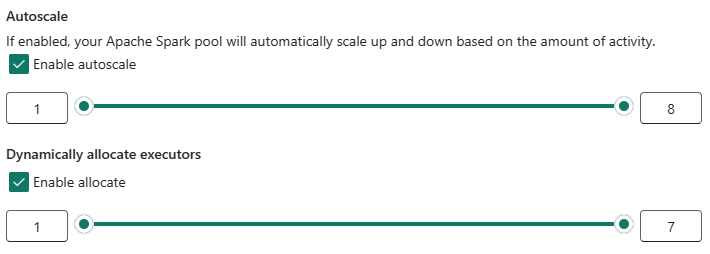

Microsoft Fabric の Apache Spark では、単一ノードのクラスターがサポートされています。そのため、ユーザーが、最小ノード構成である 1 (ドライバーと Executor が単一ノードで実行される) を選択できます。 これらの単一ノード クラスターでは、ノード障害の発生時に、復元可能な高可用性が提供されます。また、コンピューティング要件が小さいワークロードの場合にジョブの信頼性が向上します。 カスタム Spark プールの自動スケーリング オプションを有効や無効にすることもできます。 自動スケーリングを有効にすると、プールで、ユーザーが指定した最大ノード制限の範囲内で新しいノードが取得され、パフォーマンス向上のために、ジョブの実行後にそれらが廃止されます。

パフォーマンスを高めるために、データ ボリュームに基づいて指定された最大バインドの範囲内で自動的に最適な数の Executor がプールされるように Executor を動的に割り当てるオプションを選択することもできます。

Fabric の Apache Spark コンピューティング について説明します。

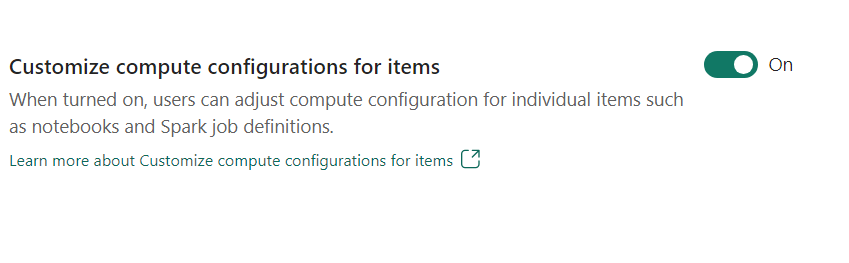

- アイテムのコンピューティング構成をカスタマイズ: ワークスペース管理者は、ユーザーがコンピューティング構成 (Driver/Executor Core、Driver/Executor Memory を含むセッション レベルのプロパティ) を、ノートブック、Spark ジョブ定義などの個々のアイテムに対して環境を使用して調整できるようにすることができます。

ワークスペース管理者がこの設定をオフにすると、既定のプールとそのコンピューティング構成がワークスペース内のすべての環境に使用されます。

Environment

環境は、Spark ジョブ (ノートブック、Spark ジョブ定義) を実行するための柔軟な構成を提供します。 環境では、ワークロードの要件に基づいて、コンピューティング プロパティを構成し、別のランタイムを選択し、ライブラリ パッケージの依存関係を設定することができます。

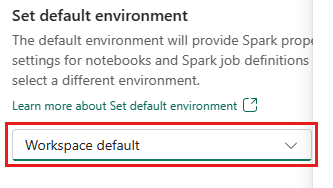

"環境" タブには、既定の環境を設定するオプションがあります。 ワークスペースに使用する Spark のバージョンを選択できます。

Fabric ワークスペース管理者は、ワークスペースの既定の環境として環境を選択できます。

[環境] ドロップダウンから新しい環境を作成することもできます。

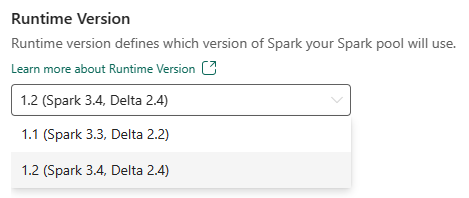

既定の環境を使用するオプションを無効にする場合は、ドロップダウン選択に一覧表示されている使用可能なランタイム バージョンから Fabric ランタイム バージョンを選択するオプションがあります。

Apache Spark ランタイムについて説明します。

ジョブ

[ジョブ] 設定を使用すると、管理者はワークスペース内のすべての Spark ジョブのジョブ受付ロジックを制御できます。

既定では、すべてのワークスペースでオプティミスティック ジョブ受付が有効になっています。 詳細については、Microsoft Fabric の Spark でのジョブの受付に関するページを参照してください。

Reserve maximum cores for active Spark jobs] (アクティブな Spark ジョブの最大コア数を予約する) を有効にして、オプティミスティック ジョブ受付ベースのアプローチを無効にし、Spark ジョブの最大コア数を予約できます。

また、Spark セッション タイムアウトを設定して、すべてのノートブック対話型セッションについてセッション有効期限をカスタマイズすることもできます。

Note

対話型 Spark セッションの既定のセッション有効期限は 20 分に設定されています。

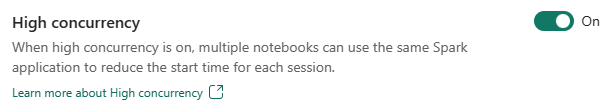

高コンカレンシー

高コンカレンシー モードを使用すると、ユーザーは Fabric 用 Apache Spark のデータ エンジニアリングとデータ サイエンスのワークロードで同じ Spark セッションを共有できます。 ノートブックなどのアイテムは、その実行に Spark セッションを使用し、有効にすると、ユーザーは複数のノートブック間で 1 つの Spark セッションを共有できます。

Fabric 用 Apache Spark での高コンカレンシーについて説明します。

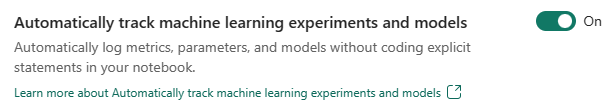

機械学習モデルと実験の自動ログ記録

管理者が機械学習モデルと実験の自動ログ記録を有効にできるようになりました。 このオプションを選択すると、トレーニング中の機械学習モデルの入力パラメータ、出力メトリック、出力項目の値が自動的に取得されます。 自動ログ記録の詳細を参照してください。

関連するコンテンツ

- Fabric の Apache Spark Runtime - 概要、バージョン管理、複数のランタイムのサポート、Delta Lake プロトコルのアップグレードについて読みます。

- Apache Spark のパブリック ドキュメントで詳細を学習する。

- 「Apache Spark ワークスペースの管理設定に関する FAQ」で、よくあるご質問への回答をご確認ください。

![[ワークスペースの設定] メニューで [データ エンジニアリング] を選択する場所を示すスクリーンショット。](media/workspace-admin-settings/data-engineering-menu-inline.png)

![[ジョブ] 設定を示すスクリーンショット。](media/workspace-admin-settings/jobs-settings.png)