概要 - AI セキュリティ態勢管理

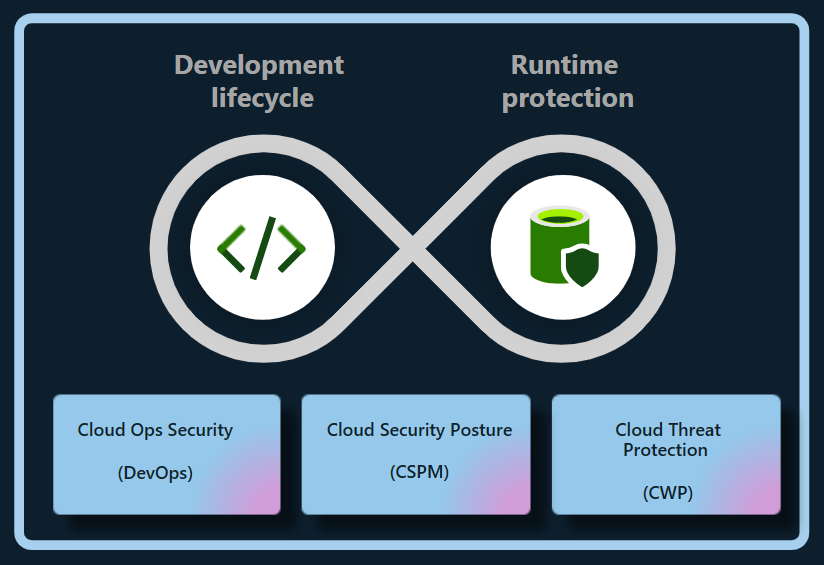

Microsoft Defender for Cloud の Defender クラウド セキュリティ態勢管理 (CSPM) プランは、エンタープライズ向けに構築された、マルチ クラウドまたはハイブリッド クラウド (現在は Azure と AWS) での生成 AI アプリケーションをライフサイクル全体にわたって保護します。 Defender for Cloud は、次の方法でクラウド AI ワークロードにまたがるリスクを削減します。

- コードからクラウドへのアプリケーション コンポーネント、データ、AI アーティファクトを含む生成 AI 部品表 (AI BOM) を検出します。

- 組み込みの推奨事項を使用し、セキュリティ リスクを調査して修復することによる、生成 AI アプリケーションのセキュリティ態勢の強化。

- 攻撃パス分析を使用したリスクの特定と修復。

重要

既に次のような AWS アカウントで AI セキュリティ態勢管理の機能を有効にする場合:

- Azure アカウントに接続されている。

- Defender CSPM が有効になっている。

- アクセス許可の種類が [最低特権アクセス] に設定されている。

次の手順に従って、関連するアクセス許可を有効にするには、そのコネクタのアクセス許可を再構成する必要があります。

- Azure portal で [環境の設定] ページに移動し、適切な AWS コネクタを選択します。

- [アクセスの構成] を選択します。

- アクセス許可の種類が [最低特権アクセス] に設定されていることを確認します。

- 手順 5 から 8 に従って構成を完了します。

生成 AI アプリを検出する

Defender for Cloud は、AI ワークロードを検出し、組織の AI BOM の詳細を特定します。 この可視性により、脆弱性を特定して対処し、潜在的な脅威から生成 AI アプリケーションを保護できます。

Defender for Cloud は、次のサービス全体にわたってデプロイされた AI ワークロードを自動的かつ継続的に検出します。

- Azure OpenAI Service

- Azure Machine Learning

- Amazon Bedrock

Defender for Cloud は、ソース コードをスキャンして、コードとしてのインフラストラクチャ (IaC) の構成ミスとコンテナー イメージの脆弱性がないかを調べることで、TensorFlow、PyTorch、Langchain などの生成 AI ライブラリの依存関係内の脆弱性も検出できます。 ライブラリを定期的に更新するか、それに対してパッチを適用することで、悪用を防ぎ、生成 AI アプリケーションを保護し、整合性を維持できます。

これらの機能により、Defender for Cloud は、コードからクラウドまでの AI ワークロードを完全に可視化できます。

生成 AI アプリのリスクを削減する

Defender CSPM は、組織の AI セキュリティ態勢に対するコンテキスト分析情報を提供します。 セキュリティに関する推奨事項と攻撃パス分析を使用して、AI ワークロード内のリスクを削減できます。

推奨事項を使用してリスクを調査する

Defender for Cloud は AI ワークロードを評価します。 また、重要なセキュリティの問題を特定して優先順位を付けるために、ID、データ セキュリティ、インターネット公開に関する推奨事項を提示します。

IaC の構成ミスを検出する

DevOps セキュリティは、IaC の構成ミスを検出します。構成ミスは、アクセス制御の過剰公開や不注意によるサービス公開などのセキュリティの脆弱性に生成 AI アプリケーションをさらす可能性があります。 このような構成ミスは、特に厳格なデータ プライバシー規制を処理するときに、データ侵害、未承認のアクセス、コンプライアンスの問題につながる可能性があります。

Defender for Cloud は、生成 AI アプリの構成を評価し、AI セキュリティ態勢を向上させるためのセキュリティに関する推奨事項を提供します。

その後に複雑な問題へと発展しないように、開発サイクルの早い段階で検出された構成ミスを修復します。

現在の IaC AI セキュリティ チェックには、次のものが含まれます。

- Azure AI サービス プライベート エンドポイントを使用する

- Azure AI サービス エンドポイントを制限する

- Azure AI サービス アカウントにマネージド ID を使用する

- Azure AI サービス アカウントに ID ベースの認証を使用する

攻撃パス分析を使用してリスクを調査する

攻撃パス分析は、AI ワークロードに対するリスクを検出して軽減します。 AI モデルを特定のデータに基づかせることや、事前学習済みモデルを特定のデータセットでファインチューニングして関連するタスクのパフォーマンスを向上させる段階は、データが露出する可能性のある段階です。

AI ワークロードを継続的にモニターすることで、攻撃パス分析は弱点と潜在的な脆弱性を特定し、推奨事項のフォローアップ行うことができます。 さらにこれは、データとコンピューティング リソースが Azure、AWS、GCP にまたがって配布されているケースに適合するように拡張されます。