チュートリアル: Visual Studio CodeのDatabricks拡張を使用したクラスタ上およびジョブとしてのPythonの実行

このチュートリアルでは、Visual Studio Code用のDatabricksエクステンションをセットアップし、Azure Databricksクラスタ上でPythonを実行し、リモートワークスペースでAzure Databricksジョブとして実行する手順を説明します。 「Visual Studio Code 用 Databricks 拡張機能について」を参照してください。

要件

このチュートリアルには、次のものが必要です:

- 「Visual Studio Code 用 Databricks 拡張機能がインストールされました。 「Visual Studio Code 用 Databricks 拡張機能のインストール」を参照してください。

- 使用するリモート Azure Databricks クラスターがあります。 クラスター名をメモしておきます。 利用可能なクラスタを表示するには、Azure Databricks ワークスペースのサイドバーで、コンピューティング をクリックします。 「コンピューティング」を参照してください。

ステップ 1: 新しいプロジェクトを作成します

この手順では、新しい Databricks プロジェクトを作成し、リモートの Azure Databricks ワークスペースとの接続を設定します。

- Visual Studio Code を起動し、 [ファイル] > [フォルダーを開く] をクリックして ローカル開発マシンで空のフォルダーを開きます。

- Visual Studio Code サイドバーで、Databricks ロゴ アイコンをクリックします。 これで、Databricks 拡張機能が開きます。

- 構成 ビューで、[構成作成] をクリックします。

- Databricks ワークスペースを構成するコマンド パレット が開きます。 Databricks ホストの場合は、など、

https://adb-1234567890123456.7.azuredatabricks.netを入力または選択します。 - プロジェクトの認証プロファイルを選択します。 「Visual Studio Codeの Databricks 拡張機能の承認を設定する」を参照してください。

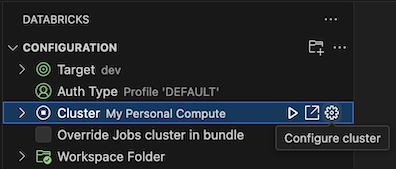

手順 2: Databricks 拡張機能にクラスター情報を追加し、クラスターを起動する

構成 ビューが既に開いている状態で、[クラスターの選択] クリックするか歯車アイコン (構成クラスター) をクリックします。

コマンド パレットで、既に作成したクラスターの名前を選択します。

まだ起動していない場合には、再生アイコン (クラスターの開始) をクリックします。

手順 3: Python コードを作成して実行する

ローカル Python コード ファイルを作成する: サイドバーで、フォルダー (エクスプローラー) アイコンをクリックします。

メイン メニュー上の [ファイル] > [新しいファイル] をクリックし、Python ファイルを選択します。 ファイルに demo.py という名前を付け、プロジェクト ルートに保存します。

次のコードをファイルに追加して保存します。 このコードは、次のように基本的な PySpark DataFrame のコンテンツを作成して表示します。

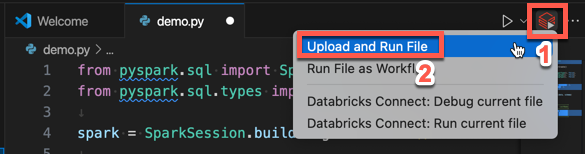

from pyspark.sql import SparkSession from pyspark.sql.types import * spark = SparkSession.builder.getOrCreate() schema = StructType([ StructField('CustomerID', IntegerType(), False), StructField('FirstName', StringType(), False), StructField('LastName', StringType(), False) ]) data = [ [ 1000, 'Mathijs', 'Oosterhout-Rijntjes' ], [ 1001, 'Joost', 'van Brunswijk' ], [ 1002, 'Stan', 'Bokenkamp' ] ] customers = spark.createDataFrame(data, schema) customers.show()# +----------+---------+-------------------+ # |CustomerID|FirstName| LastName| # +----------+---------+-------------------+ # | 1000| Mathijs|Oosterhout-Rijntjes| # | 1001| Joost| van Brunswijk| # | 1002| Stan| Bokenkamp| # +----------+---------+-------------------+エディター タブの一覧の横にある Run on Databricks アイコンをクリックして、[ アップロードとファイルの実行] をクリックします。 出力は [デバッグ コンソール] ビューに表示されます。

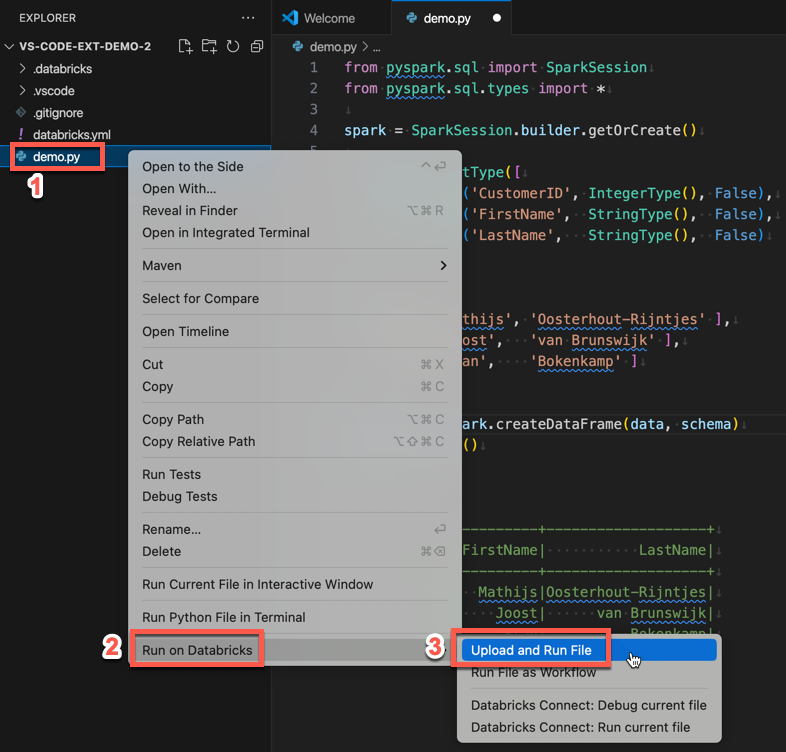

または、エクスプローラビューで

demo.pyファイルを右クリックし、Databricks>UploadおよびRun Fileで実行をクリックします。

手順 4: コードをジョブとして実行する

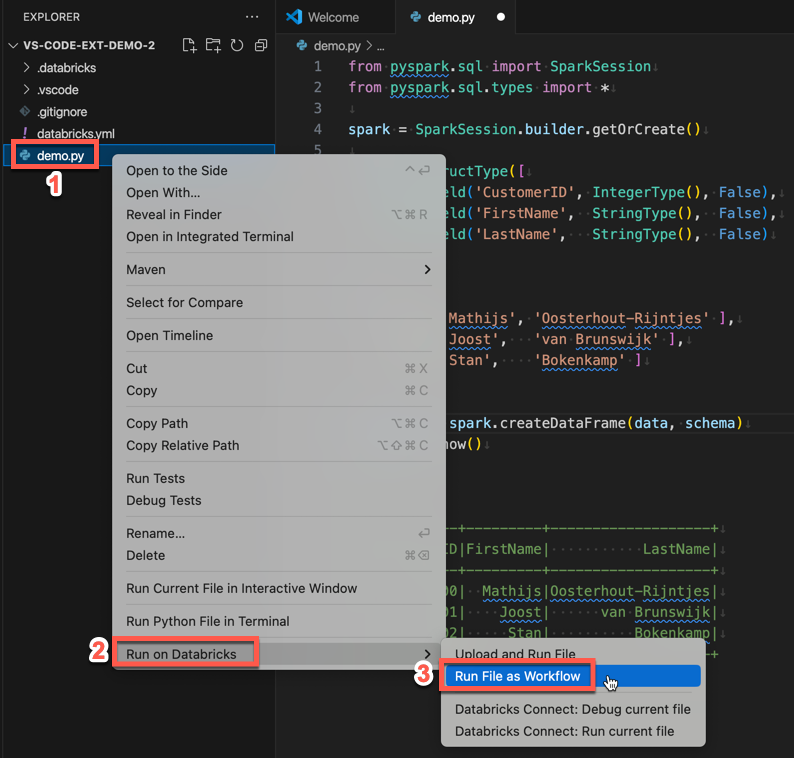

demo.pyジョブとして実行するには、エディター タブの一覧の横にある Run on Databricks アイコンをクリックし、ワークフローとしてファイルを実行 をクリックします。 出力は、demo.py ファイル エディターの横にある別のエディター タブに表示されます。

![]()

または、demo.py パネルで ファイルを右クリックし、Databricks で実行 >ワークフローとして実行を選択します。

次のステップ

これで、Databricks拡張機能を使用してローカルのPythonファイルをアップロードし、リモートで実行することに成功しました。さらに、以下のことも可能です:

- 拡張 UI を使用することで、Databricks Asset Bundles のリソースと変数を探索します。 Databricks アセット バンドル拡張機能の特徴を参照してください。

- Databricks Connect を使用して Python コードを実行またはデバッグする Visual Studio Code 用 Databricks 拡張機能の Databricks Connect を使用したコードのデバッグに関するページを参照してください。

- Azure Databricks ジョブとしてファイルまたはノートブックを実行します。 Visual Studio Code 用 Databricks 拡張機能を使って R、Scala、または SQL ノートブックをジョブとして実行する を参照してください。

pytestを使用してテストを実行します。 Visual Studio Code 用 Databricks 拡張機能の pytestを使用したテストの実行に関するページを参照してください。