Visual Studio Code 用 Databricks 拡張機能を使用して、Azure Databricks のクラスター、ファイル、ノートブックでファイルをジョブとして実行する

Visual Studio Code 用 Databricks 拡張機能を使用すると、Azure Databricks のクラスター、Python、R、Scala、SQL コード、ノートブックで Python コードをジョブとして実行できます。

この情報は、Visual Studio Code 用 Databricks 拡張機能のインストールと設定が完了していることを前提としています。 「Visual Studio Code 用 Databricks 拡張機能をインストールする」を参照してください。

Note

Visual Studio Code 内からコードまたはノートブックをデバッグするには、Databricks Connect を使用します。 「Visual Studio Code 用 Databricks 拡張機能の Databricks Connect を使用したコードのデバッグ」と「Visual Studio Code 用 Databricks 拡張機能を使用した Databricks Connect でのノートブック セルの実行とデバッグ」をご覧ください。

クラスターで Python ファイルを実行する

Visual Studio Code 用 Databricks 拡張機能を使用して Azure Databricks クラスターで Python ファイルを実行するには、拡張機能とプロジェクトを開いた状態で、次の操作を行います。

- クラスターで実行する Python ファイルを開きます。

- 次のいずれかの操作を行います。

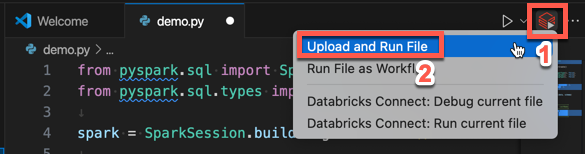

ファイル エディターのタイトル バーで、[Databricks で実行] アイコンをクリックし、[ファイルのアップロードと実行] をクリックします。

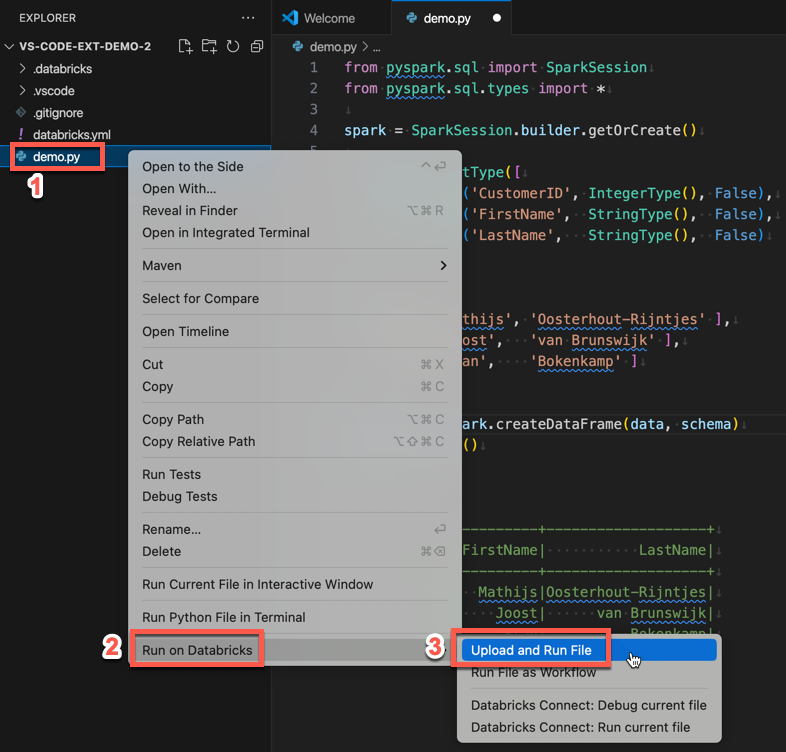

エクスプローラー ビュー ([ビュー] > [エクスプローラー]) でファイルを右クリックし、コンテキスト メニューから [Databricks で実行]>[ファイルをアップロードして実行] を選択します。

ファイルはクラスターで実行され、デバッグ コンソール ([ビュー] > [デバッグ コンソール]) に出力されます。

Python ファイルをジョブとして実行する

Visual Studio Code 用 Databricks 拡張機能を使用して Python ファイルを Azure Databricks ジョブとして実行するには、拡張機能とプロジェクトを開いた状態で、次の操作を行います。

- ジョブとして実行する Python ファイルを開きます。

- 次のいずれかの操作を行います。

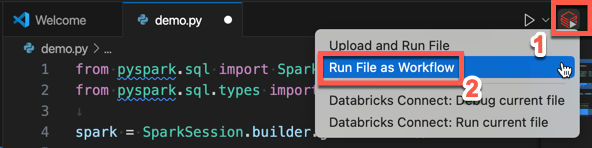

ファイル エディターのタイトル バーで、[Databricks で実行] アイコンをクリックし、[ワークフローとしてファイルを実行] をクリックします。

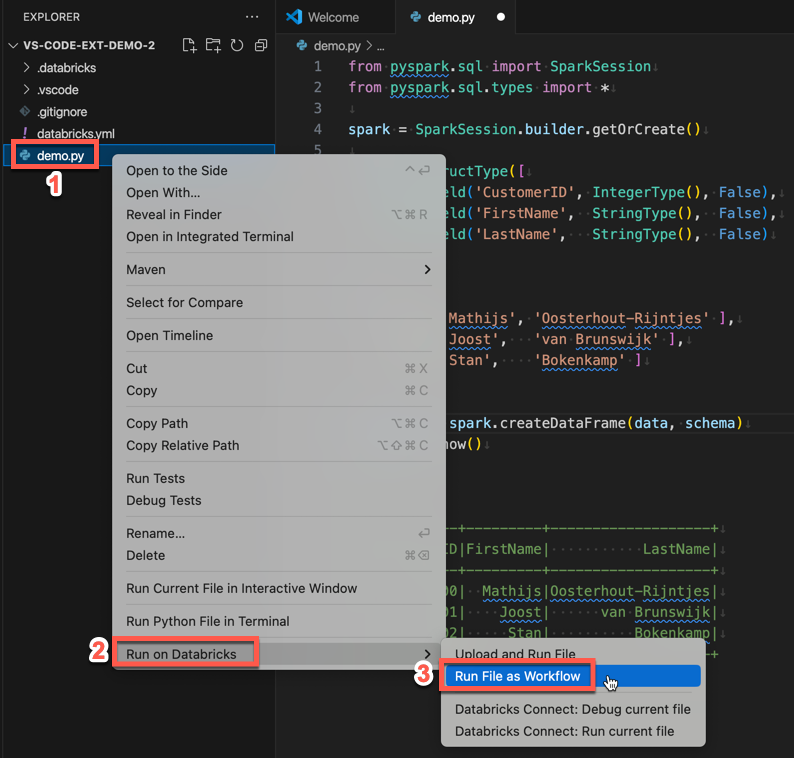

エクスプローラー ビュー ([ビュー] > [エクスプローラー]) でファイルを右クリックし、コンテキスト メニューから [Databricks で実行]>[ワークフローとしてファイルを実行] を選択します。

[Databricks Job Run](Databricks ジョブの実行) というタイトルの新しいエディター タブが表示されます。 ファイルはワークスペースでジョブとして実行され、出力はすべて新しいエディター タブの [出力] 領域に出力されます。

ジョブの実行に関する情報を表示するには、新しい [Databricks Job Run](Databricks ジョブの実行) エディター タブの [Task run ID](タスク実行 ID) リンクをクリックします。ワークスペースが開き、ジョブ実行の詳細がワークスペースに表示されます。

Python、R、Scala、SQL ノートブックをジョブとして実行する

Visual Studio Code 用の Databricks 拡張機能を使用してノートブックを Azure Databricks ジョブとして実行するには、拡張機能とプロジェクトを開いた状態で次の操作を行います。

ジョブとして実行するノートブックを開きます。

ヒント

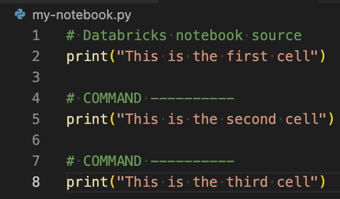

Python、R、Scala、SQL ファイルを Azure Databricks ノートブックに変換するには、ファイルの先頭にコメント

# Databricks notebook sourceを追加し、各セルの前にコメント# COMMAND ----------を追加します。 詳細については、「ファイルをインポートしてノートブックに変換する」を参照してください。

次のいずれかの操作を行います。

- ノートブック ファイル エディターのタイトル バーで、[Databricks で実行] アイコンをクリックし、[ワークフローとしてファイルを実行] をクリックします。

Note

[Run on Databricks as Workflow] (ワークフローとして Databricks で実行) が使用できない場合は、「カスタム実行構成を作成する」を参照してください。

- エクスプローラー ビュー ([ビュー] > [エクスプローラー]) でノートブック ファイルを右クリックし、コンテキスト メニューから [Databricks で実行]>[ワークフローとしてファイルを実行] を選択します。

[Databricks Job Run](Databricks ジョブの実行) というタイトルの新しいエディター タブが表示されます。 ノートブックは、ワークスペース内のジョブとして実行されます。 ノートブックとその出力は、新しいエディター タブの [出力] 領域に表示されます。

ジョブの実行に関する情報を表示するには、[Databricks Job Run](Databricks ジョブの実行) エディター タブの [Task run ID](タスク実行 ID) リンクをクリックします。ワークスペースが開き、ジョブ実行の詳細がワークスペースに表示されます。

カスタム実行構成を作成する

Visual Studio Code 用 Databricks 拡張機能のカスタム実行構成を使用すると、カスタム引数をジョブやノートブックに渡したり、異なるファイルに対して異なる実行設定を作成したりできます。

カスタム実行構成を作成するには、Visual Studio Code のメイン メニューから [実行] > [構成の追加] をクリックします。 次に、クラスターベースの実行構成の場合は [Databricks]、ジョブベースの実行構成の場合は [Databricks: Workflow] を選択します。

たとえば、次のカスタム実行構成では、[ワークフローとしてファイルを実行] 起動コマンドが変更され、 --prod 引数がジョブに渡されます。

{

"version": "0.2.0",

"configurations": [

{

"type": "databricks-workflow",

"request": "launch",

"name": "Run on Databricks as Workflow",

"program": "${file}",

"parameters": {},

"args": ["--prod"]

}

]

}

ヒント

Python 構成を使用しますが、拡張機能セットアップの一部である Databricks Connect 認証を利用する場合は、"databricks": true 構成に "type": "python" を追加します。

カスタム実行構成を使用すると、F5 キーを押すだ けでコマンド ライン引数を渡し、コードを実行することもできます。 詳細については、Visual Studio Code のドキュメントの「構成の起動」を参照してください。