クイックスタート: Azure Data Factory の使用を開始する

適用対象:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

ヒント

企業向けのオールインワン分析ソリューション、Microsoft Fabric の Data Factory をお試しください。 Microsoft Fabric は、データ移動からデータ サイエンス、リアルタイム分析、ビジネス インテリジェンス、レポートまで、あらゆるものをカバーしています。 無料で新しい試用版を開始する方法についてはこちらでご確認ください。

Azure Data Factory へようこそ この入門記事では、最初のデータ ファクトリとパイプラインを 5 分以内に作成します。 以下の ARM テンプレートでは、試すために必要なものがすべて作成され、構成されます。その後、デモ用のデータ ファクトリに移動し、もう 1 回クリックするだけでパイプラインがトリガーされ、Azure Blob Storage 間でサンプル データが移動されます。

前提条件

Azure サブスクリプションをお持ちでない場合は、開始する前に 無料アカウント を作成してください。

ビデオの概要

次のビデオでは、サンプルのチュートリアルを提供します。

ワンクリックで最初のデモを試す

最初のデモ シナリオでは、データ ファクトリの Copy アクティビティを使用して、Azure Blob Storage の入力フォルダーから出力フォルダーに moviesDB2.csv という名前の Azure BLOB をコピーします。 実際のシナリオでは、このコピー操作は、サービスで使用できる、サポートされている多数のデータ ソースとシンクの間で実行できます。 また、データに変換が含まれる場合もあります。

ワンクリックで今すぐお試しください。 下のボタンをクリックすると、次のオブジェクトが Azure に作成されます。

- データ ファクトリ アカウント

- 1 つの Copy アクティビティを伴う、データ ファクトリ内のパイプライン

- moviesDB2.csv がソースとして入力フォルダーにアップロードされた Azure Blob Storage

- データ ファクトリを Azure Blob Storage に接続するためのリンク サービス

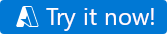

手順 1: ボタンをクリックして開始する

下のボタンを選択してお試しください。 (上記で既にクリックしている場合は必要ありません)

テンプレートをデプロイするために、次の図に示す構成ページにリダイレクトされます。 ここで必要なのは、新しいリソース グループを作成することだけです。 (その他の値はすべて既定値のままにできます)。次に、[確認と作成] をクリックし、[作成] をクリックしてリソースをデプロイします。

Note

テンプレートをデプロイするユーザーは、マネージド ID にロールを割り当てる必要があります。 これには、所有者、ユーザー アクセス管理者、またはマネージド ID オペレーターの各ロールを通じて付与できるアクセス許可が必要です。

上記で参照されているすべてのリソースは新しいリソース グループに作成されるため、デモを試した後で簡単にクリーンアップできます。

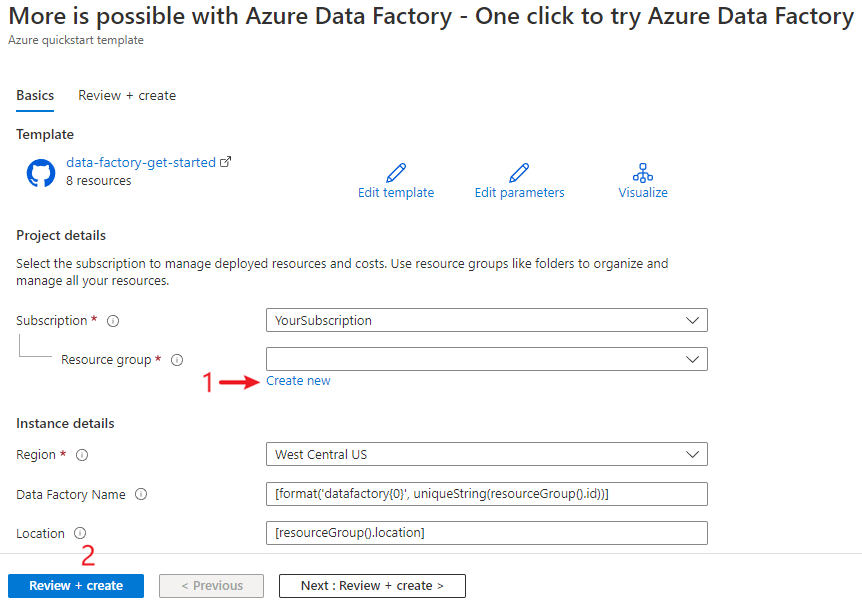

手順 2: デプロイされているリソースを確認する

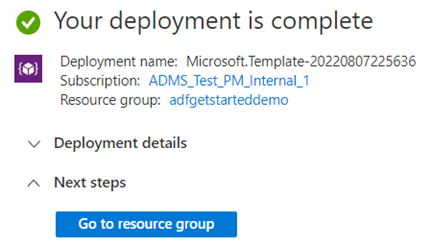

デプロイが完了したら、[リソース グループに移動] を選択します。

リソース グループに、デプロイによって作成された新しいデータ ファクトリ、Azure Blob Storage アカウント、マネージド ID が表示されます。

リソース グループ内のデータ ファクトリを選択して表示します。 次に、[スタジオの起動] ボタンを選択して続行します。

![新しく作成されたデータ ファクトリ ページの Azure portal のスクリーンショット。[Open Azure Data Factory Studio] ボタンの場所が強調表示されています。](media/quickstart-get-started/launch-adf-studio.png)

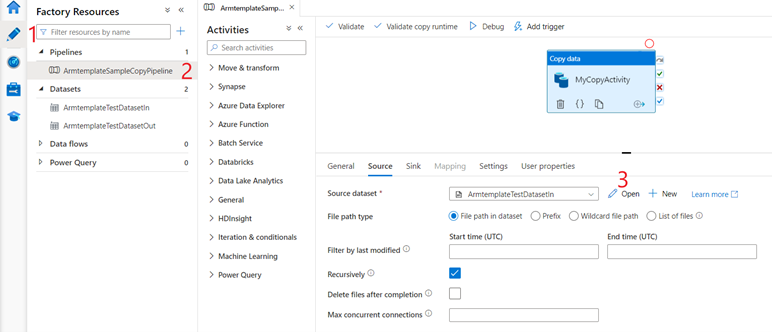

[作成] タブ

![[作成] タブ](media/quickstart-get-started/author-button.png) を選択し、テンプレートによって作成されたパイプラインを選択します。 次に、[開く] を選択してソース データを確認します。

を選択し、テンプレートによって作成されたパイプラインを選択します。 次に、[開く] を選択してソース データを確認します。

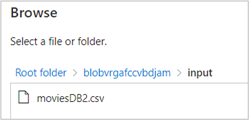

表示されるソース データセットで [参照] を選択し、入力フォルダーに既にアップロードされている moviesDB2.csv ファイルを確認します。

![ユーザーがデモ用に作成した入力ファイルを表示できる、[参照] ボタンを強調表示しているソース データセットのスクリーンショット。](media/quickstart-get-started/source-dataset-browse.png)

手順 3: デモ パイプラインをトリガーして実行する

- [トリガーの追加] を選択し、[Trigger Now] (今すぐトリガー) を選択します。

![デモのパイプラインの [Trigger Now] (今すぐトリガー) ボタンのスクリーンショット。](media/quickstart-get-started/trigger-now.png)

- [パイプラインの実行] の下の右側のウィンドウで、 [OK] を選択します。

パイプラインの監視

[監視] タブ

![[監視] タブ](media/quickstart-get-started/monitor-button.png) を選択します。

を選択します。パイプラインの実行の概要は、[監視] タブで確認できます (実行開始時刻、状態など)。

![データ ファクトリの [監視] タブのスクリーンショット。](media/quickstart-get-started/monitor-overview.png)

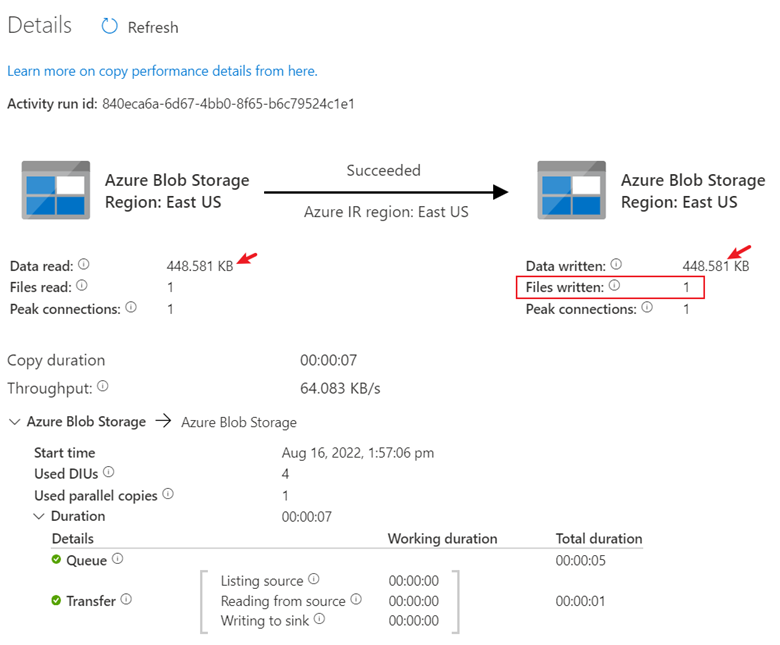

このクイックスタートでは、パイプラインに、Copy という種類のアクティビティが 1 つのみ含まれます。 パイプライン名をクリックすると、Copy アクティビティの実行結果の詳細が表示されます。

![データ ファクトリの [監視] タブにある Copy アクティビティの実行結果のスクリーンショット。](media/quickstart-get-started/copy-activity-run-results.png)

詳細をクリックすると、詳しいコピー プロセスが表示されます。 結果から、読み取られたデータと書き込まれたデータのサイズが同じで、1 ファイルが読み取られて書き込まれ、すべてのデータがコピー先に正常にコピーされたこともわかります。

リソースをクリーンアップする

このクイックスタートで作成したリソースは、2 とおりの方法でクリーンアップすることができます。 1 つは Azure リソース グループを削除する方法で、この場合、そのリソース グループに含まれているすべてのリソースが対象となります。 または、一部のリソースをそのまま保持する場合は、リソース グループを参照して、特定のリソースのみを削除し、それ以外のリソースは保持します。 たとえば、このテンプレートを使用して、別のチュートリアルで使用するデータ ファクトリを作成している場合、他のリソースは削除できますが、データ ファクトリだけは保持します。

関連するコンテンツ

このクイックスタートでは、Copy アクティビティを使用したパイプラインを含む Azure Data Factory を作成しました。 Azure Data Factory についてさらに詳しく知るには、以下の記事と Learn モジュールを参照してください。