Azure ワークフロー オーケストレーション マネージャーのしくみ

適用対象:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

ヒント

企業向けのオールインワン分析ソリューション、Microsoft Fabric の Data Factory をお試しください。 Microsoft Fabric は、データ移動からデータ サイエンス、リアルタイム分析、ビジネス インテリジェンス、レポートまで、あらゆるものをカバーしています。 無料で新しい試用版を開始する方法について説明します。

Note

ワークフロー オーケストレーション マネージャーは Apache Airflow を利用しています。

Note

Azure Data Factory 用のワークフロー オーケストレーション マネージャーは、オープンソースの Apache Airflow アプリケーションに依存しています。 Airflow のドキュメントとその他のチュートリアルについては、Apache Airflow のドキュメントまたはコミュニティのページを参照してください。

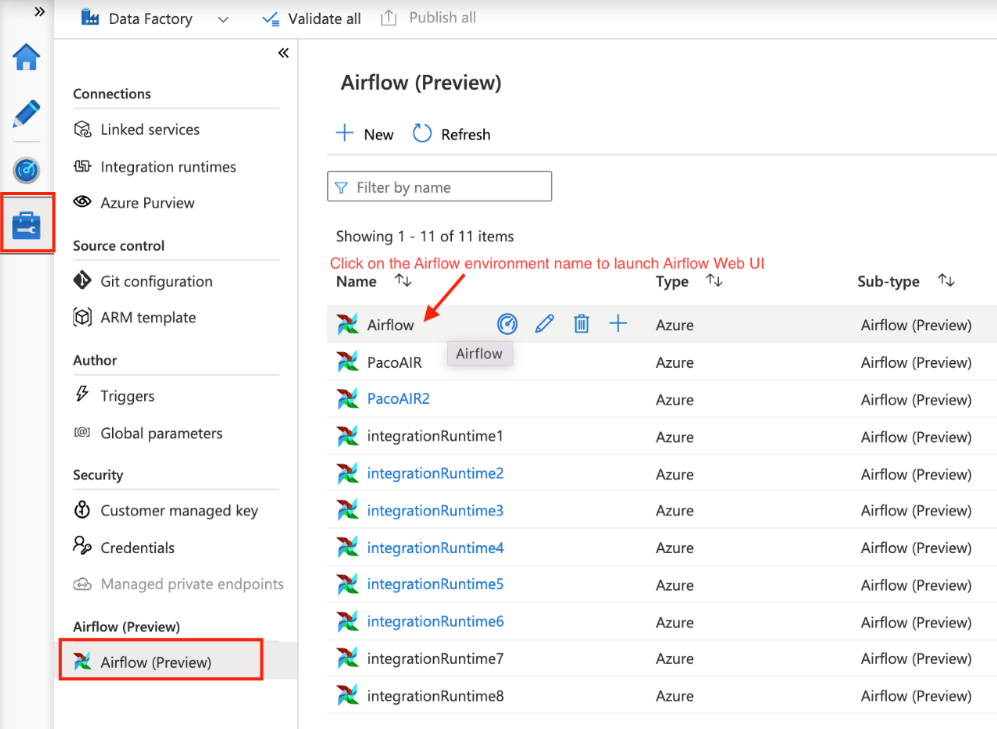

Azure Data Factory のワークフロー オーケストレーション マネージャーでは、Python ベースの有向非巡回グラフ (DAG) を使用してオーケストレーション ワークフローを実行します。 この機能を使用するには、Azure Blob Storage または GitHub リポジトリから DAG とプラグインを提供する必要があります。 コマンド ライン インターフェイス (CLI) またはソフトウェア開発キット (SDK) を使用して ADF から Airflow UI を起動して、DAG を管理できます。

ワークフロー オーケストレーション マネージャー環境を作成する

「ワークフロー オーケストレーション マネージャー環境を作成する」をご覧ください。

DAG のインポート

ワークフロー オーケストレーション マネージャーには、Python ソース ファイルから Airflow の環境に DAG を読み込むための 2 つの異なる方法が用意されています。 それらの方法を次に示します。

Git Sync を有効にする: このサービスを使用すると、GitHub リポジトリをワークフロー オーケストレーション マネージャーと同期できるため、GitHub リポジトリから直接 DAG をインポートできます。 「ワークフロー オーケストレーション マネージャーで GitHub リポジトリを同期する」を参照してください。

Azure Blob Storage: Azure Data Factory にリンクされている BLOB ストレージ アカウント内の指定されたフォルダーに、DAG やプラグインなどをアップロードできます。 次に、ワークフロー オーケストレーション マネージャー内のフォルダーのファイル パスをインポートします。 参照情報: Azure Blob Storage を使用して DAG をインポートする

Airflow 環境から DAG を削除する

「ワークフロー オーケストレーション マネージャーで DAG を削除する」を参照してください。

DAG の実行を監視する

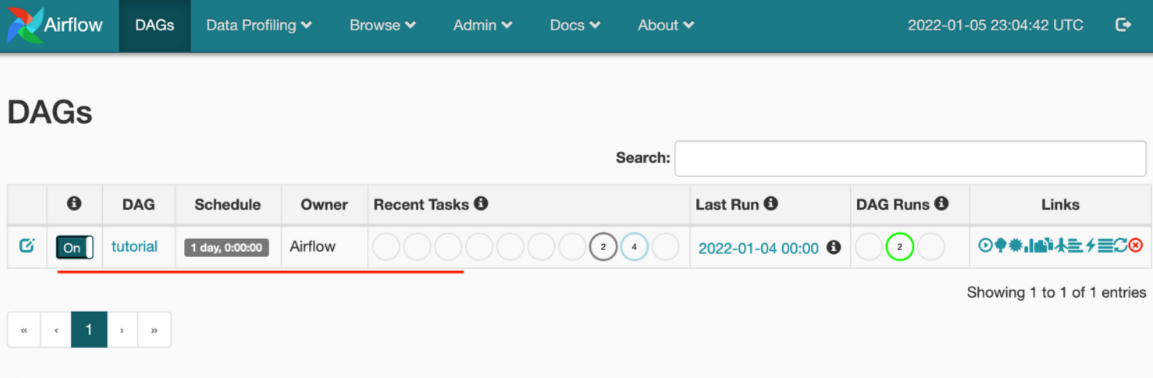

Airflow DAG を監視するには、以前に作成したユーザー名とパスワードを使用して Airflow UI にサインインします。

作成された Airflow 環境を選択します。

Airflow 統合ランタイムの作成時に指定したユーザー名とパスワードを使用してサインインします。 (必要に応じて、Airflow 統合ランタイムを編集してユーザー名またはパスワードをリセットできます)

DAG のインポートの問題のトラブルシューティング

問題: DAG のインポートに 5 分以上かかります。対策: 1 回のインポートでインポートする DAG のサイズを小さくします。 これを実現する 1 つの方法は、DAG の数を減らした複数の DAG フォルダーを複数のコンテナーにまたがって作成することです。

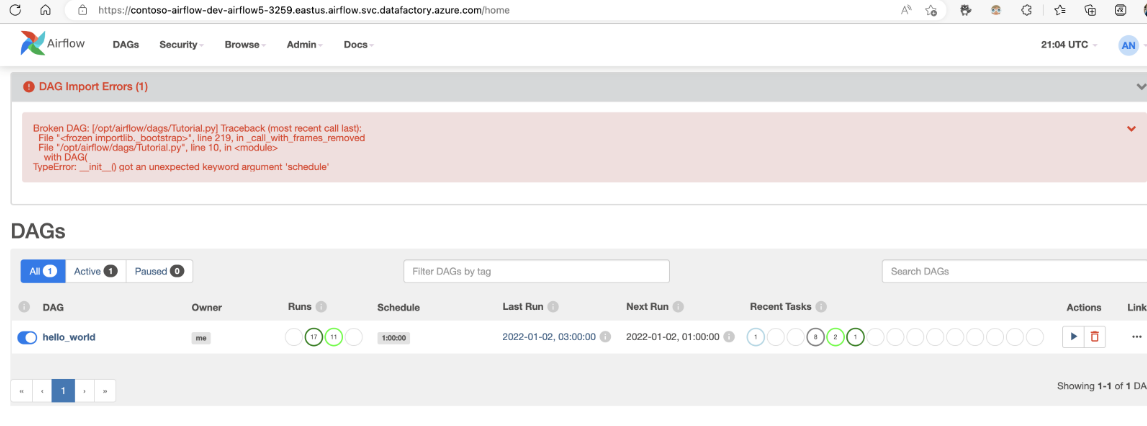

問題: Airflow UI にサインインすると、インポートされた DAG が表示されません。 対策: Airflow UI にサインインし、DAG 解析エラーがないかどうか確認します。 これは、互換性のないコードが DAG ファイルに含まれている場合に発生する可能性があります。 問題のある正確な行番号とファイルは Airflow UI を使用して確認できます。