Azure Blob Storage を使って DAG をインポートする

Note

この機能はパブリック プレビュー段階にあります。 ワークフロー オーケストレーション マネージャーは Apache Airflow を利用しています。

この記事では、Azure Blob Storage を使用して有向非巡回グラフ (DAG) をワークフロー オーケストレーション マネージャーにインポートする詳細な手順について説明します。

前提条件

- Azure サブスクリプション:Azure サブスクリプションをお持ちでない場合は、開始する前に無料の Azure アカウントを作成してください。

- Azure Data Factory: ワークフロー オーケストレーション マネージャー プレビューがサポートされているリージョンで Data Factory インスタンスを作成するか、または既存のものを選択します。

- Azure Storage アカウント: ストレージ アカウントがない場合の作成手順については、Azure Storage アカウントの作成に関する記事を参照してください。 ストレージ アカウントで、選択したネットワーク からのアクセスのみが許可されていることを確認します。

プレビュー期間中、仮想ネットワークの背後にある Blob Storage はサポートされていません。 storageLinkedServices の Azure Key Vault の構成では、DAG のインポートはサポートされていません。

DAG のインポート

設定した Airflow 環境に基づいて、Apache Airflow v2.x DAG のサンプルまたは Apache Airflow v1.10 DAG のサンプルのいずれかをコピーします。 tutorial.py という名前の新しいファイルにコンテンツを貼り付けます。

tutorial.py ファイルを Blob Storage にアップロードします。 詳細については、ファイルの BLOB へのアップロードに関するページを参照してください。

Note

dags および plugins という名前のフォルダーを含むディレクトリ パスを Blob Storage アカウントから選択して、それらを Airflow 環境にインポートする必要があります。 プラグインは必須ではありません。 dags という名前のコンテナーを作成し、すべての Airflow ファイルをその中にアップロードすることもできます。

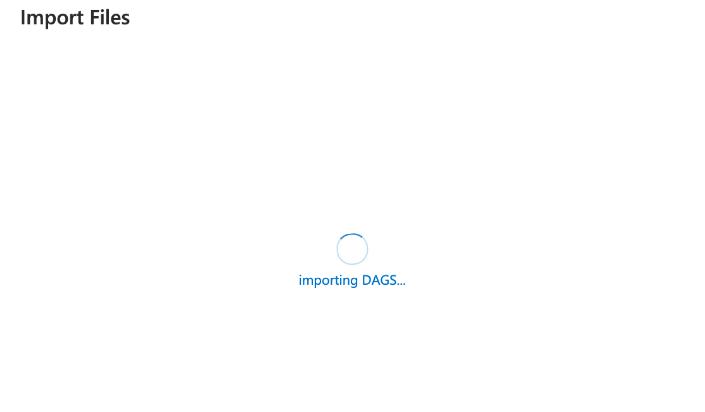

[管理] ハブで、[Apache Airflow] を選択します。 次に、以前に作成した Airflow 環境にマウス ポインターを合わせて [ファイルのインポート] を選択し、すべての DAG と依存関係を Airflow 環境にインポートします。

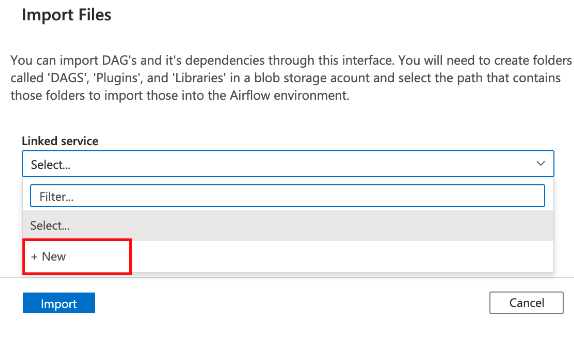

「前提条件」セクションで説明されている、アクセス可能なストレージ アカウントへの新しいリンク サービスを作成します。 独自の DAG が既にある場合は、既存のものを使用することもできます。

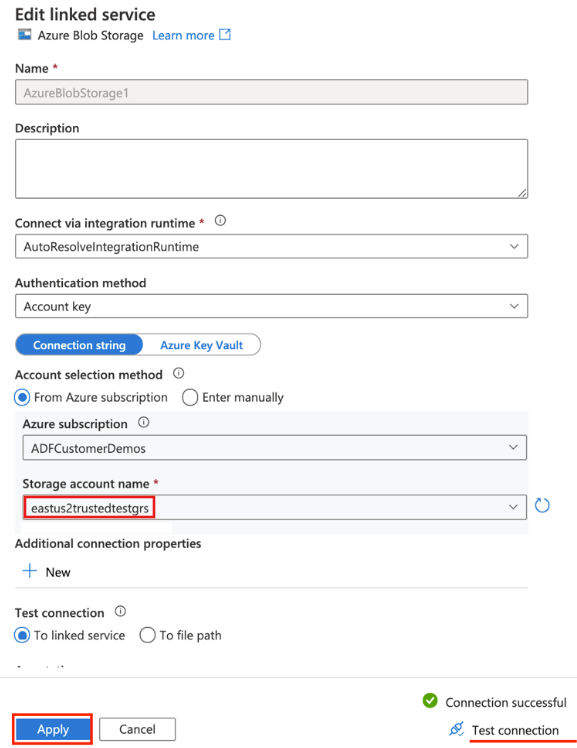

DAG をアップロードしたストレージ アカウントを使用します。 (「前提条件」セクションを確認してください)。接続をテストし、[作成] を選択します。

サンプルの SAS URL を使用している場合は、airflow を参照して選択します。 DAG ファイルを含む dags フォルダーが格納されたフォルダーを選択することもできます。

Note

このインターフェイスを使用して、DAG とその依存関係をインポートできます。 dags および plugins という名前のフォルダーを含むディレクトリ パスを Blob Storage アカウントから選択して、それらを Airflow 環境にインポートする必要があります。 プラグインは必須ではありません。

[インポート] を選択してファイルをインポートします。

プレビュー期間中は、DAG のインポートに数分かかる場合があります。 通知センター (Data Factory UI のベル アイコン) を使用して、インポート状態の更新を追跡できます。

![[管理] ハブでのファイルのインポートを示すスクリーンショット。](media/how-does-workflow-orchestration-manager-work/import-files.png)

![[ファイルのインポート] 画面の [ストレージの参照] ボタンを示すスクリーンショット。](media/how-does-workflow-orchestration-manager-work/browse-storage.png)

![[参照] の airflow ルート フォルダーを示すスクリーンショット。](media/how-does-workflow-orchestration-manager-work/browse.png)

![[ファイルのインポート] 画面の [インポート] ボタンを示すスクリーンショット。](media/how-does-workflow-orchestration-manager-work/import-in-import-files.png)