Copiare i dati e trasformarli con parametri dinamici ogni ora

SI APPLICA A:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Suggerimento

Provare Data Factory in Microsoft Fabric, una soluzione di analisi all-in-one per le aziende. Microsoft Fabric copre tutto, dallo spostamento dati al data science, all'analisi in tempo reale, alla business intelligence e alla creazione di report. Vedere le informazioni su come iniziare una nuova prova gratuita!

In questo scenario si vogliono copiare dati da AWS S3 all'archiviazione BLOB di Azure e trasformarli con Azure Databricks (con parametri dinamici nello script) in base a una pianificazione oraria per 8 ore ogni giorno su 30 giorni.

I prezzi utilizzati in questo esempio di seguito sono ipotetici e non sono destinati a implicare prezzi effettivi esatti. I costi di lettura/scrittura e monitoraggio non vengono visualizzati perché in genere sono trascurabili e non influiscono in modo significativo sui costi complessivi. Le esecuzioni di attività vengono arrotondate anche ai 1.000 più vicini nelle stime del calcolatore dei prezzi.

Fare riferimento al Calcolatore prezzi di Azure per scenari più specifici e per stimare i costi futuri per l'uso del servizio.

Impostazione

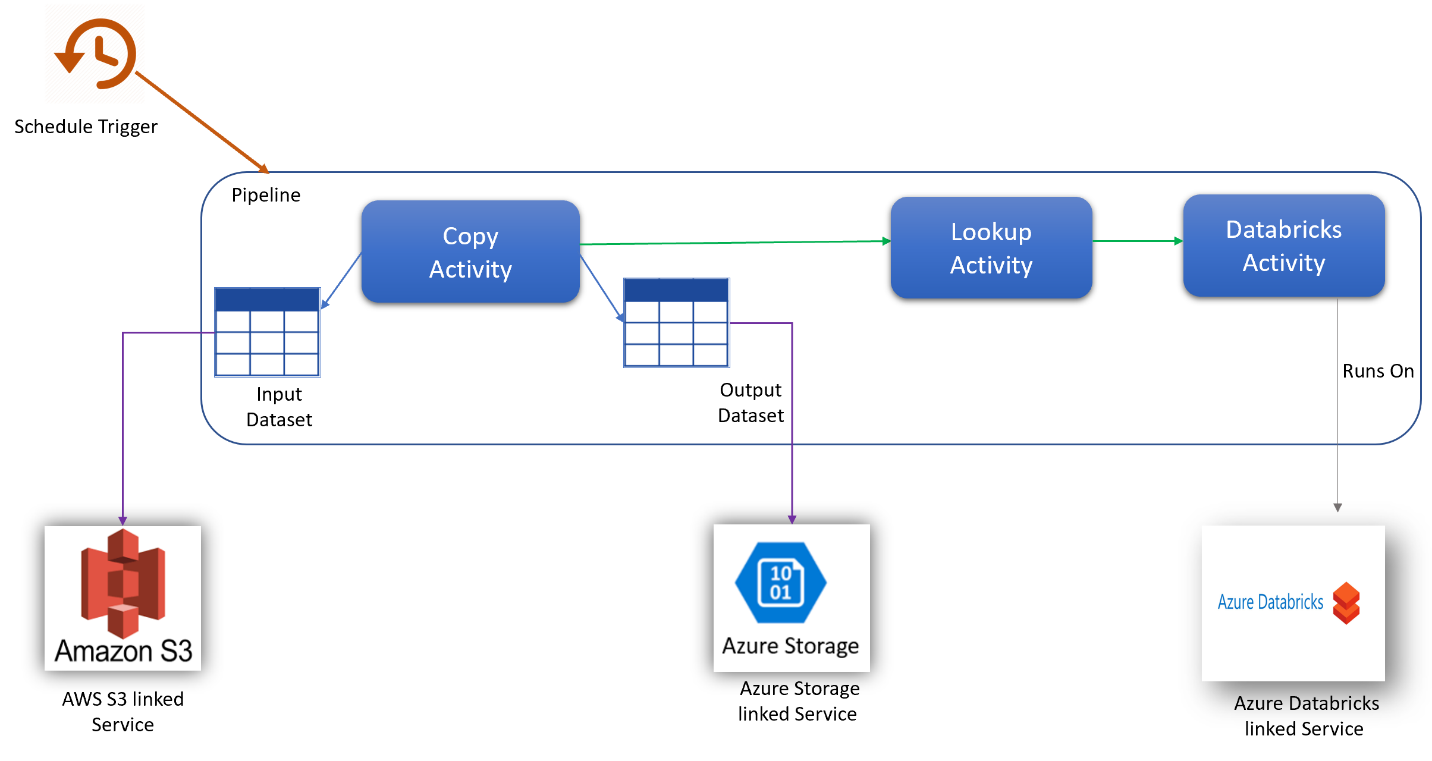

Per eseguire lo scenario è necessario creare una pipeline con gli elementi seguenti:

- Una sola attività di copia con un set di dati di input per i dati da copiare da AWS S3 e un set di dati di output per i dati in Archiviazione di Azure.

- Una sola attività di ricerca per passare i parametri in modo dinamico allo script di trasformazione.

- Una sola attività di Azure Databricks per la trasformazione dei dati.

- Un trigger di pianificazione per eseguire la pipeline ogni ora per 8 ore al giorno. Quando si vuole eseguire una pipeline, è possibile attivarla immediatamente o pianificarla. Oltre alla pipeline stessa, ogni istanza del trigger viene conteggiata come singola esecuzione di attività.

Stima dei costi

| Operazioni | Tipi e unità |

|---|---|

| Eseguire la pipeline | 4 Esecuzioni di attività per esecuzione (1 per l'esecuzione del trigger, 3 per le esecuzioni di attività) = 960 esecuzioni di attività, arrotondate per esaurire poiché il calcolatore consente solo incrementi di 1000. |

| Presupposto copia dati: ore DIU per esecuzione = 10 min | 10 min/60 min * 4 Azure Integration Runtime (impostazione DIU predefinita = 4) Per altre informazioni sulle unità di integrazione dati e l'ottimizzazione delle prestazioni di copia, vedere questo articolo |

| Presupposto dell'attività Esegui ricerca: ore di attività della pipeline per esecuzione = 1 min | 1 min/ 60 min esecuzione dell'attività della pipeline |

| Esecuzione del presupposto dell'attività di Databricks: ore di esecuzione esterna per esecuzione = 10 min | 10 min / 60 min Esecuzione dell'attività della pipeline esterna |

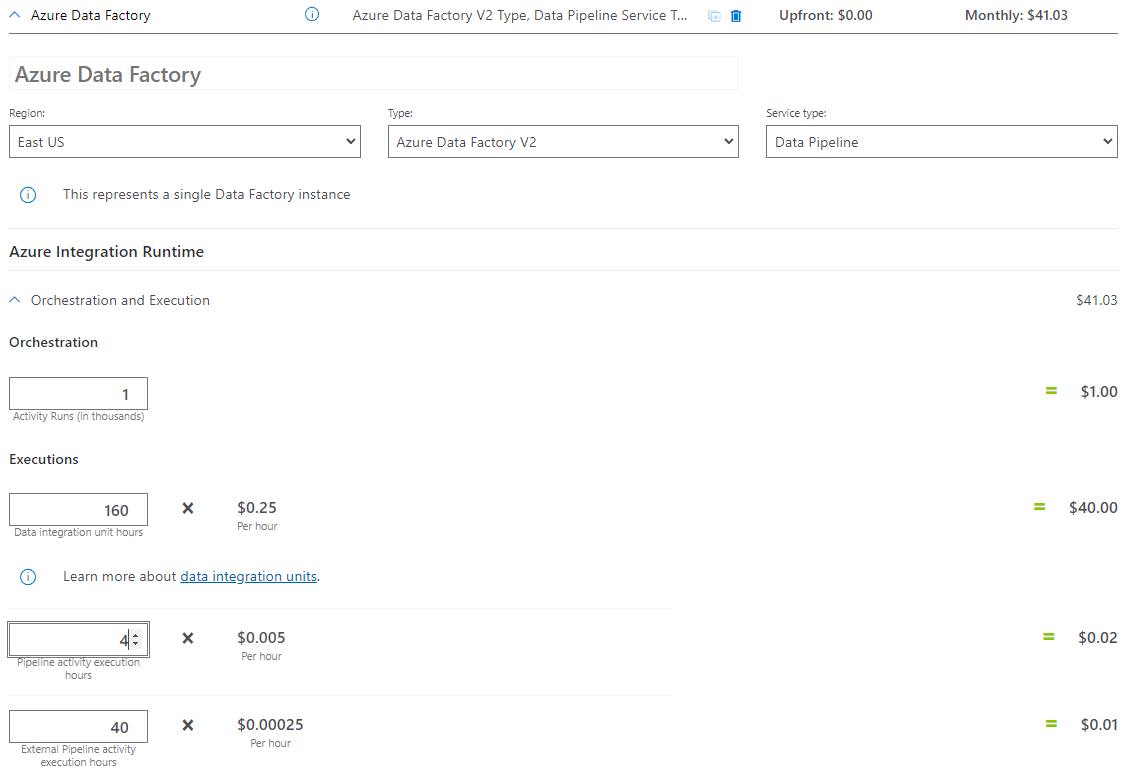

Esempio di prezzi: Esempio di calcolatore prezzi

Prezzi totali dello scenario per 30 giorni: $ 41,03

Contenuto correlato

- Esempio di prezzi: copiare i dati da AWS S3 in Archiviazione BLOB di Azure ogni ora per 30 giorni

- Esempio di prezzi: copiare dati e trasformare con Azure Databricks ogni ora per 30 giorni

- Esempio di prezzi: eseguire pacchetti SSIS in Azure-SSIS Integration Runtime

- Esempio di prezzi: usare il debug del flusso di dati per mapping per una giornata lavorativa normale

- Esempio di prezzi: trasformare i dati nell'archivio BLOB con flussi di dati per mapping

- Esempio di prezzi: integrazione dei dati nella rete virtuale gestita di Azure Data Factory

- Esempio di prezzi: ottenere dati differenziali da SAP ECC tramite SAP CDC nei flussi di dati per mapping