Qu’est-ce que Real-Time Intelligence ?

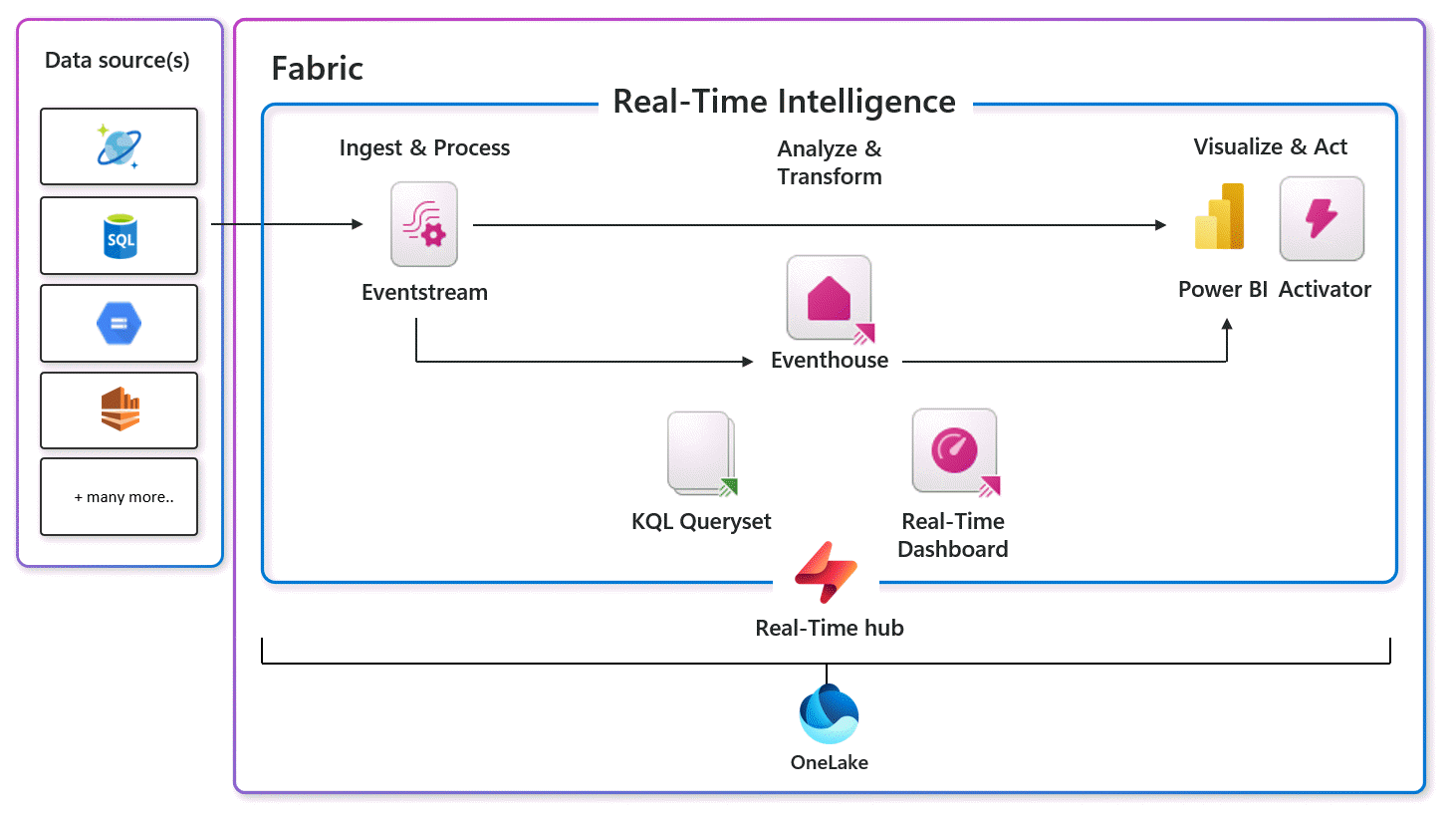

Real-Time Intelligence est un service puissant qui permet à tous les membres de votre organisation d’extraire des insights et de visualiser leurs données en mouvement. Vous avez ainsi une solution de bout en bout pour les scénarios pilotés par les événements, les données de diffusion et les journaux de données. Que l’on parle de gigaoctets ou de pétaoctets, toutes les données organisationnelles en mouvement convergent dans le hub en temps réel. Il connecte en toute transparence des données basées sur le temps à partir de différentes sources à l’aide de connecteurs sans code, permettant des insights visuels immédiats, une analyse géospatiale et des réactions basées sur des déclencheurs qui font toutes partie d’un catalogue de données à l’échelle de l’organisation.

Une fois que vous connectez en toute transparence n’importe quel flux de données, la solution SaaS devient entièrement accessible. Real-Time Intelligence gère l’ingestion, la transformation, le stockage, l’analytique, la visualisation, le suivi, l’IA et les actions en temps réel. Vos données restent protégées, régies et intégrées au sein de votre organisation, en s’alignant en toute transparence sur toutes les offres Fabric. Real-Time Intelligence transforme vos données en une ressource dynamique et exploitable qui génère de la valeur dans l’ensemble de l’organisation.

Real-Time Intelligence peut-il m’aider ?

Real-Time Intelligence peut être utilisé pour l’analyse des données, les insights visuels immédiats, la centralisation des données en mouvement pour une organisation, les actions impliquant des données, l’interrogation efficace, la transformation et le stockage de grands volumes de données structurées ou non structurées. Que vous deviez évaluer les données des systèmes IoT, des journaux système, du texte libre, des données semi-structurées ou contribuer à la consommation par d’autres membres de votre organisation, Real-Time Intelligence fournit une solution polyvalente.

En dépit de l’appellation « temps réel » (real-time), il n’est pas nécessaire que vos données circulent à des taux et des volumes élevés. Real-Time Intelligence vous offre des solutions pilotées par les événements, plutôt que des solutions pilotées par la planification. Les composants Real-Time Intelligence sont basés sur des services Microsoft de base essentiels et fiables et, ensemble, ils étendent les capacités globales de Fabric pour fournir des solutions basées sur des événements.

Les applications Real-Time Intelligence s’étendent sur un large éventail de scénarios métier, tels que l’automobile, la fabrication, l’IoT, la détection des fraudes, la gestion des opérations commerciales et la détection d’anomalies.

Comment utiliser Real-Time Intelligence ?

Real-Time Intelligence dans Microsoft Fabric offre des fonctionnalités qui, en combinaison, permettent la création de solutions Real-Time Intelligence pour prendre en charge les processus métier et d’ingénierie.

Le hub Real-Time sert de catalogue centralisé au sein de votre organisation. Il facilite l’accès, l’ajout, l’exploration et le partage de données. Développer la gamme de sources de données permet des insights et une clarté visuelle plus larges sur différents domaines. Il est important de noter que ce hub garantit que les données, non seulement, soient disponibles, mais qu’elles soient également accessibles à tous, en favorisant une prise de décision rapide et une action éclairée. Le partage de données de diffusion en continu provenant de diverses sources débloque le potentiel de créer une intelligence décisionnelle complète au sein de votre organisation.

Une fois que vous avez sélectionné un flux provenant de votre organisation ou connecté à des sources externes ou internes, vous pouvez utiliser les outils de consommation de données de Real-Time Intelligence pour explorer vos données. Les outils de consommation de données utilisent le processus d’exploration des données visuelles et explorent les insights sur les données. Vous pouvez accéder aux données qui sont nouvelles pour vous et comprendre facilement la structure des données, les modèles, les anomalies, les prévisions de quantités, et les taux de données. En conséquence, vous pouvez agir ou prendre une décision intelligente en fonction des données. Les tableaux de bord en temps réel sont équipés d’interactions prêtes à l’emploi qui simplifient le processus de compréhension des données, ce qui le rend accessible à toute personne qui souhaite prendre une décision basée sur des données en mouvement à l’aide d’outils visuels, de langage naturel et de Copilot.

Ces insights peuvent être transformés en actions avec Fabric Activator, lorsque vous configurez des alertes de différentes parties de Fabric pour réagir aux modèles de données ou aux conditions en temps réel.

Comment est-ce que j’interagis avec les composants de l’intelligence en temps réel ?

Découvrir les données de diffusion en continu

Le hub Real-Time est utilisé pour découvrir et gérer vos données de diffusion en continu. Les événements du hub Real-Time sont un catalogue de données en mouvement et contiennent :

Flux de données : tous les flux de données qui s’exécutent activement dans Fabric, auxquels vous avez accès.

Sources Microsoft : découvrez facilement les sources de diffusion en continu dont vous disposez et configurez rapidement l’ingestion de ces sources dans Fabric, par exemple : Azure Event Hubs, Azure IoT Hub, capture des changements de données (CDC) d’Azure SQL DB, CDC d’Azure Cosmos DB, CDC de PostgreSQL DB.

Événements Fabric : les fonctionnalités pilotées par les événements prennent en charge les notifications en temps réel et le traitement des données. Vous pouvez surveiller et réagir aux événements, y compris les événements d’élément d’espace de travail Fabric et les événements de Stockage Blob Azure. Ces événements peuvent être utilisés pour déclencher d’autres actions ou d’autres flux de travail, tels que le lancement d’un pipeline de données ou l’envoi d’une notification par e-mail. Vous pouvez également envoyer ces événements à d’autres destinations via des Eventstreams.

Ces données sont toutes présentées dans un format facilement consommable et sont disponibles pour toutes les charges de travail Fabric.

Se connecter à des données de diffusion en continu

Les Eventstreams sont le moyen de la plate-forme Fabric pour capturer, transformer et acheminer des événements en temps réel vers diverses destinations avec une expérience sans code. Les eventstreams prennent en charge plusieurs sources de données et destinations de données, notamment un large éventail de connecteurs vers des sources externes, par exemple : clusters Apache Kafka, flux de capture de données modifiées de base de données, sources de streaming AWS (Kinesis) et Google (pub/sub GCP).

Traitement des flux de données

En utilisant les fonctionnalités de traitement des événements dans Eventstreams, vous pouvez effectuer un filtrage, un nettoyage des données, une transformation, des agrégations fenêtrés et une détection de double, pour placer les données dans la forme souhaitée. Vous pouvez également utiliser les fonctionnalités de routage basées sur le contenu pour envoyer des données à différentes destinations en fonction des filtres. Une autre fonctionnalité, les eventstreams dérivés, vous permet de construire de nouveaux flux suite à des transformations et/ou des agrégations qui peuvent être partagées avec les consommateurs dans le hub en temps réel.

Stocker et analyser les données

Les Eventhouses sont le moteur d’analytique idéal pour traiter les données en mouvement. Ils sont spécifiquement adaptés aux événements de diffusion en continu basés sur le temps et comprenant des données structurées, semi-structurées et non structurées. Ces données sont automatiquement indexées et partitionnés en fonction du temps d’ingestion, ce qui vous offre des fonctionnalités d’interrogation analytiques extrêmement rapides et complexes sur des données de haute granularité. Les données stockées dans des eventhouses peuvent être mises à disposition dans OneLake pour être exploitées par d’autres expériences Fabric.

Les données indexées et partitionnées stockées dans des eventhouses sont prêtes pour une requête rapide à l’aide de diverses options de code, de code réduit ou d’absence de code dans Fabric. Les données peuvent être interrogées dans KQL natif (Langage de requête Kusto) ou à l’aide de T-SQL dans l’ensemble de requêtes KQL. Le Copilot Kusto, ainsi que l’expérience d’exploration des requêtes sans code, simplifie le processus d’analyse de données, tant pour les utilisateurs expérimentés de KQL que pour les scientifiques des données amateurs. KQL est un langage simple, mais puissant qui permet d’interroger des données structurées, semi-structurées et non structurées. Ce langage est expressif, facilite la lecture et la compréhension de l’intention de la requête, et est optimisé pour les expériences de création.

Visualiser les insights de données

Ces insights de données peuvent être visualisés dans des ensembles de requêtes KQL, des tableaux de bord en temps réel et des rapports Power BI, avec un délai de quelques secondes entre l’ingestion de données et les insights. Les options de visualisation varient de sans code à des expériences entièrement spécialisées, ce qui permet aux novices comme aux experts en exploration d’insights de visualiser leurs données sous forme de graphiques et de tables. Vous pouvez utiliser des indications visuelles pour effectuer des opérations de filtrage et d’agrégation sur les résultats des requêtes et utiliser une liste complète de visualisations intégrées. Ces insights peuvent être consultés dans les rapports Power BI et les tableaux de bord en temps réel, tous deux pouvant avoir des alertes basées sur les insights de données.

Actions de déclencheur

Les alertes surveillent la modification des données et prennent automatiquement des mesures lorsque des modèles ou des conditions sont détectés. Les données peuvent être transmises dans un hub Real-Time ou observées à partir d’une requête Kusto ou d’un rapport Power BI. Lorsque certaines conditions ou logiques sont remplies, une action est ensuite effectuée, comme l’alerte des utilisateurs, l’exécution d’éléments de travail Fabric comme un pipeline ou le lancement de flux de travail Power Automate. La logique peut être un seuil simplement défini, un modèle tel que des événements se produisant à plusieurs reprises sur une période, ou les résultats d’une logique complexe définie par une requête KQL. Activator transforme vos observations menées par les événements en avantages exploitables dans le domaine du business.

S’intégrer à d’autres expériences Fabric

- Acheminer les événements depuis les eventstreams vers les destinations d’éléments Fabric

- Émettre des événements à partir d’éléments Fabric dans le hub Real-Time

- Accédez aux données dans OneLake à partir de Real-Time Intelligence de plusieurs façons :

- Les données provenant de OneLake peuvent être interrogées à partir de Real-Time Intelligence en tant que raccourci

- Utiliser les données chargées dans Real-Time Intelligence comme données sous-jacentes pour la visualisation dans un rapport Power BI

- Utiliser les données chargées dans Real-Time Intelligence à des fins d’analyse dans les notebooks Fabric en Ingénieurs de données