Configurer Azure Synapse Analytics dans une activité de copie

Cet article explique comment utiliser l'activité de copie dans le pipeline de données pour copier des données depuis et vers Azure Synapse Analytics.

Configuration prise en charge

Pour la configuration de chaque onglet sous l’activité de copie, accédez respectivement aux sections suivantes.

Général

Reportez-vous aux instructions relatives aux paramètres Général pour configurer l’onglet Paramètres Général .

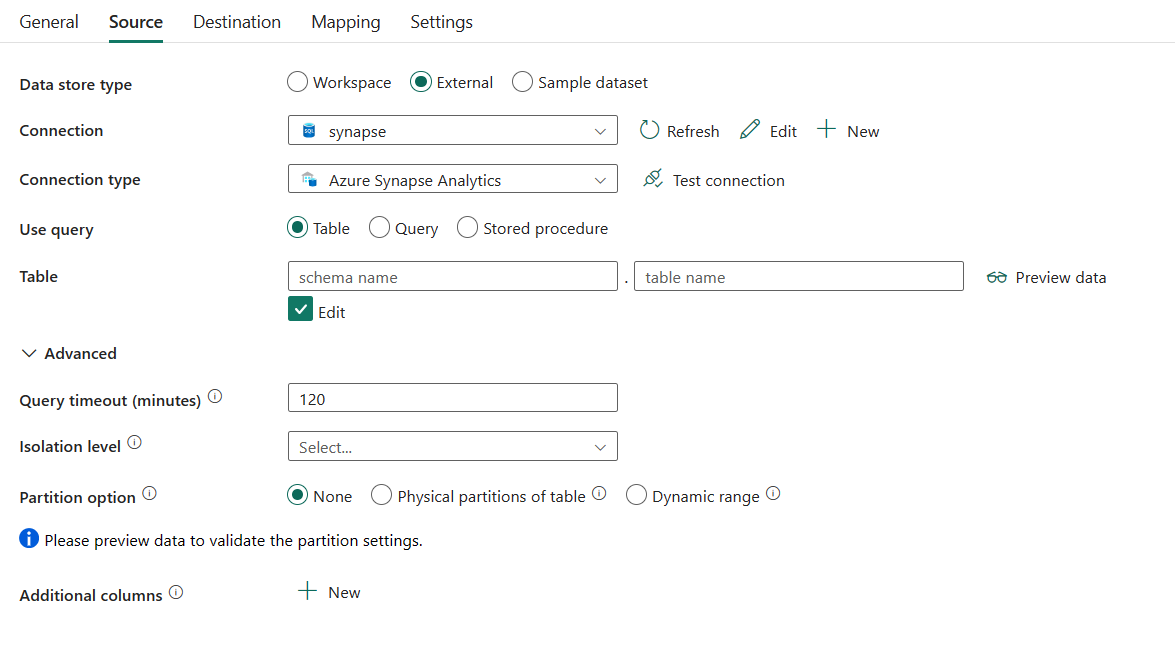

Source

Les propriétés suivantes sont prises en charge pour Azure Synapse Analytics sous l’onglet Source d’une activité de copie.

Les propriétés suivantes sont requises :

Type de magasin de données : sélectionnez Externe.

Connexion : sélectionnez une connexion Azure Synapse Analytics dans la liste des connexions. Si la connexion n’existe pas, créez une connexion Azure Synapse Analytics en sélectionnant Nouveau.

Pour Type de connexion : sélectionnez Azure Synapse Analytics.

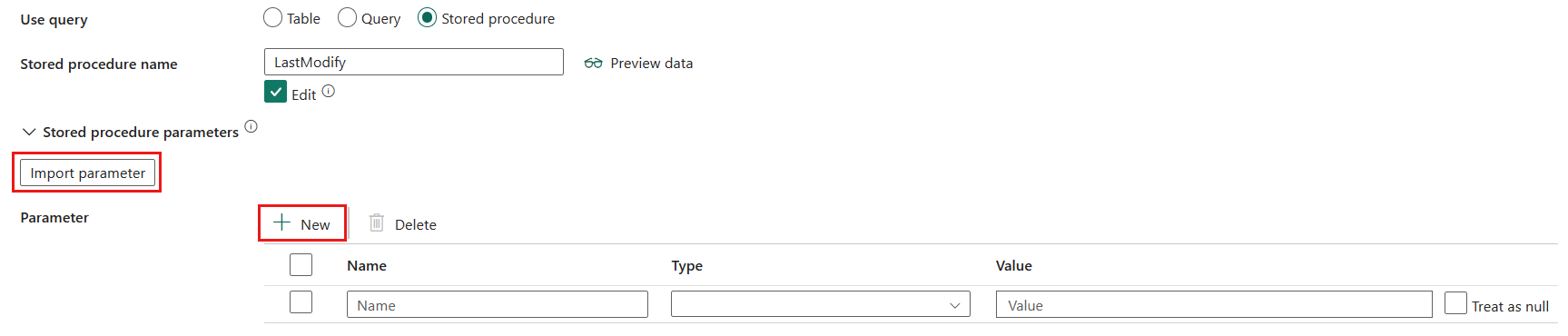

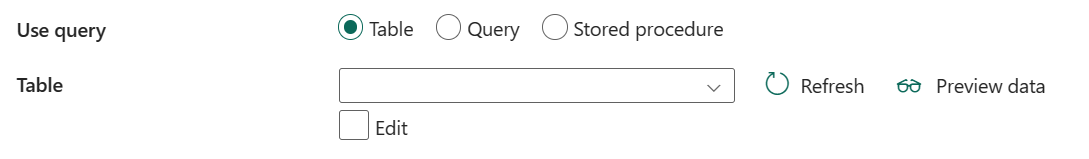

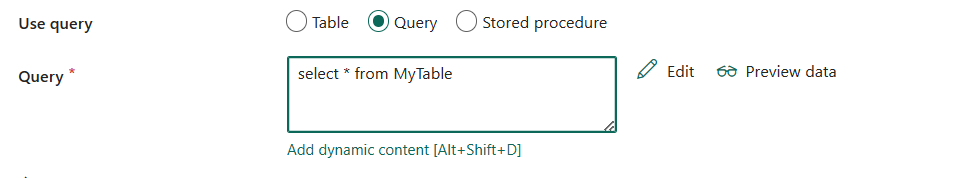

Utiliser la requête : vous pouvez choisir Table, Requête ou Procédure stockée pour lire vos données sources. La liste suivante décrit la configuration de chaque paramètre :

Table : lisez les données de la table que vous avez spécifiée dans Table si vous sélectionnez ce bouton. Sélectionnez votre table dans la liste déroulante ou sélectionnez Modifier pour entrer manuellement le nom de schéma et de table.

Requête : spécifie la requête SQL personnalisée pour lire les données. par exemple

select * from MyTable. Vous pouvez également sélectionner l’icône de crayon à modifier dans l’éditeur de code.

Procédure stockée : Nom de la procédure stockée qui lit les données de la table source. La dernière instruction SQL doit être une instruction SELECT dans la procédure stockée.

- Nom de procédure stockée : sélectionnez la procédure stockée ou spécifiez manuellement le nom de la procédure stockée lorsque vous sélectionnez Modifier.

- Paramètres de procédure stockée : sélectionnez Importer des paramètres pour importer le paramètre dans votre procédure stockée spécifiée ou ajoutez des paramètres pour la procédure stockée en sélectionnant + Nouveau. Les valeurs autorisées sont des paires de noms ou de valeurs. Les noms et la casse des paramètres doivent correspondre aux noms et à la casse des paramètres de la procédure stockée.

Sous Avancé, vous pouvez spécifier les champs suivants :

Délai d’expiration de la requête (minutes) : spécifiez le délai d’expiration pour l’exécution de la commande de requête, la valeur par défaut étant de 120 minutes. Si un paramètre est défini pour cette propriété, les valeurs autorisées sont un intervalle de temps, par exemple « 02:00:00 » (120 minutes).

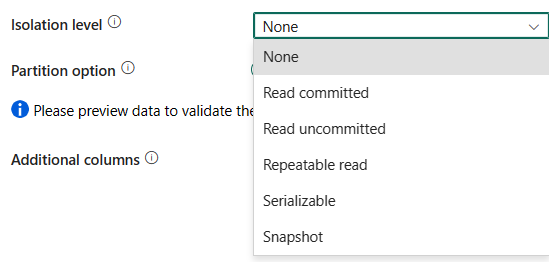

Niveau d’isolation : Spécifie le comportement de verrouillage des transactions pour la source SQL. Les valeurs autorisées sont les suivantes : Aucune, Validée en lecture, Invalidée en lecture, Lecture renouvelable, Sérialisable, ou Instantané. S’il n’est pas spécifié, aucun niveau d’isolation est utilisé. Pour plus d’informations, reportez-vous à IsolationLevel Enum.

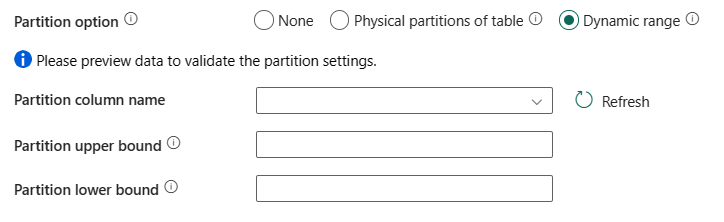

Option de partition : spécifiez les options de partitionnement des données utilisées pour charger des données à partir d’Azure Synapse Analytics. Les valeurs autorisées sont : Aucune (valeur par défaut), Partitions physiques de la table et Plage dynamique. Lorsqu’une option de partition est activée (autrement dit, pas Aucune), le degré de parallélisme pour charger simultanément des données à partir d’une instance Azure Synapse Analytics est contrôlé par le paramètre copie en parallèle sur l’activité de copie.

Aucun : choisissez ce paramètre pour ne pas utiliser de partition.

Partitions physiques de table : choisissez ce paramètre si vous souhaitez utiliser une partition physique. La colonne et le mécanisme de partition sont automatiquement déterminés en fonction de votre définition de table physique.

Plage dynamique : choisissez ce paramètre si vous souhaitez utiliser la partition de plage dynamique. Lors de l’utilisation d’une requête avec l’option parallèle activée, le paramètre de partition de plage(

?DfDynamicRangePartitionCondition) est nécessaire. Exemple de requête :SELECT * FROM <TableName> WHERE ?DfDynamicRangePartitionCondition.

- Nom de la colonne de partition : Indiquez le nom de la colonne source de type entier ou date/heure (

int,smallint,bigint,date,smalldatetime,datetime,datetime2, oudatetimeoffset) qui est utilisée par le partitionnement de plage pour la copie parallèle. S’il n’est pas spécifié, l’index ou la clé primaire de la table seront automatiquement détectés et utilisés en tant que colonne de partition. - Limite supérieure de la partition : Valeur maximale de la colonne de partition pour le fractionnement de la plage de partition. Cette valeur est utilisée pour décider du stride de la partition, et non pour filtrer les lignes de la table. Toutes les lignes de la table ou du résultat de la requête sont partitionnées et copiées.

- Limite inférieure de la partition : Valeur minimum de la colonne de partition pour le fractionnement de la plage de partition. Cette valeur est utilisée pour décider du stride de la partition, et non pour filtrer les lignes de la table. Toutes les lignes de la table ou du résultat de la requête sont partitionnées et copiées.

- Nom de la colonne de partition : Indiquez le nom de la colonne source de type entier ou date/heure (

Colonnes supplémentaires : ajoutez des colonnes de données supplémentaires au chemin d’accès relatif ou à la valeur statique des fichiers sources du magasin. L’expression est prise en charge pour ce dernier. Pour plus d’informations, accédez à Ajouter des colonnes supplémentaires pendant la copie.

Destination

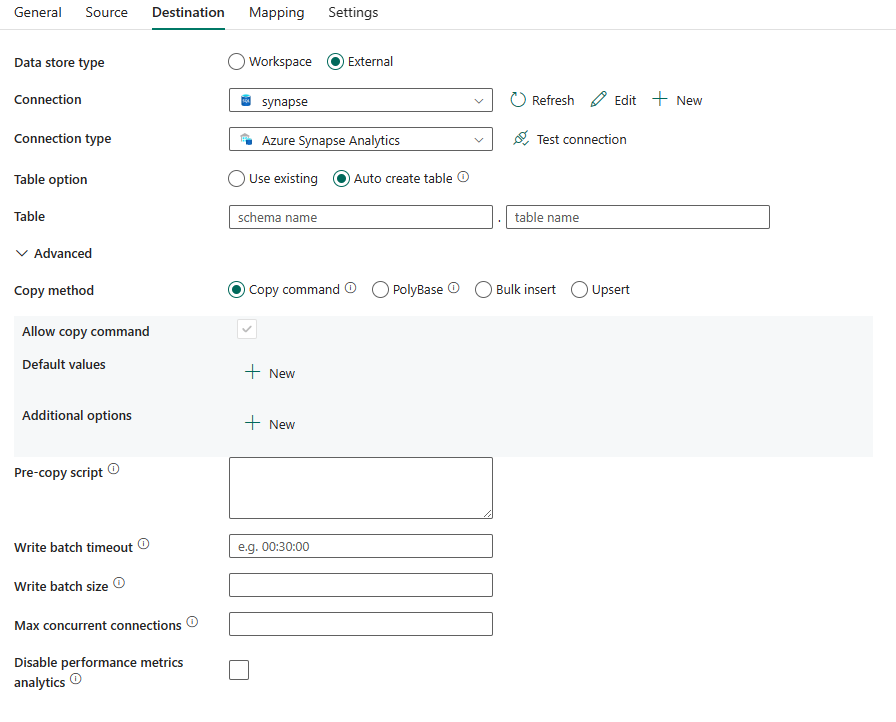

Les propriétés suivantes sont prises en charge pour Azure Synapse Analytics sous l’onglet Destination d’une activité de copie.

Les propriétés suivantes sont requises :

- Type de magasin de données : sélectionnez Externe.

- Connexion : sélectionnez une connexion Azure Synapse Analytics dans la liste des connexions. Si la connexion n’existe pas, créez une connexion Azure Synapse Analytics en sélectionnant Nouveau.

- Pour Type de connexion : sélectionnez Azure Synapse Analytics.

- Option de table : vous pouvez choisir Utiliser une table existante, Créer automatiquement une table. La liste suivante décrit la configuration de chaque paramètre :

- Utiliser une table existante : sélectionnez la table dans votre base de données depuis la liste déroulante. Sinon, vous pouvez cocher Modifier pour entrer manuellement le nom de votre schéma et de votre table.

- Création automatique de table : crée automatiquement la table (si elle n’existe pas) dans le schéma source.

Sous Avancé, vous pouvez spécifier les champs suivants :

Méthode de copie Choisissez la méthode que vous souhaitez utiliser pour copier des données. Vous pouvez choisir Commande de copie, PolyBase, Bulk insert ou Upsert. La liste suivante décrit la configuration de chaque paramètre :

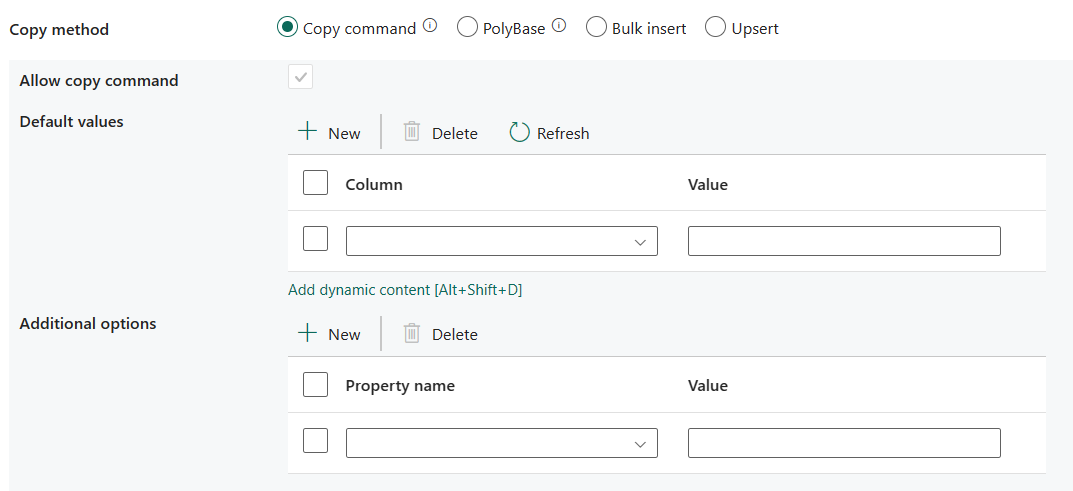

Commande de copie : utilisez l'instruction COPY pour charger des données du Stockage Azure dans Azure Synapse Analytics ou un pool SQL.

- Autoriser la commande de copie : l’option doit être sélectionnée lorsque vous choisissez Copier la commande.

- Valeurs par défaut : spécifiez les valeurs par défaut de chaque colonne cible dans Azure Synapse Analytics. Les valeurs par défaut de la propriété remplacent le jeu de contraintes DEFAULT défini dans l’entrepôt de données, et la colonne d’identité ne peut pas avoir de valeur par défaut.

- Options supplémentaires : les options supplémentaires qui seront passées à l’instruction COPY d’Azure Synapse Analytics directement dans la clause « With » dans l’instruction COPY. Citez la valeur en fonction des besoins pour l’aligner sur les spécifications de l’instruction COPY.

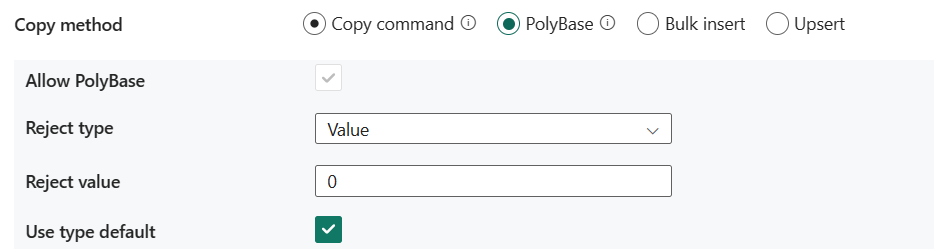

PolyBase : PolyBase est un mécanisme à débit élevé. Utilisez-le pour charger de grandes quantités de données dans Azure Synapse Analytics ou un pool SQL.

- Autoriser PolyBase : cette option doit être sélectionnée lorsque vous choisissez PolyBase.

- Type de rejet : spécifiez si l’option rejectValue est une valeur littérale ou un pourcentage. Les valeurs autorisées sont Value (par défaut) et Percentage.

- Valeur de rejet : spécifiez le nombre ou le pourcentage de lignes pouvant être rejetées avant l’échec de la requête. Découvrez-en plus sur les options de rejet de PolyBase dans la section Arguments de CREATE EXTERNAL TABLE (Transact-SQL). Les valeurs autorisées sont : 0 (par défaut), 1, 2, et ainsi de suite.

- Valeur d’échantillon de rejet : détermine le nombre de lignes à récupérer avant que PolyBase recalcule le pourcentage de lignes rejetées. Les valeurs autorisées sont 1, 2, etc. Cette propriété est obligatoire si vous choisissez Pourcentage comme type de rejet.

- Utiliser le type par défaut : spécifiez comment gérer les valeurs manquantes dans les fichiers texte délimités lorsque PolyBase récupère des données à partir du fichier texte. Pour plus d’informations sur cette propriété, consultez la section Arguments dans CREATE EXTERNAL FILE FORMAT (Transact-SQL). Les valeurs autorisées sont sélectionnées (par défaut) ou désélectionnées.

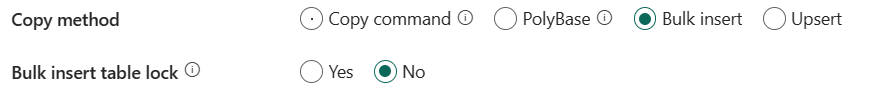

Bulk insert : utilisez Bulk insert pour insérer des données en bloc vers la destination.

- Verrou de table Bulk insert : utilisez cette option pour améliorer les performances de copie lors de l’opération d’insertion en bloc dans la table sans index, à partir de plusieurs clients. Pour plus d’informations, consultez BULK INSERT (Transact-SQL).

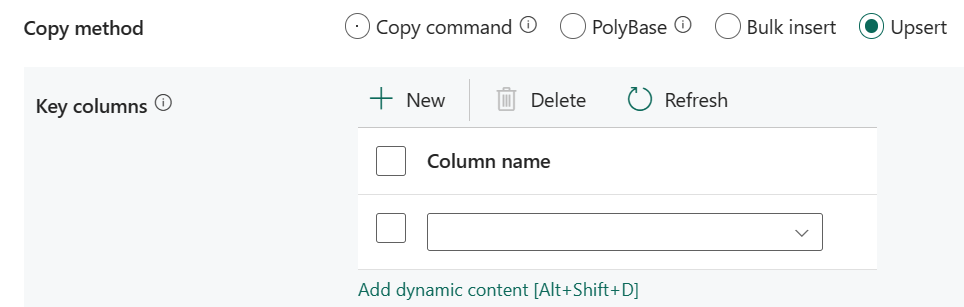

Upsert : spécifiez le groupe des paramètres pour le comportement d’écriture lorsque vous souhaitez faire un upsert de données vers votre destination.

Colonnes clés : choisissez la colonne utilisée pour déterminer si une ligne de la source correspond à une ligne de la destination.

Verrou de table Bulk insert : utilisez cette option pour améliorer les performances de copie lors de l’opération d’insertion en bloc dans la table sans index, à partir de plusieurs clients. Pour plus d’informations, consultez BULK INSERT (Transact-SQL).

Script de pré-copie : spécifiez un script pour l’activité de copie à exécuter avant d’écrire des données dans une table de destination à chaque exécution. Vous pouvez utiliser cette propriété pour nettoyer des données préchargées.

Délai d'attente du lot d'écriture : Temps d’attente pour que l’opération d’insertion par lot soit terminée avant d’expirer. La valeur autorisée est timespan. La valeur par défaut est 00:30:00 (30 minutes).

Taille de lot d’écriture : spécifiez le nombre de lignes à insérer dans la table SQL par lot. La valeur autorisée est integer (nombre de lignes). Par défaut, le service détermine de façon dynamique la taille de lot appropriée selon la taille de ligne.

Nombre maximal de connexions simultanées : spécifie la limite supérieure de connexions simultanées établies au magasin de données pendant l’exécution de l’activité. Spécifiez une valeur uniquement lorsque vous souhaitez limiter les connexions simultanées.

Désactiver l’analytique des métriques de performances : ce paramètre est utilisé pour collecter des métriques, telles que DTU, DWU, RU, etc., pour l’optimisation des performances de copie et les recommandations. Si ce comportement vous préoccupe, cochez cette case. L’option est non sélectionnée par défaut.

Copie directe à l’aide de la commande COPY

La commande COPY d’Azure Synapse Analytics prend directement en charge le Stockage Blob Azure et Azure Data Lake Storage Gen2 en tant que magasins de données sources. Si vos données sources répondent aux critères décrits dans cette section, utilisez la commande COPY pour copier directement à partir du magasin de données source vers Azure Synapse Analytics.

Les données sources et le format contiennent les types et méthodes d’authentification suivants :

Type de magasin de données sources pris en charge Format pris en charge Type d’authentification source pris en charge Stockage Blob Azure Texte délimité

ParquetAuthentification anonyme

Authentification par clé de compte

Authentification avec une signature d’accès partagéAzure Data Lake Storage Gen2 Texte délimité

ParquetAuthentification par clé de compte

Authentification avec une signature d’accès partagéLes paramètres de format suivants peuvent être définis :

- Pour Parquet : le type de compression peut être Aucun, snappy ou gzip.

- Pour DelimitedText :

- Séparateur de lignes : lors de la copie de texte délimité dans Azure Synapse Analytics via la commande COPY directe, spécifiez explicitement le séparateur de lignes (\r, \n ou \r\n). La valeur par défaut (\r, \n ou \r\n) ne fonctionne que si le séparateur de lignes du fichier source est \r\n. Sinon, activez la mise en lots pour votre scénario.

- La valeur null conserve sa valeur par défaut ou est définie sur chaîne vide ("").

- L’encodage conserve sa valeur par défaut ou est défini sur UTF-8 ou UTF-16.

- Le nombre de lignes à ignorer conserve sa valeur par défaut ou est défini sur 0.

- Le type de compression peut être Aucun ou gzip.

Si votre source est un dossier, vous devez activer la case à cocher Récursivement.

L’heure de début (UTC) et l’heure de fin (UTC) dans Filtrer par date de dernière modification, Préfixe, Activer la découverte de partition et Colonnes supplémentaires ne sont pas spécifiées.

Pour savoir comment ingérer des données dans votre Azure Synapse Analytics à l’aide de la commande COPY, consultez cet article.

Si votre magasin de données source et son format ne sont pas pris en charge à l’origine par la commande COPY, utilisez plutôt la fonctionnalité Copie intermédiaire à l’aide de la commande COPY. Elle convertit automatiquement les données dans un format compatible avec la commande COPY, puis appelle une commande COPY pour charger les données dans Azure Synapse Analytics.

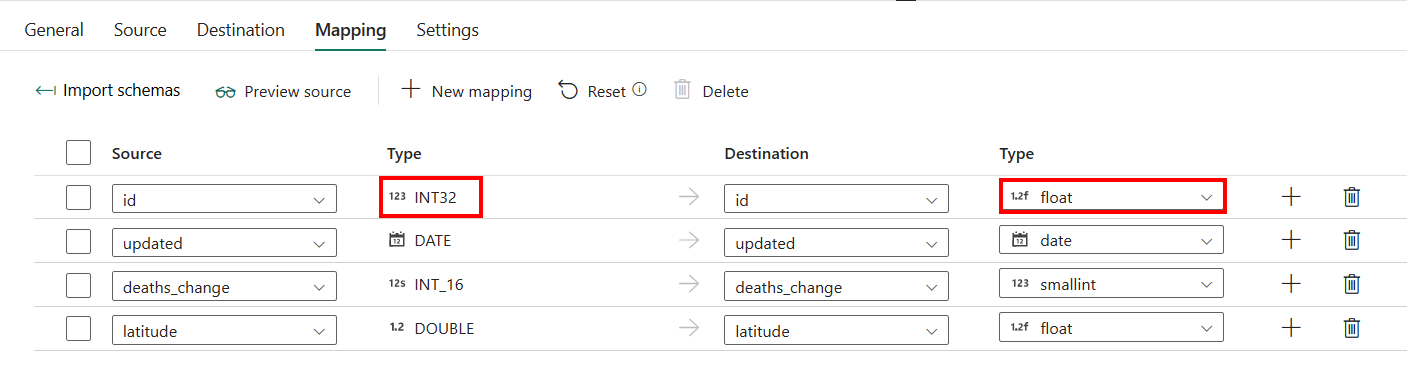

Mappage

Pour la configuration de la Tabulation Mappage, si vous n'appliquez pas Azure Synapse Analytics avec la table de création automatique comme destination, allez sur Mappage.

Si vous appliquez Azure Synapse Analytics avec une table de création automatique comme destination, à l'exception de la configuration dans Mappage, vous pouvez modifier le type de vos colonnes de destination. Après avoir sélectionné Importer des schémas, vous pouvez spécifier le type de colonne dans votre destination.

Par exemple, le type de la colonne ID dans la source est int. Vous pouvez le changer par le type float lors du mappage vers la colonne de destination.

Paramètres

Pour la configuration de l’onglet Paramètres, accédez à Configurer vos autres paramètres sous l’onglet Paramètres.

Copie en parallèle à partir d’Azure Synapse Analytics

Le connecteur Azure Synapse Analytics dans l’activité de copie propose un partitionnement de données intégré pour copier des données en parallèle. Vous trouverez des options de partitionnement de données dans l’onglet Source de l’activité de copie.

Lorsque vous activez la copie partitionnée, l’activité de copie exécute des requêtes en parallèle sur votre source Azure Synapse Analytics pour charger des données par partitions. Le degré de parallélisme est contrôlé par le Degré de parallélisme de copie sous l’onglet des paramètres de l’activité de copie. Par exemple, si vous définissez Degré de parallélisme de copie sur quatre, le service génère et exécute simultanément quatre requêtes en fonction de l’option et des paramètres de votre partition spécifiée, et chaque requête récupère une partie des données de votre instance Azure Synapse Analytics.

Il vous est recommandé d’activer la copie en parallèle avec partitionnement des données notamment lorsque vous chargez une grande quantité de données à partir de votre instance Azure Synapse Analytics. Voici quelques suggestions de configurations pour différents scénarios. Lors de la copie de données dans un magasin de données basé sur un fichier, il est recommandé d’écrire les données dans un dossier sous la forme de plusieurs fichiers (spécifiez uniquement le nom du dossier). Les performances seront meilleures qu’avec l’écriture de données dans un seul fichier.

| Scénario | Paramètres suggérés |

|---|---|

| Chargement complet à partir d’une table volumineuse, avec des partitions physiques. | Option de partition : Partitions physiques de la table. Pendant l’exécution, le service détecte automatiquement les partitions physiques et copie les données par partition. Pour vérifier si votre table possède, ou non, une partition physique, vous pouvez vous reporter à cette requête. |

| Chargement complet d’une table volumineuse, sans partitions physiques, avec une colonne d’entiers ou DateHeure pour le partitionnement des données. | Options de partition : Partition dynamique par spécification de plages de valeurs. Colonne de partition (facultatif) : Spécifiez la colonne utilisée pour partitionner les données. Si la valeur n’est pas spécifiée, la colonne de l’index ou de la clé primaire est utilisée. Limite supérieure de partition et limite inférieure de partition (facultatif) : Spécifiez si vous souhaitez déterminer le stride de la partition. Cela ne permet pas de filtrer les lignes de la table ; toutes les lignes de la table sont partitionnées et copiées. Si les valeurs ne sont pas spécifiées, l’activité Copy les détecte automatiquement. Par exemple, si les valeurs de la colonne de partition « ID » sont comprises entre 1 et 100, et que vous définissez la limite inférieure à 20 et la limite supérieure à 80, avec la copie parallèle à 4, le service récupère des données en fonction de 4 partitions, (ID des plages <=20, [21, 50], [51, 80] et >=81, respectivement). |

| Chargement d’une grande quantité de données à l’aide d’une requête personnalisée, sans partitions physiques, et avec une colonne d’entiers ou de date/DateHeure pour le partitionnement des données. | Options de partition : Partition dynamique par spécification de plages de valeurs. Requête: SELECT * FROM <TableName> WHERE ?DfDynamicRangePartitionCondition AND <your_additional_where_clause>.Colonne de partition : Spécifiez la colonne utilisée pour partitionner les données. Limite supérieure de partition et limite inférieure de partition (facultatif) : Spécifiez si vous souhaitez déterminer le stride de la partition. Cela ne permet pas de filtrer les lignes de la table ; toutes les lignes du résultat de la requête sont partitionnées et copiées. Si la valeur n’est pas spécifiée, l’activité de copie la détecte automatiquement. Par exemple, si les valeurs de la colonne de partition « ID » sont comprises entre 1 et 100, et que vous définissez la limite inférieure à 20 et la limite supérieure à 80, avec la copie parallèle à 4, le service récupère des données en fonction de 4 partitions (ID des plages <=20, [21, 50], [51, 80] et >=81, respectivement). Voici d’autres exemples de requêtes pour différents scénarios : • Interroger l’ensemble de la table : SELECT * FROM <TableName> WHERE ?DfDynamicRangePartitionCondition• Interroger une table avec une sélection de colonnes et des filtres de la clause WHERE supplémentaires : SELECT <column_list> FROM <TableName> WHERE ?DfDynamicRangePartitionCondition AND <your_additional_where_clause>• Effectuer une requête avec des sous-requêtes : SELECT <column_list> FROM (<your_sub_query>) AS T WHERE ?DfDynamicRangePartitionCondition AND <your_additional_where_clause>• Effectuer une requête avec une partition dans une sous-requête : SELECT <column_list> FROM (SELECT <your_sub_query_column_list> FROM <TableName> WHERE ?DfDynamicRangePartitionCondition) AS T |

Meilleures pratiques pour charger des données avec l’option de partition :

- Choisissez une colonne distinctive comme colonne de partition (p. ex. : clé primaire ou clé unique) pour éviter l’asymétrie des données.

- Si la table possède une partition intégrée, utilisez l’option de partition Partitions physiques de la table pour obtenir de meilleures performances.

- Azure Synapse Analytics peut exécuter un maximum de 32 requêtes à un moment donné. La définition d’un degré de parallélisme de copie trop important peut entraîner un problème de limitation de Synapse.

Exemple de requête pour vérifier une partition physique

SELECT DISTINCT s.name AS SchemaName, t.name AS TableName, c.name AS ColumnName, CASE WHEN c.name IS NULL THEN 'no' ELSE 'yes' END AS HasPartition

FROM sys.tables AS t

LEFT JOIN sys.objects AS o ON t.object_id = o.object_id

LEFT JOIN sys.schemas AS s ON o.schema_id = s.schema_id

LEFT JOIN sys.indexes AS i ON t.object_id = i.object_id

LEFT JOIN sys.index_columns AS ic ON ic.partition_ordinal > 0 AND ic.index_id = i.index_id AND ic.object_id = t.object_id

LEFT JOIN sys.columns AS c ON c.object_id = ic.object_id AND c.column_id = ic.column_id

LEFT JOIN sys.types AS y ON c.system_type_id = y.system_type_id

WHERE s.name='[your schema]' AND t.name = '[your table name]'

Si la table possède une partition physique, vous voyez « HasPartition » avec la valeur « yes » (oui).

Résumé du tableau

Les tables suivantes contiennent plus d’informations sur l’activité de copie dans Azure. Synapse Analytics.

Source

| Nom | Description | Valeur | Obligatoire | Propriété de script JSON |

|---|---|---|---|---|

| Type de banque de données | Votre type de magasin de données. | Externe | Oui | / |

| Connection | Votre connexion au magasin de données source. | < votre connexion > | Oui | connection |

| Type de connexion | Votre type de connexion source. | Azure Synapse Analytics | Oui | / |

| Utiliser la requête | La façon de lire des données. | • Table • Requête • Procédure stockée |

Oui | • typeProperties (sous typeProperties ->source)- schéma - table • sqlReaderQuery • sqlReaderStoredProcedureName storedProcedureParameters - nom - valeur |

| Délai de requête | Le délai d’expiration pour l’exécution de la commande de requête ( par défaut est de 120 minutes). | intervalle de temps | Non | queryTimeout |

| Niveau d’isolation | Le comportement de verrouillage des transactions pour la source SQL. | • Aucun • Lecture validée • Lecture invalidée • Lecture renouvelable • Serializable • Instantané |

Non | isolationLevel : • ReadCommitted • ReadUncommitted • RepeatableRead • Serializable • Instantané |

| Option de partition | Les options de partitionnement des données utilisées pour charger des données à partir d’Azure SQL Database. | • Aucun • Partitions physiques de la table • Plage dynamique - Nom de la colonne de partition - Limite supérieure de partition - Limite inférieure de partition |

Non | partitionOption : • PhysicalPartitionsOfTable • DynamicRange partitionSettings : - partitionColumnName - partitionUpperBound - partitionLowerBound |

| Colonnes supplémentaires | Ajouter les colonnes de données supplémentaires pour stocker le chemin d’accès relatif ou la valeur statique des fichiers sources. L’expression est prise en charge pour ce dernier. | • Name • Valeur |

Non | additionalColumns : • nom • valeur |

Destination

| Nom | Description | Valeur | Obligatoire | Propriété de script JSON |

|---|---|---|---|---|

| Type de banque de données | Votre type de magasin de données. | Externe | Oui | / |

| Connection | Votre connexion au magasin de données de destination. | < votre connexion > | Oui | connection |

| Type de connexion | Votre type de connexion de destination. | Azure Synapse Analytics | Oui | / |

| Option de table | Votre option de table de données de destination. | • Utiliser l’existant • Auto créer la table |

Oui | • typeProperties (sous typeProperties ->sink)- schéma - table • tableOption : - autoCreate typeProperties (sous typeProperties ->sink)- schéma - table |

| Méthode de copie | La méthode utilisée pour copier des données. | • Commande Copy • PolyBase • Bulk insert • Upsert |

Non | / |

| Lors de la sélection de la commande Copy | Utilisez l'instruction COPY pour charger des données du Stockage Azure dans Azure Synapse Analytics ou un pool SQL. | / | Nombre Appliquer au moment de l’utilisation de l’instruction COPY. |

allowCopyCommand : true copyCommandSettings |

| Valeurs par défaut | Spécifiez les valeurs par défaut de chaque colonne cible dans Azure Synapse Analytics. Les valeurs par défaut de la propriété remplacent le jeu de contraintes DEFAULT défini dans l’entrepôt de données, et la colonne d’identité ne peut pas avoir de valeur par défaut. | < valeurs par défaut > | Non | defaultValues : - columnName - defaultValue |

| Options supplémentaires | Options supplémentaires qui seront passées à l’instruction COPY d’Azure Synapse Analytics directement dans la clause « With » dans l’instruction COPY. Citez la valeur en fonction des besoins pour l’aligner sur les spécifications de l’instruction COPY. | < options supplémentaires > | Non | additionalOptions : - <nom de la propriété> : <valeur> |

| Lors de la sélection de PolyBase | PolyBase est un mécanisme à débit élevé. Utilisez-le pour charger de grandes quantités de données dans Azure Synapse Analytics ou un pool SQL. | / | Nombre Appliquer lors de l’utilisation de PolyBase. |

allowPolyBase : true polyBaseSettings |

| Type de rejet | Le type de la valeur de rejet. | • Valeur • Pourcentage |

Non | rejectType : - valeur - pourcentage |

| Valeur de rejet | Le nombre ou le pourcentage de lignes pouvant être rejetées avant l’échec de la requête. | 0 (par défaut), 1, 2, etc. | Non | rejectValue |

| Exemple de valeur de rejet | Détermine le nombre de lignes à extraire avant que PolyBase recalcule le pourcentage de lignes rejetées. | 1, 2, etc. | Oui lorsque vous spécifiez Pourcentage comme votre type de rejet | rejectSampleValue |

| Utiliser le type par défaut | Spécifie comment gérer les valeurs manquantes dans les fichiers texte délimités lorsque PolyBase récupère les données à partir du fichier texte. Pour plus d’informations sur cette propriété, consultez la section Arguments dans CREATE EXTERNAL FILE FORMAT (Transact-SQL) | sélectionné (par défaut) ou désélectionné. | Non | useTypeDefault : true (valeur par défaut) ou false |

| Lors de la sélection de Bulk insert | Insérez des données en bloc dans la destination. | / | Non | writeBehavior : insérer |

| Verrou de table d’insertion en bloc | Utilisez cette option pour améliorer les performances de copie lors de l’opération d’insertion en bloc dans la table sans index, à partir de plusieurs clients. Pour plus d’informations, consultez BULK INSERT (Transact-SQL). | sélectionné ou non sélectionné (par défaut) | Non | sqlWriterUseTableLock : true ou false (par défaut) |

| Lors de la sélection d’Upsert | Spécifiez le groupe des paramètres pour le comportement d’écriture lorsque vous souhaitez faire un upsert de données vers votre destination. | / | Non | writeBehavior : upsert |

| Colonnes clés | Indique la colonne utilisée pour déterminer si une ligne de la source correspond à une ligne de la destination. | < nom de colonne> | Non | upsertSettings : - clés : < nom de colonne > - interimSchemaName |

| Verrou de table d’insertion en bloc | Utilisez cette option pour améliorer les performances de copie lors de l’opération d’insertion en bloc dans la table sans index, à partir de plusieurs clients. Pour plus d’informations, consultez BULK INSERT (Transact-SQL). | sélectionné ou non sélectionné (par défaut) | Non | sqlWriterUseTableLock : true ou false (par défaut) |

| Script de pré-copie | Un script pour l’activité de copie à exécuter avant d’écrire des données dans une table de destination à chaque exécution. Vous pouvez utiliser cette propriété pour nettoyer des données préchargées. | < script de pré-copie > (string) |

Non | preCopyScript |

| Délai d’expiration du lot d’écriture | Temps d’attente pour que l’opération d’insertion par lot soit terminée avant d’expirer. La valeur autorisée est timespan. La valeur par défaut est 00:30:00 (30 minutes). | intervalle de temps | Non | writeBatchTimeout |

| Taille de lot d’écriture | Nombre de lignes à insérer dans la table SQL par lot. Par défaut, le service détermine de façon dynamique la taille de lot appropriée selon la taille de ligne. | < nombre de lignes > (entier) |

Non | writeBatchSize |

| Connexions simultanées maximales | La limite supérieure de connexions simultanées établies au magasin de données pendant l’exécution de l’activité. Spécifiez une valeur uniquement lorsque vous souhaitez limiter les connexions simultanées. | < limite supérieure de connexions simultanées > (entier) |

Non | maxConcurrentConnections |

| Désactiver l’analytique des métriques de performances | Ce paramètre est utilisé pour collecter des métriques, telles que DTU, DWU, RU, etc., pour l’optimisation des performances de copie et les recommandations. Si ce comportement vous préoccupe, cochez cette case. | sélectionner ou désélectionner (par défaut) | Non | disableMetricsCollection : true ou false (par défaut) |