MLOps et GenAIOps pour les charges de travail IA sur Azure

Les opérations de charge de travail IA sont centrées sur la curation des données et la consommation de ces données. Les opérations garantissent l’efficacité dans l’obtention et la maintenance de la qualité, de la fiabilité, de la sécurité, de l’éthique et d’autres normes que vous hiérarchisent pour la charge de travail.

Les tâches de charge de travail peuvent être classées en trois domaines principaux : le développement d’applications, la gestion des données et la gestion des modèles IA. Chaque catégorie doit adopter des méthodologies opérationnelles éprouvées, comme DevOps, DataOps, MLOps et GenAIOps.

Les activités DevOps couvrent toute la gestion du cycle de vie du développement d’applications par le biais de pipelines et de supervision automatisés d’intégration continue et de déploiement continu (CI/CD). Toutefois, pour les charges de travail IA, le pipeline de données est l’un des composants principaux. DataOps, une spécialisation de DevOps, se concentre sur la gestion du cycle de vie des données en rationalisant les processus comme l’extraction de données, la transformation et le chargement (ETL/ELT). Les praticiens dataOps mesurent généralement les performances du flux de données et l’efficacité du nettoyage des données et surveillent le pipeline pour détecter les anomalies.

Les charges de travail IA sont intrinsèquement non déterministes. De nombreux modèles IA sont susceptibles de produire des réponses différentes pour la même enquête pendant l’inférence. Ces charges de travail ont besoin de processus qui peuvent gérer et s’adapter à l’impdictibilité des sorties IA. DataOps s’étend à MLOps, qui opérationnalise les flux de travail Machine Learning pour l’entraînement et le test des modèles. GenAIOps, un sous-ensemble spécialisé de MLOps, cible des solutions d’IA génératives. Il implique des tâches telles que la découverte de modèles et l’affinement de modèles préentraînés avec des données enrichies.

Les activités opérationnelles se chevauchent souvent et les différentes méthodologies s’appliquent à différents degrés. Par exemple, dans l’IA discriminative, DataOps joue un rôle majeur, tandis que les activités DevOps sont moins importantes. À l’inverse, dans l’IA générative, l’excellence opérationnelle repose davantage sur DevOps que Sur DataOps.

Quel que soit l’objectif global, la prestation des capacités avec des opérations efficaces tout au long du cycle de vie du développement. Les résultats attendus sont les suivants :

- Processus reproductibles avec des résultats cohérents.

- Précision soutenue des modèles au fil du temps.

- Gouvernance efficace qui réduit les risques.

- Processus de gestion des modifications pour l’adaptation à la dérive du modèle.

L’automatisation et la surveillance sont vos stratégies opérationnelles clés pour atteindre ces objectifs.

Vous devez également établir des processus standardisés pour les composants IA, pour les opérations de routine, non planifiées et d’urgence, et disposer de mécanismes de suivi appropriés en place. Sans ces processus, vous courez le risque de :

- Erreurs répétées et non-reproduction dans le traitement des données, l’hébergement de modèles, la gestion des données de base et d’autres tâches.

- Données obsolètes ou de faible qualité utilisées pour l’apprentissage et l’affinement du modèle.

- Affectant la confiance des utilisateurs finaux dans le système, dans le pire des cas, conduisant à des problèmes juridiques, de conformité ou de sécurité.

Vous devez implémenter des processus établis avec le bon ensemble d’outils. Les outils spécialisés sont disponibles pour la gestion des flux de travail IA/Machine Learning dans les environnements.

Cet article se concentre sur la stratégie de conception pour les opérations et fournit des recommandations sur les outils.

Recommandations

Voici le résumé des recommandations fournies dans cet article.

| Recommandation | Description |

|---|---|

| Concevoir un cycle de vie efficace des opérations de charge de travail. | En fonction des composants de votre charge de travail IA, différentes étapes opérationnelles s’appliquent à son cycle de vie. Il est important que vous compreniez les meilleures pratiques pertinentes pour votre scénario et les outils qui vous sont disponibles pour les implémenter. Prenez le temps de découvrir et d’implémenter les recommandations clés pour tous les composants de votre charge de travail. ▪ DataOps ▪ MLOps ▪ GenAIOps ▪ Monitoring |

| Automatisez tout. | L’automatisation garantit la répétabilité et l’efficacité dans le cycle de vie d’une charge de travail. Bien que les processus DevOps soient un contributeur clé à ce processus, vous devez effectuer des étapes supplémentaires pour générer, tester, valider et déployer efficacement vos modèles. ▪ Automatisation |

| Utilisez les pipelines de déploiement si possible. | Les pipelines de déploiement peuvent vous aider à fournir des déploiements d’infrastructure reproductibles ou à intégrer du code en continu. Ils sont également un excellent outil pour créer et/ou valider des modèles avant de les promouvoir en production. L’implémentation de pipelines de déploiement vous permet d’améliorer la fiabilité ainsi que l’expérience utilisateur globale de votre charge de travail. ▪ Pipelines de déploiement |

| Empêchez la dérive et la décomposition dans vos modèles. | Vous devez vous protéger contre la dégradation et la dérive du modèle tout en ayant un processus structuré qui vous permet d’accepter de nouvelles modifications de modèle de manière contrôlée. La suite des recommandations relatives à la maintenance des modèles vous permet de rester conforme, d’éviter les expériences utilisateur inattendues et de fournir un service plus à jour. ▪ Maintenance du modèle |

Cycle de vie des opérations de charge de travail

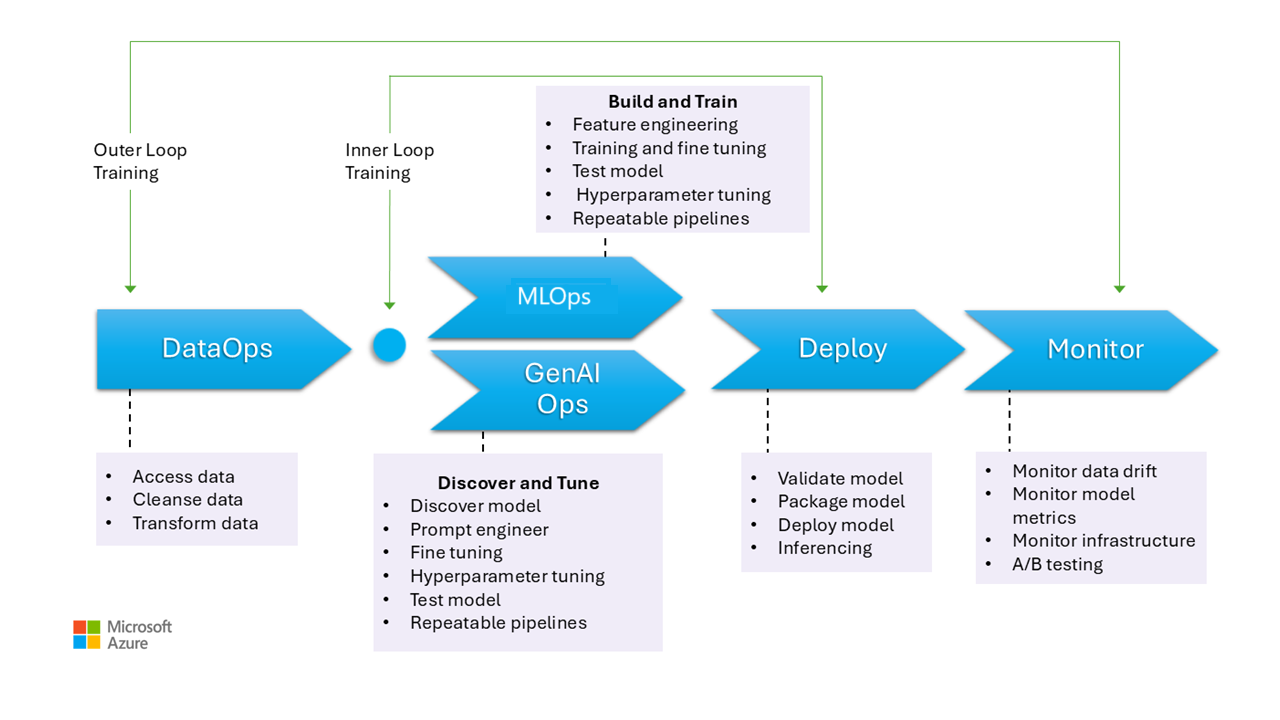

Cette image illustre les étapes opérationnelles des modèles IA, notamment la collecte de données, le nettoyage des données afin d’éliminer les incohérences ou les erreurs et de transformer les données dans un format analysable. Ces phases sont pertinentes pour former des modèles discriminatifs et baser les données dans les modèles génératifs. Toutefois, le cas d’usage spécifique des modèles génératifs d’entraînement n’est pas représenté dans cette image. Ce cas d’usage se situe en dehors de l’étendue de cet article.

Les phases de MLOps et GenAIOps sont similaires. La principale différence est que, dans le cas de GenAIOps, le focus passe de l’entraînement à la sélection du modèle approprié, de l’ingénierie rapide et de l’incorporation de connaissances spécifiques au domaine par le biais d’un réglage précis ou de l’implémentation de la génération augmentée de récupération (RAG).

Même les étapes de déploiement et de surveillance sont assez similaires.

Les sections suivantes décrivent les pratiques opérationnelles courantes. Ils couvrent chaque étape du cycle de vie, de la préproduction à la production.

DataOps

Les données sont agrégées à partir de différentes sources de données de production, puis prétraitées pour supprimer les erreurs et les incohérences et pour gérer les valeurs manquantes. Enfin, il est transformé et normalisé dans un format approprié pour l’entraînement ou l’enrichissement. Les aspects de la conception sont décrits dans les articles sur les données d’entraînement et les données de base.

Les processus d’opérations de données au cours de cette phase doivent être efficaces, car la gestion de gros volumes de données provenant de plusieurs sources et de pipelines de données complexes peut être difficile. Les approches que vous devez adopter pour vous assurer que cette phase produit des données de haute qualité. Surveillez cette étape pour suivre la progression vers la barre de qualité acceptable.

Vous devez également vous assurer que les données sont sécurisées, étant donné que les données proviennent de la production. Assurez-vous que les environnements inférieurs, tels que Dev/Test, sont aussi sécurisés que la production pour éviter tout problème de sécurité.

Remarque

Résolvez les données de mauvaise qualité en investissant dans un nettoyage approfondi des données pendant les phases initiales. Tirez parti des modèles d’analytique connus, tels que les médaillons, le maillage de données et les magasins de fonctionnalités, pour effectuer des tâches de traitement en amont. Si les phases en amont sont inefficaces, vous devez améliorer la qualité pendant les phases en aval, ce qui entraîne une augmentation des coûts de charge de travail, car la préparation des données se produit pendant chaque phase.

Pour plus d’informations sur les tâches de traitement des données, consultez les articles suivants :

Outils

Nous vous recommandons de normaliser les outils d’orchestration des données de votre charge de travail. Les outils doivent être en mesure de fournir un pipeline de données qui peut regrouper des activités et qui a une automatisation intégrée.

Un pipeline Azure Data Factory peut être un choix initial. Il peut se connecter et traiter efficacement de nombreuses sources de données. Vous pouvez également envisager Azure Synapse Analytics, qui combine le Big Data et l’entreposage de données et prend en charge les lacs de données, Apache Spark et Azure Synapse SQL. Il s’intègre également à Data Factory pour ETL.

Pour préparer des données d’apprentissage, les pipelines Azure Machine Learning fournissent des fonctionnalités spécialisées qui peuvent automatiser des tâches telles que la collecte et le traitement des données.

Les technologies open source comme Pandas (pour la préparation des données) et Scrapy sont des choix populaires.

MLOps

L’apprentissage du modèle est le processus de sélection des algorithmes appropriés et de leur fournir des données historiques et des observations prétraite pour permettre au modèle d’apprendre des modèles et d’effectuer des prédictions.

L’apprentissage du modèle (ingénierie des caractéristiques) et du réglage des hyperparamètres sont des processus itératifs, et ils sont coûteux. Pendant chaque itération, les scientifiques des données effectuent le suivi des résultats avec des combinaisons de données, de code et de paramètres. Utilisez des pipelines reproductibles pour suivre les expériences avec un effort manuel minimal jusqu’à ce que le niveau de précision approprié soit atteint.

Un autre défi opérationnel est l’approvisionnement et la mise à l’échelle de ressources de calcul spécialisées où des expériences sont menées. En outre, vous devez empaqueter et publier efficacement des modèles .

Teams peut commencer par le développement basé sur l’interface utilisateur pour réduire les défis et, à mesure qu’ils deviennent plus confiants, passent à une approche basée sur le code.

Outils

Nous vous recommandons d’utiliser des outils capables de suivre les expériences de Machine Learning en capturant des détails tels que les versions de code, les environnements, les paramètres, les exécutions et les résultats. MLflow est une infrastructure open source de ce type. Envisagez d’utiliser des espaces de travail Azure Machine Learning compatibles avec MLflow et fournir un flux de travail simplifié qui permet aux scientifiques des données de gérer la productivité et la reproductibilité dans leurs projets. Pour gérer le développement de code avec le suivi du contrôle de code source, intégrez le pipeline Machine Learning au contrôle de code source tel que GitHub ou utilisez des partages de fichiers.

Le calcul d’hébergement peut également influencer votre choix d’orchestrateur de flux de travail. Si votre application est hébergée sur Azure Kubernetes Service (AKS), envisagez d’utiliser Kubeflow.

Si vous envisagez Azure Machine Learning, nous vous recommandons de commencer par la perspective d’Azure Well-Architected Framework sur Machine Learning pour vous assurer que vous comprenez comment le produit peut vous aider à résoudre les problèmes de qualité de la charge de travail.

Une partie de l’avantage du processus est d’optimiser le temps personnel. Les scientifiques des données ont généralement besoin d’outils et sdk spécifiques pour effectuer efficacement des analyses exploratoires des données (EDA) et des expérimentations à partir de leurs stations de travail. Déterminez si les options prédéfinies dans Azure Machine Learning conviennent. Si ce n’est pas le cas, stockez la configuration de station de travail ou conservez les images de machine virtuelle approuvées pour ce travail. Un exemple d’image que vous pouvez utiliser comme point de départ est la machine virtuelle Science des données (DSVM).

Dans certains cas, l’utilisation de machines virtuelles peut être interdite par la stratégie. Recherchez des alternatives, comme l’ajout de Microsoft Dev Box et d’Azure Virtual Desktop. Vous pouvez également envisager d’utiliser Docker pour démarrer des machines qui contiennent des images prédéfinies.

Toutefois, à mesure que cette étape mûrit et que vous avez besoin d’expériences étendues, passez à des instances de calcul managées et préférez les options intégrées dans le cadre du flux de travail. Déterminez si vous pouvez utiliser des instances de calcul Azure Machine Learning pour l’entraînement et l’inférence à des fins de développement et de test. Les clusters de calcul peuvent gérer des jeux de données volumineux et des modèles complexes.

Azure Machine Learning fournit à la fois des solutions basées sur du code par le biais du Kit de développement logiciel (SDK) et des options de faible code telles que le Machine Learning automatisé et le concepteur visuel. Le Kit de développement logiciel (SDK) Python offre plusieurs façons d’entraîner des modèles, chacun avec des fonctionnalités distinctes. Machine Learning prend également en charge les technologies avancées d’optimisation et d’informatique distribuée comme ORTModule, DeepSpeed et LoRA d’ONNX Runtime Training pour accélérer le processus d’entraînement.

GenAIOps

Les activités clés de cette phase commencent par la découverte et l’évaluation des modèles existants pour identifier un modèle préentraîné pour le cas d’usage spécifique. C’est un processus itératif. Une fois que vous avez trouvé un modèle approprié, il peut tirer parti d’être affiné pour une base spécifique au domaine, ce qui implique également des étapes itératives et nécessite un certain niveau d’orchestration.

L’intégration et le déploiement de modèles nécessitent des outils et des pratiques spécialisés qui vont au-delà des fonctionnalités MLOps traditionnelles, notamment l’orchestration des modèles, les index vectoriels, les invites et les blocs de code.

Outils

Pour traiter les tâches de découverte, tirez parti des catalogues de modèles qui incluent des modèles de différents fournisseurs. Le catalogue de modèles dans le portail Azure AI Foundry vous permet d’évaluer à partir de collections organisées et de déployer efficacement des modèles.

Le flux d’invite Azure Machine Learning peut vous aider à développer du code d’orchestration, à activer le prototypage, l’expérimentation, l’itération et l’ingénierie d’invite. Ces flux peuvent être déployés sur des points de terminaison managés Azure Machine Learning. Déterminez si vous pouvez exécuter et déployer les flux avec votre technologie de pipeline CI/CD existante.

Déploiement

Au cours de cette phase, le modèle est déployé sur une plateforme d’hébergement et d’inférence ou sur la couche de service des charges de travail IA. Les API doivent être empaquetées en tant que conteneur évolutif. La plateforme conteneur peut être une plateforme de calcul managée ou d’hébergement personnalisée. Les pratiques opérationnelles doivent garantir un déploiement sécurisé et activer les restaurations.

Commencez par des solutions PaaS (Platform as a Service) et serverless comme Azure OpenAI Service pour simplifier l’adoption et la gestion. Envisagez d’utiliser l’API Serverless Azure Machine Learning pour agréger l’accès au point de terminaison. Les clusters de calcul managés sont une option viable pour les besoins avancés. L’auto-hébergement sur AKS est une autre option. Veillez à dimensionner correctement votre calcul et à maintenir une isolation appropriée à partir d’autres charges de travail. Vous pouvez également envisager des options telles que l’hébergement complet de votre modèle en tant qu’infrastructure as a service (IaaS). IaaS offre une flexibilité, mais peut ajouter une charge opérationnelle. Ces options sont décrites dans la plateforme d’application.

Cette étape présente la dernière chance d’intercepter les problèmes avant de déplacer le modèle en production. Les processus de test doivent inclure des étapes de validation pour vous assurer que le modèle est configuré pour fournir des prédictions comme prévu.

Vous devez intégrer le modèle dans l’environnement de production existant en suivant les processus d’exposition progressifs et en utilisant des déploiements côte à côte. Le modèle canary est un moyen courant de déployer de nouveaux modèles. Avec cette méthode, la base d’utilisateurs est progressivement augmentée. Le déploiement bleu-vert est une autre méthode.

Outils

Vous pouvez utiliser des pipelines Azure Machine Learning ou Azure Pipelines pour déployer vos modèles pour l’inférence. Machine Learning fournit plusieurs fonctionnalités pour les opérations simplifiées, notamment l’approvisionnement de nœuds, les mises à jour du système d’exploitation, la mise à l’échelle automatique, la surveillance et les réseaux virtuels isolés.

Machine Learning prend également en charge le déploiement bleu-vert, ce qui permet à un point de terminaison unique de contenir plusieurs déploiements.

Si vous utilisez d’autres plateformes d’hébergement, comme Azure Container Apps ou Azure App Service, vous êtes responsable des opérations, notamment l’approvisionnement et la mise à l’échelle. Utilisez Azure DevOps, des pipelines GitHub ou votre choix de technologie CI/CD dans ces cas.

Surveillance

La surveillance est une stratégie clé et est appliquée à toutes les étapes. Il s’agit d’un processus continu et sert d’entrée aux portes de qualité qui garantissent que les charges de travail d’IA sont rigoureusement testées pour maintenir la cohérence et la fiabilité tout au long du cycle de vie du développement. Les modèles doivent être surveillés à partir de perspectives opérationnelles et de science des données.

Nous vous recommandons vivement d’avoir un processus de surveillance de boucle interne DataOps qui mesure la proximité d’une barre de qualité d’acceptation et vérifie les anomalies.

Pour les modèles préentraînés, il est également important de surveiller la dérive et les performances des données, avec un focus principal sur la pertinence. Évaluez les entrées (invites) et les sorties (achèvements) pour vous assurer qu’elles sont pertinentes et précises. En outre, tenez compte des risques de sécurité, tels que les tentatives de manipulation du comportement du modèle par le biais d’invites malveillantes. Assurez-vous qu’il existe une con mode tente ration approfondie qui inspecte les données dans les deux sens et filtre le contenu inapproprié. Ces considérations sont décrites dans la zone de conception ResponsibleAI.

Après le déploiement, les opérations de surveillance sont nécessaires pour résoudre des problèmes tels que la dégradation du modèle. Les modèles peuvent devenir obsolètes en raison des modifications apportées aux données ou aux modifications externes qui peuvent entraîner la production de résultats non pertinents. En tant que mesure proactive, utilisez des processus automatisés pour la surveillance continue et évaluez et réentraînez pour maintenir la précision et la pertinence. En outre, vous devez surveiller les métriques d’infrastructure et de charge de travail, comme vous le feriez avec n’importe quelle autre charge de travail, pour garantir des performances et une fiabilité optimales. Pour plus d’informations, consultez Test de la désintégration du modèle.

Outils

Investissez dans des outils qui facilitent la collecte des métriques à partir de points de terminaison d’inférence, comme le collecteur de données Azure Machine Learning.

Vous avez également besoin de l’observabilité des performances du modèle, de la dérive des données et de la sécurité et de la qualité pour l’IA générative.

Pour plus d’informations, consultez les articles suivants :

Automation

Les charges de travail IA sont complexes, car le cycle de vie global implique de nombreux rôles, changements fréquents et étapes connexes. Les processus manuels peuvent être sujets à des erreurs et des incohérences. L’automatisation dans l’hébergement du modèle de traitement des données permet de garantir la répétabilité et l’efficacité. L’automatisation n’est pas toujours nécessaire, mais il s’agit d’un moyen efficace de gérer ces complexités. Voici quelques cas d’usage dans lesquels l’automatisation peut atténuer les risques :

Contrairement au déploiement de code traditionnel, les modèles et solutions non déterministes dans l’IA/Machine Learning nécessitent une expérimentation et une formation itératives. Lorsque plusieurs équipes collaborent, automatisation, comme moyen d’appliquer des processus standardisés, peuvent aider à maintenir la cohérence, la reproductibilité et une collaboration efficace entre les scientifiques des données, les ingénieurs et les équipes opérationnelles.

Le cycle de vie du modèle implique deux types principaux de formation :

La formation en ligne intègre souvent des données récentes dans le modèle, parfois quotidiennement, pour garantir que les décisions sont basées sur les dernières informations. Cette formation est intégrée à la charge de travail afin que le modèle soit mis à jour en permanence dans le cadre du processus normal.

L’entraînement hors connexion entraîne le modèle moins fréquemment, ce qui permet un intervalle plus long entre les mises à jour. Le processus d’entraînement est distinct de la charge de travail principale et s’effectue de manière asynchrone. Une fois le nouveau modèle prêt, il est ensuite intégré au système.

La fiabilité peut être compromise si les mises à jour sont peu fréquentes. Si une mise à jour est manquée, elle peut être reportée sans problèmes majeurs. Ce concept s’applique également aux données de base. Par exemple, si vous utilisez RAG, vous devez décider si vous devez utiliser des données récentes ou si des données légèrement plus anciennes sont suffisantes. Les deux scénarios impliquent l’équilibrage de la nécessité d’obtenir des informations à jour avec la pratique de la fréquence de mise à jour. Vous devez effectuer une formation en ligne via l’automatisation en raison de la fréquence et de la fiabilité requises. Pour une formation hors connexion, en raison de la fréquence requise, vous devez justifier l’automatisation en effectuant une analyse des coûts-avantages. En outre, vous pouvez effectuer une formation hors connexion à l’aide de ressources moins coûteuses, telles que du matériel hors connexion.

Les processus DevOps traditionnels sont généralement affectés par les changements structurels. Toutefois, dans l’IA et le Machine Learning, les modèles sont formés sur les données de production. La décomposition du modèle présente un risque important et peut entraîner une diminution des performances au fil du temps si elle n’est pas surveillée. La collecte et l’analyse automatisées des métriques de performances, des alertes et du réentraînement des modèles sont nécessaires pour maintenir l’efficacité du modèle. Utilisez l’automatisation d’une manière qui peut vous aider à détecter les modifications apportées aux données et aux dépendances de modèle pour comprendre clairement l’état actuel à tout moment.

Les modèles peuvent être formés avec deux approches distinctes.

- Les modèles sont entraînés dans l’environnement de développement avec des données de production complètes et seul l’artefact est promu par le biais d’environnements. Cette approche peut réduire les coûts de calcul, mais nécessite une sécurité plus étroite pour gérer les données de production dans les environnements inférieurs et peut ne pas être possible dans toutes les organisations.

- Le modèle est entraîné dans chaque environnement. La promotion du code peut aider à la stabilité, car le code d’entraînement est examiné et testé dans les environnements inférieurs, mais augmente le coût du calcul.

Les deux approches présentent des avantages et des inconvénients. Le choix de la bonne approche dépend des priorités de votre organisation et des pratiques SDLC (Software Development Life Cycle) de votre organisation. Quelle que soit la méthode, les tests et l’évaluation approfondis du modèle avant le déploiement de production sont essentiels

Votre code d’automatisation doit incorporer la traçabilité des données pour prendre en charge l’audit en fournissant un enregistrement clair des étapes de traitement des données. Ce dossier vous aide à gérer les attentes et vous permet de montrer comment les décisions ont été prises afin de pouvoir répondre à toutes les préoccupations relatives aux résultats.

Pipelines de déploiement

Dans les charges de travail IA/Machine Learning, le développement de modèles implique la création, la validation et la promotion de modèles sur des plateformes d’hébergement de modèles . Il est important d’avoir des pipelines de déploiement qui simplifient les flux de travail complexes liés au traitement des données, à l’ingénierie des fonctionnalités, à l’entraînement ou à l’augmentation des modèles et au déploiement en production. Étant donné la nature non déterministe de l’IA, ce qui rend les processus opaques, vous devez incorporer des tests qualitatifs dans les pipelines de mise en production et les systèmes de surveillance.

Bien que MLOps et GenAIOps nécessitent des activités IA distinctes et des technologies principales peuvent différer, les concepts sous-jacents restent similaires à ceux de DevOps. Nous vous recommandons d’appliquer les meilleures pratiques de vos processus DevOps existants. Intégrez des activités IA dans les pipelines existants de votre charge de travail.

En règle générale, les charges de travail IA impliquent des déploiements de code traditionnels. Vous pouvez choisir de gérer le déploiement de modèles en même temps que le code ou séparément dans son propre cycle de vie. L’ancienne approche est préférable. Préparez-vous à empaqueter des modèles et des points de terminaison d’inférence avec un déploiement de charge de travail pour que les opérations d’INTELLIGENCE artificielle soient principalement axées sur la préparation des données, l’apprentissage/réglage précis, la gestion des données de base et la surveillance.

Réévaluez la façon dont les ressources suivantes peuvent être adaptées pour couvrir l’ensemble du cycle de vie MLOps et GenAIOps, de la préproduction à la production :

- Outils IaC (Infrastructure-as-code)

- Pipelines CI/CD

- Pile d’observabilité pour le suivi et l’identification des problèmes

Outils

Vous pouvez étendre des workflows Azure Pipelines et GitHub Actions, couramment utilisés pour CI/CD, aux modèles Machine Learning. Ils aident à déployer l’infrastructure Machine Learning, les composants de charge de travail personnalisés, le code d’orchestration et les modèles. Combinez des pipelines Azure Machine Learning avec des pipelines Azure DevOps ou GitHub. Pour plus d’informations, consultez Utiliser Azure Pipelines avec Azure Machine Learning.

Deux facteurs principaux influencent votre choix de la bonne combinaison d’outils : le cas d’usage et les fonctionnalités. Par exemple, les pipelines Azure Machine Learning sont parfaits pour l’orchestration effectuée par les scientifiques des données. Il dispose d’un ensemble de fonctionnalités riche qui prend en charge la réutilisation, la mise en cache et bien plus encore. Pour connaître les choix d’outils, consultez Quelle technologie de pipeline Azure dois-je utiliser ?.

Maintenance du modèle

Le paysage IA/ML est concurrentiel avec l’innovation continue. De nouveaux modèles émergent fréquemment, de nouveaux cas d’usage sont découverts et de nouvelles sources de données deviennent disponibles. Par conséquent, la désintégration du modèle est un défi courant.

Pour éviter la dégradation ou la dérive des performances du modèle au fil du temps, vous devez implémenter des processus automatisés pour la surveillance, l’évaluation et la réentraînation continues. Par exemple :

Conservez un catalogue de modèles. Automatisez le processus de découverte de nouveaux modèles et de mise à jour du catalogue.

Adaptez-vous aux nouveaux cas d’usage. À mesure que de nouveaux cas d’usage sont ajoutés aux exigences de charge de travail, attendez les requêtes et ajustez votre logique de traitement des données en conséquence.

Incorporer de nouvelles sources de données. Si de nouvelles sources de données peuvent potentiellement améliorer la puissance prédictive ou la pertinence de votre modèle, mettez à jour votre pipeline d’ingestion de données pour vous connecter à ces sources et extraire des données de ces sources.

Évaluez la conformité aux exigences réglementaires. Lorsque vous vous adaptez aux nouvelles fonctionnalités, assurez-vous que les modifications restent valides dans les contraintes des normes de conformité organisationnelles ou externes.

Implémentez un processus formel pour le suivi de l’amélioration continue et incorporez l’auto-amélioration en tant que sous-processus au sein de ce cycle.

Évolution continue

Examinez et améliorez régulièrement les opérations et encouragez l’innovation.

Le modèle de maturité MLOps passe des processus manuels à l’automatisation complète. Commencez par les builds et la supervision manuelles et incorporez des builds d’applications automatisées, des environnements d’entraînement et un déploiement en phases, comme justifié par des métriques complètes. Pour plus d’informations, consultez le modèle de maturité MLOps.

Les niveaux de maturité GenAIOps passent des modèles de base au déploiement structuré, progressivement à l’aide de techniques d’optimisation automatisée. Pour plus d’informations, consultez Avancez votre niveau de maturité pour GenAIOps.