Catalogue et collections de modèles dans le portail Azure AI Foundry

Important

Les éléments marqués (préversion) dans cet article sont actuellement en préversion publique. Cette préversion est fournie sans contrat de niveau de service, nous la déconseillons dans des charges de travail de production. Certaines fonctionnalités peuvent être limitées ou non prises en charge. Pour plus d’informations, consultez Conditions d’Utilisation Supplémentaires relatives aux Évaluations Microsoft Azure.

Le catalogue de modèles du portail Azure AI Foundry est le hub qui permet de découvrir et d’utiliser un large éventail de modèles pour créer des applications d’IA générative. Le catalogue de modèles comprend des centaines de modèles provenant de fournisseurs de modèles comme Azure OpenAI Service, Mistral, Meta, Cohere, NVIDIA et Hugging Face, y compris des modèles entraînés par Microsoft. Les modèles provenant de fournisseurs autres que Microsoft ne sont pas des produits Microsoft, tels que définis dans les conditions générales des produits Microsoft, et sont soumis aux conditions fournies avec les modèles.

Collections de modèles

Le catalogue de modèles organise les modèles en différentes collections :

Organisés par Azure AI : modèles propriétaires et open weight non-Microsoft les plus populaires, empaquetés et optimisés pour fonctionner de manière fluide sur la plateforme Azure AI. L’utilisation de ces modèles est soumise aux termes du contrat de licence des fournisseurs de modèles. Lorsque vous déployez ces modèles dans le portail Azure AI Foundry, leur disponibilité est soumise au contrat de niveau de service (SLA) Azure applicable, et Microsoft prend en charge les problèmes de déploiement.

Les modèles de partenaires tels que Meta, NVIDIA et Mistral AI sont des exemples de modèles disponibles dans cette collection sur le catalogue. Vous pouvez identifier ces modèles en recherchant une coche verte sur les vignettes de modèle dans le catalogue. Vous pouvez également filtrer par collection, ici la collection Organisés par Azure AI.

Modèles Azure OpenAI exclusivement disponibles sur Azure : modèles Azure OpenAI phares de la collection, disponibles via une intégration à Azure OpenAI Service. Microsoft prend en charge ces modèles et leur utilisation conformément aux conditions du produit et au contrat de niveau de service (SLA) pour Azure OpenAI Service.

Modèles ouverts à partir du hub Hugging Face : des centaines de modèles du hub Hugging Face sont accessibles pour l’inférence en temps réel avec le calcul managé. Hugging Face crée et gère les modèles listés dans cette collection. Pour obtenir de l’aide, utilisez le forum Hugging Face ou le support Hugging Face. Apprenez-en davantage dans Déployer des modèles ouverts avec Azure AI Foundry.

Vous pouvez envoyer une demande d’ajout de modèle au catalogue de modèles en remplissant ce formulaire.

Vue d’ensemble des fonctionnalités du catalogue de modèles

Vous pouvez rechercher et découvrir les modèles qui répondent à vos besoins via keyword search et filters. Le catalogue de modèles offre également les métriques de benchmark des performances du modèle pour les modèles sélectionnés. Vous pouvez accéder au benchmark en cliquant sur Compare Models ou à partir de l’onglet Benchmark de carte de modèle.

Sur la carte de modèle, vous trouverez :

- En bref : vous trouverez des informations clés sur le modèle en un coup d’œil.

- Détails : cette page contient les informations détaillées sur le modèle, notamment la description, les informations de version, le type de données pris en charge, etc.

- Benchmarks : vous trouverez des métriques de benchmark de performances pour les modèles sélectionnés.

- Déploiements existants : si vous avez déjà déployé le modèle, vous pouvez le trouver sous l’onglet Déploiements existants.

- Exemples de code : vous trouverez les exemples de code de base pour démarrer le développement d’applications d’IA.

- Licence : vous trouverez des informations légales relatives aux licences de modèles.

- Artefacts : cet onglet s’affiche uniquement pour les modèles ouverts. Vous pouvez voir les ressources du modèle et les télécharger via l’interface utilisateur.

Déploiement de modèle : Azure OpenAI

Pour plus d’informations sur les modèles Azure OpenAI, consultez Qu’est-ce qu’Azure OpenAI Service ?.

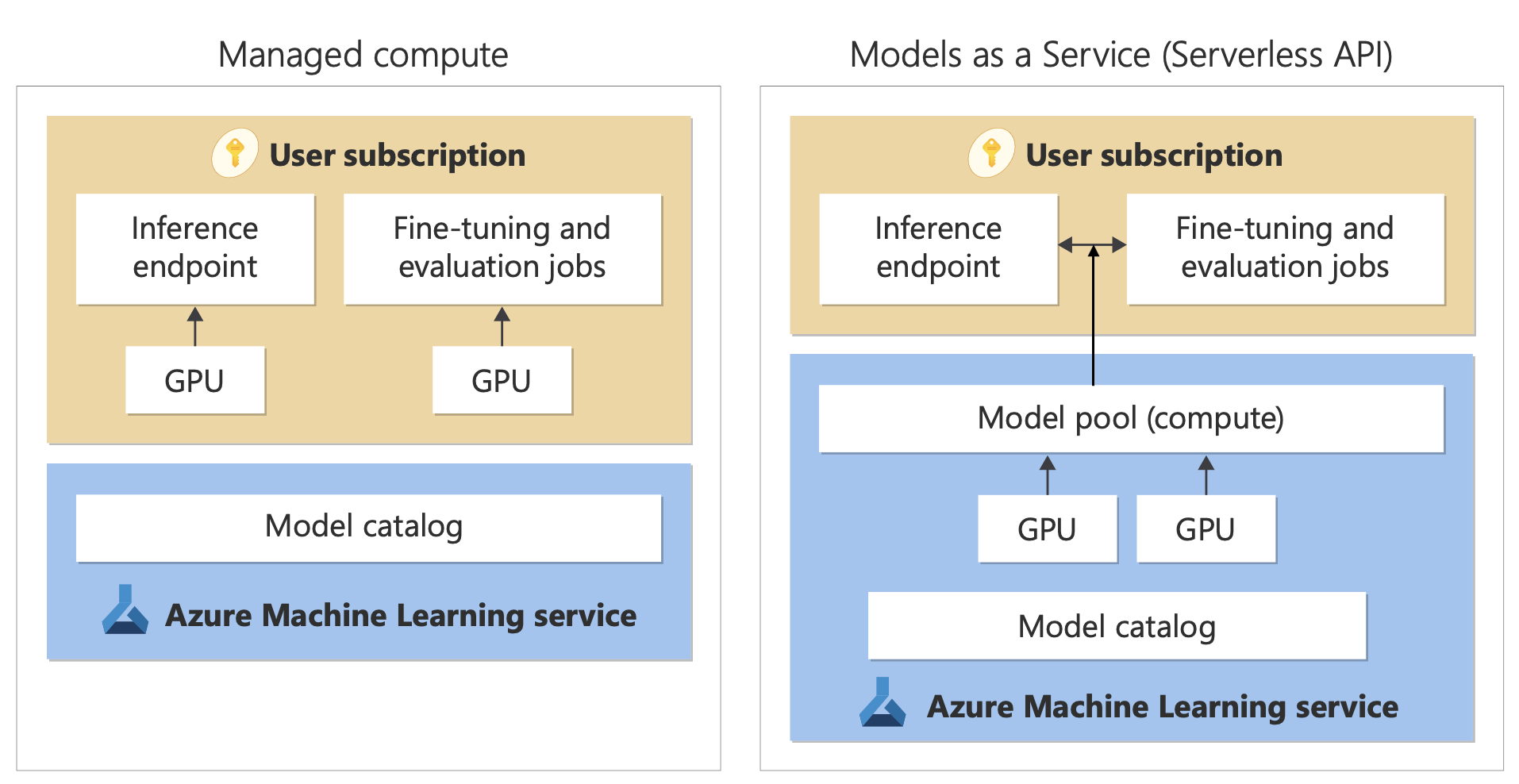

Déploiement des modèles : calcul managé et API serverless

Outre les modèles Azure OpenAI Service, le catalogue de modèles offre deux façons distinctes de déployer des modèles en vue de les utiliser : le calcul managé et les API serverless.

Les options et fonctionnalités de déploiement disponibles pour chaque modèle varient, comme vous pouvez le voir dans les tableaux suivants. Découvrez-en davantage sur le traitement des données avec les options de déploiement.

Fonctionnalités des options de déploiement de modèle

| Fonctionnalités | Capacité de calcul managée | API serverless (paiement par jeton) |

|---|---|---|

| Expérience de déploiement et facturation | Les pondérations de modèle sont déployées sur des machines virtuelles dédiées avec un calcul managé. Un calcul managé, qui peut avoir un ou plusieurs déploiements, met à disposition une API REST pour l’inférence. Vous êtes facturé pour les Heures cœur de machine virtuelle utilisées par les déploiements. | L’accès aux modèles se fait via un déploiement qui approvisionne une API pour accéder au modèle. L’API fournit l’accès au modèle que Microsoft héberge et gère pour l’inférence. Vous êtes facturé pour les entrées et sorties vers les API, généralement en jetons. Les informations de tarification sont fournies avant le déploiement. |

| Authentification des API | Clés et authentification Microsoft Entra. | Clés uniquement. |

| Sécurité du contenu | Utilisez les API du service Azure AI Sécurité du Contenu. | Les filtres Azure AI Sécurité du Contenu sont intégrés aux API d’inférence. Les filtres Azure AI Sécurité du Contenu sont facturés séparément. |

| Isolement réseau | Configurer des réseaux managés pour les hubs Azure AI Foundry. | Le calcul managé suit le paramètre d’indicateur d’accès au réseau public (PNA) de votre hub. Pour plus d’informations, consultez la section Isolement réseau pour les modèles déployés via des API serverless plus loin dans cet article. |

Modèles disponibles pour les options de déploiement prises en charge

La liste suivante contient des modèles d’API serverless. Pour les modèles Azure OpenAI, consultez Modèles d’Azure OpenAI Service.

| Modèle | Capacité de calcul managée | API serverless (paiement par jeton) |

|---|---|---|

| Modèles de la famille AI21 | Non disponible | Jamba-1.5-Mini Jamba-1.5-Large |

| Modèles de la famille Cohere | Non disponible | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual Cohere-rerank-v3-english Cohere-rerank-v3-multilingual |

| Gretel | Non disponible | Gretel-Navigator |

| Modèles de famille d’IA de santé | MedImageParse MedImageInsight CxrReportGen Virchow Virchow2 Prism BiomedCLIP-PubMedBERT microsoft-llava-med-v1.5 m42-health-llama3-med4 biomistral-biomistral-7b microsoft-biogpt-large-pub microsoft-biomednlp-pub stanford-crfm-biomedlm medicalai-clinicalbert microsoft-biogpt microsoft-biogpt-large microsoft-biomednlp-pub |

Non disponible |

| JAIS | Non disponible | jais-30b-chat |

| Modèles de la famille Meta Llama | Llama-3.3-70B-Instruct Llama-3.2-3B-Instruct Llama-3.2-1B-Instruct Llama-3.2-1B Llama-3.2-90B-Vision-Instruct Llama-3.2-11B-Vision-Instruct Llama-3.1-8B-Instruct Llama-3.1-8B Llama-3.1-70B-Instruct Llama-3.1-70B Llama-3-8B-Instruct Llama-3-70B Llama-3-8B Llama-Guard-3-1B Llama-Guard-3-8B Llama-Guard-3-11B-Vision Llama-2-7b Llama-2-70b Llama-2-7b-chat Llama-2-13b-chat CodeLlama-7b-hf CodeLlama-7b-Instruct-hf CodeLlama-34b-hf CodeLlama-34b-Python-hf CodeLlama-34b-Instruct-hf CodeLlama-13b-Instruct-hf CodeLlama-13b-Python-hf Prompt-Guard-86M CodeLlama-70b-hf |

Llama-3.3-70B-Instruct Llama-3.2-90B-Vision-Instruct Llama-3.2-11B-Vision-Instruct Llama-3.1-8B-Instruct Llama-3.1-70B-Instruct Llama-3.1-405B-Instruct Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-70b Llama-2-70b-chat Llama-2-13b Llama-2-13b-chat |

| Modèles de la famille Microsoft Phi | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct Phi-4 |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct Phi-4 |

| Modèles de la famille Mistral | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Ministral-3B Mistral-NeMo |

| Nixtla | Non disponible | TimeGEN-1 |

Cycle de vie des modèles : Dépréciation et retrait

Les modèles IA évoluent rapidement et quand une nouvelle version ou un nouveau modèle avec des fonctionnalités mises à jour dans la même famille de modèles deviennent disponibles, les modèles plus anciens peuvent être retirés du catalogue de modèles AI Foundry. Pour bénéficier d’une transition fluide vers une version de modèle plus récente, certains modèles offrent aux utilisateurs la possibilité d’activer les mises à jour automatiques. Pour en savoir plus sur le cycle de vie des différents modèles, les dates de retrait de modèle à venir et les suggestions de modèle et de version de remplacement, consultez :

- Dépréciations et mises hors service des modèles Azure OpenAI Service

- Dépréciations et mises hors service des modèles d’API serverless

Capacité de calcul managée

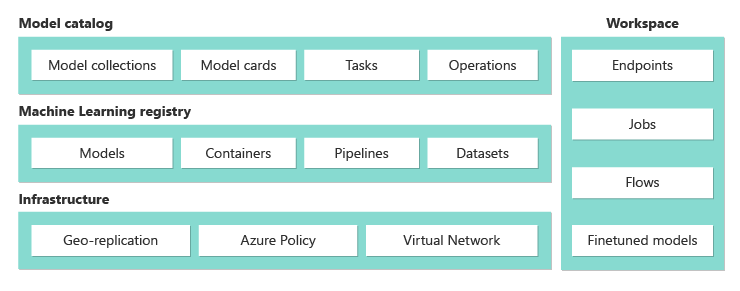

La capacité à déployer des modèles en tant que calcul managé s’appuie sur les fonctionnalités de plateforme d’Azure Machine Learning pour permettre une intégration fluide de la vaste collection de modèles dans le catalogue de modèles tout au long du cycle de vie des opérations des grands modèles de langage (LLM).

Disponibilité des modèles pour le déploiement en tant que calcul managé

Les modèles sont mis à disposition via les registres Azure Machine Learning. Ces registres offrent une approche axée sur le Machine Learning pour l’hébergement et la distribution des ressources Azure Machine Learning. Ces ressources incluent des pondérations de modèle, des runtimes de conteneur pour l’exécution des modèles, des pipelines pour l’évaluation et l’ajustement des modèles, ainsi que des jeux de données pour les benchmarks et les exemples.

Ces registres s’appuient sur une infrastructure hautement évolutive et prête pour l’entreprise qui :

Fournit des artefacts de modèle d’accès à faible latence à toutes les régions Azure avec la géoréplication intégrée.

Prend en charge les exigences de sécurité d’entreprise, notamment la limitation de l’accès aux modèles avec Azure Policy et la sécurisation du déploiement à l’aide de réseaux virtuels managés.

Déploiement de modèles pour l’inférence avec le calcul managé

Les modèles disponibles pour le déploiement vers le calcul managé peuvent être déployés sur un calcul managé Azure Machine Learning pour l’inférence en temps réel. Pour un déploiement sur le calcul managé, vous devez avoir un quota de machines virtuelles dans votre abonnement Azure pour les produits spécifiques dont vous avez besoin pour exécuter le modèle de manière optimale. Certains modèles vous permettent d’effectuer un déploiement sur un quota temporairement partagé pour les tests de modèle.

Découvrez-en davantage sur le déploiement de modèles :

Création d’applications d’IA générative avec le calcul managé

La fonctionnalité flux d’invite dans Azure Machine Learning offre une expérience idéale pour le prototypage. Vous pouvez utiliser des modèles déployés avec le calcul managé dans le flux d’invite avec l’outil Open Model LLM. Vous pouvez également utiliser l’API REST exposée par le calcul managé dans les outils LLM populaires tels que LangChain avec l’extension Azure Machine Learning.

Sécurité du contenu pour les modèles déployés en tant que calcul managé

Le service Azure AI Sécurité du Contenu est disponible pour une utilisation avec des calculs managés pour détecter différentes catégories de contenu dangereux, notamment le contenu sexuel, violent, haineux et d’automutilation. Vous pouvez également utiliser le service pour détecter des menaces avancées telles que la détection des risques de jailbreak et la détection de texte matériel protégé.

Vous pouvez vous référer à ce notebook pour une intégration de référence à Azure AI Sécurité du Contenu pour Llama 2. Vous pouvez également utiliser l’outil Sécurité du Contenu (texte) dans le flux d’invite pour passer des réponses du modèle à Azure AI Sécurité du Contenu à des fins de filtrage. Vous êtes facturé séparément pour cette utilisation, comme décrit dans la tarification d’Azure AI Sécurité du Contenu.

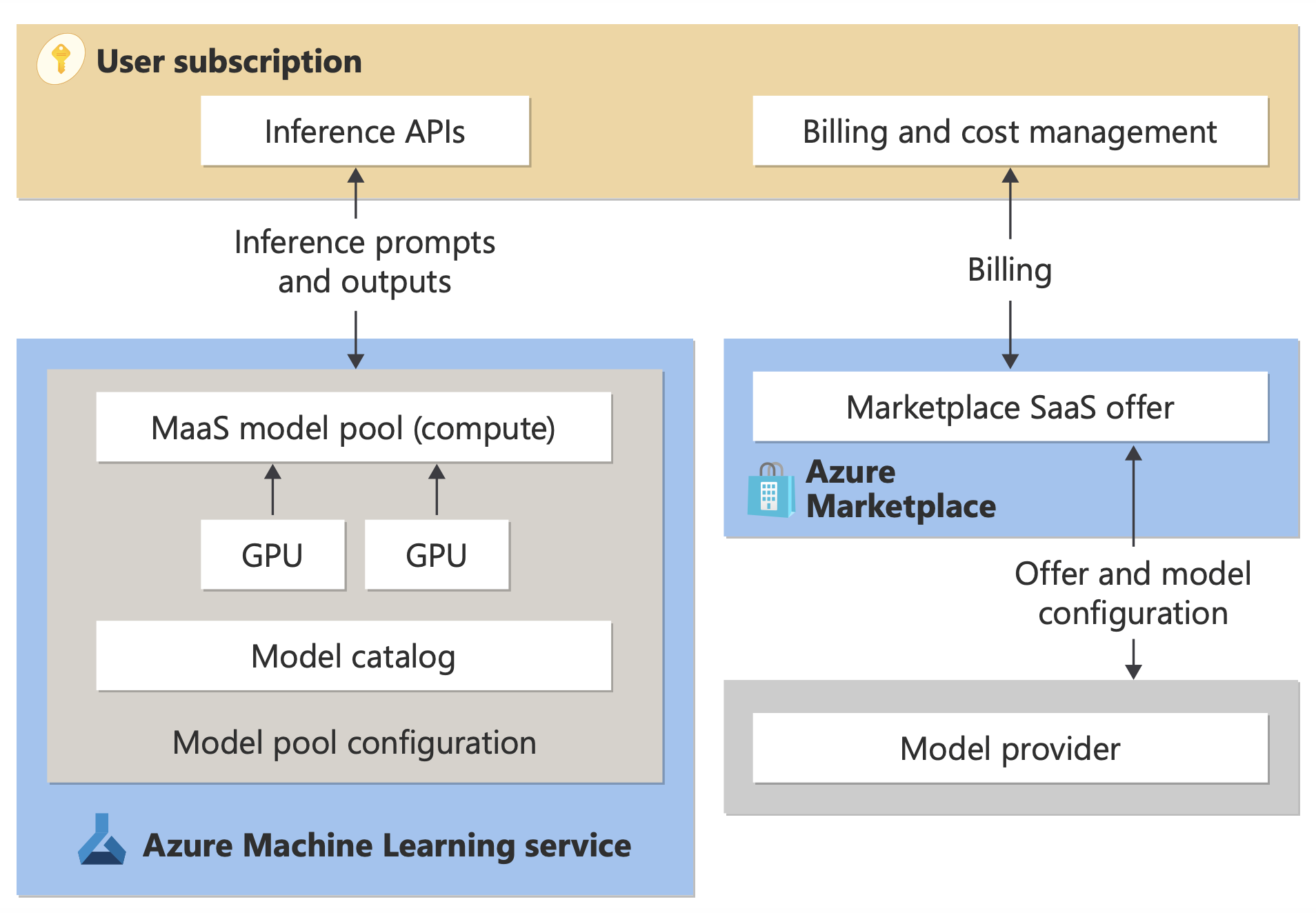

Facturation de l’API serverless (paiement par jeton)

Vous pouvez déployer certains modèles dans le catalogue de modèles à l’aide de la facturation au paiement par jeton. Cette méthode de déploiement, également appelée API serverless, permet de consommer les modèles en tant qu’API sans les héberger sur votre abonnement. Les modèles sont hébergés dans une infrastructure managée par Microsoft qui permet un accès basé sur l’API au modèle du fournisseur de modèles. L’accès basé sur l’API peut réduire drastiquement le coût d’accès à un modèle et simplifie l’expérience d’approvisionnement.

Les modèles disponibles pour le déploiement en tant qu’API serverless dans le cadre d’une facturation avec paiement à l’utilisation sont proposés par le fournisseur de modèles, mais ils sont hébergés dans une infrastructure Azure managée par Microsoft et sont accessibles via l’API. Les fournisseurs de modèles définissent les termes du contrat de licence et définissent le prix d’utilisation de leurs modèles. Azure Machine Learning service :

- Gère l’infrastructure d’hébergement.

- Met à disposition les API d’inférence.

- Agit en tant que processeur de données pour les prompts envoyés et le contenu généré en sortie par les modèles déployés via MaaS.

Découvrez-en davantage sur le traitement de données pour MaaS dans l’article sur la confidentialité des données.

Billing

L’expérience de découverte, d’abonnement et de consommation pour les modèles déployés via MaaS se trouve dans le portail Azure AI Foundry et Azure Machine Learning studio. Les utilisateurs acceptent les termes du contrat de licence régissant l’utilisation des modèles. Les informations de tarification pour la consommation sont fournies pendant le déploiement.

Les modèles provenant de fournisseurs non-Microsoft sont facturés via la Place de marché Azure, conformément aux conditions d’utilisation de la place de marché commerciale Microsoft.

Les modèles de Microsoft sont facturés via des compteurs Azure en tant que services de consommation internes. Comme décrit dans les conditions générales du produit, vous achetez des services de consommation internes à l’aide de compteurs Azure, mais ils ne sont pas soumis aux conditions générales des services Azure. L’utilisation de ces modèles est soumise aux termes du contrat de licence fourni.

Réglage des modèles

Certains modèles prennent également en charge le réglage précis. Pour ces modèles, vous pouvez tirer parti du calcul managé (préversion) ou du réglage précis de l’API serverless, afin d’adapter les modèles à l’aide de données que vous fournissez. Pour obtenir plus d’informations, consultez la vue d’ensemble de l’ajustement.

RAG avec des modèles déployés en tant qu’API serverless

Dans le portail Azure AI Foundry, vous pouvez utiliser des index vectoriels et la génération augmentée de récupération (RAG). Vous pouvez utiliser des modèles qui peuvent être déployés via des API serverless pour générer des incorporations et des inférences basées sur des données personnalisées. Ces incorporations et inférences peuvent ensuite générer des réponses spécifiques à votre cas d’utilisation. Pour plus d’informations, consultez Créer et consommer des index vectoriels dans le portail Azure AI Foundry.

Disponibilité régionale des offres et des modèles

La facturation avec paiement par jeton est disponible uniquement pour les utilisateurs dont l’abonnement Azure appartient à un compte de facturation dans un pays/une région où le fournisseur de modèles a rendu l’offre disponible. Si l’offre est disponible dans la région concernée, les utilisateurs doivent disposer d’une ressource de projet dans la région Azure où le modèle est disponible pour le déploiement ou l’ajustement, le cas échéant. Pour obtenir des informations détaillées, consultez Disponibilité des régions pour les modèles dans les points de terminaison d’API serverless | Azure AI Foundry.

Sécurité du contenu pour les modèles déployés via des API serverless

Pour les modèles de langage déployés via les API serverless, Azure AI implémente une configuration par défaut de filtres de modération de texte Azure AI Sécurité du Contenu qui détectent les contenus nuisibles comme la haine, l’automutilation, et le contenu à caractère sexuel ou violent. Pour plus d’informations sur le filtrage de contenu (préversion), consultez Catégories préjudiciables dans Azure AI Sécurité du Contenu.

Conseil

Le filtrage de contenu (préversion) n’est pas disponible pour certains types de modèles déployés via des API serverless. Ces types de modèles incluent des modèles d’incorporation et des modèles de série chronologique.

Le filtrage de contenu (préversion) se produit de façon synchrone quand le service traite des prompts pour générer du contenu. Vous pouvez être facturé séparément conformément à la tarification d’Azure AI Sécurité du Contenu pour cette utilisation. Vous pouvez désactiver le filtrage de contenu (préversion) pour des points de terminaison serverless individuels :

- Au moment où vous déployez un modèle de langage pour la première fois

- Ultérieurement, en sélectionnant le bouton bascule de filtrage du contenu dans la page des détails du déploiement

Supposons que vous décidez d’utiliser une API autre que l’API d’inférence de modèle Azure AI pour travailler avec un modèle déployé via une API serverless. Dans ce cas, le filtrage de contenu (préversion) n’est pas activé, sauf si vous l’implémentez séparément à l’aide d’Azure AI Sécurité du Contenu.

Pour bien démarrer avec Azure AI Sécurité du Contenu, consultez Démarrage rapide : Analyser du contenu texte. Si vous n’utilisez pas le filtrage de contenu (préversion) lors de l’utilisation de modèles déployés via des API serverless, vous risquez d’exposer davantage les utilisateurs à du contenu dangereux.

Isolement réseau pour les modèles déployés via des API serverless

Les points de terminaison des modèles déployés en tant qu’API serverless suivent la valeur de l’indicateur d’accès au réseau public du hub Azure AI Foundry qui contient le projet où se trouve le déploiement. Pour sécuriser votre point d'extrémité API serverless, désactivez l'indicateur d'accès au réseau public sur votre hub Azure AI Foundry. Vous pouvez sécuriser la communication entrante d’un client vers votre point de terminaison à l’aide d’un point de terminaison privé pour le hub.

Pour définir l’indicateur d’accès au réseau public pour le hub Azure AI Foundry :

- Accédez au portail Azure.

- Recherchez le groupe de ressources auquel le hub appartient, puis sélectionnez votre hub Azure AI Foundry dans les ressources listées pour ce groupe de ressources.

- Dans la page de présentation du hub, dans le volet de gauche, accédez à Paramètres>Mise en réseau.

- Sous l’onglet Accès public, vous pouvez configurer les paramètres de l’indicateur d’accès au réseau public.

- Enregistrez les changements apportés. Vos modifications peuvent prendre jusqu’à cinq minutes pour se propager.

Limites

Si vous avez un hub Azure AI Foundry avec un point de terminaison privé créé avant le 11 juillet 2024, les points de terminaison API serverless ajoutés aux projets dans ce hub ne suivront pas la configuration de mise en réseau du hub. Au lieu de cela, vous devez créer un point de terminaison privé pour le hub et créer de nouveaux déploiements d’API serverless dans le projet afin que les nouveaux déploiements puissent suivre la configuration de mise en réseau du hub.

Si vous avez un hub Azure AI Foundry avec des déploiements MaaS créés avant le 11 juillet 2024 et que vous activez un point de terminaison privé sur ce hub, les déploiements serverless des API existants ne suivront pas la configuration de mise en réseau du hub. Pour que les déploiements d’API serverless dans le hub suivent la configuration de mise en réseau du hub, vous devez recréer les déploiements.

Actuellement, la prise en charge d’Azure OpenAI sur vos données n’est pas disponible pour les déploiements serverless des APIs dans des hubs privés, car l’indicateur d’accès au réseau public est désactivé sur les hubs privés.

Toute modification apportée à la configuration réseau (par exemple, l’activation ou la désactivation de l’indicateur d’accès au réseau public) peut prendre jusqu’à cinq minutes pour se propager.