Informes de facturación y uso para Apache Spark en Microsoft Fabric

Se aplica a:✅ Ingeniería de datos y ciencia de datos en Microsoft Fabric

En este artículo se explica el uso de proceso y los informes de Apache Spark que impulsan las cargas de trabajo de ingeniería de datos y ciencia de Fabric en Microsoft Fabric. El uso del proceso incluye operaciones de almacenes de lago, como la vista previa de tablas, la carga en delta, las ejecuciones de cuadernos desde la interfaz, las ejecuciones programadas, las ejecuciones desencadenadas por los pasos del cuaderno en las canalizaciones y las ejecuciones de definición de trabajos de Apache Spark.

Al igual que otras experiencias en Microsoft Fabric, la ingeniería de datos también usa la capacidad asociada a un área de trabajo para ejecutar este trabajo y los cargos de capacidad generales aparecen en Azure Portal en la suscripción de Microsoft Cost Management. Para comprender la facturación de Fabric, visita Describir la factura de Azure en una capacidad de Fabric.

Capacidad de Fabric

Como usuario, se puede comprar una capacidad de Fabric de Azure especificando una suscripción de Azure. El tamaño de la capacidad determina la cantidad de potencia de cálculo disponible. Para Apache Spark para Fabric, cada CU comprada se traduce en 2 núcleos virtuales de Spark. Por ejemplo, si adquieres una capacidad de Fabric F128, esto se traduce en 256 SparkVCores. Una capacidad de Fabric se comparte en todas las áreas de trabajo agregadas y en las que el proceso total de Apache Spark permitido se comparte entre todos los trabajos enviados desde todas las áreas de trabajo asociadas a una capacidad. Para entender las distintas SKU, la asignación de núcleos y la limitación en Spark, consulte Límites de simultaneidad y colas en Apache Spark para Microsoft Fabric.

Configurar el proceso de Spark y la capacidad comprada

El proceso de Apache Spark para Fabric ofrece dos opciones cuando se trata de la configuración de proceso.

Grupos de inicio: estos grupos predeterminados son una manera rápida y sencilla de usar Spark en la plataforma de Microsoft Fabric en cuestión de segundos. Puede usar las sesiones de Spark de inmediato, en lugar de esperar a que Spark configure los nodos, lo que le ayuda a hacer más con los datos y obtener información más rápido. En lo que respecta a la facturación y el consumo de capacidad, se cobra por el consumo de capacidad cuando se empieza a ejecutar la definición de trabajo de bloc de notas o Spark. No se le cobrará por el tiempo que los clústeres estén inactivos en el grupo.

Por ejemplo, si envía un trabajo de bloc de notas a un grupo de inicio, solo se le facturará por el periodo de tiempo en el que la sesión de bloc de notas esté activa. El tiempo facturado no incluye el tiempo de inactividad ni el tiempo empleado en personalizar la sesión con el contexto Spark. Para obtener más información sobre la configuración de grupos de inicio en función de la SKU de capacidad de Tejido comprada, visita Configurar grupos de inicio basados en la capacidad de tejido

Grupos de Spark: se trata de grupos personalizados, donde se pueden personalizar el tamaño de los recursos que necesita para las tareas de análisis de datos. Puede asignar un nombre al grupo de Spark y elegir el número y el tamaño de los nodos (las máquinas que realizan el trabajo). También puede indicar a Spark cómo ajustar el número de nodos en función del trabajo que tenga. La creación de un grupo de Spark es gratuita; solo paga cuando ejecuta un trabajo de Spark en el grupo y, a continuación, Spark configura los nodos por usted.

- El tamaño y el número de nodos que puede tener en el grupo de Spark personalizado depende de la capacidad de Microsoft Fabric. Puede usar estos núcleos virtuales de Spark para crear nodos de diferentes tamaños para el grupo de Spark personalizado, siempre que el número total de núcleos virtuales de Spark no supere los 128.

- Los grupos de Spark se facturan como los grupos iniciales; no paga por los grupos de Spark personalizados que haya creado a menos que tenga una sesión Spark activa creada para ejecutar un bloc de notas o una definición de trabajo Spark. Solo se le factura por la duración de sus trabajos. No se le facturan etapas como la creación del clúster y la desasignación una vez finalizado el trabajo.

Por ejemplo, si envía un trabajo de bloc de notas a un grupo de Spark personalizado, solo se le cobrará por el periodo de tiempo en que la sesión esté activa. La facturación de esa sesión de bloc de notas se detiene una vez que la sesión de Spark se ha detenido o ha expirado. No se le cobrará por el tiempo empleado en adquirir instancias de clúster de la nube ni por el tiempo empleado en inicializar el contexto de Spark. Para obtener más información sobre la configuración de grupos de Spark en función de la SKU de capacidad de Fabric comprada, visita Configurar grupos basados en la capacidad de tejido

Nota:

El período de tiempo de expiración de sesión predeterminado para los grupos de inicio y los grupos de Spark que cree se establece en 20 minutos. Si no utiliza su grupo de Spark durante 2 minutos después de que expire su sesión, su grupo de Spark será desasignado. Para detener la sesión y la facturación después de completar la ejecución del cuaderno antes del período de tiempo de expiración de la sesión, puede hacer clic en el botón Detener sesión desde el menú Inicio de cuadernos o ir a la página central de supervisión y detener la sesión allí.

Informes de uso de proceso de Spark

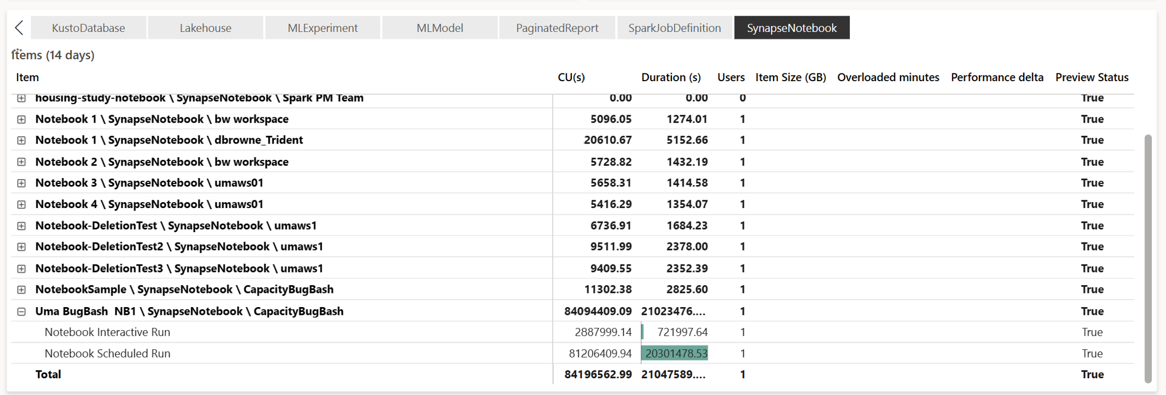

La aplicación Métricas de capacidad de Microsoft Fabric proporciona visibilidad sobre el uso de la capacidad para todas las cargas de trabajo de Fabric en un solo lugar. Los administradores de capacidad usan para supervisar el rendimiento de las cargas de trabajo y su uso, en comparación con la capacidad adquirida.

Una vez se haya instalado la aplicación, selecciona el tipo de elemento Cuaderno,Lakehouse,definición de trabajo de Spark en la lista desplegable Seleccionar tipo de elemento:. El gráfico de cinta de opciones de varias métricas ahora se puede ajustar a un período de tiempo deseado para comprender el uso de todos estos elementos seleccionados.

Todas las operaciones relacionadas con Spark se clasifican como operaciones en segundo plano. El consumo de capacidad de Spark se muestra en un cuaderno, una definición de trabajo de Spark o un lago de datos, y se agrega por nombre de operación y elemento. Por ejemplo: si se ejecuta un trabajo de cuaderno, puedes ver la ejecución del cuaderno, las RU usadas por el cuaderno (El total de núcleos virtuales de Spark/2 como 1 CU proporciona 2 núcleos virtuales de Spark), la duración que ha tomado el trabajo en el informe.

Para obtener más información sobre los informes de uso de capacidad de Spark, consulta Supervisión del consumo de capacidad de Apache Spark

Para obtener más información sobre los informes de uso de capacidad de Spark, consulta Supervisión del consumo de capacidad de Apache Spark

Ejemplo de facturación

Imagine la siguiente situación:

Hay una capacidad C1 que hospeda un área de trabajo de Tejido W1 y esta área de trabajo contiene Lakehouse LH1 y Notebook NB1.

- Cualquier operación de Spark que realice el cuaderno (NB1) o lakehouse(LH1) se notifica en la capacidad C1.

Extender este ejemplo a un escenario en el que hay otra capacidad C2 que hospeda un área de trabajo de Fabric W2 y permite decir que esta área de trabajo contiene una definición de trabajo de Spark (SJD1) y Lakehouse (LH2).

- Si la definición de trabajo de Spark (SDJ2) del área de trabajo (W2) lee datos de lakehouse (LH1), el uso se notifica con la capacidad C2 que está asociada al área de trabajo (W2) que hospeda el elemento.

- Si el cuaderno (NB1) realiza una operación de lectura desde Lakehouse(LH2), el consumo de capacidad se notifica con la capacidad C1 que alimenta el área de trabajo W1 que hospeda el elemento del cuaderno.