Supervisión del consumo de capacidad de Apache Spark

El propósito de este artículo es ofrecer instrucciones para los administradores que quieran supervisar las actividades en las capacidades que administran. Mediante el uso de los informes de consumo de capacidad de Apache Spark disponibles en la aplicación Métricas de capacidad de Microsoft Fabric, los administradores pueden obtener información sobre el consumo de capacidad de Spark facturable para los elementos de carga de trabajo de Spark, como una instancia de Lakehouse, un cuaderno y las definiciones de trabajos de Apache Spark. Algunas actividades de consumo de capacidad de Spark no se notifica en la aplicación.

Consumo de capacidad de Spark notificado

Las siguientes operaciones de los lagos de datos, cuadernos y definiciones de trabajos de Spark se tratan como actividades facturables.

| Nombre de operación | Elemento | Comentarios |

|---|---|---|

| Operaciones de Lakehouse | Lakehouse | Los usuarios pueden obtener una vista previa de la tabla en el explorador de Lakehouse. |

| Carga de tabla de Lakehouse | Lakehouse | Los usuarios cargan la tabla delta en el explorador de Lakehouse. |

| Ejecución del cuaderno | Notebook | Los usuarios ejecutan manualmente el cuaderno. |

| Ejecución del cuaderno HC | Notebook | El cuaderno se ejecuta en la sesión de Apache Spark de alta simultaneidad. |

| Ejecución programada del cuaderno | Notebook | El cuaderno se ejecuta desencadenado por eventos programados del cuaderno. |

| Ejecución de canalización del cuaderno | Notebook | El cuaderno se ejecuta desencadenado por la canalización. |

| Ejecución de VS Code del cuaderno | Notebook | El cuaderno se ejecuta en VS Code. |

| Ejecución de trabajo de Spark | Definición de trabajo de Spark | El trabajo por lotes de Spark se ejecuta iniciado por el envío del usuario. |

| Ejecución programada del trabajo de Spark | Definición de trabajo de Spark | El trabajo por lotes se ejecuta desencadenado por eventos programados del cuaderno. |

| Ejecución de canalización de trabajo de Spark | Definición de trabajo de Spark | Ejecuciones de trabajo por lotes desencadenados por la canalización. |

| Ejecución de VS Code del trabajo de Spark | Definición de trabajo de Spark | Definición de trabajo de Spark enviada desde VS Code. |

Consumo de capacidad de Spark que no se notifica

Hay algunas actividades de consumo de capacidad de Spark que no se notifican en la aplicación de métricas. Estas actividades incluyen trabajos de Spark del sistema para la administración de bibliotecas y determinados trabajos de Spark del sistema para el grupo de Spark Live o sesiones en directo.

Administración de bibliotecas: el consumo de capacidad asociado a la administración de bibliotecas en el nivel de área de trabajo no se notifica en la aplicación de métricas.

Trabajos de Spark del sistema: el consumo de capacidad de Spark que no está asociado a un cuaderno, una definición de trabajo de Spark o un lago de datos no se incluye en los informes de capacidad.

Informes de consumo de capacidad

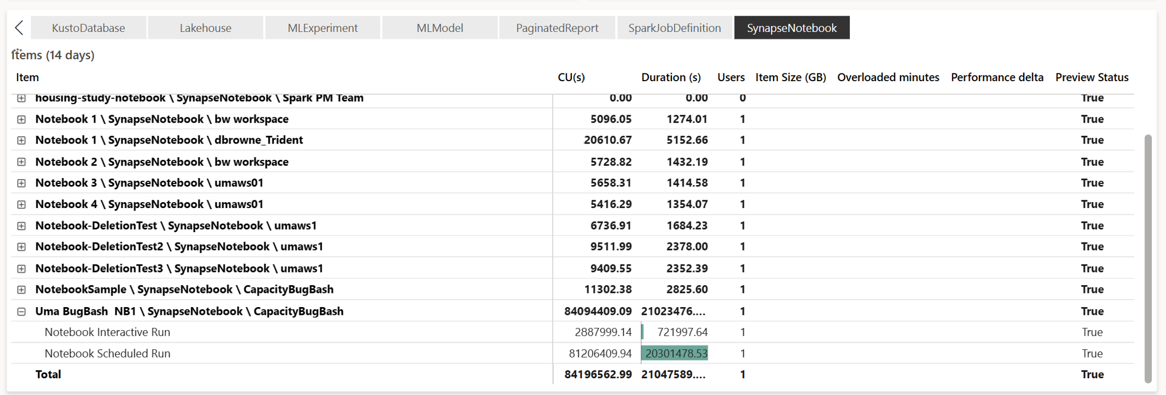

Todas las operaciones relacionadas con Spark se clasifican como operaciones en segundo plano. El consumo de capacidad de Spark se muestra en un cuaderno, una definición de trabajo de Spark o un lago de datos, y se agrega por nombre de operación y elemento.

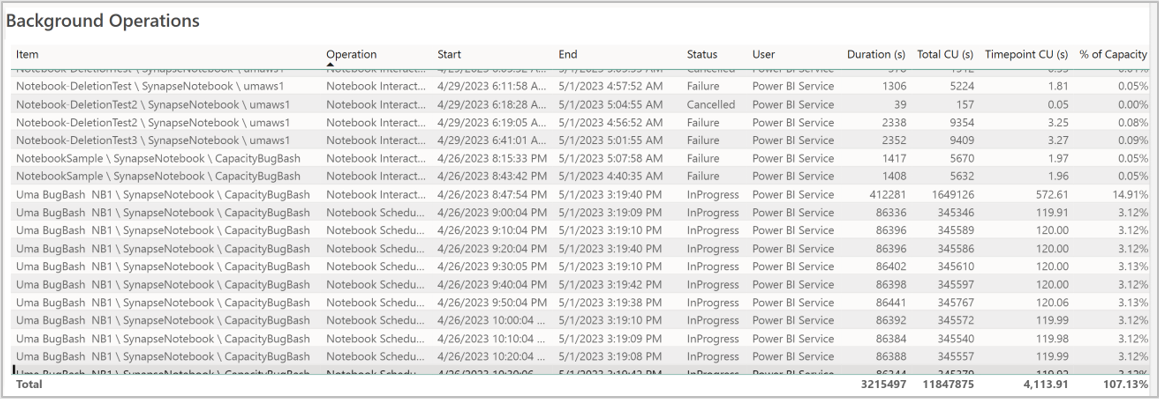

Informe de operaciones en segundo plano

Las operaciones en segundo plano se muestran para un punto de tiempo específico. En la tabla del informe, cada fila hace referencia a una operación de usuario. Revise la columna Usuario para identificar quién realizó una operación específica. Si necesita más información sobre una operación específica, puede usar su identificador de operación para buscarlo en el centro de supervisión de Microsoft Fabric.