MLOps y GenAIOps para cargas de trabajo de IA en Azure

Las operaciones de carga de trabajo de IA se centran en la conservación de los datos y el consumo de esos datos. Las operaciones garantizan la eficacia para lograr y mantener la calidad, confiabilidad, seguridad, ética y otros estándares que se priorizan para la carga de trabajo.

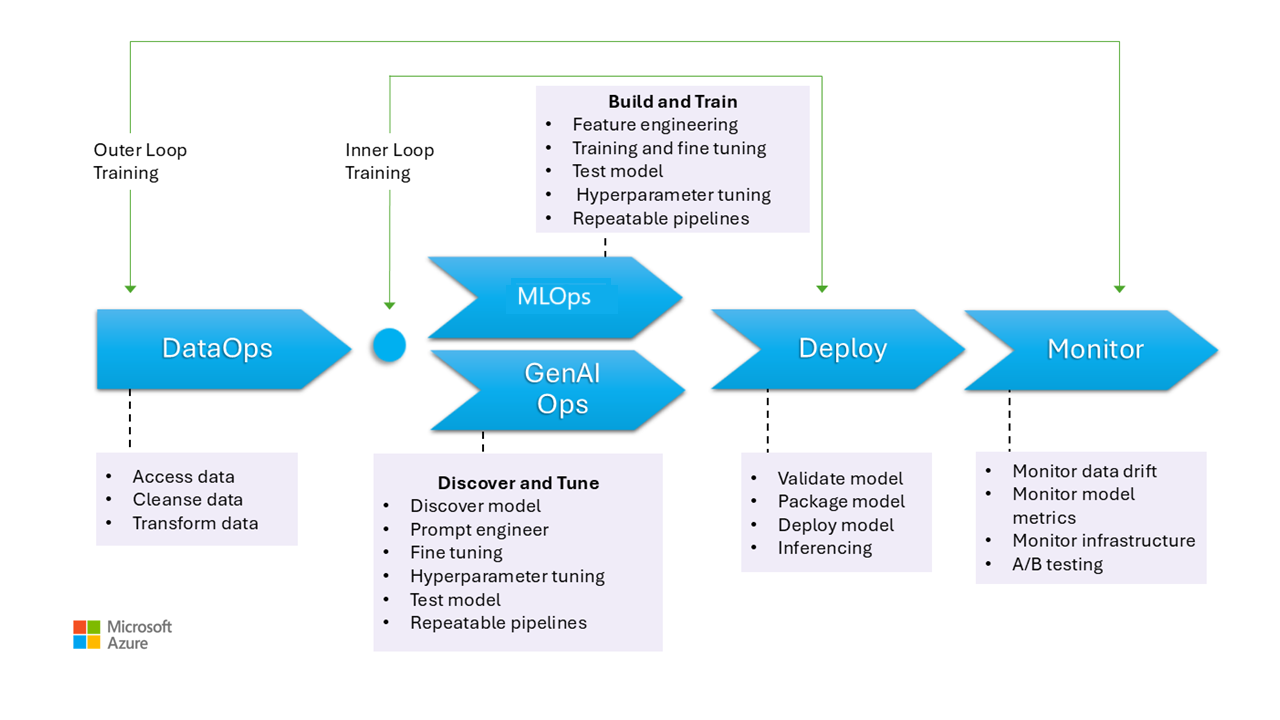

Las tareas de carga de trabajo se pueden clasificar en tres áreas principales: desarrollo de aplicaciones, control de datos y administración de modelos de IA. Cada categoría debe adoptar metodologías operativas probadas en el sector, como DevOps, DataOps, MLOps y GenAIOps.

Las actividades de DevOps abarcan toda la administración del ciclo de vida de desarrollo de aplicaciones a través de canalizaciones y supervisión automatizadas de implementación continua e implementación continua (CI/CD). Sin embargo, para las cargas de trabajo de IA, la canalización de datos es uno de los componentes principales. DataOps, una especialización de DevOps, se centra en administrar el ciclo de vida de los datos mediante la optimización de procesos como la extracción de datos, la transformación y la carga (ETL/ELT). Los profesionales de DataOps suelen medir el rendimiento del flujo de datos y la eficacia de la limpieza de datos y supervisar la canalización para detectar anomalías.

Las cargas de trabajo de IA son intrínsecamente no deterministas. Muchos modelos de inteligencia artificial son propensos a producir respuestas diferentes para la misma consulta durante la inferencia. Estas cargas de trabajo necesitan procesos que puedan administrar y adaptarse a la imprevisibilidad de las salidas de IA. DataOps se extiende a MLOps, que operacionaliza los flujos de trabajo de aprendizaje automático para el entrenamiento y las pruebas del modelo. GenAIOps, un subconjunto especializado de MLOps, tiene como destino soluciones de inteligencia artificial generativa. Implica tareas como la detección de modelos y la refinación de modelos previamente entrenados con datos enriquecidos.

Las actividades operativas a menudo se superponen y las distintas metodologías se aplican a distintos grados. Por ejemplo, en ia discriminativa, DataOps desempeña un papel importante, mientras que las actividades de DevOps son menos destacadas. Por el contrario, en la inteligencia artificial generativa, la excelencia operativa se basa más en DevOps que en DataOps.

Independientemente de que el objetivo general sea la entrega de funcionalidades con operaciones eficaces a lo largo del ciclo de vida de desarrollo. Los resultados esperados son:

- Procesos repetibles con resultados coherentes.

- Precisión sostenida de los modelos a lo largo del tiempo.

- Gobernanza eficaz que minimiza los riesgos.

- Procesos de administración de cambios para adaptarse al desfase del modelo.

La automatización y la supervisión son sus estrategias operativas clave para lograr esos objetivos.

También debe establecer procesos estandarizados para los componentes de inteligencia artificial, para las operaciones rutinarias, no planeadas y de emergencia, y tener mecanismos de seguimiento adecuados. Sin esos procesos, corre el riesgo de:

- Errores repetidos y noreproducibilidad en el procesamiento de datos, hospedaje de modelos, administración de datos en tierra y otras tareas.

- Datos de baja calidad o obsoletos usados para el entrenamiento y el refinamiento del modelo.

- Afecta a la confianza del usuario final en el sistema, en el peor de los casos, lo que conduce a problemas legales, de cumplimiento o de seguridad.

Debe implementar procesos establecidos con el conjunto correcto de herramientas. Hay herramientas especializadas disponibles para administrar flujos de trabajo de inteligencia artificial o aprendizaje automático en entornos.

Este artículo se centra en la estrategia de diseño para las operaciones y proporciona recomendaciones de herramientas.

Recomendaciones

Este es el resumen de las recomendaciones proporcionadas en este artículo.

| Recomendación | Descripción |

|---|---|

| Diseñar un ciclo de vida eficaz de las operaciones de carga de trabajo. | En función de los componentes de la carga de trabajo de IA, las distintas fases operativas se aplicarán a su ciclo de vida. Es importante que comprenda los procedimientos recomendados pertinentes para su escenario y las herramientas que están disponibles para implementarlos. Dedique el tiempo para obtener información sobre e implementar las recomendaciones clave para todos los componentes de la carga de trabajo. ▪ DataOps ▪ MLOps ▪ GenAIOps ▪ Supervisión |

| Automatización de todas las acciones | La automatización garantiza la repetibilidad y eficacia en el ciclo de vida de una carga de trabajo. Aunque los procesos de DevOps son un colaborador clave para esto, hay pasos adicionales que debe seguir para compilar, probar, validar e implementar los modelos de forma eficaz. ▪ Automatización |

| Use canalizaciones de implementación siempre que sea posible. | Las canalizaciones de implementación pueden ayudarle a entregar implementaciones de infraestructura repetibles o integrar código continuamente. También son una excelente herramienta para crear o validar modelos antes de promocionarlos a producción. La implementación de canalizaciones de implementación le ayuda a mejorar la confiabilidad, así como la experiencia general del usuario de la carga de trabajo. ▪ Canalizaciones de implementación |

| Evite el desfase y la descomposición en los modelos. | Debe protegerse contra la descomposición y el desfase del modelo, al mismo tiempo que tiene un proceso estructurado que le ayuda a aceptar nuevos cambios de modelo de una manera controlada. Seguir las recomendaciones sobre el mantenimiento del modelo le ayuda a seguir siendo compatible, a evitar experiencias de usuario inesperadas y a proporcionar un servicio más actualizado. ▪ Mantenimiento de modelos |

Ciclo de vida de las operaciones de carga de trabajo

En esta imagen se muestran las fases operativas de los modelos de inteligencia artificial, como la recopilación de datos, la limpieza de datos para eliminar incoherencias o errores y la transformación de datos en un formato analizable. Estas fases son relevantes para entrenar modelos discriminativos y datos de base en modelos generativos. Sin embargo, el caso de uso específico de los modelos generativos de entrenamiento no se muestra en esta imagen. Ese caso de uso está fuera del ámbito de este artículo.

Las fases de MLOps y GenAIOps son similares. La principal diferencia es que, en el caso de GenAIOps, el enfoque cambia de entrenamiento a seleccionar el modelo adecuado, la ingeniería de avisos e incorporar conocimientos específicos del dominio mediante el ajuste o la implementación de la generación aumentada de recuperación (RAG).

Incluso las fases de implementación y supervisión son bastante similares.

En las secciones siguientes se describen las prácticas operativas comunes. Abarcan todas las fases del ciclo de vida, desde la preproducción hasta la producción.

DataOps

Los datos se agregan de varios orígenes de datos de producción y, a continuación, se preprocesan para quitar errores e incoherencias y para controlar los valores que faltan. Por último, se transforma y normaliza en un formato adecuado para el entrenamiento o el enriquecimiento. Los aspectos del diseño se describen en los artículos Datos de entrenamiento y Datos de puesta a tierra .

Los procesos de operaciones de datos durante esta fase deben ser eficaces porque el control de grandes volúmenes de datos de varios orígenes y canalizaciones de datos complejas puede ser difícil. Los enfoques que tome deben asegurarse de que esta fase genera datos de alta calidad. Supervise esta fase para realizar un seguimiento del progreso hacia la barra de calidad aceptable.

También debe asegurarse de que los datos sean seguros, dado que los datos proceden de producción. Asegúrese de que los entornos inferiores, como Dev/Test, son tan seguros como producción para ayudar a evitar problemas de seguridad.

Nota:

Solucione los datos de mala calidad invirtiendo en una amplia limpieza de datos durante las fases iniciales. Aproveche los patrones de análisis conocidos, como medallion, data mesh y almacenes de características, para realizar tareas de procesamiento ascendentes. Si las fases ascendentes son ineficaces, debe mejorar la calidad durante las fases de bajada, lo que conduce a un aumento de los costos de carga de trabajo porque la preparación de datos se produce durante cada fase.

Para obtener información sobre las tareas de procesamiento de datos, consulte estos artículos:

Herramientas

Se recomienda estandarizar las herramientas de orquestación de datos de la carga de trabajo. Las herramientas deben ser capaces de proporcionar una canalización de datos que pueda agrupar actividades y que tenga automatización integrada.

Una canalización de Azure Data Factory puede ser una opción inicial. Puede conectarse y procesar muchos orígenes de datos de forma eficaz. También puede considerar Azure Synapse Analytics, que combina macrodatos y almacenamiento de datos y admite lagos de datos, Apache Spark y Azure Synapse SQL. También se integra con Data Factory para ETL.

Para preparar los datos de entrenamiento, las canalizaciones de Azure Machine Learning proporcionan características especializadas que pueden automatizar tareas como la recopilación y el procesamiento de datos.

Las tecnologías de código abierto como Pandas (para la preparación de datos) y Scrapy son opciones populares.

MLOps

El entrenamiento del modelo es el proceso de seleccionar algoritmos adecuados y proporcionarles datos históricos preprocesados y observaciones para permitir que el modelo aprenda patrones y realice predicciones.

Entrenar el modelo (ingeniería de características) y el ajuste de hiperparámetros son procesos iterativos y son costosos. Durante cada iteración, los científicos de datos realizan un seguimiento de los resultados con combinaciones de datos, código y parámetros. Use canalizaciones repetibles para realizar un seguimiento de los experimentos con un esfuerzo manual mínimo hasta que se alcance el nivel correcto de precisión.

Otro desafío operativo es el aprovisionamiento y el escalado de recursos de proceso especializados en los que se realizan experimentos. Además, debe empaquetar y publicar modelos de forma eficaz.

Teams puede empezar con el desarrollo basado en la interfaz de usuario para reducir los desafíos y, a medida que se vuelven más seguros, pasan a un enfoque basado en código.

Herramientas

Se recomienda usar herramientas que puedan realizar un seguimiento de los experimentos de aprendizaje automático mediante la captura de detalles como versiones de código, entornos, parámetros, ejecuciones y resultados. MLflow es uno de estos marcos de código abierto. Considere la posibilidad de usar áreas de trabajo de Azure Machine Learning, que son compatibles con MLflow y proporcionan un flujo de trabajo simplificado que permite a los científicos de datos administrar la productividad y la reproducibilidad en sus proyectos. Para administrar el desarrollo de código con el seguimiento del control de código fuente, integre la canalización de aprendizaje automático con el control de código fuente como GitHub o use recursos compartidos de archivos.

El proceso de hospedaje también puede influir en la elección de un orquestador de flujo de trabajo. Si la aplicación se hospeda en Azure Kubernetes Service (AKS), considere la posibilidad de usar Kubeflow.

Si está considerando Azure Machine Learning, le recomendamos que comience con la perspectiva de Azure Well-Architected Framework en Machine Learning para asegurarse de que comprende cómo el producto puede ayudarle con los problemas de calidad del marco bien diseñado de la carga de trabajo.

Parte de la ventaja del proceso es optimizar el tiempo personal. Normalmente, los científicos de datos necesitan herramientas y SDK específicos para realizar de forma eficaz análisis de datos exploratorios (EDA) y experimentación desde sus estaciones de trabajo. Evalúe si las opciones precompiladas en Azure Machine Learning son adecuadas. Si no es así, almacene la configuración de estación de trabajo o mantenga imágenes de máquina virtual aprobadas para este trabajo. Un ejemplo de una imagen que puede usar como punto de partida es la máquina virtual (DSVM) Ciencia de datos.

En algunos casos, la directiva podría no permitir el uso de máquinas virtuales. Busque alternativas, como agregar Microsoft Dev Box y Azure Virtual Desktop. También puede considerar el uso de Docker para arrancar máquinas que contienen imágenes precompiladas.

Sin embargo, a medida que esta fase madura y necesita experimentos extendidos, vaya a instancias de proceso administradas y prefiera opciones integradas como parte del flujo de trabajo. Evalúe si puede usar instancias de proceso de Azure Machine Learning para el entrenamiento y la inferencia con fines de desarrollo y pruebas. Los clústeres de proceso pueden controlar grandes conjuntos de datos y modelos complejos.

Azure Machine Learning proporciona soluciones basadas en código a través del SDK y opciones de poco código, como el aprendizaje automático automatizado y el diseñador visual. El SDK de Python ofrece varias maneras de entrenar modelos, cada uno con características distintas. Machine Learning también admite tecnologías de computación distribuida y optimización avanzadas, como ORTModule, DeepSpeed y LoRA de ONNX Runtime Training para acelerar el proceso de entrenamiento.

GenAIOps

Las actividades clave durante esta fase comienzan por detectar y evaluar modelos existentes para identificar uno entrenado previamente para el caso de uso específico. Es un proceso iterativo. Después de encontrar un modelo adecuado, puede beneficiarse de ser refinado para el terreno específico del dominio, que también implica pasos iterativos y requiere un determinado nivel de orquestación.

La integración e implementación de modelos requiere herramientas y prácticas especializadas que van más allá de las funcionalidades tradicionales de MLOps, incluidos los modelos de orquestación, los índices vectoriales, las solicitudes y los bloques de código.

Herramientas

Para abordar las tareas de detección, aproveche las ventajas de los catálogos de modelos que incluyen modelos de varios proveedores. El catálogo de modelos de en el portal de Azure AI Foundry permite evaluar entre colecciones seleccionadas e implementar modelos de forma eficaz.

El flujo de mensajes de Azure Machine Learning puede ayudar con el desarrollo de código de orquestación, lo que permite la creación de prototipos, la experimentación, la iteración y la ingeniería de mensajes. Estos flujos se pueden implementar en puntos de conexión administrados de Azure Machine Learning. Evalúe si puede ejecutar e implementar los flujos con la tecnología de canalización de CI/CD existente.

Implementación

Durante esta fase, el modelo se implementa en una plataforma de hospedaje e inferencia o en el nivel de servicio de las cargas de trabajo de IA. Las API deben empaquetarse como un contenedor escalable. La plataforma de contenedor puede ser un proceso administrado o una plataforma de hospedaje personalizada. Las prácticas operativas deben garantizar una implementación segura y habilitar reversiones.

Comience con soluciones de plataforma como servicio (PaaS) y sin servidor, como Azure OpenAI Service, para simplificar la adopción y administración. Considere la posibilidad de usar la API sin servidor de Azure Machine Learning para agregar el acceso al punto de conexión. Los clústeres de proceso administrados son una opción viable para las necesidades avanzadas. El autohospedaje en AKS es otra opción. Asegúrese de ajustar el tamaño adecuado al proceso y mantener el aislamiento adecuado de otras cargas de trabajo. También puede considerar opciones como hospedar completamente el modelo como infraestructura como servicio (IaaS). IaaS proporciona flexibilidad, pero puede agregar carga operativa. Estas opciones se describen en Plataforma de aplicaciones.

Esta fase presenta la última oportunidad de detectar problemas antes de mover el modelo a producción. Los procesos de prueba deben incluir pasos de validación para asegurarse de que el modelo está configurado para proporcionar predicciones según lo previsto.

Debe integrar el modelo en el entorno de producción existente siguiendo los procesos de exposición progresiva y usando implementaciones en paralelo. El modelo controlado es una manera común de implementar nuevos modelos. Con este método, la base de usuarios aumenta gradualmente. La implementación azul-verde es otro método.

Herramientas

Puede usar canalizaciones de Azure Machine Learning o Azure Pipelines para implementar los modelos para la inferencia. Machine Learning proporciona varias características para operaciones simplificadas, como el aprovisionamiento de nodos, las actualizaciones del sistema operativo, el escalado automático, la supervisión y las redes virtuales aisladas.

Machine Learning también admite la implementación azul-verde, lo que permite que un único punto de conexión contenga varias implementaciones.

Si usa otras plataformas de hospedaje, como Azure Container Apps o App de Azure Service, es responsable de las operaciones, incluido el aprovisionamiento y el escalado. Use Azure DevOps, canalizaciones de GitHub o su elección de tecnología de CI/CD en esos casos.

Supervisión

La supervisión es una estrategia clave y se aplica en todas las fases. Se trata de un proceso continuo y actúa como entrada para las puertas de calidad que garantizan que las cargas de trabajo de INTELIGENCIA ARTIFICIAL se prueban rigurosamente para mantener la coherencia y la confiabilidad durante todo el ciclo de vida de desarrollo. Los modelos deben supervisarse desde las perspectivas operativas y de ciencia de datos.

Se recomienda encarecidamente tener un proceso de supervisión de bucle interno de DataOps que mida la proximidad a una barra de calidad de aceptación y compruebe si hay anomalías.

En el caso de los modelos entrenados previamente, también es importante supervisar el desfase de datos y el rendimiento, con un enfoque principal en la relevancia. Evalúe las entradas (avisos) y las salidas (finalizaciones) para asegurarse de que son pertinentes y precisas. Además, tenga en cuenta los riesgos de seguridad, como los intentos de manipular el comportamiento del modelo a través de mensajes malintencionados. Asegúrese de que hay una con modo carpa ration exhaustiva que inspecciona los datos en ambas direcciones y filtra el contenido inapropiado. Estas consideraciones se describen en el área de diseño de ResponsibleAI.

Después de la implementación, las operaciones de supervisión son necesarias para solucionar problemas como la degradación del modelo. Los modelos pueden quedar obsoletos debido a cambios en los datos o cambios externos que pueden hacer que el modelo genere resultados irrelevantes. Como medida proactiva, use procesos automatizados para la supervisión continua y evalúe y vuelva a entrenar para mantener la precisión y la relevancia. Además, debe supervisar las métricas de infraestructura y carga de trabajo, como lo haría con cualquier otra carga de trabajo, para ayudar a garantizar un rendimiento y una confiabilidad óptimos. Para obtener más información, consulte Pruebas para la descomposición del modelo.

Herramientas

Invertir en herramientas que facilitan la recopilación de métricas de puntos de conexión de inferencia, como el recopilador de datos de Azure Machine Learning.

También necesita observabilidad del rendimiento del modelo, el desfase de datos y la seguridad y la calidad de la inteligencia artificial generativa.

Para obtener más información, consulta estos artículos:

Automatización

Las cargas de trabajo de IA son complejas porque el ciclo de vida general implica muchos roles, cambios frecuentes e pasos relacionados. Los procesos manuales pueden ser propensos a errores e incoherencias. La automatización en el hospedaje del modelo de procesamiento de datos ayuda a garantizar la repetibilidad y la eficacia. La automatización no siempre es necesaria, pero es una manera eficaz de administrar estas complejidades. Estos son algunos casos de uso en los que la automatización puede mitigar los riesgos:

A diferencia de la implementación de código tradicional, los modelos y soluciones no deterministas en ia o aprendizaje automático requieren experimentación iterativa y entrenamiento. Cuando varios equipos colaboran, automatización, como una manera de aplicar procesos estandarizados, pueden ayudar a mantener la coherencia, reproducibilidad y colaboración eficaz entre científicos de datos, ingenieros y equipos de operaciones.

El ciclo de vida del modelo implica dos tipos principales de entrenamiento:

El entrenamiento en línea incorpora datos recientes en el modelo con frecuencia, a veces diariamente, para asegurarse de que las decisiones se basan en la información más reciente. Este entrenamiento se integra en la carga de trabajo para que el modelo se actualice continuamente como parte del proceso normal.

El entrenamiento sin conexión entrena el modelo con menos frecuencia, lo que permite una brecha más larga entre las actualizaciones. El proceso de entrenamiento es independiente de la carga de trabajo principal y se realiza de forma asincrónica. Una vez listo el nuevo modelo, se integra en el sistema.

La confiabilidad se puede poner en peligro si las actualizaciones son poco frecuentes. Si se pierde una actualización, se puede posponer sin problemas importantes. Este concepto también se aplica a los datos de puesta a tierra. Por ejemplo, si usa RAG, debe decidir si necesita usar datos recientes o si los datos más antiguos son suficientes. Ambos escenarios implican equilibrar la necesidad de información actualizada con la práctica de la frecuencia de actualización. Debe realizar el entrenamiento en línea a través de la automatización debido a la frecuencia y confiabilidad necesarias. Para el entrenamiento sin conexión, debido a la frecuencia necesaria, debe justificar la automatización mediante el análisis de los beneficios de los costos. Además, puede realizar el entrenamiento sin conexión mediante recursos menos costosos, como hardware sin conexión.

Los procesos tradicionales de DevOps suelen verse afectados por cambios estructurales. Sin embargo, en ia y aprendizaje automático, los modelos se entrenan en datos de producción. La descomposición del modelo supone un riesgo significativo y puede provocar una disminución del rendimiento con el tiempo si no se supervisa. La recopilación automatizada y el análisis de métricas de rendimiento, alertas y reentrenamiento de modelos son necesarios para mantener la eficacia del modelo. Use la automatización de una manera que pueda ayudarle a detectar cambios en los datos y las dependencias del modelo para comprender claramente el estado actual en cualquier momento dado.

Los modelos se pueden entrenar con dos enfoques distintos.

- Los modelos se entrenan en el entorno de desarrollo con datos de producción completos y solo se promueve el artefacto a través de entornos. Este enfoque puede reducir los costos computacionales, pero requiere una seguridad más estricta para controlar los datos de producción en los entornos más bajos y puede que no sea posible en todas las organizaciones.

- El modelo se entrena en cada entorno. La promoción de código puede ayudar con la estabilidad porque el código de entrenamiento se revisa y prueba en los entornos inferiores, pero aumenta el costo del proceso.

Ambos enfoques ofrecen ventajas y desventajas. Elegir el enfoque adecuado depende de las prioridades de su organización y de las prácticas del ciclo de vida de desarrollo de software (SDLC) de la carga de trabajo. Independientemente del método, las pruebas exhaustivas y la evaluación del modelo antes de la implementación de producción son esenciales.

El código de automatización debe incorporar el linaje de datos para admitir la auditoría proporcionando un registro claro de las fases de procesamiento de datos. Este registro le ayuda a administrar las expectativas y le permite demostrar cómo se tomaron las decisiones para poder abordar cualquier preocupación sobre los resultados.

Canalizaciones de implementación

En las cargas de trabajo de inteligencia artificial y aprendizaje automático, el desarrollo de modelos implica crear, validar y promover modelos a plataformas de hospedaje de modelos . Es importante tener canalizaciones de implementación que optimice los flujos de trabajo complejos relacionados con el procesamiento de datos, la ingeniería de características, el entrenamiento o el aumento del modelo y la implementación en producción. Dada la naturaleza no determinista de la inteligencia artificial, que hace que los procesos sean opacos, debe incorporar pruebas cualitativas en canalizaciones de versión y sistemas de supervisión.

Aunque MLOps y GenAIOps podrían requerir distintas actividades de inteligencia artificial y tecnologías principales podrían diferir, los conceptos subyacentes siguen siendo similares a los de DevOps. Se recomienda aplicar procedimientos recomendados a partir de los procesos de DevOps existentes. Integre las actividades de inteligencia artificial en las canalizaciones existentes de la carga de trabajo.

Normalmente, las cargas de trabajo de IA implican implementaciones de código tradicionales. Puede elegir controlar la implementación del modelo junto con el código o por separado en su propio ciclo de vida. El enfoque anterior es preferible. Prepárese para empaquetar modelos e puntos de conexión de inferencia con la implementación de cargas de trabajo para mantener las operaciones de inteligencia artificial centradas principalmente en la preparación de datos, el entrenamiento o ajuste, la administración de datos en tierra y la supervisión.

Vuelva a evaluar cómo se pueden adaptar los siguientes recursos para cubrir todo el ciclo de vida de MLOps y GenAIOps, desde la preproducción a la producción:

- Herramientas de infraestructura como código (IaC)

- Canalizaciones de CI/CD

- Pila de observabilidad para el seguimiento y la identificación de problemas

Herramientas

Puede ampliar los flujos de trabajo de Acciones de Azure Pipelines y GitHub, que se usan habitualmente para CI/CD, a modelos de aprendizaje automático. Ayudan a implementar la infraestructura de aprendizaje automático, los componentes de carga de trabajo personalizados, el código de orquestación y los modelos. Combine canalizaciones de Azure Machine Learning con canalizaciones de Azure DevOps o GitHub. Para más información, consulte Uso de Azure Pipelines con Azure Machine Learning.

Dos factores principales influyen en la elección de la combinación correcta de herramientas: caso de uso y funcionalidades. Por ejemplo, las canalizaciones de Azure Machine Learning son excelentes para la orquestación que realizan los científicos de datos. Tiene un conjunto de características enriquecido que admite la reutilización, el almacenamiento en caché y mucho más. Para conocer las opciones de herramientas, consulte ¿Qué tecnología de canalización de Azure debo usar?.

Mantenimiento del modelo

El panorama de inteligencia artificial y aprendizaje automático es competitivo con la innovación continua. Los nuevos modelos surgen con frecuencia, se detectan nuevos casos de uso y hay nuevos orígenes de datos disponibles. Como resultado, la descomposición del modelo es un desafío común.

Para evitar la degradación o el desfase del rendimiento del modelo a lo largo del tiempo, debe implementar procesos automatizados para la supervisión, evaluación y reentrenamiento continuos. Por ejemplo:

Mantener un catálogo de modelos. Automatice el proceso de detección de nuevos modelos y actualización del catálogo.

Adaptarse a nuevos casos de uso. A medida que se agregan nuevos casos de uso a los requisitos de carga de trabajo, anticipe las consultas y ajuste la lógica de procesamiento de datos en consecuencia.

Incorpore nuevos orígenes de datos. Si los nuevos orígenes de datos pueden mejorar potencialmente la eficacia predictiva o la relevancia del modelo, actualice la canalización de ingesta de datos para conectarse y extraer datos de esos orígenes.

Evaluar el cumplimiento de los requisitos normativos. Al adaptarse a nuevas funcionalidades, asegúrese de que los cambios permanecen válidos dentro de las restricciones de los estándares de cumplimiento organizativos o externos.

Implemente un proceso formal para realizar un seguimiento de la mejora continua e incorpore la auto-mejora como subproceso dentro de ese ciclo.

Evolución continua

Revise y mejore periódicamente las operaciones y fomente la innovación.

El modelo de madurez de MLOps avanza de los procesos manuales a la automatización completa. Comience con compilaciones y supervisión manuales e incorpore compilaciones automatizadas de aplicaciones, entornos de entrenamiento e implementación en fases justificadas por métricas completas. Para más información, consulte Modelo de madurez de MLOps.

Los niveles de madurez de GenAIOps pasan de modelos básicos a implementación estructurada, mediante técnicas de optimización automatizadas progresivamente. Para obtener más información, consulte Avance del nivel de madurez para GenAIOps.