Catálogo de modelos y colecciones en el portal de Azure AI Foundry

Importante

Los elementos marcados (versión preliminar) en este artículo se encuentran actualmente en versión preliminar pública. Esta versión preliminar se ofrece sin acuerdo de nivel de servicio y no se recomienda para las cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

El catálogo de modelos de Azure AI Foundry es el centro para detectar y usar una amplia gama de modelos para crear aplicaciones de IA generativa. El catálogo de modelos incluye cientos de modelos en proveedores de modelos como Azure OpenAI Service, Mistral, Meta, Cohere, NVIDIA y Hugging Face, incluidos los modelos entrenados por Microsoft. Los modelos de proveedores distintos de Microsoft son productos que no son de Microsoft, tal como se define en Términos de producto de Microsoft y están sujetos a los términos proporcionados con los modelos.

Colecciones de modelos

El catálogo de modelos organiza los modelos en distintas colecciones:

Mantenidos por Azure AI: los modelos de peso abierto y propietarios más populares que no son de Microsoft empaquetados y optimizados para funcionar sin problemas en la plataforma de Azure AI. El uso de estos modelos está sujeto a los términos de licencia del proveedor de modelos. Al implementar estos modelos en el portal de Azure AI Foundry, su disponibilidad está sujeta al contrato de nivel de servicio (SLA) de Azure aplicable y Microsoft proporciona asistencia en caso de problemas de implementación.

Los modelos de asociados como Meta, NVIDIA y Mistral AI son ejemplos de modelos disponibles en esta colección en el catálogo. Puede identificar estos modelos buscando una marca de verificación verde en los iconos del modelo del catálogo. También puede filtrar por la colección Mantenido por Azure AI.

Modelos de Azure OpenAI, disponibles exclusivamente en Azure: modelos insignia de Azure OpenAI disponibles mediante una integración con Azure OpenAI Service. Microsoft admite estos modelos y su uso según los términos del producto y el contrato de nivel de servicio de Azure OpenAI Service.

Modelos abiertos del centro Hugging Face: cientos de modelos del centro Hugging Face para la inferencia en tiempo real con el proceso administrado. Hugging Face crea y mantiene los modelos enumerados en esta colección. Para obtener ayuda, use el foro de Hugging Face o el soporte técnico de Hugging Face. Obtenga más información en Implementación de modelos abiertos con Azure AI Foundry.

Puede enviar una solicitud para agregar un modelo al catálogo de modelos mediante este formulario.

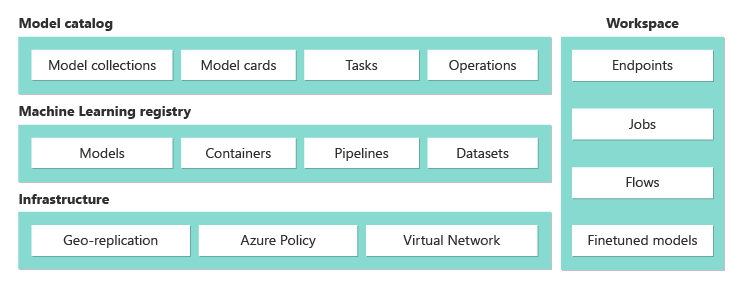

Información general sobre las funcionalidades del catálogo de modelo

Puede buscar y detectar modelos que satisfagan sus necesidades a través de keyword search y filters. El catálogo de modelos también ofrece las métricas de pruebas comparativas de rendimiento de modelos para algunos modelos. Para acceder a la prueba comparativa, haga clic en Compare Models o vaya a la pestaña Prueba comparativa de la tarjeta del modelo.

En la tarjeta del modelo, encontrará lo siguiente:

- Hechos rápidos: verá información clave sobre el modelo de un vistazo.

- Detalles: esta página contiene la información detallada sobre el modelo, incluida la descripción, la información de versión, el tipo de datos admitido, etc.

- Pruebas comparativas: encontrará métricas de pruebas comparativas de rendimiento para los modelos seleccionados.

- Implementaciones existentes: si ya ha implementado el modelo, puede encontrarlo en la pestaña Implementaciones existentes.

- Ejemplos de código: encontrará los ejemplos de código básicos para empezar a trabajar con el desarrollo de aplicaciones de IA.

- Licencia: encontrará información legal relacionada con las licencias del modelo.

- Artefactos: esta pestaña solo se mostrará para los modelos abiertos. Puede ver los recursos del modelo y descargarlos mediante la interfaz de usuario.

Implementación de modelo: Azure OpenAI

Para más información sobre los modelos de Azure OpenAI, consulte ¿Qué es Azure OpenAI Service?.

Implementación de modelo: API de proceso administrado y sin servidor

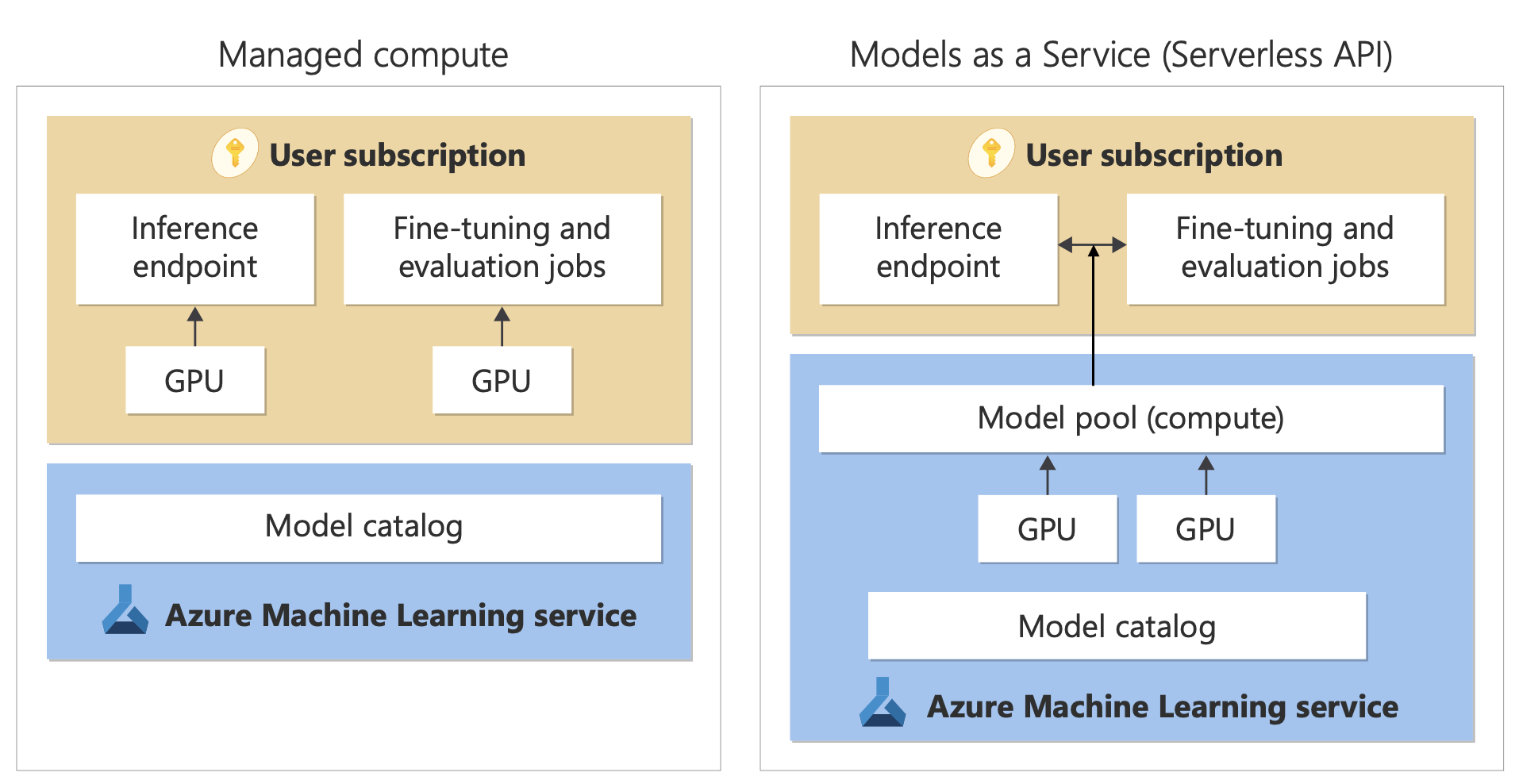

Además de los modelos de Azure OpenAI Service, el catálogo de modelos ofrece dos maneras distintas de implementar modelos para su uso: API de proceso administrado y sin servidor.

Las opciones y características de implementación disponibles para cada modelo varían, como se describe en las siguientes tablas. Obtenga más información sobre el procesamiento de datos con las opciones de implementación.

Funcionalidades de las opciones de implementación del modelo

| Características | Proceso administrado | API sin servidor (pago por token) |

|---|---|---|

| Experiencia de implementación y facturación | Los pesos del modelo se implementan en máquinas virtuales dedicadas con proceso administrado. Un proceso administrado, que puede tener una o varias implementaciones, pone a disposición una API REST para la inferencia. Se le facturan las horas principales de la máquina virtual que usan las implementaciones. | El acceso a los modelos se realiza a través de una implementación que aprovisiona una API para acceder al modelo. La API proporciona acceso al modelo que Microsoft hospeda y administra para la inferencia. Se le facturan entradas y salidas a las API, normalmente en tokens. Antes de implementar, se proporciona información de precios. |

| Autenticación de API | Claves y autenticación de Microsoft Entra. | Solo claves. |

| Seguridad del contenido | Use las API del servicio de seguridad de contenido de Azure AI. | Los filtros de seguridad de contenido de Azure AI están disponibles integrados con las API de inferencia. Los filtros de seguridad de contenido de Azure AI se facturan por separado. |

| Aislamiento de red avanzado | Configure redes administradas para centros de Azure AI Foundry. | El proceso administrado sigue la configuración de la marca de acceso a la red pública (PNA) del centro. Para obtener más información, consulte la sección Aislamiento de red para los modelos implementados a través de API sin servidor más adelante en este artículo. |

Modelos disponibles para las opciones de implementación admitidas

La lista siguiente contiene modelos de API sin servidor. Para ver los modelos de Azure OpenAI, consulte Modelos de servicio de Azure OpenAI Service.

| Modelo | Proceso administrado | API sin servidor (pago por token) |

|---|---|---|

| Modelos de la familia AI21 | No disponible | Jamba-1.5-Mini Jamba-1.5-Large |

| Modelos de familia Cohere | No disponible | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual Cohere-rerank-v3-english Cohere-rerank-v3-multilingual |

| Gretel | No disponible | Gretel-Navigator |

| Modelos de familia Healthcare AI | MedImageParse MedImageInsight CxrReportGen Virchow Virchow2 Prism BiomedCLIP-PubMedBERT microsoft-llava-med-v1.5 m42-health-llama3-med4 biomistral-biomistral-7b microsoft-biogpt-large-pub microsoft-biomednlp-pub stanford-crfm-biomedlm medicalai-clinicalbert microsoft-biogpt microsoft-biogpt-large microsoft-biomednlp-pub |

No disponible |

| JAIS | No disponible | jais-30b-chat |

| Modelos de la familia Meta Llama | Llama-3.3-70B-Instruct Llama-3.2-3B-Instruct Llama-3.2-1B-Instruct Llama-3.2-1B Llama-3.2-90B-Vision-Instruct Llama-3.2-11B-Vision-Instruct Llama-3.1-8B-Instruct Llama-3.1-8B Llama-3.1-70B-Instruct Llama-3.1-70B Llama-3-8B-Instruct Llama-3-70B Llama-3-8B Llama-Guard-3-1B Llama-Guard-3-8B Llama-Guard-3-11B-Vision Llama-2-7b Llama-2-70b Llama-2-7b-chat Llama-2-13b-chat CodeLlama-7b-hf CodeLlama-7b-Instruct-hf CodeLlama-34b-hf CodeLlama-34b-Python-hf CodeLlama-34b-Instruct-hf CodeLlama-13b-Instruct-hf CodeLlama-13b-Python-hf Prompt-Guard-86M CodeLlama-70b-hf |

Llama-3.3-70B-Instruct Llama-3.2-90B-Vision-Instruct Llama-3.2-11B-Vision-Instruct Llama-3.1-8B-Instruct Llama-3.1-70B-Instruct Llama-3.1-405B-Instruct Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-70b Llama-2-70b-chat Llama-2-13b Llama-2-13b-chat |

| Modelos de familia Phi de Microsoft | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct Phi-4 |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct |

| Modelos de familia Mistral | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Ministral-3B Mistral-NeMo |

| Nixtla | No disponible | TimeGEN-1 |

Proceso administrado

La capacidad de implementación de modelos como proceso administrado se basa en funcionalidades de plataforma de Azure Machine Learning para permitir una integración sin problemas de la amplia colección de modelos del catálogo de modelo en todo el ciclo de vida de las operaciones de modelos de lenguaje grande (LLM).

Disponibilidad de modelos para la implementación como proceso administrado

Los modelos están disponibles a través de los registros de Azure Machine Learning. Estos registros permiten un enfoque centrado en el aprendizaje automático para hospedar y distribuir recursos de Azure Machine Learning. Estos recursos incluyen ponderaciones de modelos, entornos de ejecución de contenedores para ejecutar los modelos, canalizaciones para evaluar y ajustar los modelos y conjuntos de datos para pruebas comparativas y ejemplos.

Los registros se basan en una infraestructura altamente escalable y lista para la empresa que ofrece las siguientes ventajas:

Proporciona artefactos de modelo de acceso de baja latencia para todas las regiones de Azure con replicación geográfica integrada.

Admite requisitos de seguridad empresarial, como la limitación del acceso a los modelos mediante Azure Policy y la implementación segura mediante redes virtuales administradas.

Implementación de modelos para la inferencia con proceso administrado

Los modelos disponibles para la implementación en un proceso administrado se pueden implementar en el proceso administrado de Azure Machine Learning para la inferencia en tiempo real. La implementación en un proceso administrado requiere que tenga una cuota de máquina virtual en la suscripción de Azure para los productos específicos que necesita para ejecutar el modelo de forma óptima. Algunos modelos permiten implementar en una cuota compartida temporalmente para las pruebas de modelos.

Más información sobre la implementación de modelos:

Creación de aplicaciones de IA generativa con proceso administrado

La característica flujo de avisos de Azure Machine Learning ofrece una excelente experiencia para la creación de prototipos. Puede usar modelos implementados con proceso administrado en el flujo de avisos con la herramienta Open Model LLM. También puede usar la API de REST expuesta por el proceso administrado en herramientas de LLM populares como LangChain con la Extensión de Azure Machine Learning.

Seguridad del contenido para los modelos implementados como proceso administrado

El servicio de seguridad de contenido de Azure AI (AACS) está disponible para su uso con procesos administrados para detectar diversas categorías de contenido dañino, como contenido sexual, violencia, odio. También puede usar el servicio para detectar amenazas avanzadas, como la detección de riesgos de jailbreak y la detección de texto de material protegido.

Puede consultar este cuaderno para la integración de referencia con Azure AI Content Safety for Llama 2. O bien, puede usar la herramienta Content Safety (texto) en el flujo de avisos para pasar respuestas del modelo a Seguridad de contenido de Azure AI para la detección. Se le factura por separado por este tipo de uso, como se describe en Precios de seguridad de contenido de Azure AI.

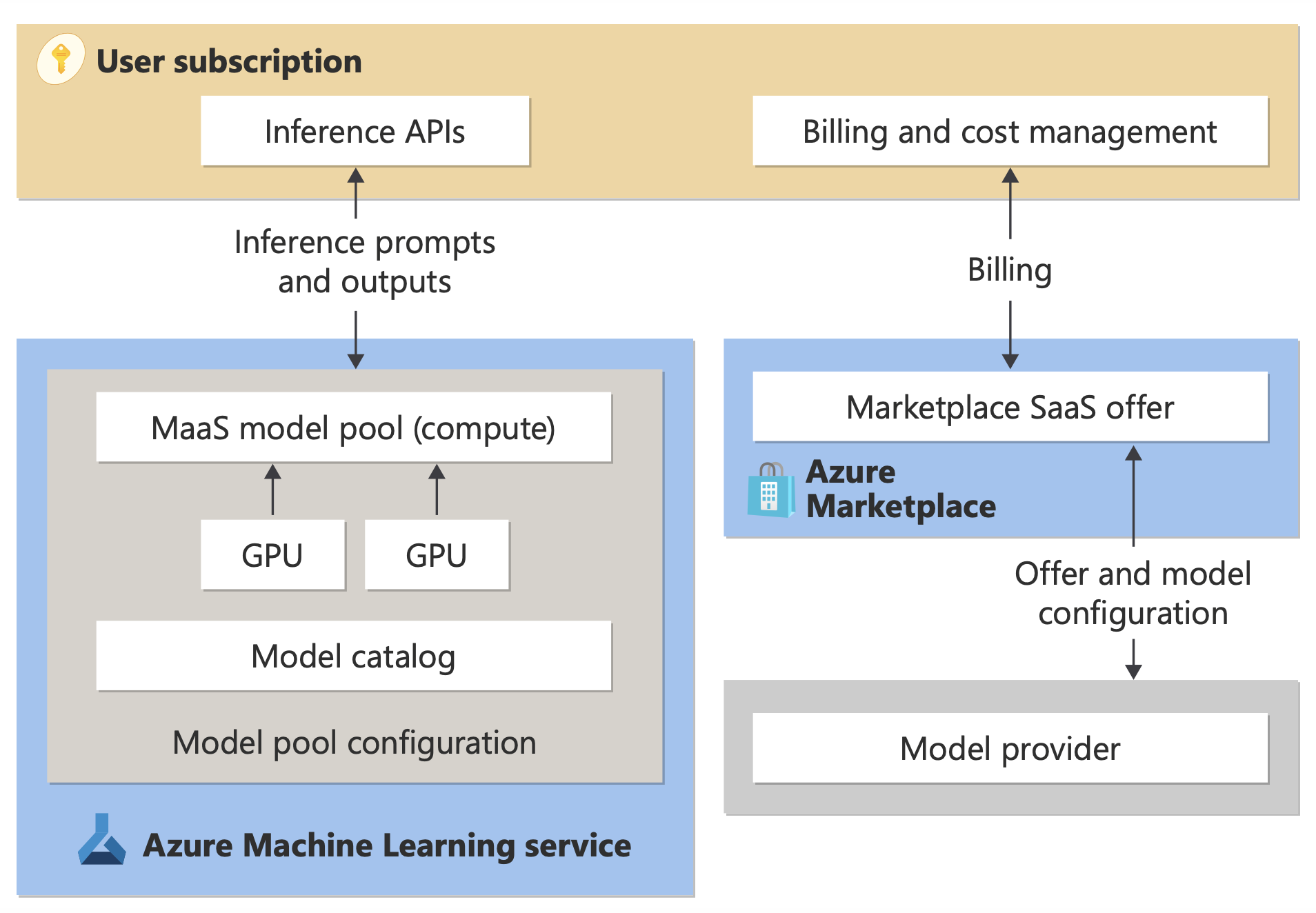

Facturación de API sin servidor (pago por token)

Puede implementar determinados modelos del catálogo de modelos con facturación de pago por token. Este método de implementación, también denominado API sin servidor, proporciona una manera de consumir los modelos como API sin hospedarlos en la suscripción. Los modelos se hospedan en una infraestructura administrada por Microsoft, lo que permite el acceso basado en API al modelo del proveedor de modelos. El acceso basado en API puede reducir drásticamente el coste de acceder a un modelo y simplificar la experiencia de aprovisionamiento.

El proveedor de modelos ofrece modelos disponibles para la implementación como API sin servidor con facturación de pago por uso, pero se hospedan en una infraestructura de Azure administrada por Microsoft y se accede a ellos a través de la API. Los proveedores de modelos definen los términos de licencia y establecen el precio para el uso de sus modelos. La API de Azure Machine Learning Service:

- Administra la infraestructura de hospedaje.

- Hace que las API de inferencia estén disponibles.

- Actúa como procesador de datos para solicitudes enviadas y contenido generado por modelos implementados a través de MaaS.

Obtenga más información sobre el procesamiento de datos para MaaS en el artículo sobre la privacidad de los datos.

Facturación

La experiencia de detección, suscripción y consumo de los modelos implementados a través de MaaS se encuentra en el portal de Azure AI Foundry y Estudio de Azure Machine Learning. Los usuarios aceptan los términos de licencia para el uso de los modelos. La información de precios para el consumo se proporciona durante la implementación.

Los modelos de proveedores que no son de Microsoft se facturan a través de Azure Marketplace, de acuerdo con los Términos de uso de Microsoft Commercial Marketplace.

Los modelos de Microsoft se facturan a través de medidores de Azure como servicios de consumo de primera entidad. Como se describe en Términos del producto, compra servicios de consumo de primera entidad mediante medidores de Azure, pero no están sujetos a los términos del servicio de Azure. El uso de estos modelos está sujeto a los términos de licencia proporcionados.

Ajuste de modelos

Algunos modelos también admiten el ajuste preciso. Para estos modelos, puede aprovechar el ajuste preciso de proceso administrado (versión preliminar) o de API sin servidor para adaptar los modelos mediante los datos que proporcione. Para obtener más información, consulte la introducción a la optimización.

RAG con modelos implementados como API sin servidor

En el portal de Azure AI Foundry, puede usar índices vectoriales y generación aumentada de recuperación (RAG). Puede usar modelos que se pueden implementar a través de API sin servidor para generar inserciones e inferencias basadas en datos personalizados. Estas inserciones e inferencias pueden generar respuestas específicas de su caso de uso. Para obtener más información, consulte el artículo sobre cómo compilar y consumir índices vectoriales en el portal Azure AI Foundry.

Disponibilidad regional de ofertas y modelos

La facturación de pago por token solo está disponible para los usuarios cuya suscripción de Azure pertenece a una cuenta de facturación en un país o región en el que el proveedor de modelos ha hecho que esté disponible la oferta. Si la oferta está disponible en la región pertinente, el usuario debe tener un recurso de proyecto en la región de Azure donde el modelo esté disponible para la implementación u optimización, según corresponda. Para obtener más información, consulte Disponibilidad de regiones para modelos en puntos de conexión de API sin servidor | Azure AI Foundry.

Seguridad del contenido para los modelos implementados a través de API sin servidor

En el caso de los modelos de lenguaje implementados a través de API sin servidor, Azure AI implementa una configuración predeterminada de filtros de moderación de texto de Seguridad del contenido de Azure AI que detectan contenido dañino, como odio, autolesión, contenido sexual y violento. Para más información sobre el filtrado de contenido (versión preliminar), consulte Categorías de daños en Azure AI Content Safety.

Sugerencia

Filtrado de contenido (versión preliminar) no está disponible para determinados tipos de modelo que se implementan a través de API sin servidor. Estos tipos de modelo incluyen la inserción de modelos y modelos de serie temporal.

El filtrado de contenido (versión preliminar) se produce de forma sincrónica a medida que el servicio procesa las solicitudes para generar contenido. Es posible que se le facture por separado según los precios de seguridad de contenido de Azure AI para este uso. Puede deshabilitar el filtrado de contenido (versión preliminar) para puntos de conexión individuales sin servidor:

- En el momento en que se implementa por primera vez un modelo de lenguaje

- Más adelante, seleccionando el botón de alternancia filtrado de contenido en la página de detalles de implementación

Supongamos que decide usar una API distinta de la API de inferencia de modelo de Azure AI para trabajar con un modelo implementado a través de una API sin servidor. En tal situación, el filtrado de contenido (versión preliminar) no está habilitado a menos que lo implemente por separado mediante Seguridad del contenido de Azure AI.

Para empezar a usar Seguridad del contenido de Azure AI, consulte Inicio rápido: analizar contenido de texto. Si no usa el filtrado de contenido (versión preliminar) al trabajar con modelos que se implementan a través de API sin servidor, corre un mayor riesgo de exponer a los usuarios a contenido perjudicial.

Aislamiento de red para los modelos implementados a través de API sin servidor

Los puntos de conexión de los modelos implementados como API sin servidor siguen la configuración de marca de acceso de red pública del centro de Azure AI Foundry que tiene el proyecto en el que existe la implementación. Para ayudar a proteger el punto de conexión de API sin servidor, deshabilite la marca de acceso de red pública en el centro de Azure AI Foundry. Puede ayudar a proteger la comunicación entrante de un cliente al punto de conexión mediante un punto de conexión privado para el centro.

Para establecer la marca de acceso de red pública para el centro de Azure AI Foundry:

- Vaya a Azure Portal.

- Busque el grupo de recursos al que pertenece el centro y seleccione el centro de Azure AI Foundry en los recursos enumerados para este grupo de recursos.

- En la página de información general del centro, en el panel izquierdo, vaya a Configuración>Redes.

- En la pestaña Acceso público, puede configurar las opciones de la marca de acceso de red pública.

- Guarde los cambios. Los cambios pueden tardar hasta cinco minutos en propagarse.

Limitaciones

Si tiene un centro de Azure AI Foundry con un punto de conexión privado creado antes del 11 de julio de 2024, los puntos de conexión de API sin servidor agregados a los proyectos de este centro no seguirán la configuración de red del centro. En su lugar, debe crear un nuevo punto de conexión privado para el centro y crear nuevas implementaciones de API sin servidor en el proyecto para que las nuevas implementaciones puedan seguir la configuración de red del centro.

Si tiene un centro de Azure AI Foundry con implementaciones de MaaS creadas antes del 11 de julio de 2024 y habilita un punto de conexión privado en este centro, las implementaciones de API sin servidor existentes no seguirán la configuración de red del centro. En el caso de las implementaciones de API sin servidor en el centro para seguir la configuración de red del centro, debe volver a crear las implementaciones.

Actualmente, la compatibilidad de Azure OpenAI en los datos no está disponible para implementaciones de API sin servidor en los concentradores privados, ya que estos tienen deshabilitado el indicador de acceso a la red pública.

Cualquier cambio de configuración de red (por ejemplo, habilitar o deshabilitar la marca de acceso a la red pública) puede tardar hasta cinco minutos en propagarse.